Sistemas de numeración y unidades

1 Sistemas de numeración

La información que queremos utilizar en un sistema informático debe estar representada de alguna manera que el ordenador pueda entender.

En sistemas orales, o escritos, lo habitual es hacer uso de un idioma concreto mediante un alfabeto conocido. En informática se hace uso de distintos sistemas de numeración para representar tanto números como el resto de información.

1.1 Sistema decimal

El ser humano, desde hace tiempo ha utilizado como sistema para contar el sistema decimal, representado mediante el sistema arábigo. Posiblemente se adoptó este sistema por contar con 10 dedos en las manos.

El sistema numérico decimal está basado en diez símbolos ordenados (0, 1, 2, 3, 4, 5, 6, 7, 8, 9), situados de manera ponderada (cada posición tiene un peso específico), que permiten representar las cantidades deseadas. Debido a que hacemos uso de diez símbolos se dice que utiliza la base 10.

Cuando se combina con otros sistemas de numeración, debemos indicar la base en la forma 19(10 , es decir, poniendo un pequeño “(10” a la derecha del número representado la base 10.

La representación de cualquier combinación del sistema decimal se puede representar en forma de potencia, donde la base es 10 y el exponente es la posición en la que se sitúa el símbolo.

Vamos a tomar como ejemplo el siguiente número: 146. La representación en forma de potencias:

146 = 100 + 40 + 6

146 = 1 × 100 + 4 × 10 + 6 × 1

146 = 1 × 102 + 4 × 101 + 6 × 100

Como se puede comprobar, lo que hemos hecho ha sido coger cada símbolo representado y lo hemos multiplicado por la base (en este caso base 10) y a la base le hemos puesto el exponente de la posición en la que se encuentra. El símbolo de más a la derecha tiene como exponente el cero, y hacia la izquierda el exponente se incrementa en uno para cada posición.

1.2 Sistema binario

En informática el sistema binario es el más importante ya que es el sistema que internamente utilizan los circuitos digitales. En este sistema sólo se hace uso de dos símbolos, el “0” y el “1”, y por tanto su base es 2. Los dos dígitos se denominan bits (contracción de binary digit).

Para representar que estamos haciendo uso del sistema binario debemos indicar la base al lado del número, por ejemplo: 101001(2. Como se puede ver es añadir “(2” en pequeño al final del último símbolo.

1.3 Sistema hexadecimal

Esta vez necesitamos dieciséis símbolos ordenados, así que es un sistema de base 16. Para la representación se hace uso de los símbolos numéricos que conocemos (0, 1, 2, 3, 4, 5, 6, 7, 8, 9) y para representar los siguientes, las letras “A”, “B”, “C”, “D”, “E” y “F”, de esta manera formamos los 16 símbolos que necesitamos.

Teniendo en cuenta esto, podemos hacer la representación directa de que A(16 = 10(10 y que E(16 = 14(10

En informática es muy habitual hacer uso del sistema hexadecimal a la hora de trabajar con bytes (que es una “palabra” de 8 bits). Un símbolo hexadecimal se representa como 4 bits, por lo que necesitaríamos 2 símbolos hexadecimales para un byte.

También se usa durante la edición de código en formato de datos, o durante la programación en ensamblador.

Al igual que con los sistemas anteriores, debemos añadir la base cuando estemos utilizando el sistema hexadecimal: F17A(16 , FBE1D(16 , 1FAB27(16

1.4 Sistema octal

En ordenadores antiguos era habitual hacer uso del sistema octal. Hoy día se usa más como sistema intermedio entre binario y hexadecimal.

Esta vez nos basamos en ocho símbolos ordenados (0, 1, 2, 3, 4, 5, 6, 7), que, al combinarlos, permiten representar las cantidades deseadas. Debido a que hacemos uso de ocho símbolos se dice que utiliza la base 8.

Para representar la base, debemos añadir “(8” a la derecha del número que hayamos indicado, como por ejemplo: 770(8 , 175(8

1.5 Conversiones entre los distintos sistemas de numeración

Hasta ahora no nos habíamos encontrado con distintos sistemas de numeración, pero ahora que conocemos cuatro de ellos, tenemos que saber que existe la posibilidad de realizar conversiones entre ellos.

Una vez entendidos los distintos sistemas de numeración nos tiene que quedar claro que aunque la representación de los símbolos sea la misma, el número o cantidad representada no es la misma. Por ejemplo:

1010(10 ≠ 1010(2 ≠ 1010(16 ≠ 1010(8

A continuación se va a explicar cómo realizar conversiones entre los distintos sistemas de numeración que hemos visto, y a modo de resumen está la tabla de conversiones directa.

1.5.1 Conversión de decimal a...

La manera más sencilla para realizar las distintas conversiones partiendo de un número decimal es hacer divisiones sucesivas usando la base a la que queremos realizar la conversión.

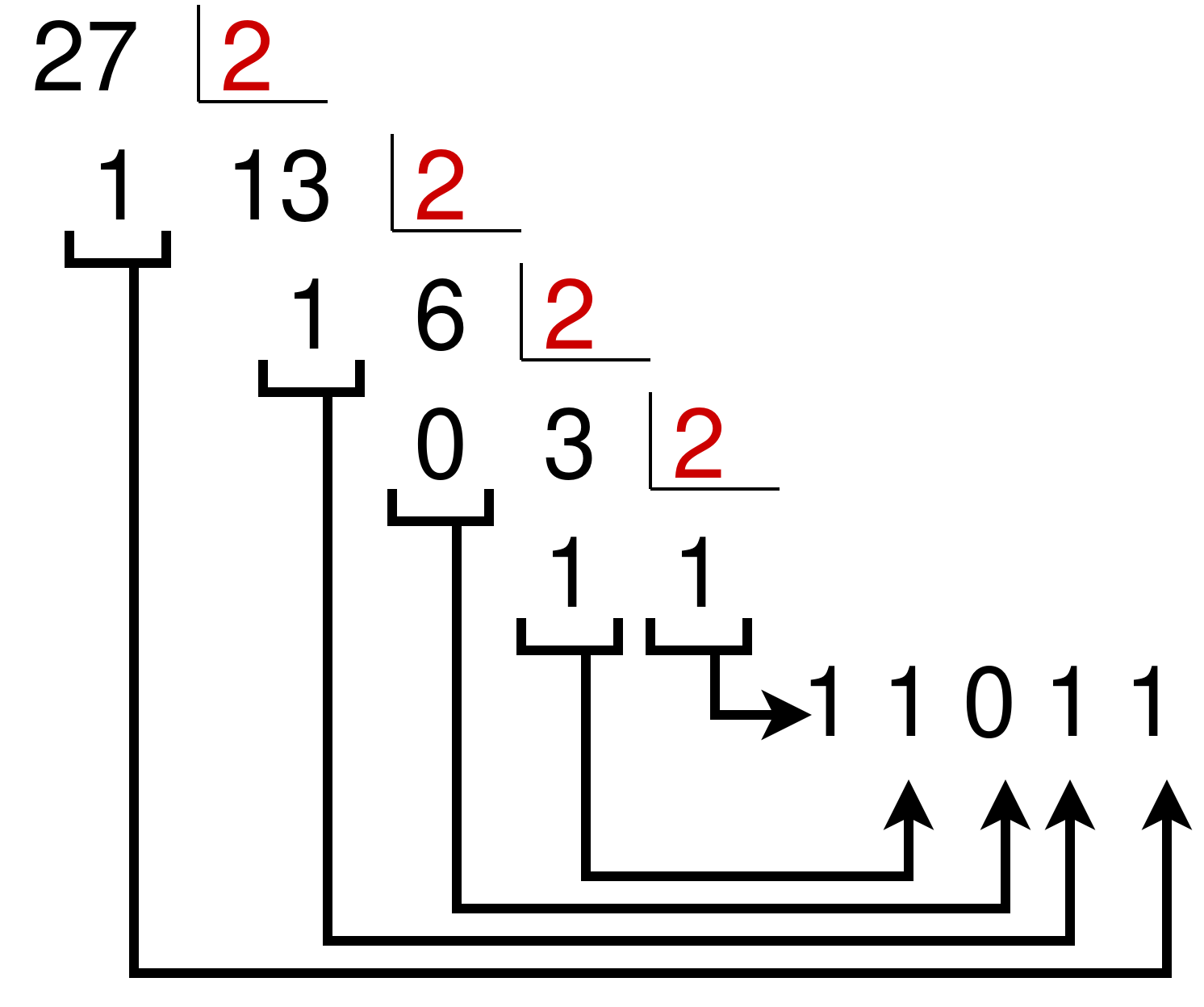

... binario

Se trata de dividir sucesivamente el número decimal y los sucesivos cocientes entre dos (la base binaria).

Vamos a utilizar como ejemplo el número decimal 27(10 :

Los restos los cogemos en orden inverso para obtener la siguiente equivalencia: 27(10 = 11011(2

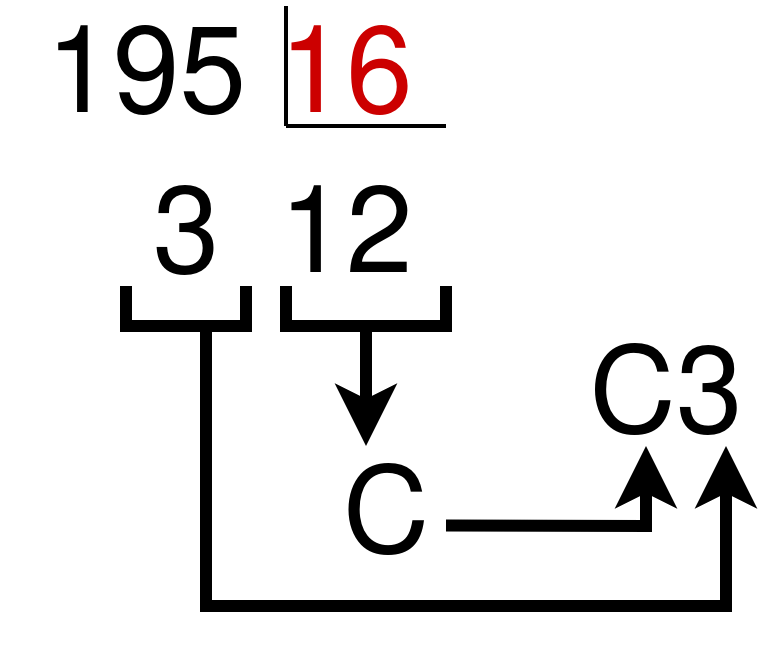

... hexadecimal

Se trata de dividir sucesivamente el número decimal y los sucesivos cocientes entre 16 (la base hexadecimal). Cuando el cociente o resto sea entre 10 y 15, habrá que cambiarlo por la letra correspondiente.

Los restos los cogemos en orden inverso para obtener la siguiente equivalencia: 195(10 = C3(16

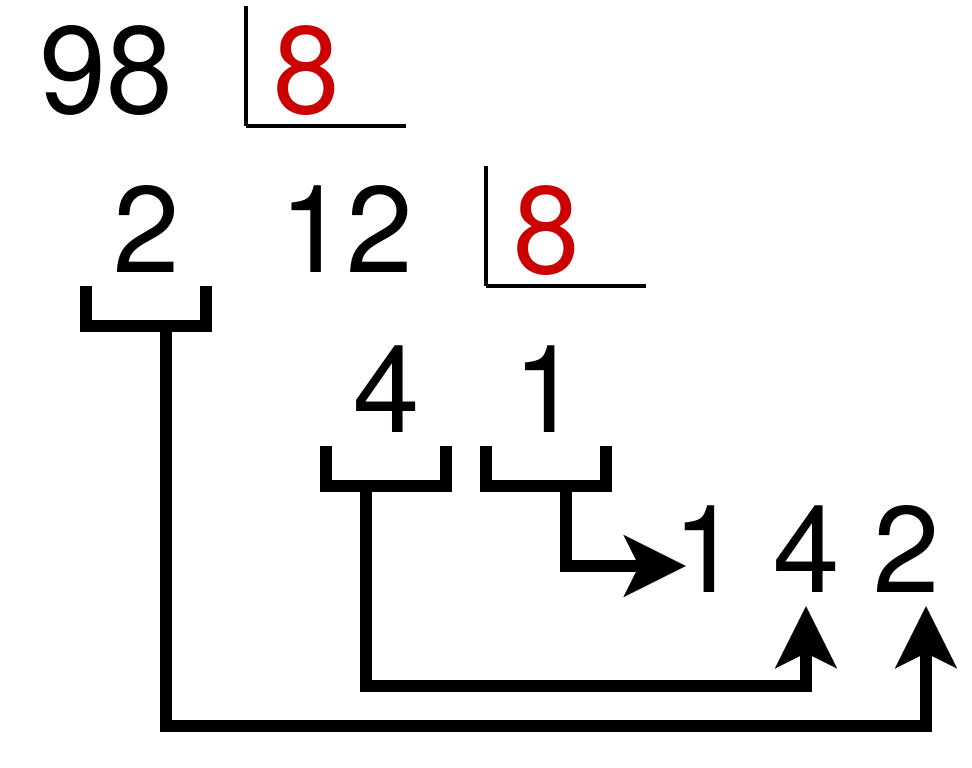

... octal

Al igual que los anteriores, hacemos divisiones sucesivas:

Los restos los cogemos en orden inverso para obtener la siguiente equivalencia: 98(10 = 142(8

1.5.2 Conversión de binario a...

... decimal

El sistema de numeración binario es un sistema posicional donde cada dígito binario (bit) tiene un valor basado en su posición relativa al LSB (Least Significant Bit = bit menos significativo, que es el que está más a la derecha y que tiene el menor valor).

Cualquier número binario puede convertirse a su equivalente decimal multiplicando cada bit por la base (2) y usando como exponente la posición (siendo 0 el exponente del bit de más a la derecha). Para ilustrarlo, cojamos como ejemplo el número binario 11011(2:

11011(2

1 × 24 + 1 × 23 + 0 × 22 + 1 × 21 + 1 × 20

16 + 8 + 0 + 2 + 1 = 27(10

Nótese que el procedimiento consiste en determinar los valores (es decir, las potencias de 2) de cada posición de bit que contenga un 1 y luego sumarlos.

Nótese también que el MSB (Most Significant Bit = bit más significativo, el que está más a la izquierda, el que tiene mayor valor) tiene un valor de 24 a pesar de que es el quinto bit. Esto se debe a que el LSB (Least Significant Bit, el bit menos significativo, el que está a la derecha) es el primer bit y tiene un valor de 20.

... octal

Para convertir un número binario a octal se agrupan los dígitos de 3 en 3 empezando desde el lado derecho hacia la izquierda, sustituyendo cada trío de dígitos binarios por su equivalente en octal.

Si en el lado izquierdo quedase algún bit “suelto” (sin formar un grupo de 3), se pueden poner “0” a la izquierda.

Cogemos como ejemplo el número binario 1100101001001(2 para pasarlo a octal, haremos:

001 100 101 001 001(2 = 14511(8

... hexadecimal

Similar al caso anterior, pero en este caso la agrupación que se realiza debe de ser de 4 en 4 bits. Si usamos el mismo ejemplo anterior 1100101001001(2 :

0001 1001 0100 1001(2 = 1949(16

1.5.3 Conversión de hexadecimal a...

... binario

Para pasar de hexadecimal a binario convertiremos cada símbolo hexadecimal a 4 bits.

F17A(16 = 1111 0001 0111 1010(2

1A4F(16 = 0001 1010 0100 111(2

... decimal

Al igual que hemos hecho con las conversiones previas a decimal, se podría realizar haciendo potencias de 16, pero se entiende que es más complicado de realizar.

Por lo tanto, la manera más sencilla es pasar primero a binario como acabamos de ver y posteriormente convertir ese binario a decimal como hemos visto previamente.

... octal

Pasar primero a binario y después a octal.

1.5.4 Conversión de octal a...

... binario

Cada dígito en octal se convierte en su representación en 3 bits:

167(8 = 001 110 111(2

253(8 = 010 101 011(2

Los ceros de la izquierda se podrían quitar, ya que no alteran el valor.

... decimal

Se puede realizar de dos maneras. La primera es hacer uso de potencias de 8 (similar al paso de pasar de binario a decimal, pero cambiando la base):

157(8 = 1 × 82 + 5 × 81 + 7 × 80=

1 × 64 + 5 × 8 + 7 × 1=

64 + 40 + 7 = 111(10

157(8 = 111(10

Con números grandes puede ser un poco complicado calcular las potencias de 8, por lo que la alternativa es pasarlo primero a binario como hemos visto, y después pasarlo de binario a decimal.

... hexadecimal

La manera más sencilla es realizar la conversión primero a binario tal como hemos visto, y posteriormente pasar el número binario a hexadecimal como se ha visto previamente.

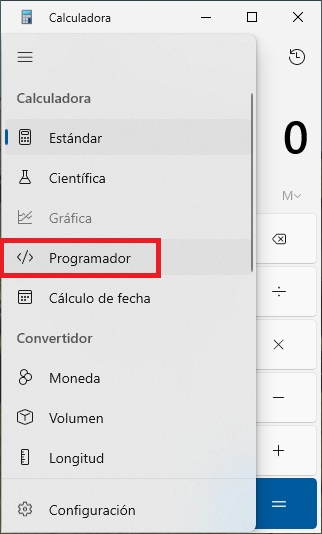

1.6 Comprobar conversiones

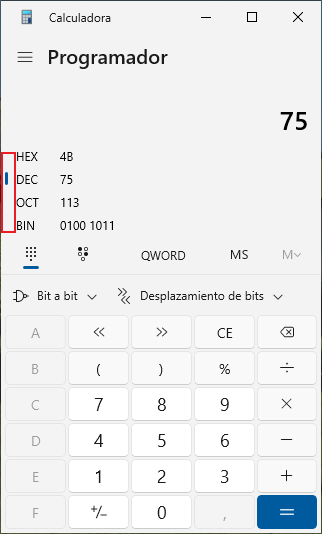

Podemos hacer uso de la calculadora del sistema Windows para comprobar si estamos realizando de manera correcta las conversiones. El problema es que por defecto sólo hace uso del sistema decimal. Para poder utilizar los sistemas de numeración que hemos aprendido, es necesario utilizar la versión “Programador”.

Una vez está en modo “Programador”, nos debemos fijar qué sistema de numeración está elegido. Al escribir cualquier número, en el resto de opciones veremos las conversiones automáticamente.

2 Unidades de Información digital

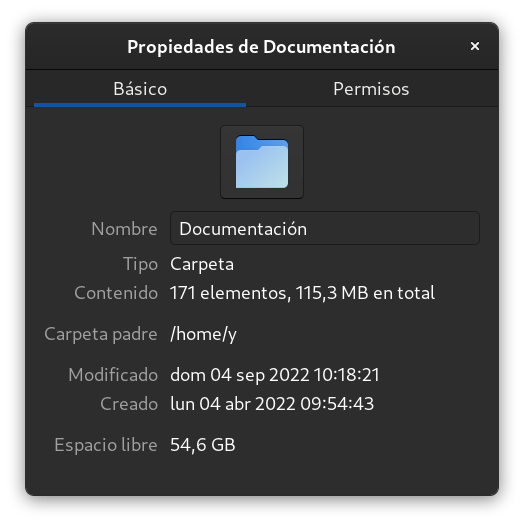

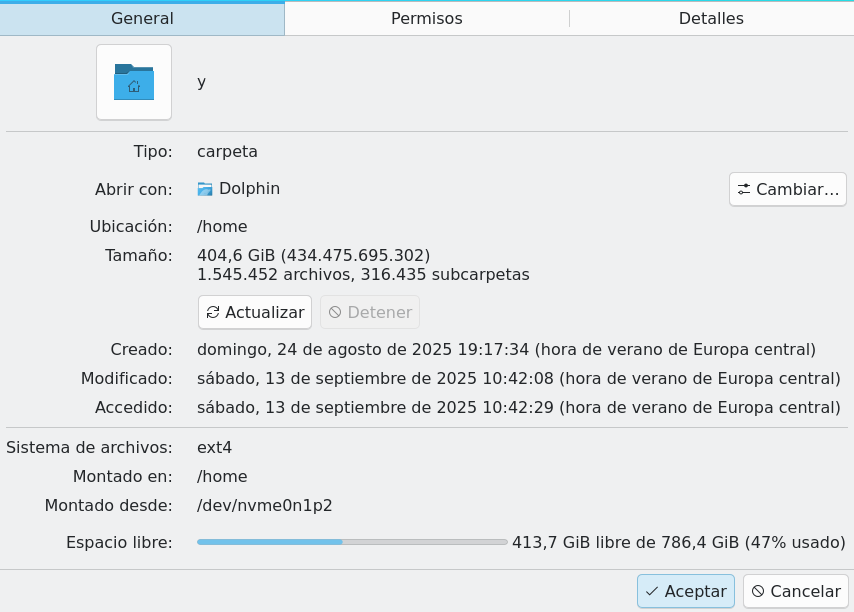

A la hora de almacenar información digital es importante conocer el tamaño del objeto que queremos almacenar y el espacio libre del lugar en el que lo queremos guardar.

En decimal estamos acostumbrados a contar usando el Sistema Internacional de Unidades, y dependiendo de la magnitud que queramos medir, haremos uso de unos prefijos establecidos. Por ejemplo, para medir la distancia usamos el metro, y por tanto nos quedaría:

Sin prefijo : metro, una unidad.

deca-metro: 101 metros

hecto-metro: 102 metros

kilo-metro: 103 metros

mega-metro: 106 metros

giga-metro: 109 metros

...

En decimal hacemos uso de la base 10, y por tanto con cada prefijo lo que estamos haciendo es modificar el exponente que indica la cantidad. Para unidades pequeñas el exponente varía de uno en uno, pero a partir de cierta cantidad (kilo-), la cantidad cambia multiplicando por 1000 (103).

2.1 Sistema binario

En informática la información se guarda en formato binario, y la unidad más pequeña es el bit, que es un acrónimo de binary digit. Cada bit es una única unidad que sólo permite dos estados: 0 o 1. A la hora de representarlo se hace uso de la letra b minúscula, por lo tanto, 10b son 10bits.

2.1.1 Múltiplos

Al igual que en decimal, a medida que aumentamos la cantidad, se hace uso de prefijos para facilitar el conocer de qué cantidad estamos hablando.

A continuación se expone una tabla de las medidas más utilizadas:

| Nombre | Símbolo | Cantidad |

|---|---|---|

| Bit | b | 20 = 1 |

| Nibble | 4b | |

| Byte | B | 8b |

| Kibibyte | KiB | 210 = 1024 B |

| Mebibyte | MiB | 220 = 1024 KiB |

| Gibibyte | GiB | 230 = 1024 MiB |

| Tebibyte | TiB | 240 = 1024 GiB |

| Pebibyte | PiB | 250 = 1024 TiB |

| Exbibyte | EiB | 260 = 1024 PiB |

2.2 Sistema decimal

Aunque la manera correcta de nombrar las unidades cuando hablamos en términos informáticos debería ser la anterior (en sistema binario), lo habitual es que se haga uso de los prefijos del sistema decimal. En la siguiente tabla se ven los nombres y cantidades:

| Nombre | Símbolo | Cantidad |

|---|---|---|

| Bit | b | 20 = 1 |

| Nibble | 4b | |

| Byte | B | 8b |

| Kilobyte | KB | 103 = 1000 B |

| Megabyte | MB | 106 = 1000 KB |

| Gigabyte | GB | 109 = 1000 MB |

| Terabyte | TB | 1012 = 1000 GB |

| Petabyte | PB | 1015 = 1000 TB |

| Exabyte | EB | 1018 = 1000 PB |

Cuando hablamos de unidades informáticas deberíamos usar el sistema binario, ya que es tal como se guarda la información y la cantidad real.

2.3 Usos

A la hora de utilizar las medidas vistas previamente hay que diferenciar qué queremos medir, ya que no se hará siempre igual.

Almacenamiento: A la hora de querer expresar una cantidad de almacenamiento (para un disco duro, un pendrive USB, RAM, ...) se hace uso del Byte y de sus múltiplos usando los prefijos vistos previamente.

Exploradores de ficheros mostrando la cantidad en decimal y binario.

Transmisión: Cuando hablamos de tasa de transferencia de datos se hace uso del término “tasa de bits” (en inglés bitrate), que indican el número de bits que se transmiten por unidad de tiempo. Hoy día se suele medir en kbps (o kb/s, kilobits por segundo), Mbps (Mb/s, o megabit por segundo), ... Para convertirlo a Bytes por segundo habría que dividirlo por “8”.

La transmisión de datos se expresa en “bits por segundo”

Hardware y Software

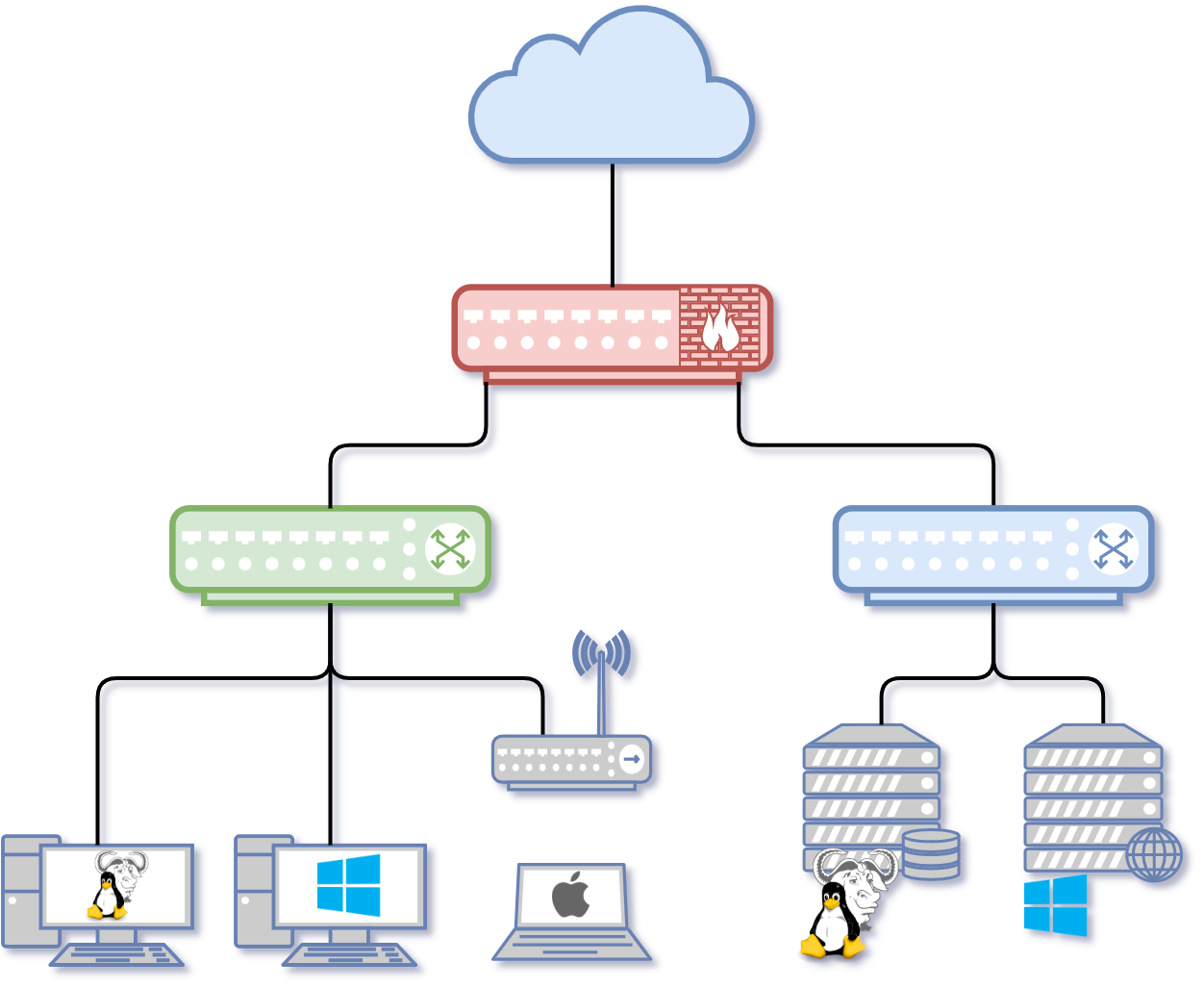

3 Sistemas Informáticos

3.1 Introducción

La informática es un área de la ciencia que abarca distintas disciplinas teóricas (como la creación de algoritmos, teoría de computación, teoría de la información, ...) y disciplinas prácticas (diseño de hardware, implementación de software). Normalmente llamamos informática al uso, almacenado o procesado de datos e información en formato digital.

Un sistema informático es aquel que nos permite almacenar y procesar datos en formato digital, para convertirlos en información. Normalmente un sistema informático lo asociamos a los ordenadores (computadoras), que contienen distintos componentes que podemos utilizar en nuestro día a día.

3.2 Breve historia de la computación/informática

Los ordenadores que estamos acostumbrados a utilizar, y que creemos que es lo que conocemos como informática, no es más que una evolución de un conjunto de ideas y avances que ha habido a lo largo de la historia como: la lógica, el álgebra, la mecánica, la electrónica, creación de materiales, ...

Es por eso que no podemos ceñirnos a la evolución de la informática como algo que ha ocurrido en las últimas décadas, si no que podemos remontarnos a varios siglos atrás. Lo que viene a continuación es un pequeño resumen de un listado más largo que aparece en la wikipedia.

- 1623

- Primera calculadora mecánica.

- 1666

- Se crea la primera calculadora mediante ruedas y engranajes.

- 1801

- Mediante el uso de tarjetas perforadas se controla el mecanismo de una máquina de tejer para realizar dibujos y diseños. Vídeo.

- 1837

- Charles Babbage describe la máquina analítica. Es el diseño de un computador moderno de propósito general.

- 1843

- Ada Augusta Lovelace sugirió la idea de que las tarjetas perforadas se adaptaran de manera que causaran que el motor de Babbage repitiera ciertas operaciones. Debido a esta sugerencia algunos consideran a Lady Lovelace la primera programadora.

- 1854

- George Boole publica su Álgebra de Boole. A causa del desarrollo del álgebra de Boole, Boole es considerado por muchos como el padre de la teoría de la informática.

- 1912

- Leonardo Torres Quevedo construye un Autómata capaz de jugar finales de ajedrez (torre y rey contra rey) que llamó “El Ajedrecista”.

- 1919

- Los inventores estadounidenses W. H. Eccles y F. W. Jordan desarrollan el primer circuito multivibrador o biestable (en léxico electrónico flip-flop). El flip-flop permitió diseñar Circuitos electrónicos que podían tener dos estados estables, alternativamente, pudiendo representar así el “0” como un estado y el otro con un “1”. Esto formó la base del almacenamiento y proceso del bit binario, estructura que utilizan las actuales computadoras.

- 1924

- Walther Bothe construye una puerta lógica AND para usarla en experimentos físicos, por lo cual recibió el premio Nobel de física en 1954.

- 1936

- Alan Turing describe la máquina de Turing, la cual formaliza el concepto de algoritmo.

- 1938

- Konrad Zuse completa la primera computadora electromecánica, aunque no 100% operativa, la Z1.

- 1944

- En Inglaterra se construyeron los ordenadores Colossus (Colossus Mark I y Colossus Mark 2), con el objetivo de descifrar las comunicaciones de los alemanes durante la Segunda guerra mundial.

- 1945

- John Von Neumann escribe el “First Draf of a report on the EDVAC” una página del primer documento donde se describe el diseño lógico de una computadora utilizando el concepto de programa almacenado (stored-program). Hoy día conocido como Arquitectura de von Neumann.

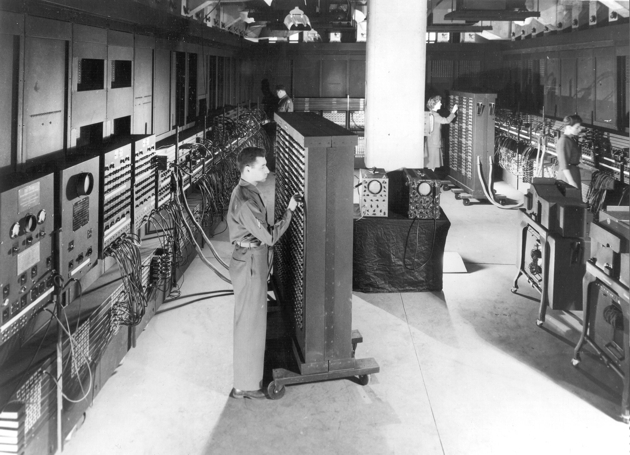

- 1946

-

En la Universidad de Pensilvania se construye la ENIAC (Electronic Numerical Integrator And Calculator), que fue la primera computadora electrónica de propósito general

- 1951

- El Sistema A-0 fue inventado por Grace Murray Hopper. Fue el primer compilador desarrollado para una computadora electrónica.

- 1958

- Comienza la segunda generación de computadoras, caracterizados por usar circuitos transistorizados en vez de válvulas al vacío.

A partir de la década de los 60 se aceleran los avances, y cada año se crean nuevos sistemas que permiten evolucionar lo ya conocido.

- 1964

- La aparición del IBM 360 marca el comienzo de la tercera generación de computadoras. Comienzan las placas de circuitos integrados.

- 1969

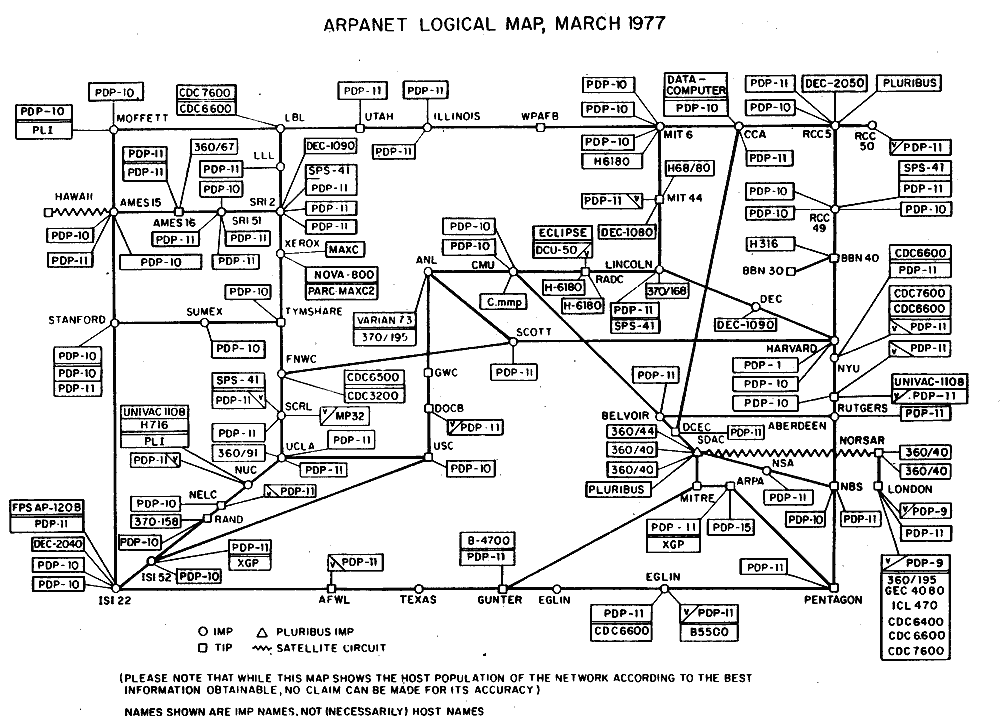

- Se publica el primer borrador de lo que será conocido como ARPANET (el precursor de la actual Internet).

- 1970

- Intel crea la primera memoria dinámica RAM.

- 1971

- Intel presenta el primer procesador comercial y a la vez el primer chip microprocesador, el Intel 4004.

- 1971

- Ray Tomlinson crea el primer programa para enviar correo electrónico.

- 1972

- Se decide reescribir Unix, pero esta vez utilizando lenguaje C.

- 1974

- Se crea el sistema Ethernet para enlazar a través de un cable único a las computadoras de una LAN.

- 1981

- Se lanza al mercado el IBM PC, que se convertiría en un éxito comercial, marcaría una revolución en el campo de la computación personal y definiría nuevos estándares.

- 1981

- Se termina de definir el protocolo TCP/IP. Lo utilizamos actualmente para navegar por Internet.

- 1983

- Richard Stallman anuncia públicamente el proyecto GNU, con el objetivo de crear el primer sistema operativo libre de tipo Unix.

- 1986

- El lenguaje SQL es estandarizado por ANSI.

- 1990

- Tim Berners-Lee idea el hipertexto para crear el World Wide Web (www) una nueva manera de interactuar con Internet.

- 1991

- Linus Torvalds comienza a desarrollar Linux, el kernel (o núcleo) de un sistema operativo compatible con Unix.

- 1991

- Comienza a popularizarse la programación orientada a objetos.

- 1995

- Aparece la primera versión de MySQL.

- 1995

- Se inicia el desarrollo del servidor Apache.

- 1997

- EL IEEE crea la primera estándar WLAN y la llamaron 802.11. El primer protocolo para WiFi.

Se podrían añadir más momentos importantes hasta el día de hoy, pero como ya se ha dicho previamente, se ha elegido sólo un pequeño resumen.

3.3 Componentes de un sistema informático

Podemos diferenciar distintos componentes dentro de un sistema informático:

Hardware: Es todo lo que forma parte del ordenador, que puede ser tocado físicamente. Es decir: teclado, ratón, monitor, placa base, procesador, memoria, disco duro, cables, etc. Es la “maquinaria” necesaria utilizada para el tratamiento automático de la información.

Software: Es el elemento lógico, es todo aquello que es “intangible”. Es el conjunto de programas y datos que permiten manejar el hardware, controlando y coordinando su funcionamiento para que realice las tareas deseadas.

4 Hardware

Como ya se ha comentado previamente, el hardware es todo lo que forma parte del ordenador, que puede ser tocado físicamente. Dentro de un ordenador vamos a poder diferenciar distintos componentes que cumplirán una función distinta que detallaremos más adelante.

Es posible que ya conozcamos alguno de estos componentes, pero debemos conocer el origen y cómo surge la arquitectura de los ordenadores modernos.

4.1 Arquitectura Von Neumann

Las primeras computadoras electromecánicas eran diseñadas para un único propósito, estaban “diseñadas” para realizar una tarea. Un caso conocido puede ser Bombe, una máquina electromecánica capaz de descifrar los sistemas criptográficos nazis de Enigma. The Imitation Game

Algunas se podían “reprogramar”, pero a base de recablear distintos componentes tras un estudio de lo que se quería realizar. Podía tomar hasta tres semanas preparar un programa de ENIAC y conseguir que funcionara.

El concepto de máquinas de computación universal y el uso de programa almacenado ya existía a nivel teórico desde mediados de la década de 1930 (escrito por Alan Turing).

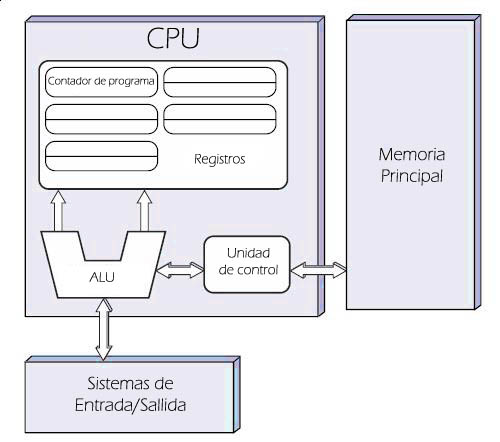

El matemático y físico John von Neumann, junto con otros compañeros, describe en 1945 un diseño para una arquitectura de computadoras en el que se describren los siguientes componentes que se interrelacionan entre sí a través del bus del sistema que actúa como canal de comunicación entre ellos:

Unidad Central de Proceso (CPU, por sus iniciales en inglés), que a su vez, contiene:

Unidad Aritmético Lógica (ALU en inglés): Es un circuito digital que realiza operaciones aritméticas (suma, resta, multiplicaciones,…) y operaciones lógicas (AND, OR, X-OR,…) entre los valores de los argumentos (uno o dos).

Registros del procesador: Memoria de alta velocidad y poca capacidad integrada en la CPU para almacenar datos utilizados durante la ejecución de un programa:

Contador de programa

Acumulador

Registro de instrucciones

Unidad de control: Su función es buscar las instrucciones en la memoria principal, decodificarlas y ejecutarlas, empleando para ello la unidad de proceso.

La memoria principal: Sistema donde se almacenan las instrucciones y los datos del programa que se está ejecutando en ese instante, dividida en celdas que se identifican por medio de una única dirección.

Los sistemas de Entrada/Salida: Realizan la transferencia de información entre periféricos de entrada y/o salida para extender las capacidades del equipo.

Hoy en día, los ordenadores han evolucionado, pero la arquitectura sigue siendo la misma, aunque más compleja.

Podemos ver una simulación de la Arquitectura Von Neumann aquí

4.2 Componentes básicos

Un ordenador moderno se puede distinguir de distintos componentes, los cuales cumplen una función específica. Así mismo, también pueden contar con subcomponentes integrados que son necesarios para cumplir su cometido final.

A continuación se van a detallar los componentes necesarios de un ordenador moderno.

4.2.1 Placa base

La placa base (conocida en inglés como motherboard) es una tarjeta de circuito impreso que tiene elementos electrónicos (resistencias, condensadores, reguladores …) a la que se conectan el resto de componentes que forman el ordenador. Es por eso que se puede considerar como la parte fundamental a la hora de montar un ordenador, ya que sin ella, el resto de componentes no se podrán comunicar entre sí.

4.2.1.1 Formatos de placa base

Las placas base deben tener un tamaño compatible con las cajas en las que van a ir montadas, y es por eso que hay distintos tamaños estandarizados. Cada uno de estos tamaños determinan dónde van a ir montados algunos de los componentes y conectores, así como los agujeros donde irán los tornillos de sujeción a la caja.

Si queremos profundizar más en los distintos formatos, la Wikipedia cuenta con una sección en la que se comparan los distintos tamaños.

4.2.1.2 Conectores de la placa base

Como ya hemos indicado, a la placa base se conectan el resto de componentes que forman el ordenador, y es por eso que va a tener distintos conectores:

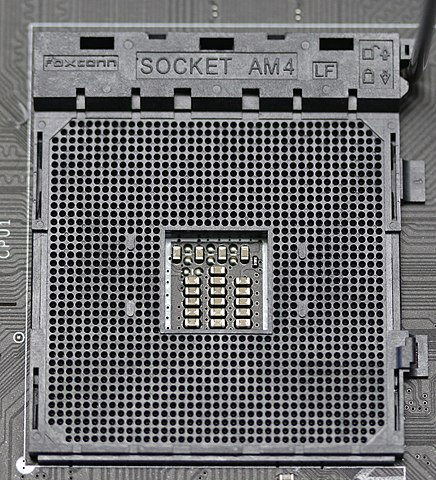

Zócalo del microprocesador: También llamado socket. Es donde se conecta el microprocesador sin tener que soldarlo a la placa, y de esta manera puede ser sustituido. El número de conexiones que conectan la placa base al microprocesador ha ido aumentando a medida que ha ido evolucionando la tecnología, siendo hoy día de hasta 1700 conectores.

Dependiendo del tipo de procesador, y el modelo, el socket variará en número de contactos y el tipo de los mismos. Existen distintas maneras de interconexión:

PGA: De ping grid array, o matriz de rejilla de pines. El procesador cuenta con unos pines en formato perpendicular que se conectan al socket donde estarán unos agujeros.

En la imagen se puede ver un Socket AM4 con tecnología PGA que tiene 1331 contactos.

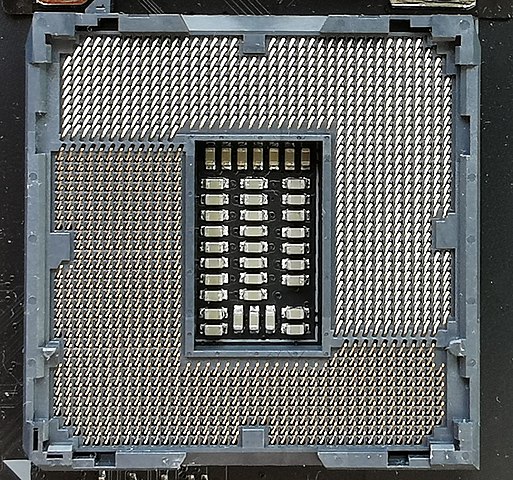

- LGA: De land grid array, o matriz de contactos en rejilla. En este caso el procesador no cuenta con pines, sino que es una matriz de contactos chapados en oro. Esta rejilla de contactos hacen contacto con el zócalo de la placa base que es la que cuenta con unos pequeños pines flexibles.

- BGA: De ball grid array, o matriz de rejilla de bolas. El procesador cuenta con unas bolas de estaño que al calentarse se sueldan a la placa base. Hoy en día se utiliza en componentes de tamaño reducido, como en móviles, los chips de memoria en los módulos de RAM, …

Conectores de alimentación: La placa base tendrá distintos conectores provenientes de la fuente de alimentación con diferentes voltajes, para así proveer de alimentación a los componentes conectados a ella.

Ranuras de memoria RAM: Hoy en día es habitual contar con varias ranuras donde conectar las memoria RAM. Más adelante hablaremos en profundidad sobre la memoria RAM.

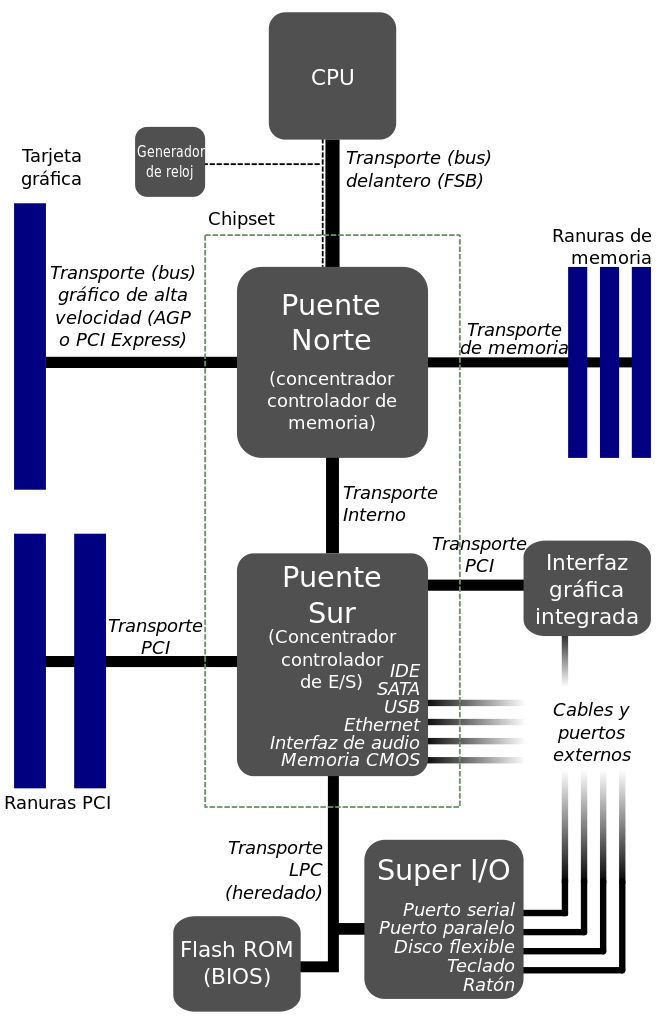

Chipset: Es un conjunto de chips, o circuitos electrónicos, que gestionan la comunicación entre los distintos componentes que forman el ordenador, y que están conectados en la placa base. Hoy en día se suelen dividir en dos partes:

Northbridge: O puente norte. Controla el tráfico de los componentes que trabajan a más alta frecuencia. Comunica el microprocesador, la memoria RAM y la GPU (la ranura PCI express).

Southbridge: O puente sur, comunica los periféricos, los dispositivos de almacenamiento, puertos de entrada/salida como USB, ethernet, …

Hoy día el northbridge está integrado en el propio procesador y en algunos casos partes del Southbridge también.

Ranuras de expansión: Vamos a identificar estas ranuras como las más modernas PCIexpress. Son un bus de comunicación de datos de alta velocidad que es usado principalmente para conectar tarjetas gráficas.

Es cierto que se pueden conectar otro tipo de tarjetas de expansión, como capturadoras de vídeo, tarjetas de red, controladoras RAID, …

Hoy en día existen conectores (M.2) donde poder conectar discos duros que tienen un tipo de conector especial.

Otros conectores de entrada/salida: En la placa base existen otros muchos conectores de entrada y salida, que cumplirán distintas funciones dependiendo del tipo de conector, función y/o protocolo de comunicación que utilicen.

Algunos de estos conectores tendrán conector exterior (al que se podrá conectar directamente el dispositivo), mientras que otros necesitarán de un adaptador (como sucede hoy día con conectores extra USB o el conector “serie”). Algunos ejemplos son:

USB: Donde poder conectar distintos dispositivos como teclados, ratón, pendrives, mandos de juegos, impresoras, … El USB (Universal Serial Bus) es un estándar de comunicación de periféricos hoy día. En las placas actuales también hay conectores de tipo USB-C.

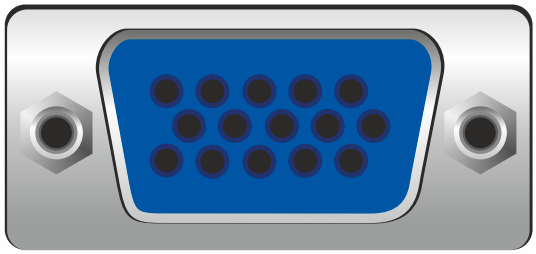

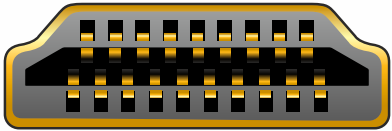

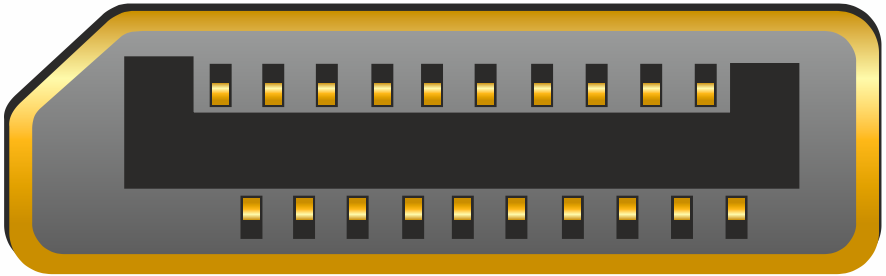

Conectores de pantalla como VGA, HDMI o DisplayPort. Dependiendo de lo moderna que sea la placa base, contará con uno o varios de estos conectores.

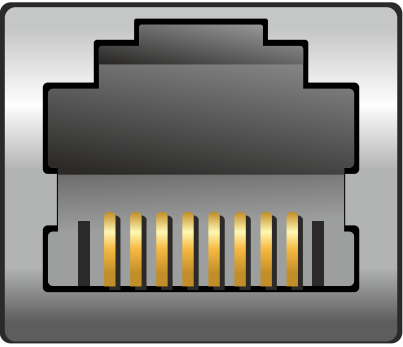

Red: Hoy día el conector RJ45 es el estándar, que dependiendo de la versión ethernet, nos dará al menos 1Gbit de transmisión. Dependiendo del modelo de placa base también puede tener conectores para realizar conexiones a redes inalámbricas.

Audio: Tanto de entrada como de salida. Normalmente se hace uso de conectores de tipo jack, pero también puede haber conectores de salida digital.

Pila: Las placa base cuentan con una pila para mantener la alimentación para guardar la información de la RAM-CMOS, que es una pequeña memoria que usa la BIOS durante el arranque del sistema.

Conectores para ventiladores: Para regular la temperatura del microprocesador y del interior de la caja, la placa tiene varios conectores que se conectarán a distintos ventiladores que se regularán en intensidad.

Otros conectores: Existen otros conectores para otros puertos que hoy en día no se usan tanto (serie, paralelo, …) y también los conectores para encender el ordenador, realizar el reset, comprobar el funcionamiento del disco…

A continuación un diagrama simplificado de una placa base. Fuente: Wikipedia.

4.2.1.3 Ejemplo de placa base

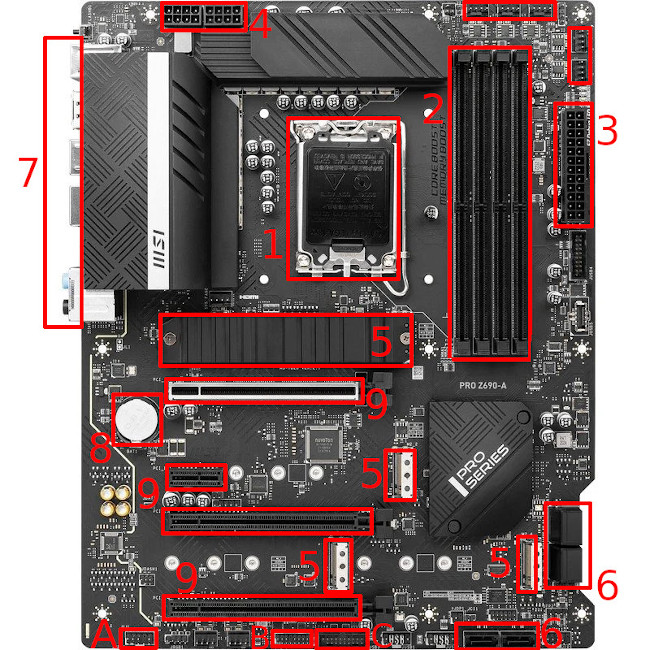

A continuación se van a diferenciar los componentes vistos anteriormente en una placa base real, utilizada para crear un equipo de escritorio moderno:

Zócalo (socket) del procesador.

Ranuras para la memoria RAM.

ATX de alimentación.

Conectores de alimentación extra necesarios por la CPU.

M.2 para discos duros.

SATA para discos duros.

Conectores exteriores (se verán a continuación)

Pila.

Ranuras PCIexpress de distintas velocidades.

Audio

Conectores frontales.

USB 3.0

Los conectores exteriores de esta placa tienen el siguiente aspecto:

De izquierda a derecha, y de arriba abajo:

Pulsador para actualizar la BIOS.

Conector PS2 y USB para actualizar la BIOS.

DisplayPort y HDMI

Usb 2.0 y 3.2

Conector LAN, USB y USB-C

Conectores de audio

4.2.2 BIOS/UEFI

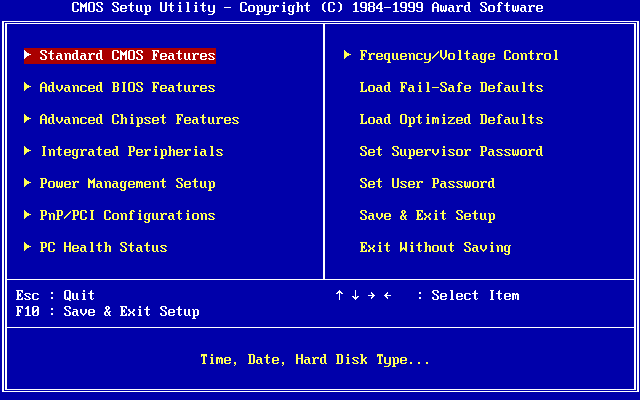

La BIOS/UEFI es un interfaz de firmware que está incorporado en un chip en la placa base.

La función principal es la de iniciar el ordenador, realizar una comprobación del hardware del sistema y se encarga de arrancar el gestor de arranque.

Se ha unificado en esta sección BIOS y UEFI ya que cumplen de manera similar la misma función, pero la segunda es una evolución de la primera.

4.2.2.1 BIOS

El sistema básico de entrada-salida (del inglés Basic Input/Output System, o BIOS) lo creó IBM para sus ordenadores “Personal Computer”. Posteriormente se obtuvo por ingeniería inversa las funciones que realizaba tratando de buscar equipos que fueran compatibles (denominados “PC-compatible”) y de esta manera convirtiéndose en un estándar de facto.

A través de este interfaz se podían configurar algunos aspectos del hardware como las interrupciones de teclado que utilizaban los sistemas operativos antiguos (como MS-DOS), direcciones, el orden del sistema de arranque, …

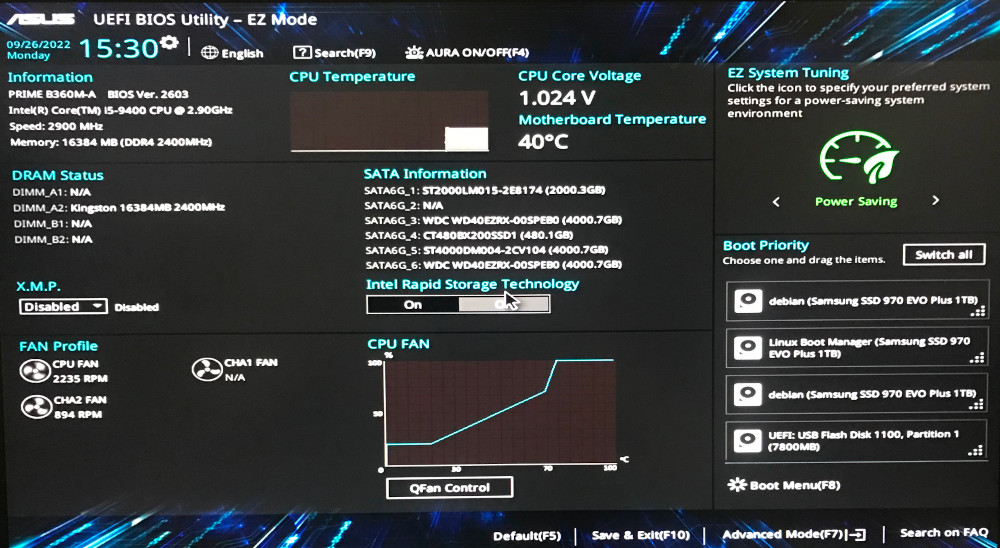

4.2.2.2 UEFI

La Unified Extensible Firmware Interface (UEFI o «interfaz unificada de firmware extensible») es una especificación pública que define un interfaz entre el sistema operativo y el firmware de la plataforma.

Se puede considerar una evolución de la BIOS que tiene las siguientes características:

Permite arrancar desde particiones de más de 2TB gracias a eliminar las limitaciones del MBR (master boot record).

Diseño modular y extensible.

Retro-compatible con BIOS.

Interfaz gráfica más amigable con el usuario.

4.2.3 Procesador

El procesador (o microprocesador) es la unidad central de proceso (CPU) de la arquitectura Von Neumann, y es el circuito integrado más complejo que tiene el ordenador. Se puede considerar el “cerebro”.

Es el encargado de ejecutar todos los programas y operaciones que realizamos, pero sólo sabe ejecutar instrucciones en lenguaje máquina (código binario).

El microprocesador se conecta a la placa base a través del socket, y encima de él se añade un sistema de refrigeración para disipar el calor que genera durante su funcionamiento.

4.2.3.1 Características

A la hora de determinar las características principales que cuenta un procesador podemos destacar las siguientes:

Frecuencia del reloj: Es la cantidad de veces que los transistores internos del procesador pueden conmutar eléctricamente (abrir y cerrar el flujo de corriente eléctrica). Hoy en día se mide en GHz (giga hercios), donde 1GHz es mil millones de ciclos por segundo.

Normalmente se confunde con el número de operaciones o instrucciones que puede ejecutar en un segundo, pero eso no es del todo correcto.

Tampoco determina que cuanta mayor frecuencia el procesador vaya a ser mejor que otro con menor frecuencia (ya existían procesadores a 4GHz hace años).

Bus de direcciones: Este tamaño determinará la cantidad máxima de memoria que podemos direccionar. Con 32 bits se pueden direccionar 2³², es decir, 4GB. Mientras que con 64 bits en los procesadores modernos llegamos hasta los 16 exabytes de memoria RAM (2⁶⁴).

Bus de datos: Es el dato más grande que es capaz de manejar en una única instrucción.

Memoria caché: Es una memoria que se encuentra internamente dentro del procesador, que es mucho más rápida, pero también de mucho menor tamaño, si la comparamos con la memoria RAM. Los procesadores actuales cuentan con unos pocos MB de tamaño dependiendo del nivel de caché. Ejemplo el Intel Core i5-12400 con 7.5MB de L2 caché.

Voltaje: Para que el procesador funcione necesita ser alimentado con frecuencia eléctrica. Normalmente a mayor voltaje se consigue mayor frecuencia de reloj.

Número de cores: Los microprocesadores actuales no cuentan con una única CPU interna (como era habitual hasta el año 2006 más o menos), ya que pueden contar con varias, denominadas “cores”.

Actualmente también se pueden diferenciar en el tipo de core que tiene, ya que algunos están diseñados para más eficiencia mientras que otros para mayor carga de trabajo.

Multihilo/Hyperthreading: Consiste en simular dos procesadores lógicos dentro de un único procesador físico. Permite ejecutar programas que están preparados, y eso permite una mejora en el rendimiento.

Existen otro tipo de características más técnicas, pero que también son importantes de conocer. A nivel de cómo está diseñado el procesador, lo que se denomina la arquitectura interna también contamos con diferencias. Hoy día podemos encontrar dos arquitecturas diferenciadas:

CISC: Del inglés Complex Instruction Set Computer (conjunto de instrucciones complejas), es un conjunto de instrucciones que se caracteriza por ser muy amplio y permitir operaciones complejas entre operandos situados en la memoria o en los registros internos.

Los CISC pertenecen a la primera corriente de construcción de procesadores. Pertenecen a esta arquitectura la mayoría de los procesadores actuales de ordenadores personales: AMD, X86_64.

RISC: Del inglés Reduced Instruction Set Computer (computador con conjunto de instrucciones reducido) es una filosofía de diseño de CPU para computadora que está a favor de conjuntos de instrucciones pequeñas y simples que toman menor tiempo para ejecutarse.

Hoy en día podemos encontrar esta arquitectura sobre todo en ARM que se utiliza en procesadores de móviles como los A15 de Apple (pero también en los procesadores de escritorio M1 y M2), Qualcomm Snapdragon, …

4.2.3.2 Rendimiento

Dadas todas las características que hemos visto previamente, no podemos determinar si un procesador es mejor a otro sólo mirando sus características y determinando que “cuanto más mejor”. Por ejemplo:

Intel Pentium 4: 2.80GHz de frecuencia de reloj

Intel Core 2 Duo E8200: 2.66GHz de frecuencia de reloj

Intel i5-11400: Frecuencia de reloj base 2.60GHz.

No nos podemos quedar con la idea de que “cuanto más mejor” cuando nos referimos a cantidades en las características del procesador

Es por eso que existen las pruebas de rendimiento, también conocido en inglés como benchmark.

Estas pruebas de rendimiento se ejecutan a través de un programa que va a ejecutar un conjunto de operaciones (que siempre serán las mismas) y determinará el tiempo llevado a cabo, y junto con otras especificaciones terminará dando una puntuación al resultado obtenido.

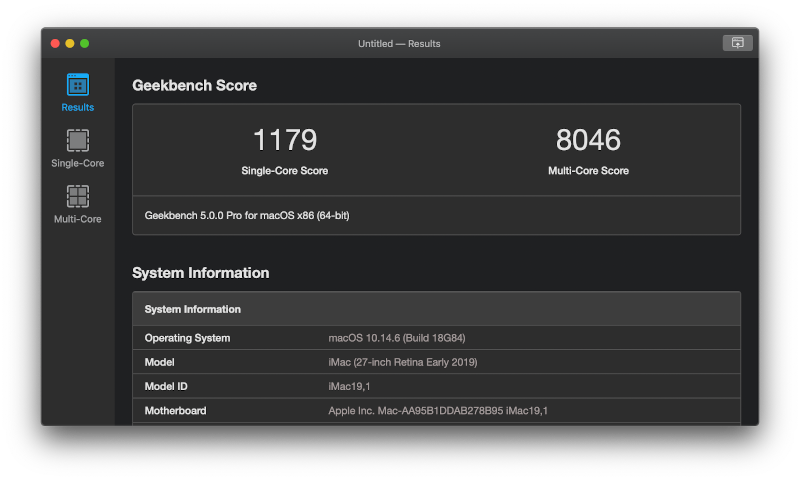

De esta manera, si utilizamos el mismo programa de benchmark en dos procesadores distintos, obtendremos puntuaciones distintas. Por ejemplo, Geekbench es un programa multiplataforma muy popular hoy día:

4.2.4 Sistema de refrigeración

Debido a que el procesador genera calor durante su funcionamiento, y que esto repercute en su funcionamiento, se debe de mantener a una temperatura acorde. Es por ello que debemos hacer uso de un sistema de refrigeración.

El sistema de refrigeración cuenta con dos partes:

Disipador: Está en contacto con el procesador y por el principio cero de la termodinámica le traspasa el calor.

Sistema de reducción de temperatura: Trata de reducir el calor que recibe el disipador para que el procesador se enfríe. Podemos diferenciar los siguientes sistemas:

Por aire: Usando ventiladores.

De agua autocontenida y aire: Es un circuito cerrado de agua que pasa a través de un radiador refrigerado por ventiladores. Venden el sistema cerrado, por lo que no hay que hacer nada con el líquido.

Refrigeración líquida: Se utilizan componentes especiales para realizar el contacto con la CPU (y la GPU), y se debe hacer un circuito cerrado por el que pasará el líquido refrigerante, y una bomba que moverá el líquido.

Disipador con ventilador y refrigeración líquida autocontenida.

4.2.5 Memoria RAM

La memoria de acceso aleatorio (en inglés Random Access Memory) es una memoria a corto plazo para almacenar los programas que están siendo ejecutados.

Cuando un programa se ejecuta se cargan todas sus instrucciones en RAM, así como todos los datos que va a manipular.

Es una memoria volátil, esto quiere decir que cuando deja de recibir electricidad, se pierde la información, por ejemplo al apagarse el ordenador o al reiniciarlo.

Se denominan “de acceso aleatorio” porque se puede leer o escribir en cualquier posición tardando lo mismo, no siendo necesario seguir un orden para acceder.

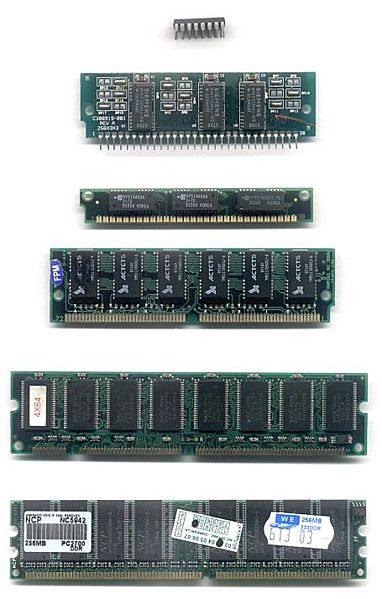

A lo largo de la historia la memoria RAM ha tomado distintas formas:

Antes de los circuitos integrados era una matriz metálica que funcionaba por electromagnetismo. Foto.

Con la llegada de los circuitos integrados se instalaban en la placa soldandolos o sobre pequeños zócalos.

Para hacer el sistema modular, se pasó al formato SIPP (Single In-line Pin Package). En una sola tarjeta se integraban varios módulos de memoria, pero los pines eran frágiles.

Como evolución llegó el formato SIMM (single In-line Memory Module), que en lugar de pines tenía contactos en ambas caras del módulo.

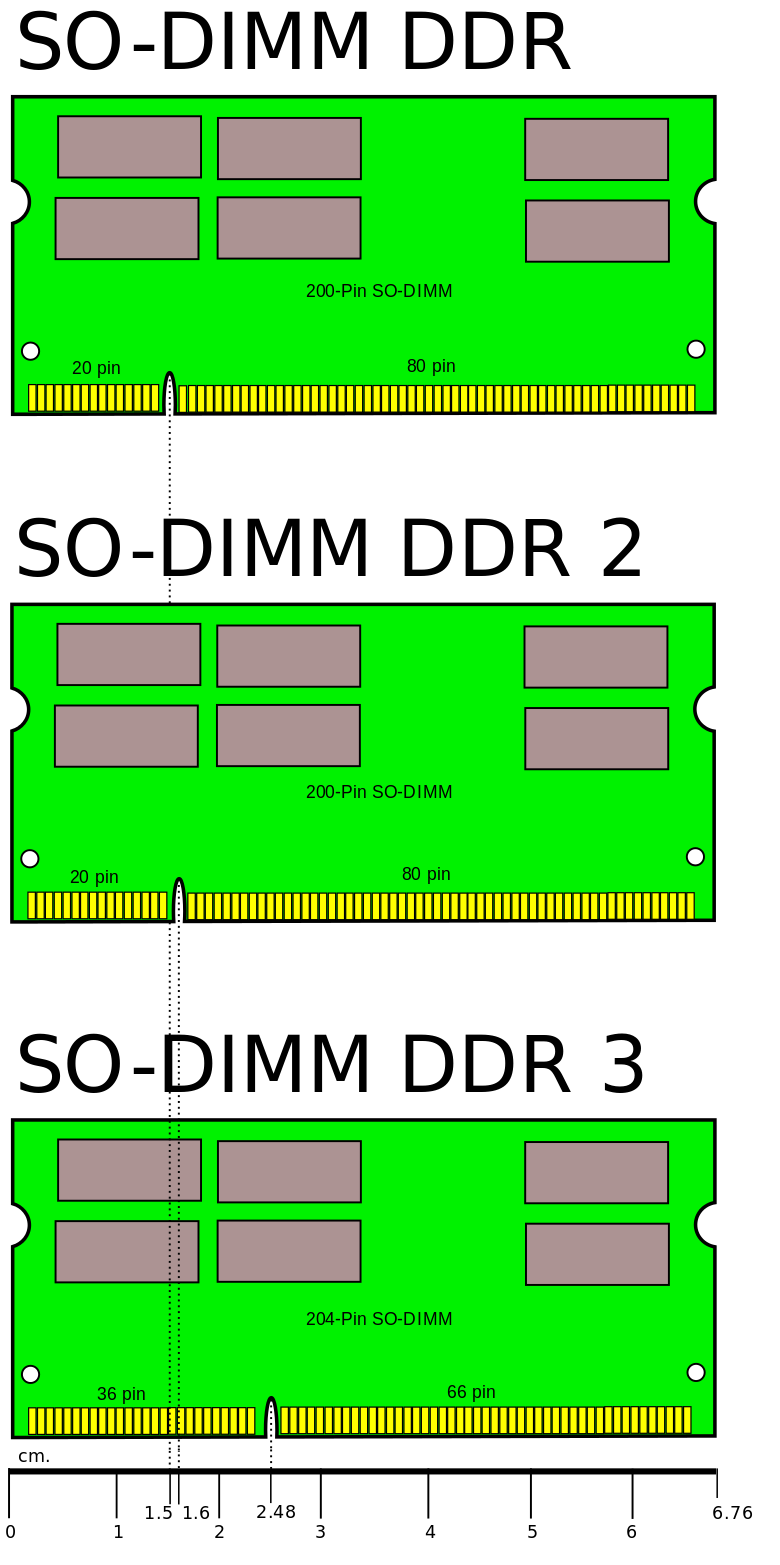

Hoy en día hacemos uso del formato DIMM (Dual In-line Memory Module) y su versión reducida SO-DIMM utilizada en portátiles.

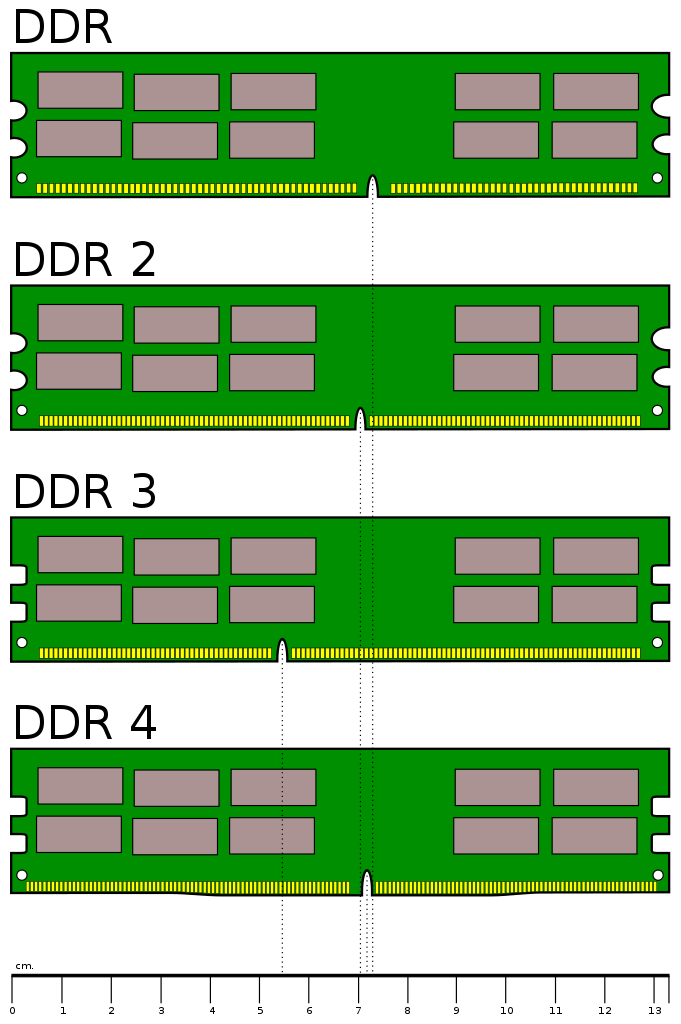

Hoy en día hacemos uso de memoria dinámica de acceso aleatorio que tiene un interfaz síncrona (SDRAM) y que tienen la capacidad de transferir simultáneamente datos por dos canales distintos en un mismo ciclo de reloj (DDR, de double data rate).

A continuación se pueden diferenciar cómo ha variado el formato físico.

En la Wikipedia podemos ver una tabla con la evolución desde DDR hasta DDR5, con todos los datos técnicos como: voltaje utilizado, número de pines, ancho de banda en MB/s…

4.2.6 Dispositivos de almacenamiento de datos

Los dispositivo de almacenamiento de datos nos permiten leer o grabar datos de forma temporal o permanente. Existen distintos tipos de dispositivos que se pueden diferenciar por formato, tamaño, tecnología, tipo de acceso, …

Si diferenciamos por el tipo de tecnología utilizada para realizar el almacenamiento podemos distinguir:

Dispositivos magnéticos: Se utilizan las propiedades magnéticas de materiales para realizar el almacenamiento de datos digitales sobre el soporte de datos. En este apartado podemos poner como ejemplo:

Unidades de cinta magnética: No sólo utilizadas para almacenar datos en informática, también se ha utilizado en formato casete para la música.

Disquete: O floppy disk, es un formato formado por una fina lamina circular dentro de una caja de plástico. Los tamaños más utilizados fueron de 8", 5 ¼" y 3½".

Discos duros: Luego profundizaremos sobre ellos.

Dispositivos ópticos: Es un tipo de unidad de disco que utiliza un láser para realizar la lectura y escritura de datos. Los formatos más habituales en informática han sido los CDs, DVDs y Blu-Ray.

Unidad de estado sólido: Conocidos como SSD (solid state drive), hacen uso de memoria flash para almacenar datos de manera persistente.

Si diferenciamos por el acceso a los datos podemos diferenciar por:

Acceso secuencial: Para realizar la lectura del dato que nos interesa debemos leer registro a registro desde el inicio hasta llegar al dato que deseamos encontrar.

Acceso aleatorio: Para realizar la lectura de un dato concreto, podemos acceder de manera directa, sin tener que pasar por el resto de datos.

Vamos a centrarnos en los denominados “discos duros” y que son más utilizados a día de hoy:

4.2.6.1 Discos duros HDD

Las unidades de discos duros (también conocidos como HDD, de hard disk drive) emplean un sistema de grabación magnética para almacenar y recuperar archivos digitales.

Están compuestos por varios platos de aluminio que giran todos a la vez sobre el mismo eje y que son recorridos por unos cabezales que están montados sobre unos brazos que recorren la superficie.

Estos cabezales son los encargados de magnetizar la superficie del plato al realizar las escrituras o leyendo la superficie para determinar cuál es el estado magnético y de esta manera conocer los datos guardados.

Fuente: Wikipedia

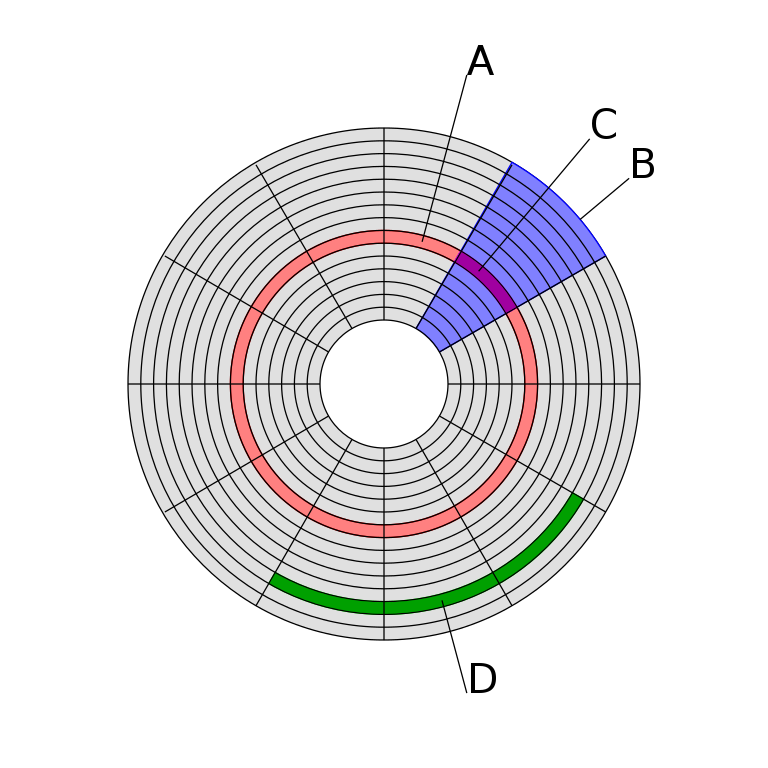

A la hora de guardar la información en los platos se sigue la estructura de la imagen superior, donde:

Es una pista del disco.

Es un sector geométrico.

Es un sector de una pista.

Es un grupo de sectores.

Si tenemos en cuenta las características de un HDD, podemos destacar:

Tiempo medio de acceso: tiempo medio que tarda el cabezal en situarse en la pista y el sector deseado.

Tiempo de lectura/escritura: tiempo medio que tarda el disco en leer o escribir nueva información: Depende de la cantidad de información que se quiere leer o escribir, el tamaño de bloque, el número de cabezales, el tiempo por vuelta y la cantidad de sectores por pista.

Velocidad de rotación: Es la velocidad de giro de los platos. Por norma general a mayor velocidad de rotación, más alta será la transferencia de datos, pero también el ruido generado y el calor producido. Se mide en RPM (revoluciones por minuto). Dependiendo del tipo de disco puede variar entre 5.400RPM en equipos portátiles a 15.000RPM para servidores.

Debido a que los discos duros utilizan partes mecánicas hay que tener cuidado al transportarlos (aunque estén parados) y con el movimiento, ya que un golpe puede romper algún componente interno.

Los discos duros HDD son propensos a golpes, debido a los componentes móviles internos

4.2.6.2 SSD

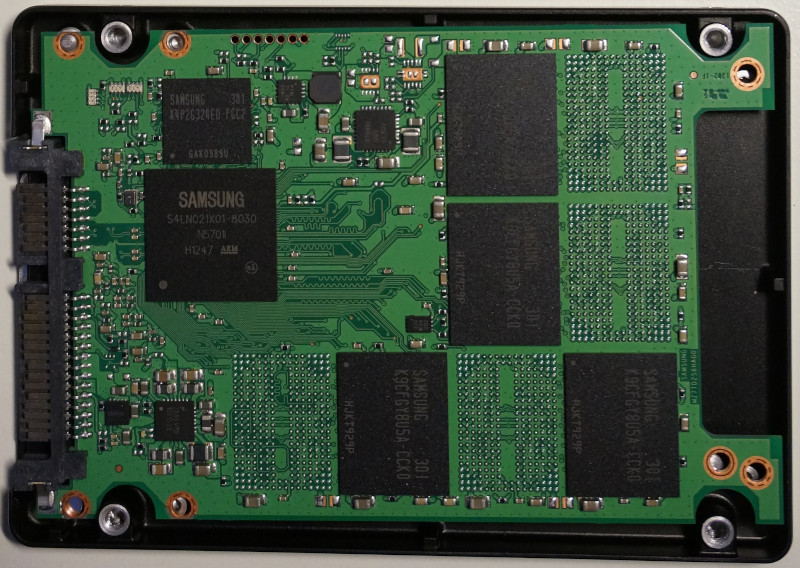

Conocidos como solid state drive, hace uso de memorias flash para el almacenamiento de datos en lugar de platos, y debido a que no tiene componentes móviles, son menos propensos a daños por golpes.

Debido a la mejora en la tecnología de guardado de datos, y por no poseer partes móviles, no generan ruido, son más ligeros, el tiempo de acceso a los datos es menor, y todo ello hace que la transferencia de datos aumente en comparación con los HDD.

Izquierda: Interior de SSD de 2,5”. Derecha: SSD conector m.2

Hoy en día la manera más habitual de usar este tipo de unidades es con el factor de forma de 2,5” o en conocido como mSATA o m.2.

4.2.6.3 NVMe

La especificación de interfaz de controlador de host de memoria no volátil (NVMHCIS, en inglés non-volatile memory host controller interface specification) que está conectado a través del bus PCI Express (PCIe). Normalmente se llama NVMe para abreviar.

Este tipo de dispositivos, al igual que el anterior, hacen uso de tecnología FLASH para el almacenamiento de datos. Debido a que están conectados al bus PCI Express, y que la especificación de acceso se creó desde cero (para aprovechar la tecnología moderna de memorias FLASH, el paralelismo de las CPUs…), consiguen un rendimiento muy superior a las generaciones anteriores.

Izquierda: NVMe en formato tarjeta PCIe. Derecha: NVMe con conector m.2

Las primeras unidades tenían un formato de tarjeta de expansión que se conectaba directamente a la ranura PCIexpress, mientras que hoy día existen los conectores M.2 para instalarlos.

4.2.6.4 Comparativa HDD, SSD y NVMe

En la siguiente tabla se puede comparar algunas características básicas de los distintos tipos de unidades de almacenamiento vistas.

| HDD | SSD | NVMe (PCIe 3.0) | NVMe (PCIe 4.0) | NVMe (PCIe 5.0) | |

|---|---|---|---|---|---|

| Conector | SATA | SATA | M.2 | M.2 | M.2 |

| Velocidad Lectura | 150MB/s | 560 MB/s | 3500 MB/s | 7000 MB/s | 14000 MB/s |

| Velocidad Escritura | 120MB/s | 510 MB/s | 3000 MB/s | 5300 MB/s | 10000 MB/s |

| Precio por TB | Bajo | Medio | Alto | Alto | Alto |

Hay que tener en cuenta que las velocidades dependen de la tecnología de la unidad y también de la conexión utilizada. Son velocidades aproximadas, y por tanto habría que ver las especificaciones técnicas de cada dispositivo antes de comprarlo.

Con las velocidades de lectura y escritura suelen indicar si es secuencial o aleatoria. En lecturas y escrituras aleatorias la velocidad es más baja.

También existen pruebas de rendimiento para sistemas de almacenamiento, por lo que es importante informarse bien antes de elegir uno.

4.2.7 Fuente de alimentación

La fuente de alimentación en un ordenador es el componente que convierte la corriente alterna a varias corrientes continuas ya que el ordenador hace uso de diferentes voltajes.

A la hora de elegir una fuente de alimentación debemos tener en cuenta:

Potencia: Se mide en vatios (W, de watts), y tendremos que tener en cuenta el consumo de los distintos componentes que tienen nuestro ordenador.

Factor de forma: En los ordenadores de sobremesa hoy en día el formato es ATX, pero podemos elegir dependiendo del tipo de conexiones:

Cableado completo: La fuente de alimentación cuenta con todo el cableado completo.

Semi-modular: Algunos de los cables que son necesarios se pueden poner y quitar, dependiendo de las necesidades que tengamos.

Full-modular: Todos los cables se pueden poner y quitar, lo que facilita la instalación de la fuente de alimentación y el orden dentro de la caja durante el montaje

Fuentes de alimentación con cableado completo, semi-modular y full-modular.

4.2.8 GPU/Tarjeta gráfica

Hoy en día es habitual contar con una tarjeta gráfica en los ordenadores personales, cuando el desempeño de su función va a requerir realizar grandes procesamientos de gráficos como: juegos, edición de vídeo, edición fotográfica, uso de dibujo asistido por ordenador, …

Podemos diferenciar:

Gráficos integrados: Hoy en día los procesadores pueden contar con una unidad de procesamiento gráfico interna, que para el desempeño del uso del ordenador y tareas livianas (ver vídeos, juegos antiguos o con pocas necesidades) puede ser suficiente.

Para confirmar si nuestro procesador tiene o no, deberíamos mirar las especificaciones técnicas del mismo (por ejemplo: Intel i7-14700KF no cuenta con procesador gráfico mientras que el i7-14700 sí).

Gráficos dedicados: Este es el caso de las denominadas tarjetas gráficas, que van conectadas a una ranura PCI-express. Nos vamos a centrar en este tipo de tarjetas.

Las tarjetas gráficas actualmente se instalan en la ranura PCI-Express de mayor velocidad de la placa base y suele contar con los siguientes componentes:

Unidad de procesamiento gráfico: O GPU, es un procesador como la CPU pero diseñado para el procesamiento gráfico. Su finalidad es la de realizar operaciones con vectores, triángulos, texturas, … lo más rápido posible.

Las tarjetas gráficas también sirven para realizar codificación/decodificación de vídeo por hardware, lo que disminuye el tiempo en comparación a realizar esa compresión a través de la CPU.

Actualmente la tecnología puntera trata de simular la luz de la manera más real posible haciendo uso del denominado raytracing.

VRAM: O memoria gráfica, son los chips que almacena y transporta información hacia la tarjeta gráfica. En el caso de las tarjetas gráficas dedicadas, cuentan con sus propios chips en la tarjeta, mientras que cuando hablamos de gráficos integrados suele ser RAM que se reserva para el uso de gráficos.

Conectores de salida: Para poder realizar la conexión entre la tarjeta y los monitores que tengamos conectados. Hoy en día lo más habitual es tener conectores HDMI y DisplayPort.

Si nuestro procesador cuenta con una gráfica integrada y aparte tenemos una gráfica dedicada, dependiendo del uso que queramos darle al ordenador, quizá sea conveniente desactivar la integrada a través de la UEFI.

Si tenemos gráfica integrada y dedicada, quizá nos interese desactivar la integrada a través de UEFI

Las compañías que crean las tarjetas gráficas también han creado SDK (Software Development Kits, o kits de desarrollo de software), como Nvidia CUDA, para poder realizar computación paralela y así aprovechar la potencia de cálculo para proyectos de machine learning, simulaciones científicas, cálculo de proteínas, secuencias de ADN, …

Podemos usar el procesamiento de la tarjeta gráfica para ayudar a la ciencia usando proyectos como Folding@Home gracias a la computación distribuida

4.2.9 Conectores más importantes

Aunque ya hemos visto de manera generalizada algunos tipos de conexiones que tiene la placa base, vamos a profundizar en este apartado separándolos por secciones.

4.2.9.1 Conectores gráficos

Al igual que el resto de componentes, los conectores para dispositivos gráficos (pantallas) han sufrido una evolución, y aunque alguno de ellos tiene muchos años, hoy día se sigue utilizando.

El conector VGA es un conector analógico que sólo envía la señal gráfica al dispositivo conectado. Hoy día, aunque se puede considerar obsoleto a nivel tecnológico, sigue estando presente en servidores y en proyectores de gama baja, ya que ofrece la suficiente calidad gráfica.

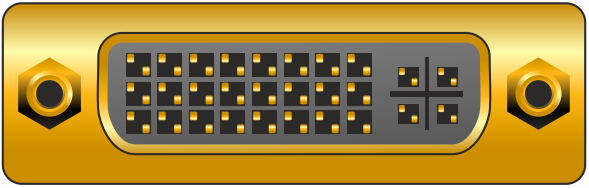

El conector DVI era el sucesor del conector anterior, y podía ser retrocompatible con VGA, aunque la idea es que este conector permitía tener señales digitales. Había diferentes tipos de conectores, dependiendo del tipo de señal que transportaba. Para portátiles también existió una versión “mini” y otra “micro”, que era más delgada.

El conector HDMI hoy en día es un estándar muy utilizado, sobre todo en televisiones, ya que permite enviar la señal gráfica y audio. Aunque el conector se mantiene igual, existen distintas revisiones que permiten mayor transmisión de datos (para tecnologías nuevas como HDR, audio con más canales, …)

DisplayPort es un interfaz digital desarrollado por la Asociación de Estándares Electrónicos de Vídeo (VESA). Es libre de licencias, y opcionalmente permite la transmisión de audio y datos (por ejemplo USB).

4.2.9.2 Conectores de dispositivos de almacenamiento

Para dispositivos de almacenamiento, como discos duros, CD-ROMs… ha habido varios tipos de conectores que es importante conocer.

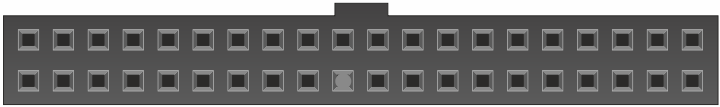

Parallel-ATA, o IDE, era un conector que se utilizaba en discos duros y lectores de CD-ROM, con el que a través de un único cable podían conectarse dos dispositivos. Debido a esto, los dispositivos tenían un “jumper” que identificaba si era el “maestro” o “esclavo”.

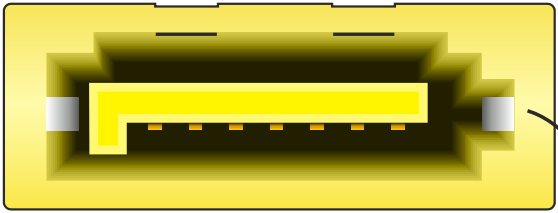

Serial-ATA, o SATA, es la evolución del conector anterior. Es un conector más pequeño pero que permite más velocidad. Ha habido distintas versiones (siendo todas retrocompatibles), siendo la última SATA 3 (subversión 3.5), que admite hasta 600MB/s.

M.2, es el nuevo conector que incluyen los nuevos discos duros de estado sólido NVMe.

4.2.9.3 USB

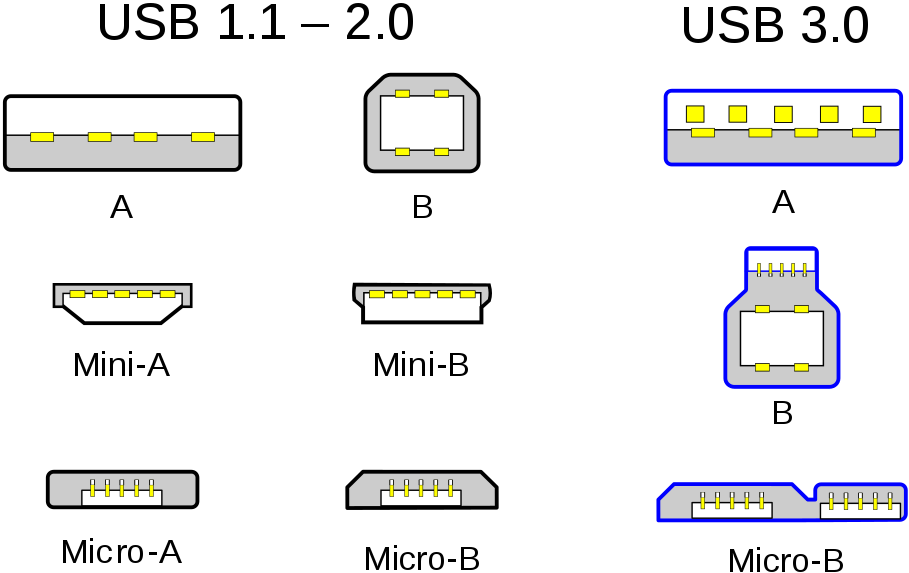

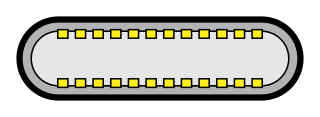

El USB (Universal Serial Bus) es un estándar que define los cables, conectores y protocolos que más se utiliza hoy en día para conectar ordenadores y una infinidad de tipos de dispositivos.

Aunque se creó a mediados de los 90, su conector más utilizado (el tipo-A) apenas ha variado (buscando ser retrocompatible), pero sí su velocidad.

Para la nueva especificación USB-C trajo consigo un nuevo conector que es reversible (se puede conectar en ambas direcciones), con idea de reemplazar todos los conectores anteriores. La idea es que ambos dispositivos (anfitrión y huésped) se hace uso del mismo conector y el cable que los una llegue a ser universal, teniendo en cuenta la especificación que utilice.

Las placas bases tienen varios conectores USB typo-A soldados para poder realizar conexiones, pero también tiene conexiones en la placa para poder tener más USB (por ejemplo, gracias a los que vienen en la caja).

Estos conectores externos tienen un cable que se conectan a unos pines en la placa base, que dependiendo del protocolo, tendrán una forma u otra (por eso es importante ver el manual de la placa base).

4.2.9.4 Conexiones de red

Para que nuestro ordenador se pueda conectar a una red, las placas base ya tienen incorporado al menos un conector para ello.

El conector RJ-45 es el utilizado en redes de ordenadores que contiene cuatro pares de cables de cobre para realizar la transmisión de datos a través del protocolo ethernet, que veremos más adelante.

El conector SMA se utiliza en algunos tipos de antenas WiFi desmontables que nos podemos encontrar en algunos routers, placas base, tarjetas PCI… Es un conector enroscable y fácilmente desmontable.

4.2.9.5 Otros conectores

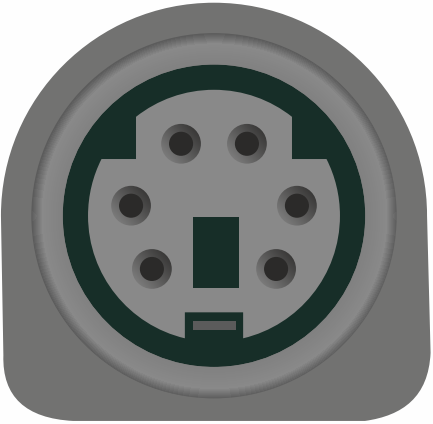

PS2 era el conector utilizado para realizar la conexión de teclados y ratones antes de la llegada del USB. Normalmente venía con dos colores, violeta para el teclado y verde para el ratón, ya que aunque el conector era el mismo, el teclado requiere en ambos lados un colector abierto para permitir la comunicación bidireccional.

El jack de 3,5mm es el conector más utilizado para audio analógico desde hace muchos años en el ordenador, a pesar de que su aparición (en distinto tamaño) es del año 1878. Hoy en día las placas base tienen distintos conectores para introducir estos jacks dependiendo de si es para altavoces, micrófono, sonido envolvente…

El conector RS232 (también conocido como “puerto serie”), es un interfaz que permite el intercambio de datos binarios entre dos equipos. Originalmente para mandar información a un terminal de datos, y posteriormente muy utilizado en switches. Aunque hoy en día las placas base no tienen el conector externo, suelen tener los pines de conexión para añadir un adaptador.

Desde que los ordenadores se hicieron populares en la década de los 80 hasta ahora ha habido muchos otros tipos de conectores que han llegado a los ordenadores de consumo personal.

También ha habido otros muchos tipos de conectores que se han quedado en el ámbito más profesional (transceiver SFP, conectores SAS para discos duros, …) por lo que es imposible abarcarlos a todos.

4.2.9.6 Conector, protocolo y cables: errores frecuentes

Hemos visto distintos conectores que durante años su forma física no ha variado, buscando ser retrocompatible con versiones anteriores, pero que la transmisión de velocidad sí se ha ido incrementando a lo largo de los años.

Algunos ejemplos:

PCI

USB

SATA

HDMI

DisplayPort

Es por eso que es importante entender y comprender que la forma del conector hoy en día no nos tiene por qué indicar la velocidad de transmisión máxima que acepta el dispositivo conectado, y por eso deberemos ir a las especificaciones técnicas de la placa base o el dispositivo concreto.

Por otro lado, con los cables sucede lo mismo. Debemos confirmar y asegurar que los cables que utilizamos van a ser capaz de transmitir la velocidad máxima que tanto dispositivo como placa base aceptan.

Es importante conocer las especificaciones técnicas de cada componente y cable que usemos, para no realizar ningún cuello de botella.

4.2.10 Caja del ordenador

La caja del ordenador, o chasis, es la estructura metálica donde se introducen (de manera ordenada, y anclando mediante tornillos) los distintos componentes que hemos visto hasta ahora.

Existen distintos tipos de caja, normalmente variando el tamaño, por lo que es importante adecuar la caja a los componentes que queramos albergar dentro.

Cuidado con comprar una caja demasiado pequeña y que luego la placa base, o la anchura de la tarjeta gráfica no entre

Los servidores cuentan con unas cajas de tamaño estandarizados en altura, denominado “Unidad de Rack” (rack unit en inglés, o simplemente “U”), cuya unidad equivale a 44.45 milímetros. De esta manera los servidores contarán con una altura fijada para poder ser instalados en un bastidor rack.

4.3 Arranque de un ordenador

Una vez el hardware está instalado, es momento de entender cómo funciona el sistema de arranque de nuestro ordenador hasta llegar al Sistema Operativo.

Toda la secuencia de arranque se puede dividir en distintas etapas que vamos a ver a continuación:

Se acciona el botón de encendido del equipo (o arranca el equipo tras un reinicio).

Se carga la BIOS/UEFI y se comienza a ejecutar.

Se realiza el Power-On Self-Test (POST), que es una secuencia que comprueba el estado de los componentes hardware. En caso de que algún componente no parezca estar correcto, la placa base emitirá sonidos. Si este paso falla, no continuará el proceso.

Es habitual que si algún componente falla, la placa base emita uno o varios tonos (si tiene un pequeño altavoz) de distinta duración

Comprobación del procesador

Se comprueba el estado de la RAM y la cantidad instalada

Comprueba el estado de la memoria de vídeo.

Inicializa los sistemas de acceso a dispositivos de almacenamiento (IDE, Serial-ATA, NVMe…).

La BIOS/UEFI comprueba el número de discos duros existentes. Se comprueba la tabla de particiones del disco duro indicado como primario para el arranque.

Se ejecuta el gestor de arranque de la tabla de particiones marcada como arrancable.

El gestor de arranque prepara todo lo que necesita el Sistema Operativo para funcionar, lo carga y le transfiere la ejecución a él.

5 Particionado y sistemas de ficheros

Anteriormente hemos visto que los sistemas de almacenamiento (más conocidos como discos duros) son dispositivos que pueden ser de distintos tipos, capacidades, tamaños...

A la hora de usar un disco duro en nuestro Sistema Operativo, tenemos que tener en cuenta al menos dos cosas:

Tipo de particionado.

Sistema de ficheros.

Dependiendo del Sistema Operativo, y el modo que elijamos durante la instalación, nos dará más opciones o menos a la hora de elegir, modificar o personalizar algunas de estas opciones.

Para tomar las decisiones correctas, deberíamos conocer, al menos, los siguientes detalles:

Número de discos duros instalados en el equipo.

El tipo de cada uno (mecánico, SSD, NVMe...).

Tamaño de los mismos.

Función que va a realizar el equipo.

De esta manera, podremos realizar un análisis previo de cómo queremos realizar la instalación.

5.1 Particionado MBR y GPT

Los discos duros se dividen en lo que se llaman particiones. Es una manera de realizar divisiones lógicas del espacio, que actúan de forma independiente entre sí.

El símil del particionado de disco duro es un armario: tenemos una cantidad de hueco posible, que decidimos “particionar” añadiendo estanterías tanto horizontales como verticales, donde almacenar distintos tipos de ropa, de manera independiente, en cada uno de esos compartimentos.

A la hora de crear la tabla de particiones de un disco duro podemos elegir entre los siguientes tipos:

MBR: De Master Boot Record, o también conocido como tabla de particiones DOS.

GPT: De GUID Partition Table, propuesta por la especificación EFI, más moderna que la anterior.

En la siguiente tabla se pueden identificar algunas de las diferencias más destacadas entre ambos sistemas, y tal como se puede ver, las ventajas que se incorporan en GPT hacen que el sistema sea más robusto:

| MBR | GPT | |

|---|---|---|

| Tamaño máximo de partición | 2 TB | 18 Exabytes |

| Nº de particiones primarias | 4 | Ilimitado (Windows reconoce 128) |

| Tabla de particiones | Al inicio | Al inicio y al final (backup) |

| ID de la partición | Se almacena en la partición | Identificador único de GUID |

| Soporte de arranque múltiple | Débil | Las entradas del gestor de arranque están en una partición separada |

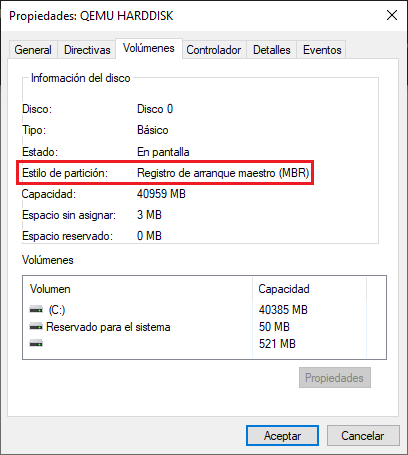

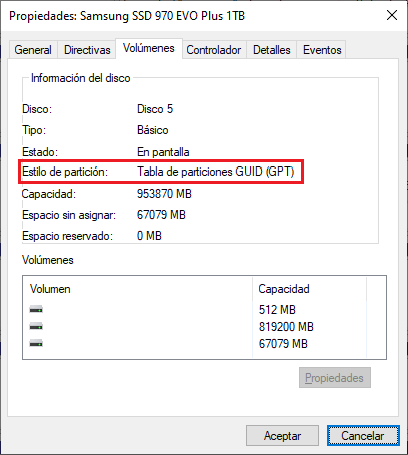

En la siguiente imagen se puede ver la diferencia entre ambos sistemas al crear la tabla de particiones:

Para comprobar cuál es el sistema de particiones de nuestro disco duro lo podemos hacer desde:

En Windows: Desde el administrador de discos duros.

En GNU/Linux: Con GParted, fdisk, ...

A continuación se pueden ver capturas de pantalla de distintos discos en un equipo Windows.

5.2 RAID

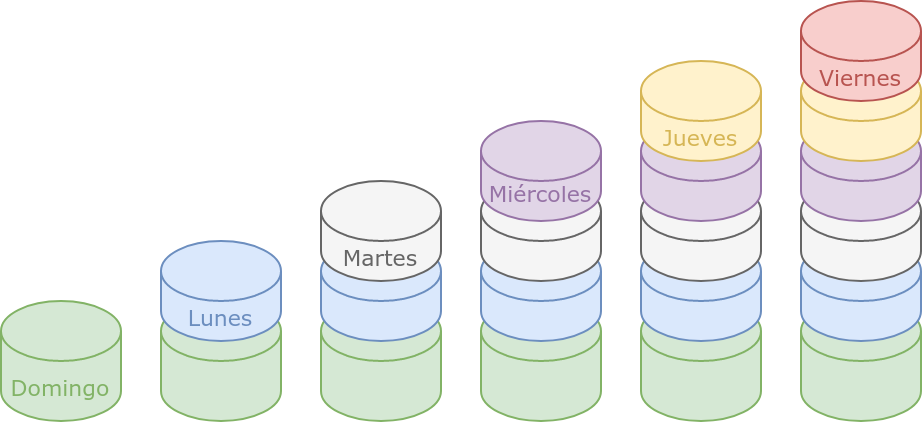

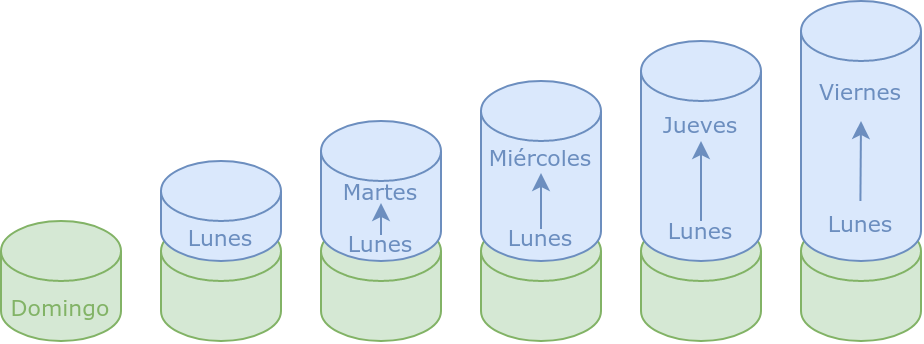

RAID (en inglés redundant array of independent disks) es un grupo o matriz redundante de discos independientes que hace referencia a un sistema para crear una unidad de almacenamiento lógica utilizando varias unidades de almacenamiento. De esta manera, el sistema operativo sólo ve un único almacenamiento lógico, que “por detrás” utiliza varios.

Dependiendo del tipo de grupo creado, los datos se distribuirán o se replicarán entre las unidades que forman el grupo.

A la hora de crear un sistema RAID, podemos hacerlo de dos maneras:

RAID por hardware: Existe un hardware especializado que se encarga de realizar las operaciones del sistema RAID, así como de crearlo, gestionarlo, hacer las operaciones de paridad necesarias... Podemos diferenciar dos sub-tipos:

Placa Base: Algunas placas base tienen un controlador especializado que se encarga de la creación del RAID, que se puede gestionar desde el sistema UEFI.

Tarjeta controladora especializada: Este sistema es el más profesional. Los discos duros en lugar de ir conectados a la placa base, se conectan a esta tarjeta (normalmente a través de unos cables especiales que se conectan por SATA al disco duro y mediante conectores especiales a la tarjeta). Hay veces que cuentan con una batería propia (para controlar la escritura en caso de que el servidor se quede sin alimentación) y con un menú propio de configuración.

RAID por software: El Sistema Operativo se encarga de crear y gestionar el sistema RAID. En caso de necesitar realizar paridad, la CPU se encargará de ello, quitando recursos a otros procesos.

Tal como se puede ver en la Wikipedia, existen distintos tipos de RAID, que también pueden combinarse entre sí, pero a continuación se explicarán los más estándares.

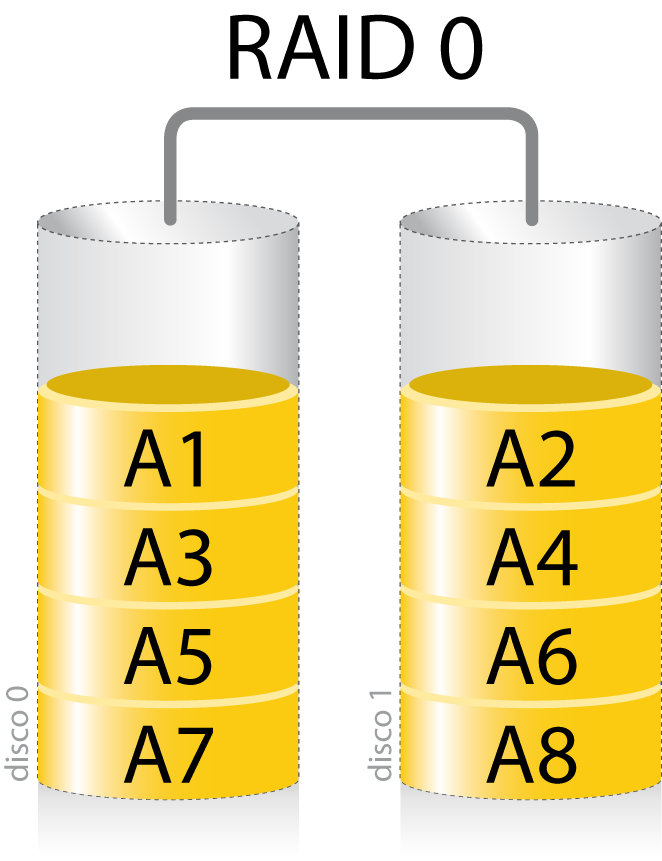

5.2.1 RAID 0

Un sistema RAID 0 distribuye los datos de manera equitativa entre dos o más discos, sin hacer uso de información de paridad. RAID 0 no habilita redundancia, por lo que si uno de los discos duros del sistema se estropea, se perderán todos los datos.

Espacio total = sumatorio del espacio de los discos.

Con este sistema se puede conseguir una mayor velocidad de escritura, ya que los datos se escriben de manera simultánea en todos los discos.

No se aconseja utilizar RAID 0 en sistemas con datos importantes.

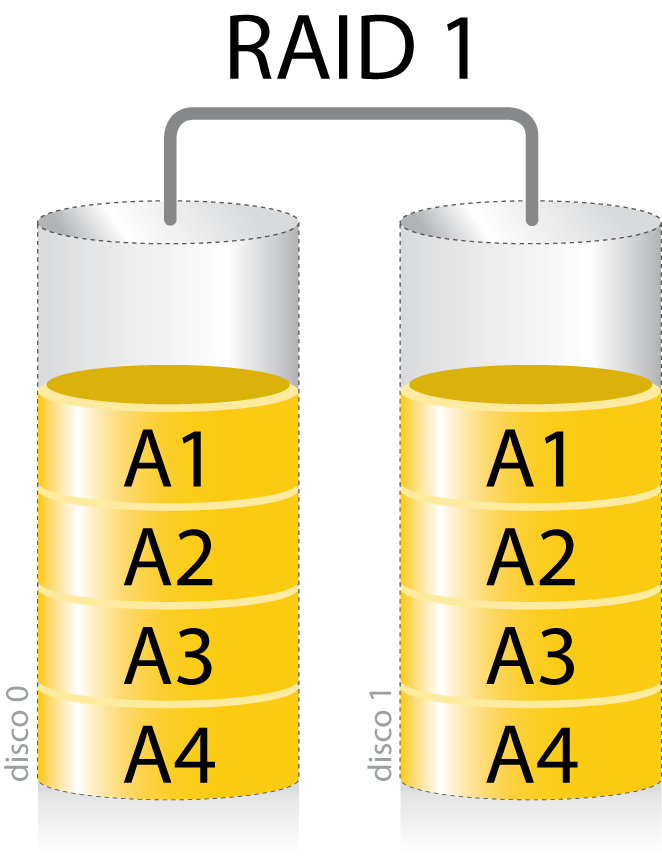

5.2.2 RAID 1

El RAID 1, también conocido como RAID espejo, crea una copia exacta de los datos en dos o más sistemas de almacenamiento.

Resulta útil cuando queremos tener seguridad a la hora de preservar los datos a pesar de no aprovechar la capacidad total del conjunto de los discos. Si uno de los discos falla, los datos no se pierden.

El RAID 1 sólo puede ser tan grande como el más pequeño de los discos.

No se mejora el rendimiento en escritura, pero en la lectura el tiempo se reduce al poder usar varios discos de forma simultánea.

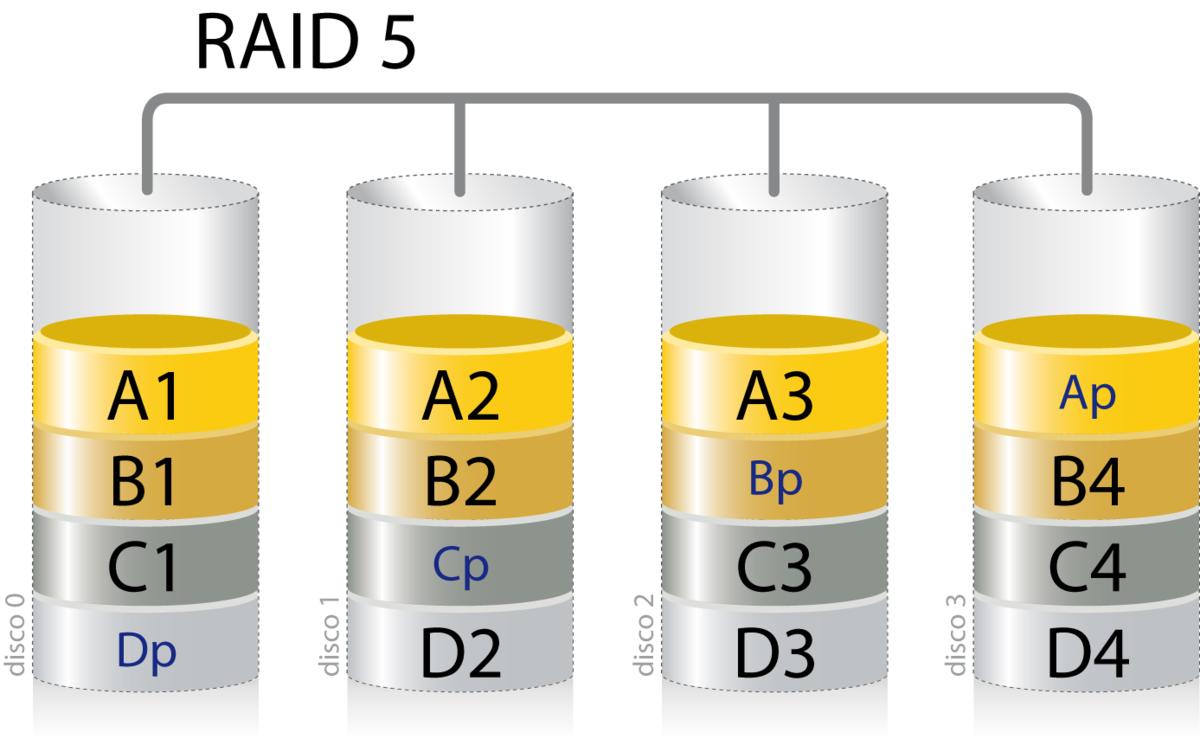

5.2.3 RAID 5

RAID 5 es una división de los datos a nivel de bloques que distribuye la información entre el conjunto de discos que lo forman, y añadiendo paridad. La paridad se utiliza para poder corregir errores o generar los datos en caso de pérdida de uno de los discos.

Para crear un sistema RAID 5 se necesitan al menos 3 discos duros, quedando uno de ellos “inutilizado” en lo que se refiere a guardar información.

El volumen total = (n-1)*tamaño de disco más pequeña, donde “n” es el número de discos que forman el RAID 5. Si tenemos 3 discos de 2TB, el tamaño total será = (3-1)*2TB = 4TB.

En caso de rotura de un disco duro, los datos se mantienen, pero el sistema RAID 5 no soportaría la rotura de un segundo disco duro. Es por ello que cuando sucede esto, hay que sustituir el disco dañado para que se regeneren los datos en el nuevo disco duro, gracias al sistema de paridad.

5.2.3.1 Discos spare/reserva

Existen variantes de RAID 5, y algunas controladoras hardware también implementan, la posibilidad de tener discos denominados “hot spare”, o de reserva.

Estos discos están conectados (a la controladora, o la placa base) pero sin estar dentro del grupo RAID. Entrarán a formar parte del grupo en el momento en el sistema detecte que uno de los discos pertenecientes al grupo está fallando, y por tanto el sistema RAID esté degradado.

De esta manera, al entrar en el grupo, el RAID comenzará a arreglarse de manera automática sin tener que esperar a que el administrador de sistemas se entere de que ha habido algún error.

5.3 Sistemas de ficheros

Los sistemas de ficheros controlan cómo se almacenan y recuperan los datos. Sin un sistema de archivos, los datos colocados en un medio de almacenamiento serían un gran cuerpo de datos sin manera de saber dónde termina un dato y comienza el siguiente. Un sistema de ficheros se crea sobre una partición creada previamente, que a su vez está en un disco duro:

Un sistema de ficheros nos proporciona una “vista lógica” de cómo se almacenan los datos.

Las funciones principales de los sistemas de ficheros son:

Asignar espacio a los archivos.

Administrar el espacio libre (reorganizándolo en caso necesario).

Provee una API a los programas para crear, borrar, modificar y cerrar los ficheros.

Permite gestionar el acceso a los ficheros (permisos de ficheros).

Optimizar el rendimiento de acceso.

5.3.1 Ficheros

Un fichero (o archivo) es una secuencia de bytes almacenado en un dispositivo que es identificado por un nombre y normalmente una extensión. Los ficheros pueden ser almacenados en directorios, y estos a su vez en otros directorios.

En inglés sí existe distinción entre file y archive siendo la diferencia:

File: Es un conjunto de información que se almacena de manera conjunta. Cómo se almacena esa información depende de cómo se ha diseñado el programa que lee y/o escribe esa información.

Archive: Un archivo es un conjunto de ficheros almacenados junto con metadata (datos que aportan información sobre datos). El ejemplo más claro puede ser un archivo comprimido, archivos que permiten distribuir programas, ...

Los ficheros cuentan con un nombre para que los podamos identificar. Dependiendo del sistema de ficheros puede ser:

Case sensitive: O sensible a mayúsculas/minúsculas. Esto quiere decir que “hola.txt” y “HOla.txt” son dos ficheros distintos.

Case insensitive: O insensible a mayúsculas/minúsculas. No puede haber dos ficheros con las mismas letras en el mismo orden, aunque sean mayúsculas y minúsculas. “hola.txt” y “HOla.txt” no pueden convivir en el mismo directorio.

Los ficheros suelen contar con una extensión, que va después del nombre seguido de un punto, y normalmente suele ser de 3 letras para la mayoría de casos. Estas extensiones sirven para conocer el tipo de fichero a simple vista, pero no determina el contenido del fichero.

La extensión no determina el tipo de fichero que es. Si renombramos un fichero con una extensión, el contenido del fichero sigue siendo el mismo

Un pequeño listado de extensiones habituales que podemos identificar:

Documentos de texto y ofimáticos: .txt, .doc, .docx, .xls, .xlsx, .ppt, .pptx, .odt, .odp, .ods, .pdf ...

Ficheros multimedia, imagen, audio, vídeo: .png, .jpg, .jpeg, .tiff, .ps, .bmp, .svg, .gif, .mp3, .mp4, .avi, .mpg, .mpeg, .mkv, ...

Archivos comprimidos: .zip, .bz2, .gz, .gzip, .7z, .rar, .r00, ...

Archivos de programación: .c, .java, .class, .py, .php, .rb, .pl, .sh, ...

En los sistemas Windows las extensiones están ocultas en el explorador de archivos, por lo que para un usuario sin conocimientos, no existen.

5.3.2 Sistemas de ficheros más utilizados

Existen muchos sistemas de ficheros, y cada Sistema Operativo suele utilizar uno por defecto, que es el que está optimizado para sus funciones. Eso no quita que pueda hacer uso de otros sistemas de ficheros en otros dispositivos.

Los Sistemas Operativos utilizan un sistema de ficheros predeterminado, pero suelen poder acceder a dispositivos que hagan uso de otros

A continuación se expone una tabla con los sistemas de ficheros predeterminados de distintos Sistemas Operativos y los sistemas de fichero que pueden leer por defecto:

| Sistema Operativo | Sistema de Ficheros | También puede leer |

|---|---|---|

| DOS, Windows 95 | ||

| Windows 95 OSR2, Windows 98 | FAT16, FAT32 | |

| Windows NT, 2000, XP,… Windows 10, Windows 11 | NTFS (varias versiones) | FAT16, FAT32 |

| Windows Server > 2012, Windows 11 | NTFS, ReFS | FAT16, FAT32, NTFS |

| GNU/Linux | Ext4, ReiserFS | La gran mayoría |

| MacOS | HFS+, APFS | FAT16, FAT32 |

Existen programas y drivers para permitir que los sistemas operativos puedan leer otros sistemas de ficheros que no pueden en origen. A veces pueden tener limitaciones (en la escritura, permisos, ...).

En la Wikipedia existe un listado con distintas características de un gran listado de sistemas de ficheros. A continuación parte de esa información:

| FAT 32 | NTFS | ReFS | EXT-4 | APFS | |

|---|---|---|---|---|---|

| Nombre de fichero max. | 8.3 (255) | 255 | 255 | 255 | 255 |

| Volumen max. | 16TB | 16TB | 1YB | 1 EB | ? |

| Tamaño max. fichero | 4GB | 16TB | 16EB | 16TB | 8 EB |

| Permisos | No | Si | Si | Si | Si |

| Compresión | No | Si | No | No | Si |

| Cifrado | No | Si | No/Si | Si | Si |

Debido a que los sistemas de ficheros van adquiriendo características nuevas, es posible que algunas no estuviesen en las primeras versiones y fueran añadidas a posteriori.

5.4 Jerarquía de directorios

A la hora de almacenar la información en un sistema de ficheros, se hace siguiendo una jerarquía de directorios. Esta jerarquía de directorios es creada por el sistema operativo durante la instalación y en ella se almacenan los ficheros necesarios para el sistema.

Posteriormente la jerarquía puede ser expandida para guardar información de usuarios, o para que programas y servicios puedan guardar y utilizar información. La estructura inicial debe ser conservada y no se debe modificar si no estamos seguros de lo que hacemos.

Los directorios y ficheros creados durante la instalación del Sistema Operativo forman parte de una estructura “inmutable”. Si se modifican/mueven es posible que el sistema deje de funcionar. ¡CUIDADO!

5.4.1 Sistemas Windows

Microsoft comenzó a utilizar el sistema denominado “letra de unidad” con el lanzamiento de MS-DOS, aunque no fueron los primeros en utilizarlos.

Este sistema utiliza una letra del alfabeto para identificar los volúmenes o unidades lógicas de sistemas de almacenamiento.

Tanto en MS-DOS como en Windows, se denomina de la siguiente manera:

A:\ Es la unidad de disquete.

B:\ Reservada para la segunda unidad de disquete.

C:\ Partición o disco duro principal. Donde se instala el sistema operativo y los programas.

D:\ Reservado para el CD-ROM/DVD-ROM.

E:\ hasta Z: para otro discos duros, particiones, CD-ROMs/DVD-ROM, sistemas extraíbles de almacenamiento...

También se puede utilizar este sistema para carpetas compartidas por red, aunque no es necesario.

5.4.2 GNU/Linux

En los sistemas operativos GNU/Linux (aunque también sucede en las variantes UNIX como FreeBSD y MacOS) la jerarquía comienza en un único punto representado con “/” denominado directorio raiz o “barra”.

El Filesystem Hierarchy Standard (FHS) es la referencia para conocer dónde se deben almacenar los ficheros dentro de la jerarquía, siendo algunos de los directorios más conocidos. Más adelante hablaremos de ello.

6 Software

El software es el elemento lógico que forma parte del ordenador, todo aquello que es “intangible”. Es el conjunto de programas y datos que permiten manejar el hardware, controlando y coordinando su funcionamiento para que realice las tareas deseadas.

Dentro del software podemos diferenciar distintos tipos (aunque existen otras categorizaciones):

Software de sistema: Son aquellos programas que permiten la administración del hardware (de los recursos físicos). Crean una capa de abstracción entre el hardware y los programas que utiliza el usuario. Dentro de este apartado podemos incluir: sistemas operativos, drivers (controladores), herramientas de diagnóstico, ...

Software de desarrollo: Son aquellos programas que los desarrolladores de software utilizan para crear, depurar y mantener programas.

Software de aplicación: En esta categoría entran los programas que tienen una función específica y que normalmente son utilizados por los usuarios finales del sistema.

A partir de aquí profundizaremos en cada uno de estos aspectos en los capítulos siguientes.

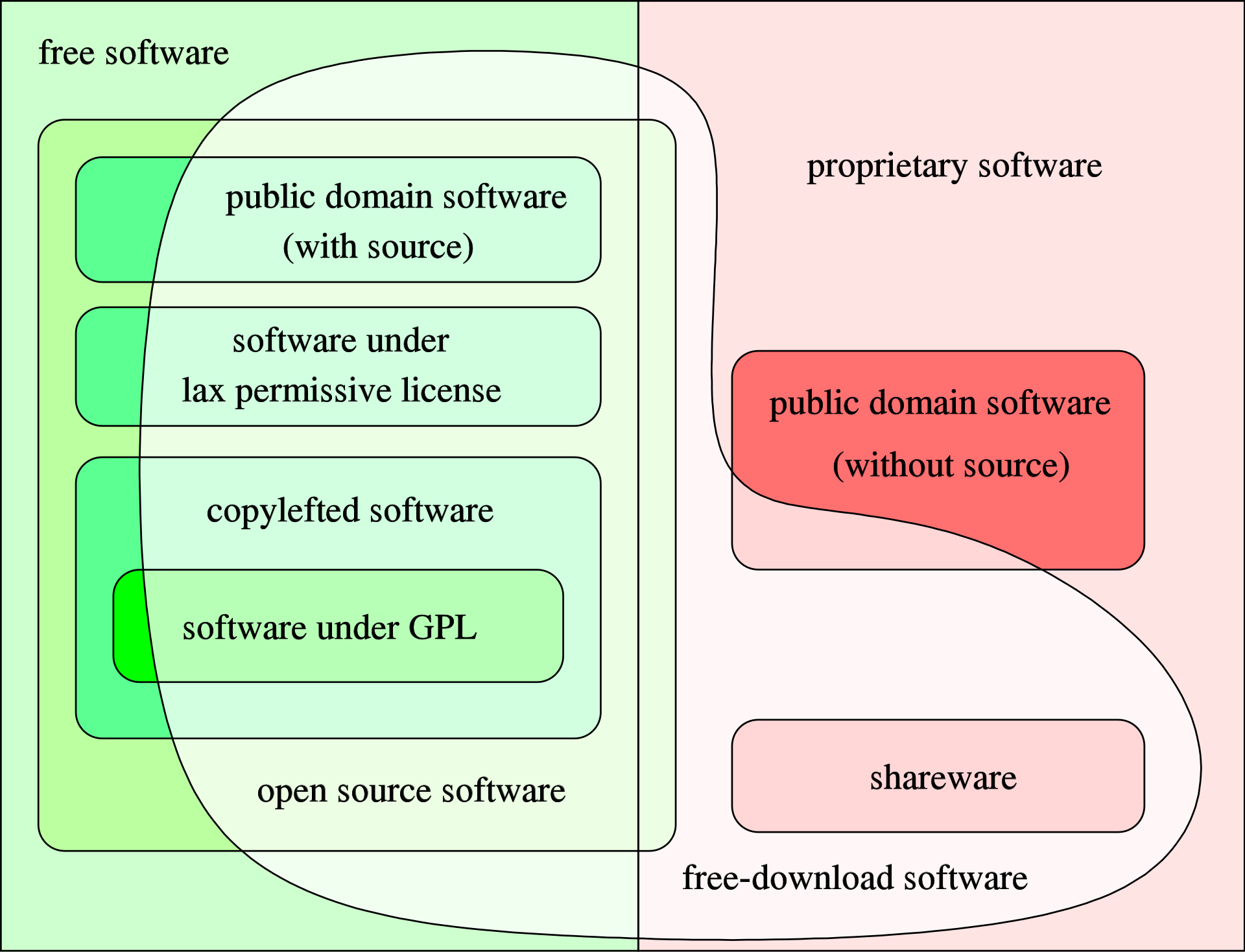

6.1 Licencias de Software

A la hora de utilizar cualquier tipo de software lo habitual es que tengamos que aceptar una licencia, que es un contrato entre el licenciante (autor o titular de los derechos de explotación y/o distribución del software) y el licenciatario (el usuario o consumidor final).

Las licencias incluyen una serie de términos y condiciones, que son un conjunto de permisos que el autor otorga al usuario.

Algunos ejemplos de condiciones en una licencia pueden ser:

Definir el tipo de uso.

Limitar/permitir la distribución del software.

Plazo de cesión de los derechos.

Limitar/permitir la modificación del software.

6.1.1 Software privativo

En contraposición al Software Libre se encuentra el software privativo, el cuál no permite el acceso al código fuente, ya que sólo se encuentra a disposición de los desarrolladores, no permitiendo su libre modificación, adaptación o distribución.

Dentro de este tipo de software podemos encontrar algunos tipos de licenciamiento conocidos:

Freeware: Normalmente se utiliza para el software que es gratuito pero que no permite la modificación del mismo.

Shareware: El usuario puede evaluar de forma gratuita el producto, durante un tiempo limitado o con una funcionalidad limitada.

Entre el software más utilizado que es software privativo nos podemos encontrar a: Windows, Photoshop, juegos comerciales, ...

6.1.2 Software de dominio público

Es aquel que el autor decide publicarlo bajo el denominado dominio público, lo que hace que cualquiera pueda acceder al código fuente, modificarlo pero también publicarlo bajo una licencia no libre.

Este tipo de licencia suele ser aplicada a libros y música, por ejemplo, tras 70 años después de la muerte del autor.

7 Sistemas Operativos

El Sistema Operativo (SO) es el software que controla el hardware del ordenador, creando recursos lógicos y servicios que otro software y los usuarios pueden utilizar.

De manera muy simplificada, el núcleo del Sistema Operativo crea una abstracción del hardware real, limitando el acceso al mismo a los programas para gestionar su buen funcionamiento.

7.1 Funciones principales

Entre las funciones más importantes de las que se encarga el Sistema Operativo, destacaremos:

Gestionar los procesos en ejecución: El sistema operativo se encarga de cargar el proceso que queramos ejecutar y de asignarle los recursos necesarios para su correcto funcionamiento. También se encarga de las posibles peticiones de los procesos, de pausarlos, de asignarles el procesador cuando le corresponda...

Gestionar la memoria RAM: La memoria RAM es finita en el ordenador, y cuando ejecutamos un proceso este se carga en RAM para poder ser ejecutado. Si un proceso necesitase más memoria, será el sistema operativo el que se encargue de asignarle más en caso de que haya libre. Cuando los procesos mueren, esa memoria debe ser liberada, para que otros procesos puedan utilizarla.

Administrar la CPU gracias a un algoritmo de programación: El sistema operativo coordina el uso de la CPU entre las diferentes tareas y procesos que se ejecutan en el sistema. Utiliza algoritmos de programación para determinar el orden y la prioridad de ejecución de los procesos, asegurando un uso equitativo de los recursos de la CPU.

Gestionar las entradas y salidas de datos a través de los periféricos: Además de direccionar las entradas y salidas de datos, el sistema operativo proporciona controladores (drivers) para interactuar con los periféricos de entrada y salida, como teclados, mouse, impresoras, discos duros externos, entre otros. Estos controladores permiten que los dispositivos se comuniquen correctamente con el sistema operativo y las aplicaciones.

Asegurar el buen funcionamiento del sistema: El sistema operativo gestiona información esencial para el funcionamiento del sistema, como la tabla de procesos, la tabla de archivos abiertos y otros datos relevantes. Además, realiza la gestión del rendimiento para asegurar un funcionamiento óptimo del sistema.

Seguridad: El sistema operativo proporciona un mecanismo de autenticación y autorización para garantizar que los usuarios accedan solo a los recursos y funciones para los cuales tienen permisos. Esto incluye la gestión de cuentas de usuario, contraseñas y asignación de privilegios.

Administrar los archivos: El sistema operativo maneja las operaciones relacionadas con la gestión de archivos, como la creación, modificación, eliminación y acceso a los archivos en el sistema de almacenamiento.

7.2 Breve historia de los sistemas operativos