Sistemas de Gestión Empresarial

1 Introducción

La informática es un área de la ciencia que abarca distintas disciplinas teóricas (como la creación de algoritmos, teoría de computación, teoría de la información, ...) y disciplinas prácticas (diseño de hardware, implementación de software).

A la hora de crear programas (o software), podemos identificarlos de distintos tipos:

Software de sistema: Programas o aplicaciones que pertenecen al sistema y nos ayudan a mejorarlo, administrarlo ... Pueden ser aplicaciones de monitorización, de auditoría de logs, drivers, ...

Software de desarrollo: En este caso serán aplicaciones que nos ayudarán a crear otras aplicaciones. Por ejemplo: librerías de funciones, compiladores, debuggers, IDEs...

Aplicaciones de usuario: Son aplicaciones que los usuarios finales utilizarán en su día a día. Podríamos diferenciarlas como:

Aplicaciones generalistas: Son aquellas que cualquier tipo de usuario utilizará en cualquier momento. Son creadas con un propósito específico, pero que no hay que tener grandes conocimientos para usarlas. Por ejemplo: navegadores web, clientes de correo, aplicaciones de ofimática simple, calculadora, calendario, ...

Aplicaciones de uso específico: En este caso son aplicaciones creadas para un usuario específico, con una utilidad muy concreta y que normalmente deben existir conocimientos para utilizarla.

Pueden ser aplicaciones no muy complejas, pero cuya utilidad, o lo que hagan, tenga importancia y conste de procesos complejos. Por ejemplo: aplicaciones CAD, sistemas de virtualización, aplicaciones científicas (R, JupyterLab), aplicaciones empresariales, ...

En esta asignatura veremos distintos tipos de software especializado dentro de la gestión empresarial como son los ERP y los CRM, que podríamos englobar como sistemas de información.

2 Sistemas de información

Un sistema de información, de manera generalizada, es aquel que ayuda a administrar, recolectar, recuperar, procesar, almacenar y distribuir información relevante para ser usados dentro de los procesos fundamentales de una organización.

Normalmente estos sistemas de información son fáciles de usar, tienen cierto grado de flexibilidad (se pueden adaptar a las empresas), permiten guardar y recuperar información de manera rápida y sencilla.

De esta manera, la información resultante será más valiosa para la propia organización, ya que tendrá una “imagen” más amplia y habiendo podido relacionar más información que de no haber utilizado este tipo de software.

2.1 Componentes

Un sistema de información debe contar con los siguientes componentes básicos, que deben interactuar entre sí de manera adecuada para un buen funcionamiento global:

El hardware, equipo físico utilizado para procesar y almacenar datos.

El software y los procedimientos utilizados para transformar y extraer información.

Los datos que representan las actividades de la empresa.

La red que permite compartir recursos entre computadoras y dispositivos.

Las personas que desarrollan, mantienen y utilizan el sistema.

El último punto es muy importante, ya que de nada sirve tener la mejor herramienta, en el mejor hardware, si luego las personas que van a hacer uso de ella no tienen los conocimientos suficientes.

Las personas que utilizan los sistemas de información deben tener los conocimientos adecuados para su correcta utilización.

Es por eso que las personas que hagan uso del sistema de información deberán ser entrenadas y/o tener manuales para su correcto uso, así como también tener en cuenta sus opiniones para mejorar los procesos internos de la empresa.

2.2 Datos vs información

Los datos reflejan hechos recogidos en la organización y que están todavía sin procesar (reflejan valores o resultados de mediciones). Estos datos serán hechos o cifras sobre algún tema específico concreto, que a simple vista no tienen por qué decir nada.

Por otro lado, la información se obtiene una vez se han procesado, agregado y/o presentado de manera adecuada esos datos para que puedan ser útiles y de esta manera obtener un valor que de otra manera no se podría obtener.

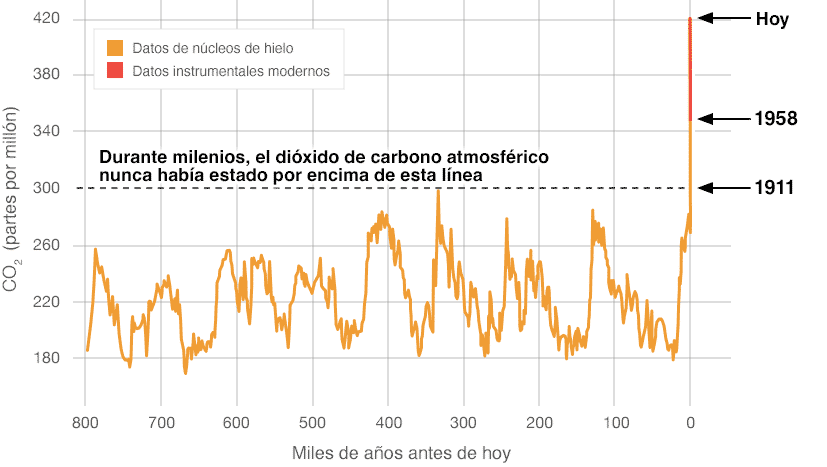

El ejemplo más claro entre datos e información se puede obtener en cualquier estudio científico, en el que a tras la obtención de unos datos, a través del método científico se llega una conclusión y con ello información.

Por ejemplo, mediciones del dióxido de carbono (CO2) en la atmósfera, se obtienen datos y se llega a la siguiente imagen que es la información:

2.3 Objetivo

El objetivo de los sistemas de información, y en este caso, los utilizados para la gestión empresarial, es el de realizar acciones de manera más rápida y eficiente, por lo que también debería ser más económico para la empresa.

El uso de las tecnologías de la información y la comunicación en las empresas se ha convertido en un elemento esencial como motor vertebrador y fuente de ventajas competitivas.

Hoy en día una empresa que no haga uso de la informática está condicionando su estrategia empresarial, y es bastante probable que esté perdiendo oportunidades de negocio, así como la posibilidad de desarrollar sus productos y servicios.

Es por eso que el uso de la informática y de software especializado de gestión empresarial puede ayudar a las empresas en:

Obtener ventajas competitivas.

Mejorar la eficiencia interna de la empresa: reducir costes, mejorar la productividad, mejorar la organización de la información, ...

Mejorar y facilitar la toma de decisiones a través de la recopilación de la información.

Para desarrollar nuevas estrategias de negocios.

2.4 Requisitos

Para que la información sea útil en la toma de decisiones dentro de una organización, debe cumplir una serie de requisitos:

Exactitud: debe ser precisa y libre de errores.

Comprensión: inteligible por el usuario.

Completitud: debe contener todos aquellos hechos que pudieran ser importantes.

Economicidad: el coste para obtener la información debe ser menor que el beneficio.

Confianza: garantizar tanto la calidad de los datos utilizados, como la de las fuentes de información.

Relevancia: ha de ser útil para la toma de decisiones.

Nivel de detalle: se debe proporcionar con la presentación y el formato adecuados, para que resulte sencilla y fácil de manejar.

Oportunidad: se debe entregar la información a la persona que corresponde y en el momento adecuado.

Verificabilidad: la información ha de poder ser contrastada y comprobada en todo momento.

A tener en cuenta: el exceso de información también puede ser contraproducente.

2.5 Actividades

A la hora de hacer uso de un sistema de información, las actividades que se pueden realizar con él se pueden resumir en:

Recopilación: Es la recogida de datos en bruto. Estos datos pueden ser de dentro de la organización, del exterior, recopilados de manera automática o de manera manual.

Almacenamiento: Los datos deben ser guardados de manera estructurada para su posterior uso. Por otro lado, nos debemos asegurar que su persistencia no corra peligro, por lo que deberemos contar con un sistema de almacenamiento que sea capaz de asegurar posibles problemas. Para ello deberemos tener un sistema en alta disponiblidad, y con un buen sistema de backups configurado.

También hay que asegurar que el acceso a los datos estará limitado y asegurado mediante sistemas de control de acceso y de autenticación.

Procesamiento: Es el punto clave en el que los datos se convierten en información, de esta manera cumpliendo la labor de ayudar a la organización en la toma de decisiones.

Distribución: El sistema permitirá distribuir la información entre las personas que la necesiten.

2.6 Tipos de sistemas de información

Aunque existen distintos tipos de sistemas de información, y su clasificación se puede realizar teniendo en cuenta distintas funcionalidades y/o objetivos, nos vamos a centrar en dos tipos:

ERP: Enterprise Resource Planning o planificación de recursos en la empresa. Se trata de los sistemas de gestión integrados que permiten dar soporte a la totalidad de los procesos de una empresa: control económico financiero, logística, producción, mantenimiento, recursos humanos, ...

CRM: Customer Relationship Management, sistemas para gestionar las relaciones con los clientes y el soporte a todos los contactos comerciales.

ERP

3 Introducción

Los sistemas de planificación de recursos empresariales (ERP, por sus siglas en inglés, enterprise resource planning) son los sistemas de información gerenciales que integran y manejan muchos de los negocios asociados con las operaciones de producción y de los aspectos de distribución de una compañía en la producción de bienes o servicios.

Los sistemas ERP son llamados ocasionalmente back office (trastienda) ya que el cliente y el público general no tienen acceso a él. Sólo los usuarios internos de la empresa (y no tienen por qué ser todos) accederán a distintos apartados para realizar modificaciones. Estas modificaciones se visualizarán, o tendrán efecto, sobre lo que el usuario final verá.

4 Objetivos

Los sistemas ERP son sistemas de gestión de información que automatizan muchas de las prácticas de negocio asociadas con los aspectos operativos o productivos de una empresa.

Los sistemas ERP suelen estar compuestos por distintos módulos para realizar diferentes acciones dentro de la empresa. En caso de necesitar cualquiera de ellos, se realizará la instalación o configuración del mismo, ya que lo habitual suele ser que estén desactivados por defecto.

Entre los módulos más habituales que nos podemos encontrar se pueden destacar: producción, ventas, compras, logística, contabilidad (de varios tipos), gestión de proyectos, GIS, inventarios y control de almacenes, pedidos, nóminas, ...

Los objetivos principales de los sistemas ERP son:

Unificación y trazabilidad de todos los procesos en un mismo sistema.

Optimización de los procesos empresariales.

Planificación de los recursos.

Automatización de los procesos entre las áreas de la empresa.

Acceso a los datos y creación de información estructurada.

Posibilidad de compartir información entre todos los componentes de la organización.

Eliminación de datos y operaciones innecesarias de reingeniería.

5 Características

Tal como nos dice Wikipedia, las características que distinguen a un ERP de cualquier otro software empresarial son que deben ser modulares, configurables y especializados:

Modulares. Los ERP entienden que una empresa es un conjunto de departamentos que se encuentran interrelacionados por la información que comparten y que se genera a partir de sus procesos. Una ventaja de los ERP, tanto económica como técnica, es que la funcionalidad se encuentra dividida en módulos, los cuales pueden instalarse de acuerdo con los requerimientos del cliente. Ejemplo: ventas, materiales, finanzas, control de almacén, recursos humanos, etc.

Configurables. Los ERP pueden ser configurados mediante desarrollos en el código del software. Por ejemplo, para controlar inventarios, es posible que una empresa necesite manejar la partición de lotes, pero otra empresa no. Los ERP más avanzados suelen incorporar herramientas de programación de cuarta generación para el desarrollo rápido de nuevos procesos.

Especializados. Un ERP especializado, brinda soluciones existentes en áreas de gran complejidad y bajo una estructura de constante evolución. Estas áreas suelen ser, el verdadero problema de las empresas, además de contener todas las áreas transversales. Trabajar bajo ERP especializados es el paso lógico de las empresas que requieren soluciones reales a sus verdaderas necesidades.Un ERP genérico solo ofrece un bajo porcentaje de efectividad basado en respuestas generalistas, que requieren ampliaciones funcionales.

CRM

6 Introducción

Tal como nos dice Wikipedia, la gestión o administración de relaciones con el cliente (customer relationship management), más conocida por sus siglas en inglés CRM, puede tener varios significados:

Administración o gestión basada en la relación con los clientes: un modelo de gestión de toda la organización, basada en la satisfacción del cliente (u orientación al mercado según otros autores). El concepto más cercano es marketing tradicional.

Software para la administración o gestión de la relación con los clientes: Sistemas informáticos de apoyo a la gestión de las relaciones con los clientes, a la venta y al marketing, y que se integran en los llamados Sistemas de Gestión Empresarial (SGE), y que incluyen CRM, ERP, PLM, SCM y SRM.

El software de CRM puede comprender varias funcionalidades para gestionar las ventas y los clientes de la empresa: automatización y promoción de ventas, tecnologías data warehouse («almacén de datos») para agregar la información transaccional y proporcionar capa de reporting, dashboards e indicadores claves de negocio, funcionalidades para seguimiento de campañas de marketing y gestión de oportunidades de negocio, capacidades predictivas y de proyección de ventas.

El CRM es un enfoque para gestionar la interacción de una empresa con sus clientes actuales y potenciales, es una forma de pensar y de actuar de una empresa hacia los clientes/consumidores. Utiliza el análisis de datos de la historia de los clientes con la empresa y para mejorar las relaciones comerciales con dichos clientes, centrándose específicamente en la retención de los mismos y, en última instancia, impulsando el crecimiento de las ventas.

7 Objetivos

Teniendo en cuenta lo dicho anteriormente, si el CRM está separado del programa que gestiona las ventas y recursos, puede resultar complejo el realizar una buena gestión de todo ello. Al final, la relación con el cliente es debido a las ventas o proyectos que se le realizan.

Los sistemas de software CRM aportan distintas funciones para a la gestión de las relaciones con el cliente:

Almacenamiento de los datos de los clientes a nivel comercial.

Creación de segmentos personalizados para distintos objetivos.

Seguimiento tanto de clientes como de ventas.

Automatización de los procesos de venta (leads, alertas, tareas…).

Generación de promociones específicas.

Gestión del servicio postventa de los productos.

8 Componentes

Los componentes principales de un CRM están construidos y manejan la relación con el cliente en base al marketing, observando la relación que existe a lo largo del tiempo a través de las distintas etapas de proyectos, ya que estas no son homogéneas.

No es lo mismo la relación con un cliente al inicio del primer proyecto que durante la ejecución de un tercer proyecto.

8.1 Tipos de comunicación

Podríamos identificar como buenos componentes de relación con el cliente los siguientes:

Comunicación verbal: Parte de la comunicación que realizaremos con el cliente será de forma verbal. De esta manera obtendremos una cercanía y un inicio de relación donde asentar las bases de la relación comercial.

No tiene por qué ser el primer acercamiento, pero será, normalmente, el que más estreche la relación. También suele ser la manera más rápida para compartir cierta comunicación y para comenzar las bases de inicio de proyectos.

Internet: Hoy en día el marketing a través de Internet es el más habitual. Ya sea a través de la página web corporativa, redes sociales, o en algunos casos incluso a través de campañas de publicidad incrustadas en otras webs.

Hoy en día para la captación de nuevos clientes, para dar a conocer las novedades y los avances en productos/proyectos, es una manera clave de mantener o iniciar la relación con clientes.

Campañas por e-mail: Aunque un poco relegadas por las redes sociales, las campañas por e-mail siguen siendo una manera en la que una empresa se debe relacionar con los clientes. Pueden ser de dos tipos:

Dirigidas a clientes concretos: Dependiendo de lo que queramos ofrecer, y teniendo en cuenta lo que los clientes han contratado previamente, se podrá dirigir las campañas a clientes concretos, tratando de buscar el mayor impacto posible.

Generalizadas: Por ser campañas más generalistas, o simplemente para ofrecer información general (posibles cambios dentro de la empresa, o mejoras en los servicios), estas campañas pueden ser dirigidas a todos los clientes en general.

Marketing telefónico: Algunas empresas, dirigidas a servicios generalistas, pueden hacer uso de campañas de marketing a través del teléfono en busca de nuevos clientes.

Soporte: Una vez terminado un proyecto, o con la contratación de un servicio, es habitual tener un sistema de soporte al cliente.

A través de este sistema, el cliente podrá pedir “ayuda” y dependiendo del tipo de empresa un técnico especializado le resolverá las dudas o le ayudará.

Odoo

9 Introducción

Odoo, antes conocido como OpenERP es un software de planificación de recursos empresariales con licencia dual. Existe una versión de código abierto y una versión con licencia comercial con características y servicios exclusivos.

Odoo también cuenta con un apartado de CRM (en inglés customer relationship management, o gestión de relaciones con el cliente), pudiendo también crear una web de comercio electrónico, facturación, ...

10 Instalación

Tal como hemos visto en el tema anterior, la instalación de un sistema se puede realizar de distintas maneras, por lo que deberemos atender a las necesidades del proyecto para realizar una instalación adecuada.

En nuestro caso, se va a optar por realizar una instalación a través de servicios Docker, de esta manera podemos realizar pruebas con distintas versiones (tanto de Odoo como de la base de datos).

La alternativa sería realizar la instalación en una máquina virtual o haciendo uso de los distintos instaladores que existen en la web oficial

Para realizar la instalación seguiremos las indicaciones que aparecen en la web de Docker Hub haciendo pequeñas modificaciones.

10.1 Servicios independientes

Es el sistema más básico, que requiere de levantar dos contenedores Docker:

Contenedor de base de datos PostgreSQL. Podremos elegir entre las distintas versiones del gestor de base de datos, pero haremos caso a las recomendaciones de la web. Habría que tener especial cuidado con el usuario y la contraseña que utilizamos.

En este caso también se ha expuesto el puerto 5432 que es el puerto por defecto de PostgreSQL:

Crear y arrancar el contenedor de la base de datos

ruben@vega:~$ docker run -d -e POSTGRES_USER=odoo \

-e POSTGRES_PASSWORD=odoo -e POSTGRES_DB=postgres \

-p 5432:5432 --name odoo_db postgres:15

- Contenedor con el propio Odoo. Este contenedor tendrá los servicios y librerías necesarias para poder hacer funcionar la aplicación web.

Crear y arrancar el contenedor de la base de datos

ruben@vega:~$ docker run -d -p 8069:8069 --name odoo \

--link odoo_db:db -t odoo

10.2 Docker Compose

Docker Compose es una herramienta para correr servicios multi-contenedor y se crea a través de un fichero en formato YAML. Es una manera de crear,parar,reconstruir una arquitectura de servicios de manera rápida y sencilla.

Se debe crear un fichero compose.yaml y lo ideal es que esté dentro de un directorio con el nombre del “stack de servicios”, ya que coge el directorio como parte del nombre a la hora de crear los contenedores.

Contenido de fichero compose.yaml

version: '3.1'

services:

web:

image: odoo:16.0

depends_on:

- db

ports:

- "8070:8069"

db:

image: postgres:15

environment:

- POSTGRES_DB=postgres

- POSTGRES_PASSWORD=odoo

- POSTGRES_USER=odoo

ports:

- "5433:5432"

Para arrancar los servicios se realiza, desde el mismo directorio donde se encuentra el fichero, con el siguiente comando

Levantar docker compose

ruben@vega:~$ docker compose up

En Julio del 2023 se migró a Compose v2, tal como se indica en la web oficial. Dependiendo de la versión que tengamos instalada será docker compose up o docker-compose up

10.3 Herramientas extra

Para poder acceder a la base de datos podemos hacer uso de un cliente externo. De esta manera no tendremos que entrar al contenedor y tendremos un interfaz gráfico con el que poder administrarla.

Podemos utilizar:

DBeaver: Es una aplicación de escritorio que permite conectarnos a distintos SGBDs. Existe versión community y otra con licencia que permite también conectarse a bases de datos NO-SQL.

pgAdmin: Es una aplicación que permite administrar PostgreSQL a través del servidor web.

Crear y arrancar el contenedor pgAdmin

ruben@vega:~$ docker run -p 8090:80 \

-e 'PGADMIN_DEFAULT_EMAIL=user@domain.com' \

-e 'PGADMIN_DEFAULT_PASSWORD=SuperSecret' \

--name pgadmin4 -d dpage/pgadmin4

Uso de datos en informes

11 Dashboards

Los paneles de información (en inglés dashboard) son herramientas gráficas que nos permiten visualizar datos para convertirlos en información sin tener que realizar ningún tipo de programación.

Podríamos decir que los paneles son un interfaz gráfico previamente programado que obtiene datos de una fuente de datos (una hoja de cálculo, un fichero CSV, una base de datos,...) para posteriormente visualizarlo de una forma gráfica.

12 Características

Los paneles de información suelen contar con las siguientes características:

Son fáciles de usar: no es necesario ser programador para hacer uso de ellos, siempre y cuando los datos los tengamos en un formato correcto.

Permiten hacer uso de diferentes tipos de gráficos: tablas, mapas para datos geolocalizados, mapas de calor, gráficos tipo tarta, mapas de barras (horizontales y verticales), ...

Son interactivos: podemos hacer que los gráficos estén enlazados entre sí, y de esta manera al seleccionar un apartado de uno, el resto se actualizan.

Se pueden generar filtros para realizar una búsqueda en los datos.

Podemos compartir el dashboard creado o generar una presentación.

Como contrapartida, también pueden existir algunos inconvenientes a la hora de utilizarlos, que debemos de tener claros antes de utilizarlos:

Estamos limitados a las características que ofrecen. Por lo tanto, si nos interesa crear un gráfico distinto a los que ofrece, no vamos a poder hacerlo.

Los datos deben de estar en el formato que acepte la herramienta. Si programamos nosotros, el formato puede ser propio, o el diccionario de datos puede estar a nuestro gusto.

Dependencia de la herramienta. Si deciden eliminar funcionalidades, hacerla de pago, ... deberemos migrar los datos y crear de nuevo el panel.

13 Entendiendo los datos

Antes de crear un panel de información debemos tener claro los tipos de datos que tenemos, cómo están organizados (o si debemos organizarlos), en qué formato están, ... es por eso que debemos realizar un análisis previo de los mismos.

13.1 Análisis de datos

A la hora de realizar el análisis de datos, debemos tener en cuenta, al menos, las siguientes características:

Fuente de los datos: ¿son datos propios? ¿podemos recuperarlos en cualquier momento? ¿son fiables?

Formato de los datos: Debemos tener en cuenta no sólo el formato del fichero en el que obtenemos los datos, si no si estos están normalizados. Por ejemplo, si los números están guardados en formato entero/real o en formato texto; si existen datos de geolocalización, si están separados o agregados; ...

Entender los datos: Aunque pueda parecer obvio, es necesario entender cada apartado de los datos para posteriormente relacionarlos entre sí, y para hacer uso de ellos en el panel/gráfico.

13.2 Creación del esquema de datos

Teniendo en cuenta el punto anterior, quizá sea necesario normalizar los datos o crear un formato específico. Por lo tanto, debemos de conocer algún tipo de herramienta o de lenguaje de programación que nos permita hacerlo.

Si los datos en bruto obtenidos no cumplen las expectativas, entre las tareas que debemos realizar estarán:

Normalizar los datos: A cada tipo de datos convertirlo al formato que debe ser. Por ejemplo, en algunos datos de geoposición de OpenData Euskadi, hacen uso de un formato llamado UTM, que es necesario convertir a latitud y longitud.

Diccionario de datos: Crear el esquema/diccionario de datos que mejor se adecúe a los datos y al sistema de panel que vayamos a utilizar.

13.3 Crear el tipo de fichero

Por útlimo, será necesario generar el tipo fichero con el formato que la herramienta necesita: json, CSV, formato excel, ...

Para ello, dependiendo del esquema de datos, podremos generar el fichero con herramientas simples (por ejemplo excel, para generar un fichero en formato CSV) o deberemos hacer uso quizá de lenguajes de programación con librerías específicas que nos faciliten la labor (por ejemplo python).

13.4 Documentación del análisis

Siempre es recomendable documentar el proceso del análisis de datos para entender en etapas sucesivas, o tiempo después, el por qué se han modificado los datos tal como se ha hecho, o la razón de hacer uso de un tipo de fichero y no otro.

La documentación también facilitará el realizar modificaciones más adelante o para poder realizar adaptaciones a nuevas herramientas. De esta manera, en principio, tendremos parte del trabajo hecho y no habrá que volver a realizarlo.

14 Looker Studio como generador de paneles de información

Looker Studio, anteriormente DataStudio, es una herramienta de Google para visualizar y crear paneles informativos con datos que proporcionamos desde distintas fuentes.

Es una herramienta gratuita, fácil de usar y que permite generar distintos tipos de paneles con los datos proporcionados. Aparte, también permite crear otros tipos de visualizaciones, por lo que la comunidad aporta nuevos paneles.

Para poder crear los paneles, necesitaremos hacer uso de datos, que podremos importar o usar desde distintas fuentes, como por ejemplo:

Ficheros CSV (comma separated value)

Hojas de cálculo de Google

Bases de datos MySQL, PostgreSQL, SQL Server, ...

Otros conectores creados por la comunidad

14.1 Obtener datos

En primer lugar vamos a necesitar crear una fuente de datos, donde deberemos subir los datos obtenidos. Tal como se ha dicho previamente, es necesario realizar un análisis de los mismos para posteriormente normalizarlos en caso necesario.

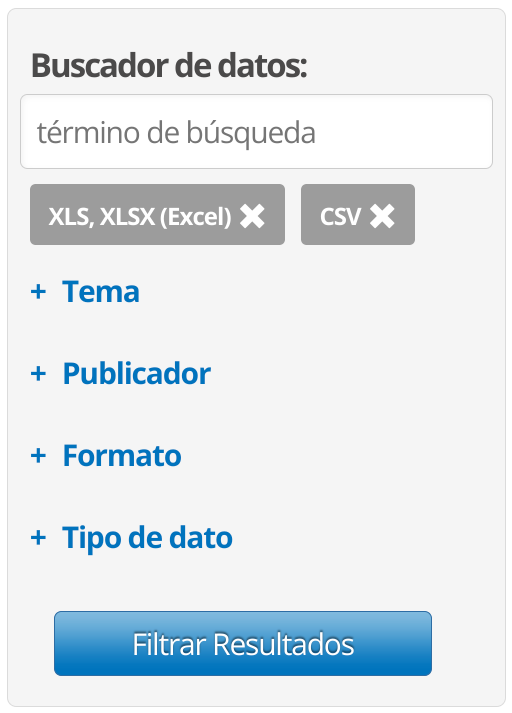

Para este ejemplo se va a hacer uso de una hoja de cálculo de Google con datos obtenidos de OpenData Euskadi. Buscaremos para que los datos estén en formato CSV y/o XLS de Excel, y de esta manera la conversión de los datos no resulte tan compleja.

En caso de estar en formato JSON, u otro, quizá deberíamos realizar una conversión previa. Aparte, de que en caso de querer realizar la manipulación de los datos, no sería tan directa.

Tras realizar la búsqueda obtendremos un listado de resultados, en el que podremos analizar si son de nuestro interés. En algunos casos los nombres son bastante representativos. Buscaremos datos que sean de nuestro interés y que tengan datos de geolocalización.

Una vez descargado los datos, y generado una hoja de cálculo en Google con ellos, deberemos realizar el análisis de los datos. Entre otras cosas, deberíamos:

Renombrar la primera fila, para que cada columna esté identificada de manera correcta.

Comprobar si hay datos duplicados que se puedan borrar.

Eliminar columnas que no nos interesen y/o que estén vacías

Comprobar si los datos geográficos están en el formato adecuado. Para ello, podremos ver si al usarlos en Google Maps hacen referencia a la localidad correspondiente.

Los datos latitud y longitud deben estar en la misma celda y separado por una coma.

En caso de estar en formato UTM, habría que convertirlos (se puede usar este conversor).

Una vez realizado, deberíamos tener los datos listos para poder ser usados.

14.2 Crear fuente de datos en Looker Studio

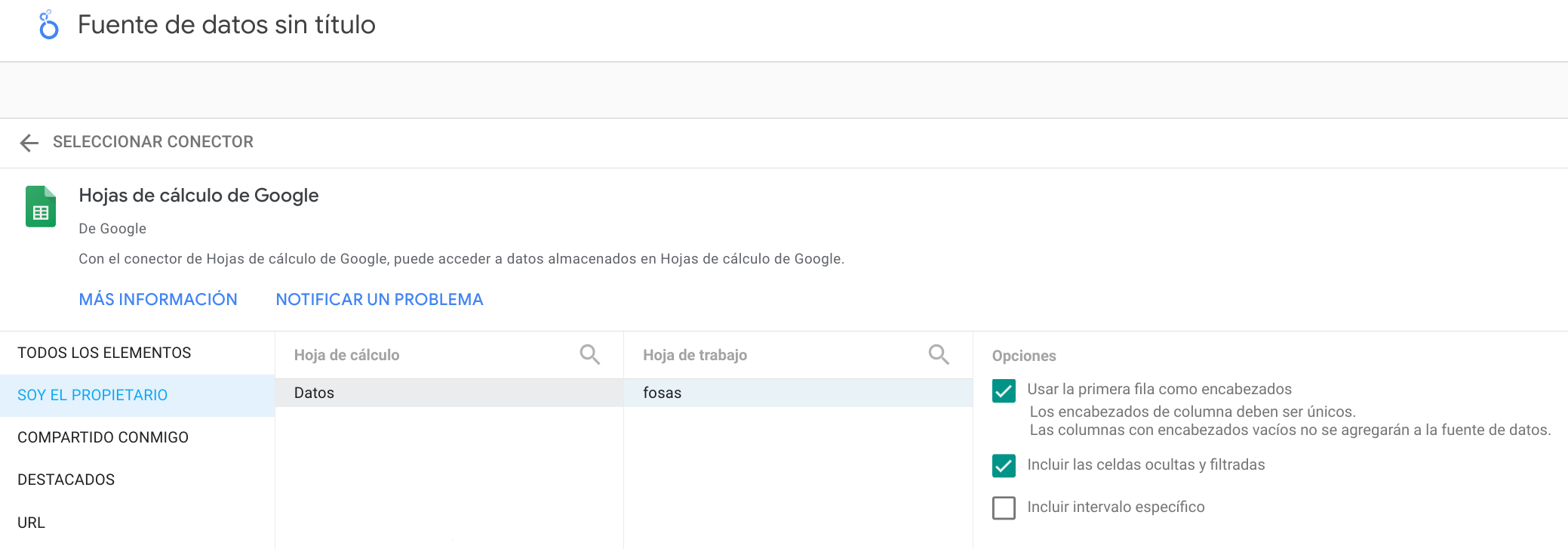

Para poder hacer uso de los datos en los paneles de información, primero debemos agregar una “Fuente de datos”, por lo que para ello vamos a “Crear → Fuente de Datos”, y elegimos el conector específico que nos interese.

En el caso de utilizar una hoja de cálculo de Google, deberemos darle permisos para poder acceder, y elegiremos la hoja de cálculo que nos interese. También nos va a permitir seleccionar unas opciones durante la importación:

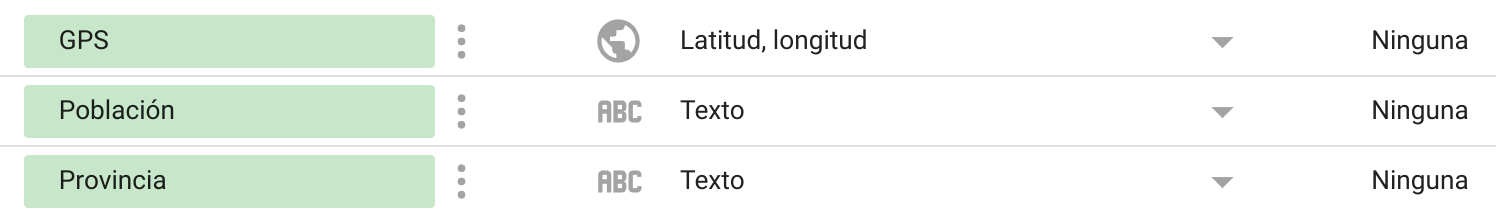

Tras realizar la importación, dentro de la fuente de datos deberemos identificar el tipo de fuente que es cada dato. En algunos casos Looker Studio identificará el tipo correcto, pero en otros no, como sucede con las posiciones de geolocalización.

Una vez realizada la normalización de los datos, podemos comenzar a crear el informe.

14.3 Crear informe

Una vez terminada la normalización de los datos, es momento de comenzar a crear el informe y convertir los datos en información. Para ello, debemos pensar qué tipo de información queremos mostrar y cómo.

Looker Studio nos permite hacer uso de distintos tipos de gráficos, cada uno con sus peculiaridades y su configuración, por lo que es interesante investigar cada uno de ellos y comprobar su funcionamiento.

A continuación se explican algunos de ellos:

Tabla: Es la manera más sencilla de representar los datos, y tal como dice su nombre, en formato tabla, separado por filas y columnas. Podremos colocar las columnas en el orden adecuado, generar sistemas de ordenación, añadir colores a las filas pares o impares, ...

Cuadro de resultados: Normalmente son utilizados para contabilizar el número de datos seleccionados o totales.

Gráfico de barras: Nos muestra los datos agregados en columnas, pudiendo elegir en formato vertical, horizontal, ascendente, descendente...

Mapas: Existen distintos tipos de mapas, que dependiendo de los datos nos permitirá visualizar datos de una manera u otra.

Mapa de calor: Nos crea un mapa de calor con los datos posicionados.

Mapa de burbujas: Geolocaliza los datos añadiendo pequeños círculos. Estos pueden ser de distintos colores identificando algún aspecto destacable de los datos.

En el siguiente enlace se puede ver los aspectos más básicos de un informe.

Alta Disponibilidad y Arquitectura de sistemas

15 Alta Disponibilidad

La alta disponibilidad en servidores se puede definir como el diseño de infraestructura (y su implantación) que asegura la continuidad del servicio y que no tiene un único punto de fallo.

Es lógico entender que un servicio debe de ser contínuo en el tiempo, ya que debe de dar servicio de manera continuada para que los usuarios puedan acceder a él. Pero para que esta premisa sea efectiva, y para asegurarnos que así sea, la infraestructura debe de estar redundada y carecer de puntos de fallo únicos en su diseño.

Esto quiere decir, que de cada servicio y para cada posible punto de fallo deberá haber al menos dos de ellos, para que en caso de que uno deje de funcionar el servicio siga funcionando (dos tomas eléctricas separadas, dos servidores que otorguen el servicio, dos conexiones a internet, ... ).

Es habitual que un sistema en Alta Disponibilidad deba de estar pensado desde el diseño. Algunos tipos de servicios pueden empezar como un único servidor y posteriormente realizar un escalado horizontal, formando la alta disponibilidad, mientras que para otros el diseño en alta disponibilidad debe de estar pensado desde el comienzo (habitualmente en algunos tipos de clusters).

15.1 Importancia de un sistema en Alta Disponibilidad

Como se ha citado previamente, la alta disponibilidad nos va a asegurar al menos tres grandes ventajas:

Una continuidad en el servicio

Un diseño libre de puntos de fallos únicos, gracias a la redundancia.

Mejorar el rendimiento global.

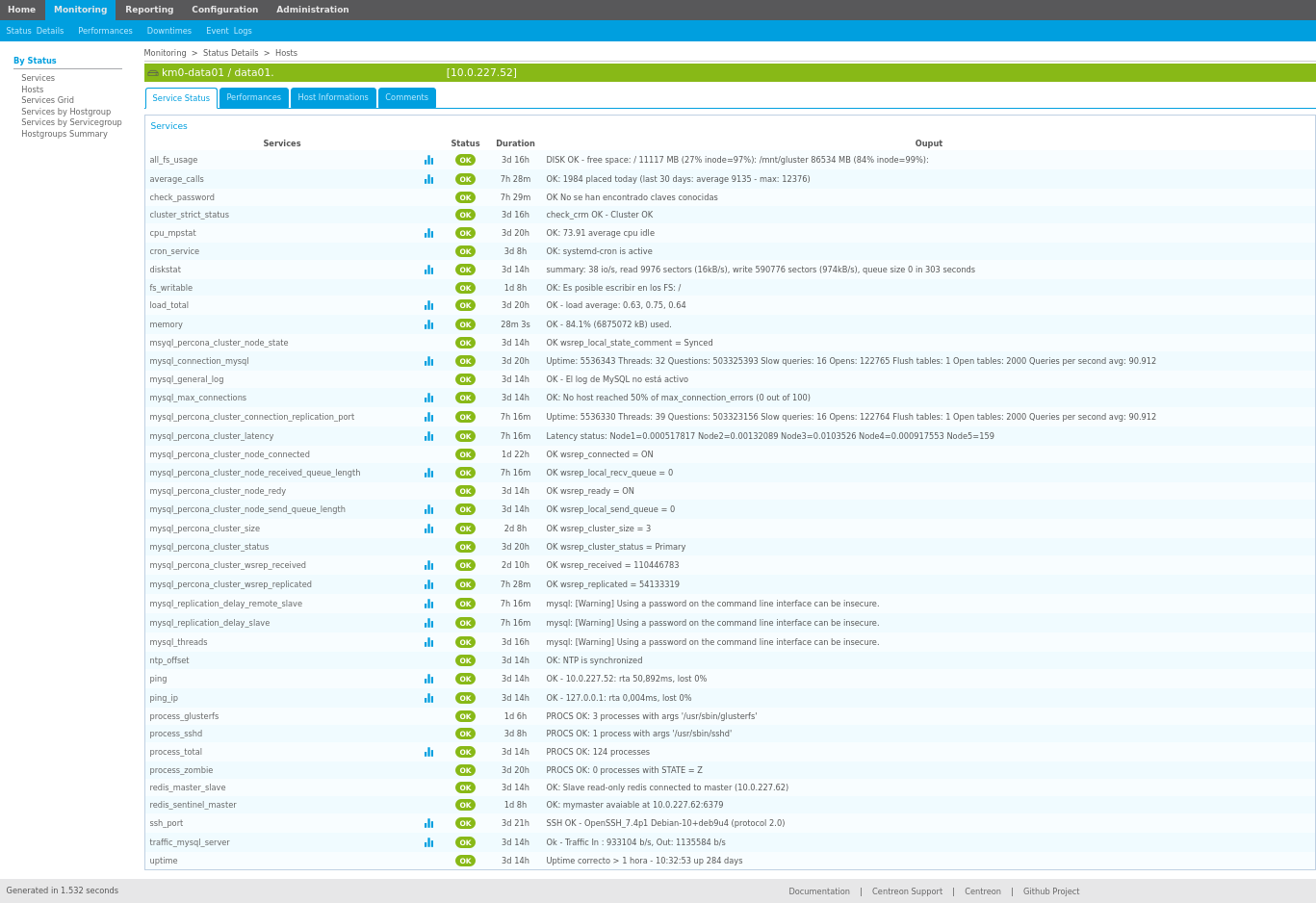

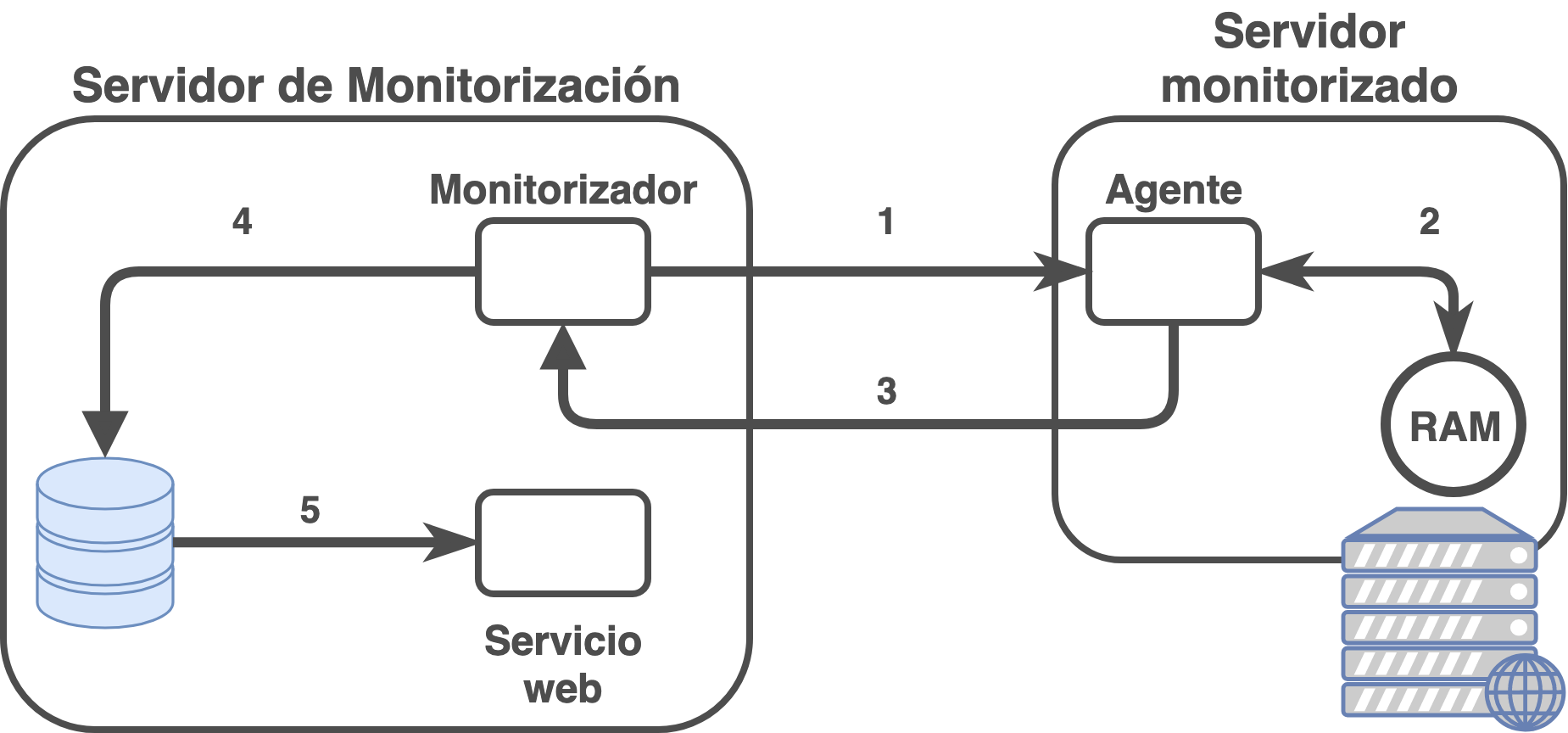

La redundancia permitirá que en caso de fallo de algún equipamiento/servicio, al estar redundando, no afecte al servicio. Gracias al sistema de monitorización seremos capaces de ver el problema y solventarlo lo antes posible. De estar el diseño correcto, el servicio mantendrá su actividad, mientras que por el contrario, si ha habido algún fallo en el diseño de infraestructura (o el problema es más grave de lo esperado) el servicio se verá afectado.

15.2 Tipos de Alta Disponibilidad

Existen muchos tipos de alta disponibilidad dependiendo de en qué capa de infraestructura estemos hablando. Por poner unos ejemplos:

Redundancia eléctrica: Los servidores normalmente cuentan con doble fuente de alimentación, por lo que cada fuente de alimentación debe de estar conectada a una toma eléctrica completamente separada de la otra.

Redundancia de conectividad física: El acceso a internet debe de ser redundado.

Redundancia de conectividad LAN: El acceso a la LAN/DMZ/red de servicio debe de estar redundado (stacks de switches, LACPs configurados en switches y servidores, … ).

Redundancia de servidores: Debe de existir una redundancia de servidores para asegurar que el servicio funcione en más de un servidor físico.

Redundancia de servicio: El servicio que se ofrece debe de estar redundado entre los distintos servidores.

La alta disponibilidad también se puede diferenciar como:

Alta disponibilidad real: En caso de que haya algún problema el servicio continúa como si no hubiese pasado nada, gracias a la redundancia completa de servicios/dispositivos.

Alta disponibilidad pasiva: En caso de error, los servidores activos serían los que reciben el impacto del problema y hay que escalar los servidores pasivos a modo activo para que comiencen a funcionar otorgando el servicio. Como se puede presuponer, esta modificación puede ser realizada de manera automática o de manera manual (lo que llevaría algo de tiempo, y por tanto el servicio se vería afectado).

16 Arquitectura de instalación

A la hora de realizar la instalación de un sistema de información, y teniendo en cuenta que es un pilar fundamental de la empresa, habrá que tomar ciertas decisiones desde el punto de vista de sistemas hardware.

De estas decisiones se encargará el sysadmin, o administrador de sistemas, pero tendrá que tener ayuda de los especialistas de la aplicación de sistemas de información, así como de determinar una decisión desde el punto de vista empresarial.

Entre las tareas que hay que tener en cuenta, se podrían destacar las siguientes:

Hardware: Determinar el hardware en donde se va a realizar la instalación. Hoy en día existen distintas alternativas, como son:

Hardware dedicado: Un servidor propio para el sistema, donde se realizará la instalación sólo para este servicio.

Máquina Virtual: El servicio será instalado en una máquina virtual a través de un sistema de virtualización profesional. El servicio es agnóstico al hardware, por lo que no sabrá si está virtualizado o no. Hoy en día suele ser la opción más común dadas las ventajas que ofrecen.

Elección del sistema de información: Esta es una tarea importante y que no se puede dejar de lado, ya que la decisión de optar por una herramienta u otra puede suponer un problema a futuro.

Es por eso que se debe realizar un estudio de mercado entre las distintas posibilidades y tener en cuenta, al menos, las siguientes situaciones:

Estado actual de la herramienta: Es importante saber si la herramienta analizada cuenta con un desarrollo continuado, si existe una empresa o grupo de desarrollo por detrás que la apoye; que no esté abandonada; que sea una herramienta con buena aceptación y críticas...

Coste de licencia: Es una herramienta que cuenta con una licencia a perpetuidad bajo un coste determinado, tiene licencia por el número de usuarios que acceden a ella, es una herramienta de Software Libre ...

Seguridad, actualizaciones y parches: La herramienta cuenta con actualizaciones de seguridad periódicas; no ha habido fallos de seguridad graves en las últimas versiones; cuando se detectan fallos las actualizaciones aparecen de manera rápida y efectiva; las actualizaciones y/o parches son gratuitos o de pago...

Coste de mantenimiento: Existe un coste asociado al mantenimiento de la aplicación, pero este puede ser por parte del sistema (realizar actualizaciones, aumento de recursos...) o por pago de licencias anuales, por versiones...

Posibilidades de personalización: Existe la posibilidad de personalizar la herramienta; parametrizar opciones propias que se ajustan a la empresa; creación de módulos/plugins propios para mejorar/expandir la funcionalidad de la herramienta, ...

Conocimientos sobre la herramienta: Dentro de la organización se cuenta con conocimientos acerca del uso/instalación/administración de la herramienta, debe ser subcontratado o existe la posiblidad de adquirir conocimiento mediante cursos o manuales.

Sistema operativo: Dependiendo del sistema de información elegido, se deberá instalar en un sistema operativo u otro. En este punto se pueden tener en cuenta también los puntos anteriores sobre el conocimiento para la toma de decisiones.

Método de instalación: Hoy en día existen distintas posibilidades a la hora de instalar servicios, por lo que es importante realizar una buena decisión:

Tradicional: Vamos a llamar sistema tradicional a aquel que se realiza mediante un instalador que realiza la instalación en el sistema operativo, que no suele dar demasiadas opciones de configuración durante el proceso.

Contenedores: Hoy día existen servicios que podemos instalar a través de sistemas de contenedores (como puede ser Docker), los cuales suelen facilitar la instalación, así como la posibilidad de que también sea un sistema multicapa.

Por capas: La instalación multicapa puede resultar un poco más compleja y la aplicación/servicio debe poder permitir realizarlo. Aunque inicialmente pueda suponer un poco más de esfuerzo, pero a la larga puede suponer una gran ventaja como es la alta disponibilidad.

Pasar de un sistema “monolítico” a un sistema por capas es posible, pero una vez más dependeremos de la aplicación. Por otro lado, si desde el inicio se ha creado un sistema multicapa, escalarlo será más sencillo que realizar la migración cuando ya esté en uso.

16.1 Arquitectura multicapa

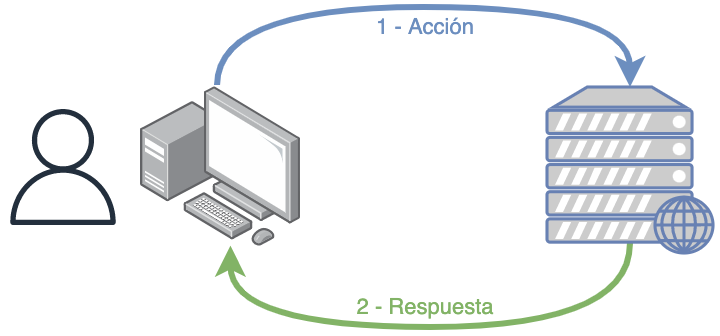

Un sistema informático multicapa es aquel que hace uso de una arquitectura cliente-servidor en las que existe una separación lógica y/o física entre las distintas funciones que tiene una aplicación o servicio.

Normalmente se suele representar como una arquitectura en tres niveles, siendo estos:

Capa de presentación: Es la que ve el usuario (también se la denomina «capa de usuario»), presenta el sistema al usuario, le comunica la información y captura la información del usuario en un mínimo de proceso (realiza un filtrado previo para comprobar que no hay errores de formato).

También es conocida como interfaz gráfica y debe tener la característica de ser «amigable» (entendible y fácil de usar) para el usuario. Esta capa se comunica únicamente con la capa de negocio.

Hoy en día lo habitual es que hagamos uso de servicios web, por lo que la capa de presentación es la web que estamos visualizando. En el caso de aplicaciones móviles, es la propia aplicación que tenemos instalada en el dispositivo.

Capa de negocio: es donde residen los programas que se ejecutan, se reciben las peticiones del usuario y se envían las respuestas tras el proceso. Se denomina capa de negocio (e incluso de lógica del negocio) porque es aquí donde se establecen todas las reglas que deben cumplirse.

Esta capa se comunica con la capa de presentación, para recibir las solicitudes y presentar los resultados, y con la capa de datos, para solicitar al gestor de base de datos almacenar o recuperar datos de él. También se consideran aquí los programas de aplicación.

En este tipo de arquitecturas, esta capa es la que se denomina backend, y lo habitual es que sea un sistema al que llamamos a través de una API (del inglés, application programming interface, o interfaz de programación de aplicaciones).

Capa de datos: es donde residen los datos y es la encargada de acceder a los mismos. Está formada por uno o más gestores de bases de datos que realizan todo el almacenamiento de datos, reciben solicitudes de almacenamiento o recuperación de información desde la capa de negocio.

Las aplicaciones web se pueden separar en dos capas: aplicación y base de datos.

En aplicaciones web es posible crear una arquitectura en capas aunque la aplicación no esté 100% pensado para ello: la propia aplicación y la base de datos.

16.2 Arquitectura de microservicios

Para poder crear una arquitectura de microservicios el enfoque debe darse desde el primer momento del desarrollo de software. Es decir, antes de realizar ningún tipo de programación la aplicación se planteará como pequeños servicios que podrán interactuar entre sí.

Cada servicio se encargará de implementar una única funcionalidad. En caso de necesitar alguna característica que se repita en varios, se debería crear un microservicio que proporcione dicha característica o funcionalidad.

Podríamos comparar una arquitectura de microservicios como una librería de programación, en la que existen funciones que realizan una única función.

Cada microservicio se desplegará de manera independiente, e incluso cada uno podrá estar programado en distintos lenguajes de programación. De esta manera se puede hacer uso del lenguaje y la tecnología más adecuada para cada funcionalidad.

17 Escalabilidad

Teniendo en cuenta todo lo dicho hasta ahora, cuando un sistema empieza a tener problemas de rendimiento deberemos abordar el problema y plantearnos cómo solucionarlo. De no hacerlo, se corre el peligro de que el servicio se vea interrumpido y por tanto perder tiempo de trabajo.

Antes de realizar ninguna modificación habría que analizar qué es lo que está sucediendo (para ello es importante tener un buen sistema de monitorización), y de esta manera saber en qué punto existe el problema y así poder solucionarlo.

Dependiendo de las decisiones tomadas durante la instalación, y tras lo visto previamente, podremos abordarlo de dos maneras diferentes.

“Escalabilidad” no existe en el diccionario de la RAE, pero se usa como anglicismo de la palabra scalability.

17.1 Escalado vertical

Cuando se escala verticalmente un sistema lo que se va a realizar es añadir más recursos al nodo que está teniendo problemas. Tras el análisis previo realizado se añadirán los recursos necesarios (más RAM, discos duros más rápidos, aumentar el número de procesadores/cores).

Comúnmente también se dice “meter más hierro”, porque antiguamente lo que se hacía era incrementar los recursos hardware del sistema. Hoy en día en sistemas virtualizados, estos recursos se pueden modificar, dependiendo del virtualizador, en “caliente”, por lo que no sería necesario reiniciar el servicio.

Es el sistema más simple, ya que incrementando los recursos se espera que el problema se apacigüe o desaparezca, aunque esto no tiene por qué ser siempre así.

17.2 Escalado horizontal

El escalado horizontal trata de solventar el problema repartiendo la carga entre más nodos. Este proceso de escalado es más complejo y dependerá de la modularidad del servicio ofrecido. Es decir, la lógica de la aplicación debería haberse pensado desde el inicio para un sistema que escalará de manera horizontal en el futuro.

En principio, al realizar un escalado horizontal no existe una limitación de crecimiento, ya que siempre que se pueda repartir la carga entre servidores, no importará el número de ellos.

Dentro del escalado horizontal podríamos diferenciar dos tipos:

Escalado horizontal por capas: Teniendo en cuenta lo visto previamente acerca de la arquitectura multicapa, en este modelo lo que se conseguirá es escalar cada capa de manera independiente. Podría realizarse de la siguiente manera:

Servidores frontales (proxys) reciben las peticiones de la aplicación o del navegador y que balancean la carga y la mandan a servidores con la capa de presentación.

Servidores con la capa de presentación que realizan las peticiones de negocio a los servidores correspondientes.

Servidores de lógica de negocio que procesan las peticiones y piden los datos a un clúster de bases de datos.

Clúster de base de datos.

Escalado horizontal de microservicios: En el caso del escalado de microservicios, será similar al escalado horizontal, pero en este caso sólo se escalarán los microservicios necesarios.

Debido a que todo es mucho más modular, es posible que quizá sólo sea necesario realizar el escalado de algunos microservicios, que quizá sean los más utilizados o los que requieren más tiempo de ejecución.

Windows Subsystem for Linux

18 Introducción

WSL (del inglés Windows Subsystem for Linux) es una capa de compatibilidad que ha desarrollado Microsoft para correr ejecutables creados para sistemas Linux de manera nativa en Windows.

Desde el año 2019 la versión por defecto es la 2, que introdujo muchos cambios en el sistema, ya que esta versión corre dentro de una capa de virtualización creada a través de un subconjunto del virtualizador Hyper-V. Esto hace que el kernel que se está ejecutando sea mucho más compatible con los binarios de Linux que la versión 1. A pesar de usar virtualización, también mejora el rendimiento respecto a la versión anterior.

Por defecto WSL no viene instalado en el sistema en Windows 10, por lo que es necesario realizar la instalación para poder ejecutar las aplicaciones que deseemos (como Docker, por ejemplo). En versiones Windows 11 sí viene instalado.

19 Instalación

Para realizar la instalación necesitaremos una versión compatible de Windows (10 build 19041 o posterior). Hoy en día no debería ser problema si tenemos el sistema actualizado.

Para realizar la instalación necesitaremos de permisos de administrador, y lo realizaremos, para mayor comodidad, desde una consola de PowerShell o la nueva terminal de Windows. Para ello, abrimos la consola con permisos de administrador y ejecutamos:

Instalación de WSL en Windows 10

PS C:\Users\ruben> wsl --install

Tras la instalación es necesario reiniciar el sistema para que aplique cambios y levante los servicios necesarios. Una vez reiniciado nos aparecerá una ventana donde nos pedirá que introduzcamos el usuario y la contraseña para el sistema Linux recién instalado.

Por defecto, la distribución que se instala es Ubuntu.

20 Configuraciones

Tras realizar la instalación podremos observar que Windows ha realizado una serie de configuraciones para adecuar la nueva instalación del servicio.

Al tener las instancias levantadas, se genera un nuevo interfaz de red Hyper-V, con una red 172.25.240.0/20.

Tal como se ha dicho, en WSL-2 las instancias realmente son máquinas virtuales Hyper-V. La configuración de las instancias se encuentran en el directorio AppData del usuario que las crea. Por ejemplo, para Debian, se encuentra el disco duro dentro de ./AppData/Local/Packages/TheDebianProject…/LocalState/ext4.vhdx

El directorio AppData está oculto por defecto en el explorador de ficheros de Windows.

Dentro de las instancias se puede acceder al disco duro de Windows a través de /mnt/c, o la unidad correspondiente.

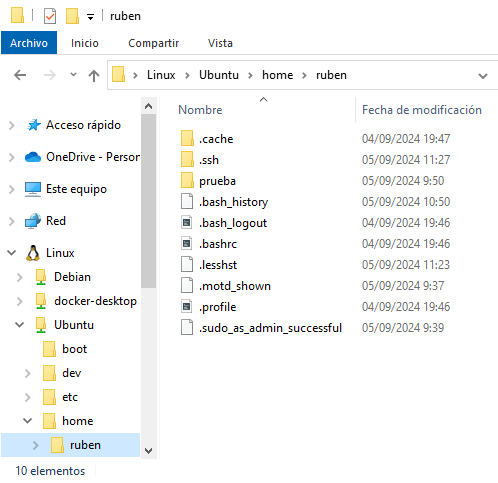

Desde Windows se puede acceder al sistema de ficheros de las instancias a través del explorador de ficheros, ya que nos aparecen las instancias que tenemos creadas.

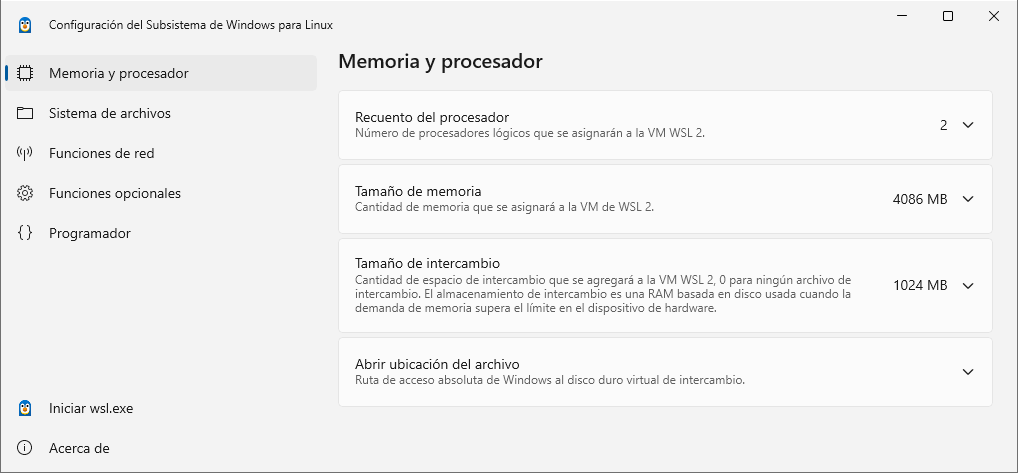

Para poder realizar una configuración general de todo el ecosistema WSL se puede realizar desde una aplicación (disponible desde verano del 2024):

En esta aplicación se pueden modificar aspectos tan interesantes como:

- Procesadores lógicos dentro del WSL

- Tamaño máximo de la memoria

- Modo de red (NAT, mirrored, o proxy)

20.1 Configuración avanzada

Para realizar una configuración avanzada, existe una documentación desde dos puntos de vista:

wsl.conf: fichero de configuración que se sitúa en el directorio /etc en las distribuciones. Esta configuración sólo afecta en la distribución correspondiente donde se haya realizado. Más adelante veremos un ejemplo para el uso de Docker.

.wslconfig: fichero en el directorio del usuario de Windows. Este fichero tendrá la configuración que afectará a todas las distribuciones que hayamos instalado con WSL 2.

21 WSL con usuarios no privilegiados

WSL hace uso de ciertas características que necesitan de permisos de administrador. En caso de no tener permisos de administrador, por defecto sólo se hará uso de WSL versión 1, por lo que el rendimiento de los subsistemas es peor.

Por lo tanto, para poder utilizar WSL2 se necesita tener acceso a los credenciales de administrador y ejecutar los siguientes comandos:

Usar WSL2 en usuarios no privilegiados

PS C:\Users\usuario> wsl --update

PS C:\Users\usuario> wsl --set-default-version 2

22 Comandos útiles

Una vez realizada la instalación, existen ciertos comandos que nos pueden ser útil a la hora de hacer uso de WSL. No se van a detallar todos, ya que con wsl –help obtendremos la ayuda del comando y muchas más opciones.

Mostrar todas las distribuciones que se pueden instalar

PS C:\Users\ruben> wsl -l -o

Instalar una distribución Debian

PS C:\Users\ruben> wsl --install -d Debian

Mostrar las distribuciones instaladas

PS C:\Users\ruben> wsl -l -v

Ejecutar una distribución instalada y entrar en ella

PS C:\Users\ruben> wsl -d Debian

ruben@DESKTOP-1RVJ3UP:/mnt/c/Users/ruben$

Terminar/Apagar una distribución

PS C:\Users\ruben> wsl -t Debian

Apagar todas las instancias

PS C:\Users\ruben> wsl --shutdown

Eliminar una distribución instalada

PS C:\Users\ruben> wsl --unregister Debian

Clonar una instancia de una distribución instalada

PS C:\Users\ruben> wsl --export Ubuntu ubuntu.tar

PS C:\Users\ruben> wsl --import Ubuntu2 ubuntu2_files ./ubuntu.tar

23 Acceder al sistema de ficheros de los subsistemas

Microsoft ha creado la posibilidad de poder acceder al sistema de ficheros de los Linux que levantemos con WSL a través del explorador de ficheros de Windows. Esto permite copiar/pegar ficheros entre las distribuciones que hayamos creado y el propio sistema base. En la siguiente imagen se ve el explorador de archivos con tres subsistemas Linux creados:

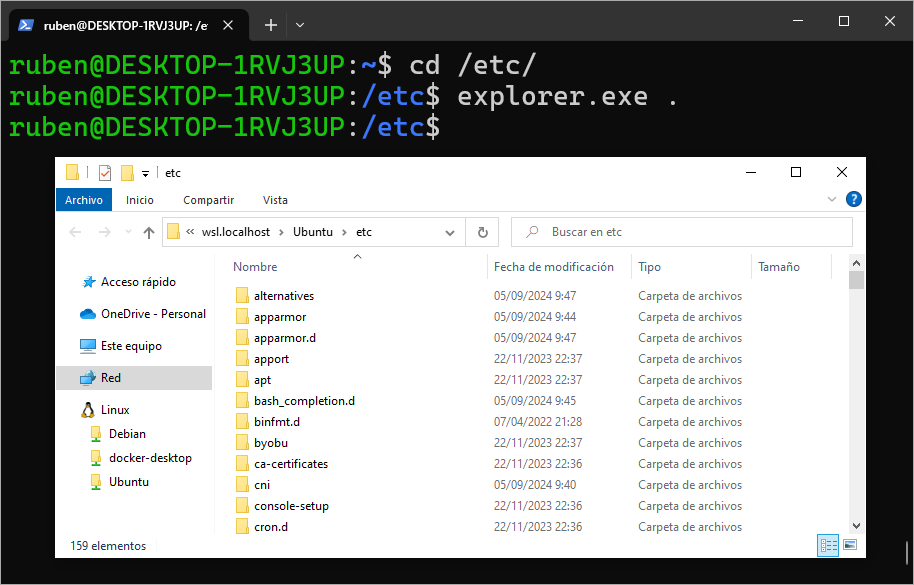

Como alternativa, desde dentro del subsistema Linux podemos ejecutar aplicaciones Windows, por lo que estando en cualquier ruta, podemos llamar al comando explorer.exe . que nos abrirá el explorador de Windows en esa misma ruta:

23.1 Rendimiento de los sistemas de ficheros en WSL

Por cómo funciona WSL y la gestión de sistemas de ficheros entre el sistema anfitrión Windows y el subsistema Linux, tenemos que tener claro que existen dos sistemas de ficheros independientes, pero accesibles entre ellos:

- Sistema de ficheros de Windows: Es el sistema de ficheros de nuestro equipo Windows. Hay que tener en cuenta, que cuando entramos al subsistema Linux, por defecto nos encontramos en ese mismo sistema de ficheros:

Al entrar al subsistema Linux, estamos en el sistema de ficheros de Windows

PS C:\Users\ruben\Desktop> wsl -d Ubuntu

ruben@DESKTOP-1RVJ3UP:/mnt/c/Users/ruben/Desktop$

Tal como se puede ver, al entrar en Ubuntu, la ruta en la que nos encontramos es /mnt/c/Users/ruben/Desktop, que es el sistema de ficheros de Windows (C:) montado en la ruta de Linux /mnt/c. Por eso, desde Linux tendremos acceso a todo el sistema de ficheros de Windows desde esa ruta.

- Sistema de ficheros del subsistema Linux: La máquina virtual de Linux que hemos creado tiene su propio sistema de ficheros, que como en cualquier Linux, está en

/.

Pasamos al sistema de ficheros real de Linux

ruben@DESKTOP-1RVJ3UP:/mnt/c/Users/ruben/Desktop$ cd

ruben@DESKTOP-1RVJ3UP:~$ pwd

/home/ruben

Tal como se puede ver, con el comando pwd, ahora nos encontramos en el sistema de ficheros de Linux real.

A la hora de hacer uso de aplicaciones en el susbsistema Linux, es recomendable hacerlo dentro del sistema de ficheros de Linux, no en el sistema montado, debido a que el rendimiento en el sistema montado es mucho peor. Por tanto, nos debemos asegurar que la aplicación está en la ruta correcta.

Usar el sistema de ficheros de Windows montado en el subsistema Linux perjudica el rendimiento.

24 Docker dentro de WSL

Si queremos tener Docker dentro de un subsistema Linux, existen dos posibilidades completamente diferenciadas:

- Utilizar Docker Desktop en Windows. Docker Desktop usará WSL por debajo y tenemos la posibilidad de que los subsistemas hagan uso del Docker engine creado instalado en Docker Desktop. Este es el modo aconsejado por la documentación de Microsoft.

- Instalar el Docker Engine dentro de un subsistema Linux.

Este último método lo explicamos a continuación.

24.1 Instalar Docker Engine en WSL

En algunos casos nos puede interesar no hacer uso de Docker Desktop, porque lo que queremos es tener la posibilidad de un control total de Docker, como si de una instalación de máquina virtual completa de Linux se tratara. Es por ello que debemos realizar una pequña modificación en el funcionamiento del subsistema Linux correspondiente.

Es más sencillo hacer uso de Docker Desktop en lugar de este sistema.

Supongamos que hemos creado el subsistema Linux de la distribución Ubuntu, deberemos entrar en ella, y tendremos que crear un fichero en /etc/wsl.conf con el siguiente contenido.

Configuración del fichero wsl.conf

[boot]

systemd=true

Salimos de la distribución y tenemos que forzar su reinicio. Una vez realizado estos pasos, si volvemos a entrar en la instancia, systemd estará funcionando y por tanto podremos instalar y hacer uso del Docker Engine como si fuese una máquina virtual creada al modo tradicional.

Introducción a Docker

25 Introducción

Hoy en día es muy habitual hacer uso de los sistemas de contenedores, siendo el más conocido Docker en el mundo del desarrollo de software. Este sistema trae consigo una serie de ventajas que veremos más adelante, que nos permite asegurar, entre otras cosas, que las versiones utilizadas en el entorno de producción son las mismas que durante las etapas de desarrollo.

En este documento se va a explicar cómo realizar la instalación y configuración de un sistema basado en contenedores Docker para poder arrancar servicios, y ciertas configuraciones que son necesarias conocer.

26 Sistemas de contenedores

Los sistemas de contenedores son un método de virtualización (conocido como “virtualización a nivel de sistema operativo”), en el que se permite ejecutar sobre una capa virtualizadora del núcleo del sistema operativo distintas instancias de “espacio de usuario”.

Este “espacio de usuario” (donde se ejecutarán aplicaciones, servicios...) se les denomina contenedores, y aunque pueden ser como un servidor real, están bajo un mecanismo de aislamiento proporcionado por el kernel del sistema operativo, y sobre el que se pueden aplicar límites de espacio, recursos de memoria, de acceso a disco...

Un contenedor es un espacio de ejecución de servicios al que se les puede aplicar límites de recursos (como la memoria, el acceso a disco…)

Desde el punto de vista del usuario, que un servicio se ejecute en una máquina virtual o en un contenedor es indistinguible. En cambio, desde el punto de vista de un administrador de sistemas o de un desarrollador, el uso de contenedores trae consigo una serie de ventajas que veremos en apartados posteriores.

26.1 Un poco de historia

Aunque está muy en boga el despliegue de aplicaciones haciendo uso de contenedores, no es un concepto nuevo, ya que lleva existiendo desde la década de los 80 en sistemas UNIX con el concepto de chroot.

Chroot, también conocido como “jaulas chroot”, permitían ejecutar comandos dentro de un directorio sin que, en principio, se pudiese salir de dicha ruta. Tenía muy pocas restricciones de seguridad, pero era un primer paso al sistema de contenedores.

LXC nace en 2008 utilizando distintas funcionalidades del kernel Linux para proveer un entorno virtual donde poder ejecutar distintos procesos y tener su propio espacio de red. Con LXC nacen distintas herramientas para controlar estos contenedores, así como para crear plantillas y una API que permite interaccionar con LXC desde distintos lenguajes de programación.

Ha habido otras tecnologías en Linux, como OpenVz, pero nos centraremos en Docker, ya que es lo más conocido actualmente.

26.2 Qué es un contenedor y cómo se crea

Para entender qué es un contenedor dentro de la infraestructura Docker y cómo se crea, tenemos que diferenciar distintos conceptos:

- Imagen Docker

- Contenedor Docker

A continuación se van a detallar en profundidad.

26.2.1 Imágenes Docker

Para crear un contenedor necesitamos hacer uso de una “imagen”, que es un archivo inmutable (no modificable) que contiene el código de la aplicación que queremos ejecutar y todas sus dependencias necesarias, para que pueda ser ejecutada de manera rápida y confiable independientemente del entorno en el que se encuentre.

Las imágenes, debido a su origen sólo-lectura, se pueden considerar como “plantillas”, que son la representación de una aplicación y el entorno necesario para ser ejecutada en un momento específico en el tiempo. Esta consistencia es una de las grandes características de Docker.

Una imagen contiene el servicio que nos interesa ejecutar junto con sus dependencias, y son independientes del servidor donde se ejecuta.

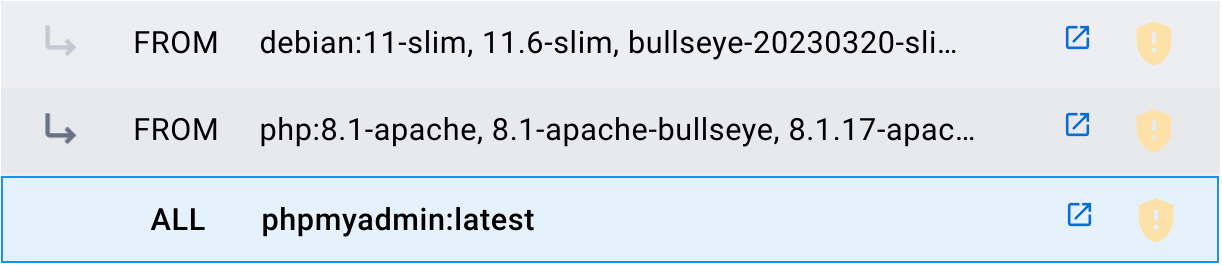

Una imagen puede ser creada utilizando otras imágenes como base. Por ejemplo, la imagen de PHPMyAdmin empaqueta la aplicación PHPMyAdmin sobre la imagen PHP (versión 8.1-apache), que a su vez hace uso de la imagen Debian (versión 11-slim).

A las imágenes creadas se les suele añadir etiquetas (tags) para diferenciar versiones o características internas. Cada creador determina las etiquetas que le interesa crear. Por ejemplo:

- latest: Se le denomina a la última imagen creada.

- php:8.1-apache: Indica que en esta imagen PHP la versión es la 8.1 y además cuenta con Apache.

Podemos utilizar imágenes públicas descargadas a través de un registry público, que no es otra cosa que un repositorio de imágenes subidas por la comunidad. El registry principal más utilizado es Docker Hub.

Las imágenes Docker pueden ser públicas o privadas y se almacenan en un repositorio llamado registry, siendo el más conocido Docker Hub

Se pueden crear nuestras propias imágenes privadas, que pueden ser almacenadas en nuestros equipos o a través de un registry privado que podemos crear (también existen servicios de pago).

26.2.2 Contenedores Docker

Un contenedor Docker es un entorno de tiempo de ejecución virtualizado donde los usuarios pueden aislar aplicaciones. Estos contenedores son unidades compactas y portátiles a las que se les puede aplicar un sistema de limitación de recursos.

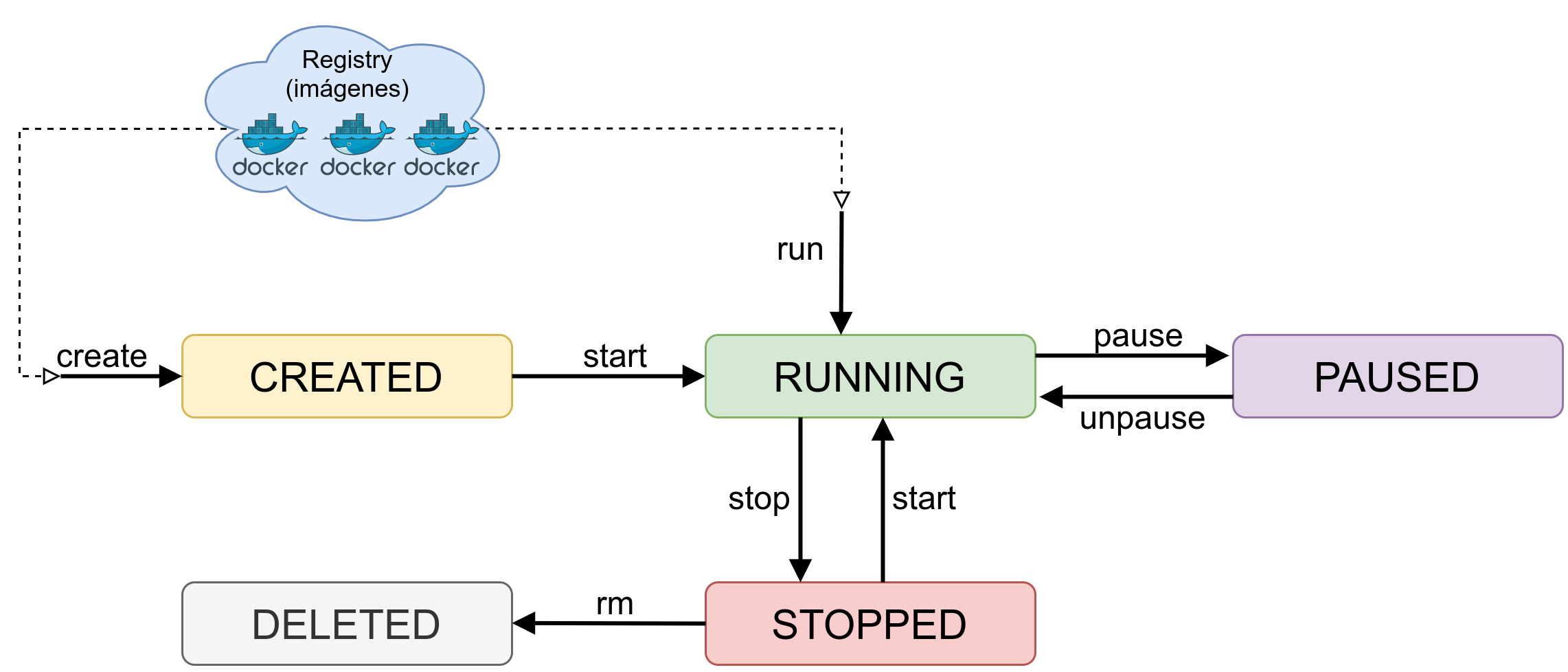

Un contenedor se crea a través de una imagen, es la versión ejecutable de la misma que se crea en un entorno virtualizado

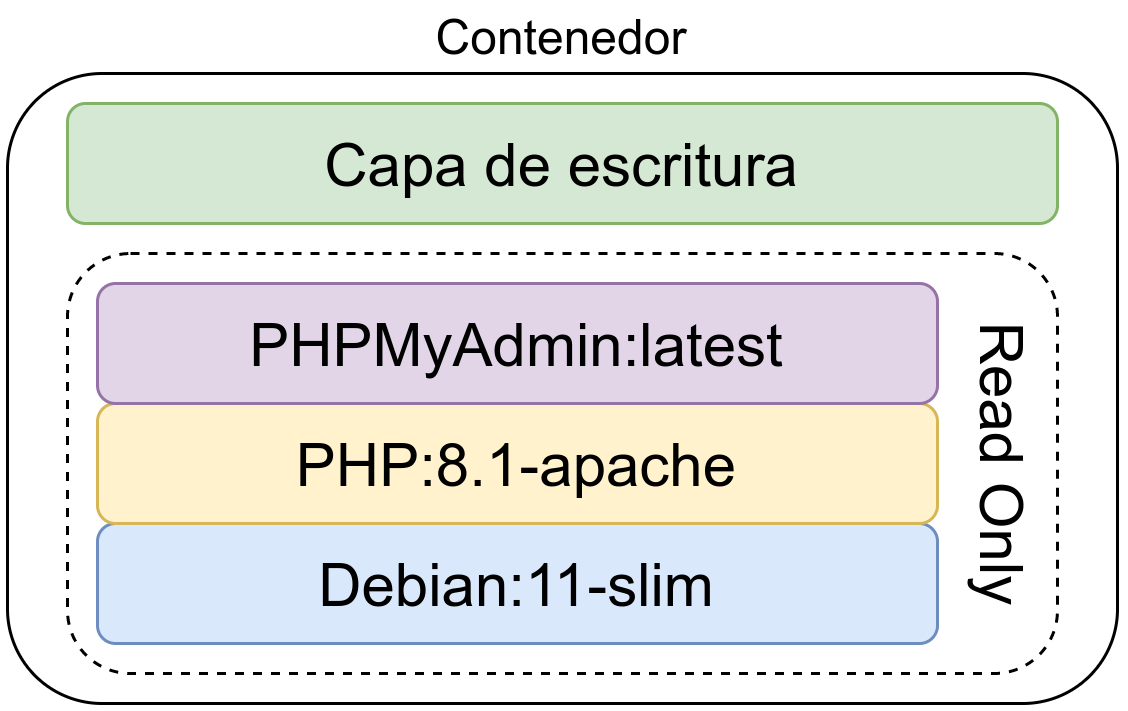

Un contenedor se crea a través de una imagen y es la versión ejecutable de la misma. Lo que se hace es crear una capa de escritura sobre la imagen inmutable, donde se podrán escribir datos. Se pueden crear un número ilimitados de contenedores haciendo uso de la misma imagen base.

La capa de escritura no es persistente y se pierde al eliminar el contenedor, es decir, los datos de un contenedor se eliminan al borrar el contendor. Para evitar este comportamiento se puede hacer uso de un volumen persistente de datos, de esta manera esos datos no se pierden.

Los datos creados dentro de un contenedor se borran al eliminar el contenedor

26.3 Contenedores vs. Máquinas virtuales

El uso de máquinas virtuales está muy extendido gracias a que cada vez es más sencillo crearlas. Esto no quiere decir que siempre sea la mejor opción, por lo que se va a realizar una comparativa teniendo en cuenta distintos aspectos a la hora de realizar un desarrollo con máquinas virtuales y con sistemas de contenedores.

26.3.1 Infraestructura

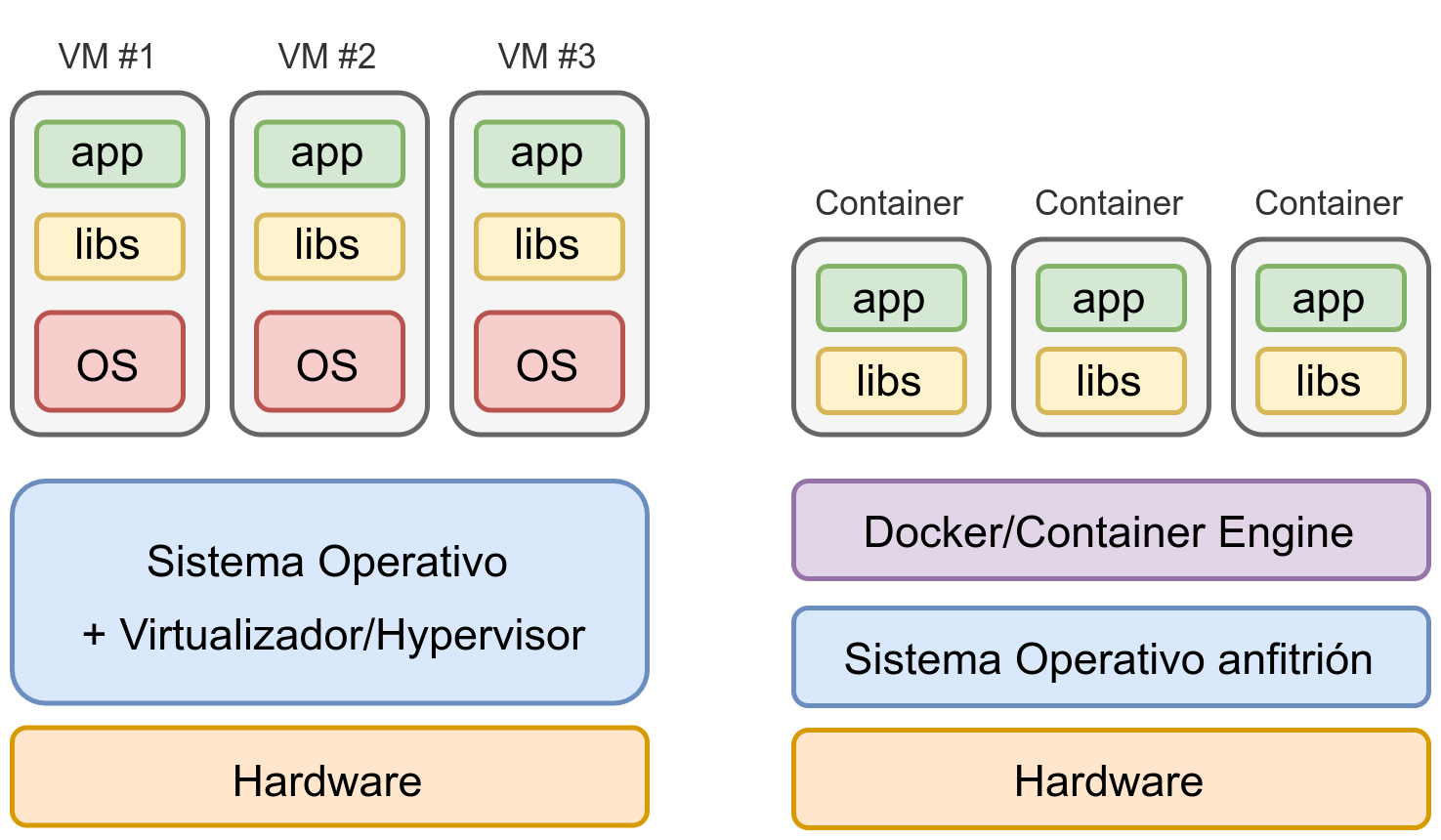

La creación de máquinas virtuales nos permite crear entornos aislados en los que poder instalar el Sistema Operativo que más nos interese y con ello poder instalar el software y los servicios que necesitemos.

Las máquinas virtuales se virtualizan a nivel de hardware, donde debe existir un Sistema Operativo con Hypervisor que permita dicha virtualización. Por otro lado, los contenedores se virtualizan en la capa de aplicación, haciendo que este sistema sea mucho más ligero, permitiendo utilizar esos recursos en los servicios que necesitamos hacer funcionar dentro de los contenedores.

En la imagen se puede apreciar una comparativa diferenciando cómo quedaría una infraestructura de 3 aplicaciones levantadas en distintas máquinas virtuales o en distintos contenedores.

Tal como se puede ver en la imagen, al tener cada servicio en una máquina virtual separada, se va a tener que virtualizar todo el Sistema Operativo en el que se encuentre, con el consiguiente coste de recursos (memoria RAM y disco duro) y con el coste en tiempo de tener que realizar la configuración y securización del mismo.

Usando contenedores la infraestructura se simplifica notáblemente

Por otro lado, en un sistema de contenedores, cada contenedor es un servicio aislado, en el que sólo tendremos que preocuparnos (en principio) de configurar sus parámetros.

26.3.2 Ventajas durante el desarrollo

A la hora de desarrollar una aplicación es habitual hacer pruebas utilizando distintas versiones de librerías, frameworks o versiones de un mismo lenguaje de programación. De esta manera, podremos ver si nuestra aplicación es compatible.

Cuando se hace uso de una máquina virtual dependemos de las versiones que tiene nuestra distribución y es posible que no podamos instalar nuevas versiones u otras versiones en paralelo.

Por ejemplo, la última versión de PHP actualmente es la 8.4.11 y de Apache la 2.4.65:

- En Debian 12 sólo se puede instalar PHP 8.2.29 y Apache 2.4.62.

- En Ubuntu 24.04 la versión de PHP es la 8.3.6 y la de Apache la 2.4.58.

Con Docker, podremos levantar contenedores con distintas versiones del servicio que nos interese en paralelo para comprobar si nuestra aplicación/servicio es compatible.

Con Docker es posible levantar servicios con distintas versiones en paralelo

Por otro lado, si un desarrollador quiere utilizar un sistema operativo distinto, no se tendrá que preocupar de si su distribución tiene las mismas versiones. O en el caso de usar Windows/Mac, no tener que estar realizando instalaciones de las versiones concretas.

26.3.3 Ventajas durante la puesta en producción

Ligado al apartado anterior, durante la puesta en producción es obligatorio hacer uso de las mismas versiones utilizadas durante el desarrollo para asegurar la compatibilidad.

Para asegurar la compatibilidad en producción, siempre se debe usar la misma versión de los servicios que en desarrollo

Si tenemos un servidor que no está actualizado, o en el mismo servidor tenemos distintas aplicaciones que requieren utilizar distintas versiones de software, en un entorno de máquinas virtuales se hace muy complejo, ya que lo habitual será tener que instalar nuevas máquinas virtuales.

No siempre es posible tener distintas versiones del mismo software en un mismo servidor

En un entorno con contenedores, al igual que se ha comentado antes, esto no es problema.

26.3.4 Rapidez en el despliegue

Ligado a todo lo anterior, realizar el despliegue de un entorno de desarrollo/producción es más rápido utilizando contenedores, sin importar el sistema operativo en el que nos encontremos.

El despliegue con contenedores es más rápido.

Más adelante se verá cómo realizar el despliegue de distintos servicios haciendo uso de un único comando.

27 Docker

Docker es un proyecto de Software Libre nacido en 2013 que permite realizar el despliegue de aplicaciones y servicios a través de contenedores de manera rápida y sencilla, tal como veremos más adelante.

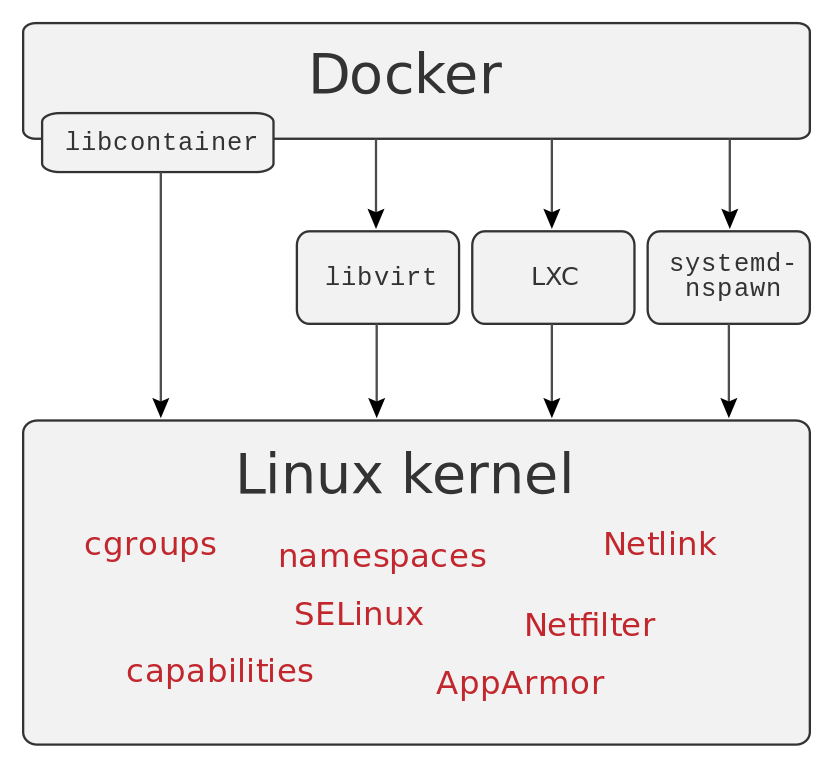

Estos contenedores proporcionan una capa de abstracción y permiten aislar las aplicaciones del resto del sistema operativo a través del uso de ciertas características del kernel Linux.

Dentro del contenedor, se puede destacar el aislamiento a nivel:

- Árbol de procesos

- Sistemas de ficheros montados

- ID de usuario

- Aislamiento de recursos (CPU, memoria, bloques de E/S...)

- Red aislada

Al igual que sucede con otro tipo de software, para que Docker haga uso de todas estas características, está construido haciendo uso de otras aplicaciones y servicios.

En el 2015 la empresa Docker creó la Open Container Initiative, proyecto actualemente bajo la Linux Foundation, con la intención de diseñar un estándar abierto para la virtualización a nivel de sistema operativo.

27.1 Instalación

Dependiendo del sistema operativo en el que nos encontremos, Docker tiene la opción de instalarse de distintas maneras. En sistemas operativos GNU/Linux cada distribución tiene un paquete para poder realizar la instalación del mismo.

Instalación de Docker en Ubuntu

ruben@vega:~$ sudo apt install docker.io

El nombre del paquete en Ubuntu y Debian es “docker.io”.

27.1.1 Instalación en Windows y/o Mac

En sistemas Windows y MacOS existe la opción de instalar Docker Desktop, una versión que utiliza una máquina virtual para simplificar la instalación en estos sistemas. De todas maneras, también se instala el CLI para poder usar los comandos que veremos a continuación.

En caso de Windows, se requiere tener las extensiones de virtualización habilitadas en la BIOS/UEFI y una de estas dos opciones, que habrá que configurar antes de instalar Docker Desktop:

- Usar WSL2.

- Usar Hyper-V y el sistema de contenedores de Windows.

27.2 Configuración

Tras realizar la instalación veremos cómo el servicio Docker ha levantado un interfaz nuevo en nuestra máquina, cuya IP es 172.17.0.1/16, siendo el direccionamiento por defecto.

Nueva IP en el equipo

ruben@vega:~$ ip a

...

3: docker0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc noqueue

link/ether 02:42:9c:1f:e2:90 brd ff:ff:ff:ff:ff:ff

inet 172.17.0.1/16 brd 172.17.255.255 scope global docker0

valid_lft forever preferred_lft forever

Esta IP hará de puente (similar a lo que sucede con las máquinas virtuales) cuando levantemos contenedores nuevos. Los contenedores estarán dentro de ese direccionamiento 172.17.0.0/16, por lo tanto, aislados de la red principal del equipo.

Los contenedores que levantemos estarán en la red 172.17.0.0/16

27.3 Usar Docker con usuario sin privilegios

Para poder hacer uso de Docker con un usuario sin permisos de root/administrador, se debe añadir a los usuarios no privilegiados dentro de un grupo. Dependiendo de dónde usemos Docker, tendremos que realizarlo de una manera u otra.

27.3.1 Linux

En este caso, el grupo que debe tener el usuario es “docker”, que se lo podemos añadir al usuario de distintas maneras:

- Editar el fichero /etc/group, y añadir el usuario al grupo

- Ejecutar estos comandos que ponemos a continuación:

Añadir el grupo docker al usuario correspondiente

ruben@vega:~$ sudo addgroup ruben docker

[sudo] password for ruben:

Adding user `ruben' to group `docker' ...

Adding user ruben to group docker

Done.

ruben@vega:~$ newgrp docker

A partir de ahora ya se puede hacer uso de Docker con el usuario al que hayamos añadido al grupo.

27.3.2 Windows

Para que un usuario en Windows pueda usar Docker Desktop tiene que pertenecer al grupo “docker-users”. Para añadirlo, desde un PowerShell con permisos de administrador, ejecutaremos:

Añadir al usuario “usuario” al grupo docker-users

PS C:\Users\ruben> net localgroup "docker-users" "usuario" /add

27.4 Primeros pasos

El comando docker tiene muchas opciones, por lo que es recomendable ejecutarlo sin parámetros. De esta manera se pueden ver todas las opciones y una ayuda simplificada para cada una de ellas.

Algunas de las opciones del comando docker

ruben@vega:~$ docker

Usage: docker [OPTIONS] COMMAND

Management Commands:

builder Manage builds

completion Generate the autocompletion script for the specified shell

config Manage Docker configs

container Manage containers

context Manage contexts

image Manage images

manifest Manage Docker image manifests and manifest lists

network Manage networks

node Manage Swarm nodes

plugin Manage plugins

secret Manage Docker secrets

service Manage services

stack Manage Docker stacks

swarm Manage Swarm

system Manage Docker

trust Manage trust on Docker images

volume Manage volumes

Commands:

...

Para cada una de estas opciones, se le puede añadir el parámetro --help para mostrar la ayuda. Hay un segundo apartado que se ha cortado, en el que se incluyen más comandos.

Para asegurar que el servicio Docker está funcionando, podemos hacer uso de docker info, que nos mostrará mucha información acerca del servicio. Pero si lo que queremos es comprobar si tenemos algún contenedor corriendo, es más sencillo hacer docker ps (que es la versión simplificada de docker container ls ):

Comprobar estado de Docker y contenedores levantados

ruben@vega:~$ docker ps

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

ruben@vega:~$ docker container ls

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

En este caso, como no hay ningún contenedor levantado, sólo muestra las cabeceras de las columnas del listado.

27.5 Levantando nuestro primer contenedor

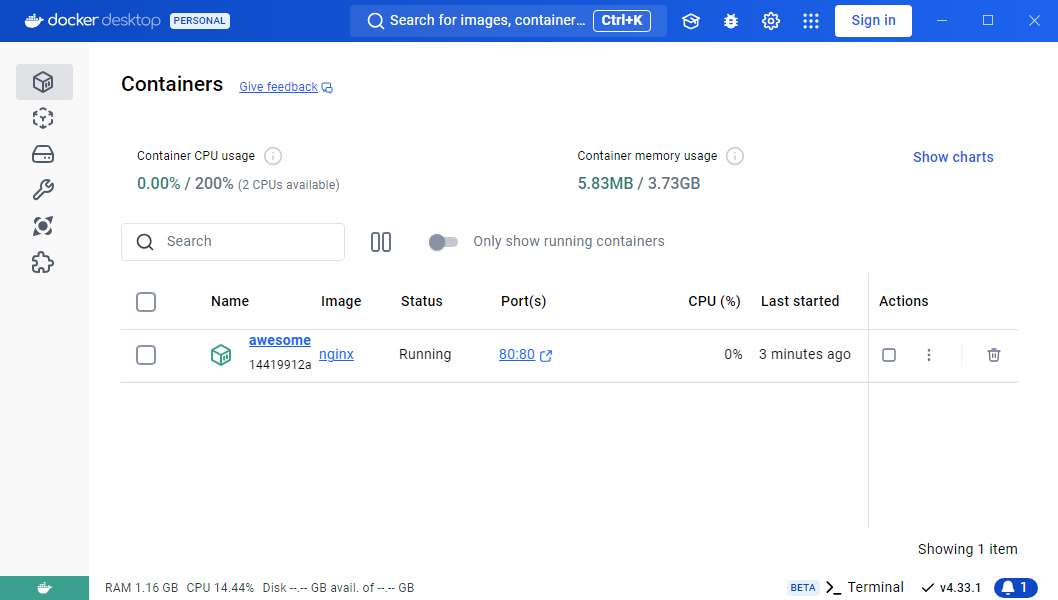

Es momento de crear nuestro primer contenedor. Para ello, dado que se está usando la consola, hay que hacer uso del comando docker con una serie de parámetros. En este caso se ha optado por levantar el servicio Apache HTTPD:

Levantando el primer contenedor

ruben@vega:~$ docker run -p 80:80 httpd

AH00558: httpd: Could not reliably determine the server's ...

AH00558: httpd: Could not reliably determine the server's ...

[Fri Mar 24 18:25:14.194246 2023] [mpm_event:notice] ...

[Fri Mar 24 18:25:14.194347 2023] [core:notice] [pid ...

172.17.0.1 - - [24/Mar/2023:18:25:41 +0000] "GET / HTTP/1.1" 304 -

Vemos los logs del servicio Apache al arrancar y si vamos al navegador a la dirección http://localhost muestra lo siguiente:

Y para entender lo que hace el comando, los parámetros son:

- docker: Cliente de consola para hacer uso de Docker.

- run: Ejecuta un comando en un nuevo contenedor (y si no existe lo crea).

- -p 80:80: Publica en el puerto 80 del servidor el puerto 80 utilizado en el contenedor. Se puede pensar que es como hacer un port-forward en un firewall.

- httpd: Es la imagen del contenedor que se va a arrancar. En este caso, la imagen del servidor Apache HTTPD.

Y si vemos qué muestra el estado de docker, vemos cómo aparece el contenedor levantado.

Comprobar estado de Docker y contenedores levantados

ruben@vega:~$ docker ps

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

a1c3362b0d6c httpd "httpd-..." 3 seconds ago Up 2 seconds 0.0.0.0:80->80/tcp great

En la columna PORTS se puede apreciar cómo aparece que se ha levantado el puerto 0.0.0.0:80 (escucha en el puerto 80 para cualquier IP del sistema operativo) que es una redirección al puerto 80/TCP interno del contenedor.

27.6 Contenedores en background y más opciones

Tal como se puede ver en el ejemplo anterior, el contenedor se queda en primer plano, viendo los logs del Apache. Esto para ver qué es lo que está sucendiendo durante el desarrollo puede ser útil, pero lo ideal es que el contenedor arranque en modo background, y cuando necesitemos vayamos a ver los logs.

A continuación se va a arrancar un nuevo contenedor de Apache con nuevos parámetros:

Crear un contenedor Web en el puerto 8080

ruben@vega:~$ docker run --name mi-apache -d -p 8080:80 httpd

Los nuevos parámetros son:

--name mi-apache: De esta manera se le da un nombre al contenedor, para poder identificarlo de manera rápida entre todos los contenedores creados.-d: Este parámetro es para hacer el detach del comando, y de esta manera mandar a background la ejecución del contenedor.-p 8080:80: Publica en el puerto 8080 del servidor el puerto 80 utilizado en el contenedor. Se puede pensar que es como hacer un port-forward en un firewall.

27.7 Parar, arrancar y borrar contenedores

Hasta ahora hemos aprendido a crear contenedores, pero en ciertos momentos nos puede interesar parar un contenedor que no estemos utilizando, o una vez haya cumplido su función, borrarlo.

27.7.1 Parar contenedores

Para parar un contenedor, debemos conocer el nombre del mismo o su ID (que es único). Estos datos los podemos conocer a través del comando docker ps.

Con esto, podemos ejecutar:

Parar un contenedor

ruben@vega:~$ docker stop mi-apache

27.7.2 Arrancar un contenedor parado

Una vez parado un contenedor, o al reiniciar el servidor, si queremos arrancar un contenedor parado, debemos conocer también su ID o nombre.

Para visualizar todos los contenedors (tanto los arrancados como los parados), lo podemos hacer a través del comando docker ps -a.

Gracias a ese listado, podemos volver a arrancar un contenedor que esté parado con docker start mi-apache, siendo “mi-apache” el contenedor que queremos arrancar.

27.7.3 Borrar un contenedor

Si queremos borrar un contenedor, éste debe estar parado, ya que Docker no nos va a dejar borrar un contenedor que está en ejecución.

Es interesante borrar contenedores que hayamos creado de pruebas o contenedores que ya no se vayan a utilizar más, para de esta manera liberar recursos.

Para borrarlo, similar a los casos anteriores, se hará con docker rm mi-apache.

28 Variables de entorno

Algunos contenedores tienen la opción de recibir variables de entorno al ser creados. Estas variables pueden afectar al comportamiento del contenedor, o para ser inicializado de alguna manera distinta a las opciones por defecto.

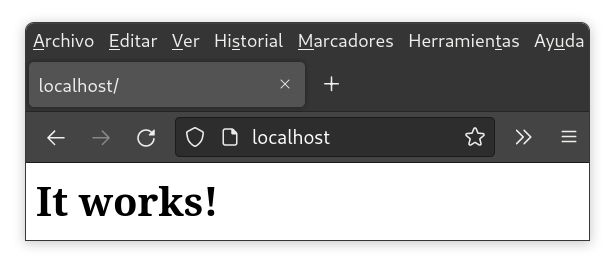

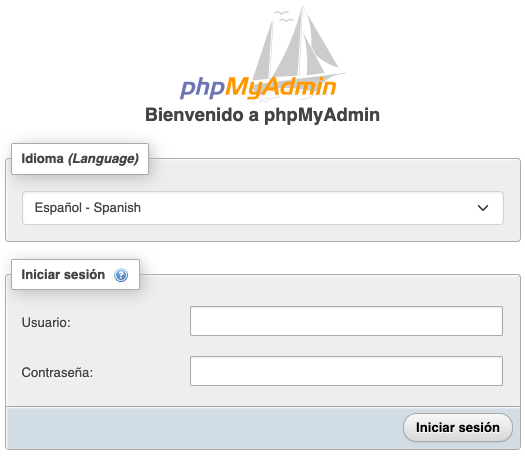

El creador de la imagen Docker puede crear las variables de entorno que necesite para después utilizarlas en su aplicación. A modo de ejemplo, se va a utilizar la imagen de la aplicación PHPMyAdmin.

A continuación se van a crear 2 contenedores de PHPMyAdmin, diferenciados por el puerto, el nombre, y la variable de entorno PMA_ARBITRARY:

- El primer contenedor va a estar en el puerto 8081, se le va a dar el nombre “myadmin-1” y no va a tener la variable de entorno incializada.

- El segundo contenedor usará el puerto 8082, llamado “myadmin-2” y la variable PMA_ARBITRARY inicializada a “1”, tal como aparece en la documentación de la imagen de PHPMyAdmin.

Para ello, se han ejecutado los siguientes comandos:

Creación de dos contenedores PHPMyAdmin

ruben@vega:~$ docker run --name myadmin-1 -d -p 8081:80 phpmyadmin

ruben@vega:~$ docker run --name myadmin-2 -e PMA_ARBITRARY=1 -d -p 8082:80 phpmyadmin

Tal como se puede ver, al segundo contenedor se le ha pasado un nuevo parámetro -e, que significa que lo que viene a continuación es una variable de entorno (en inglés environment). En este caso, la variable de entorno es PMA_ARBITRARY que se ha inicializado a 1.

Si ahora en nuestro navegador web apuntamos al puerto 8081 y al puerto 8082 de la IP de nuestro servidor, veremos cómo existe una ligera diferencia en el formulario que nos muestra la web.

En el formulario del puerto 8081 (donde no hemos inicializado la variable) sólo podemos indicar el usuario y la contraseña. Por el contrario, en el formulario del puerto 8082, al inicializar la variable PMA_ARBITRARY, y tal como nos dice la documentación de la imagen, nos permite indicar la IP del servidor MySQL al que nos queremos conectar.

A la izquierda formulario del puerto 8081, sin variable inicializada. A la derecha, puerto 8082 con variable inicializada.

Dado que una variable puede afectar al comportamiento (o la creación) del servicio que levantemos a través de un contenedor, es importante leer la documentación e identificar las variables que tiene por si nos son de utilidad.

Es recomendable leer la documentación de las imágenes Docker para identificar las posibles variables de entorno que existen y ver si nos son útiles.

29 Volumen persistente de datos

Hasta ahora hemos levantado un contenedor a través de una imagen que levanta el servicio Apache, mostrando su página por defecto. Podríamos escribir en el contenedor la página HTML que nos interesase, pero hay que entender que los datos de un contenedor desaparecen cuando el contenedor se elimina.

Para que los cambios realizados dentro de un contenedor se mantengan, tenemos que hacer uso de los denominados volúmenes de datos. Esto no es más que hacer un montaje de una ruta del disco duro del sistema operativo dentro de una ruta del contenedor.

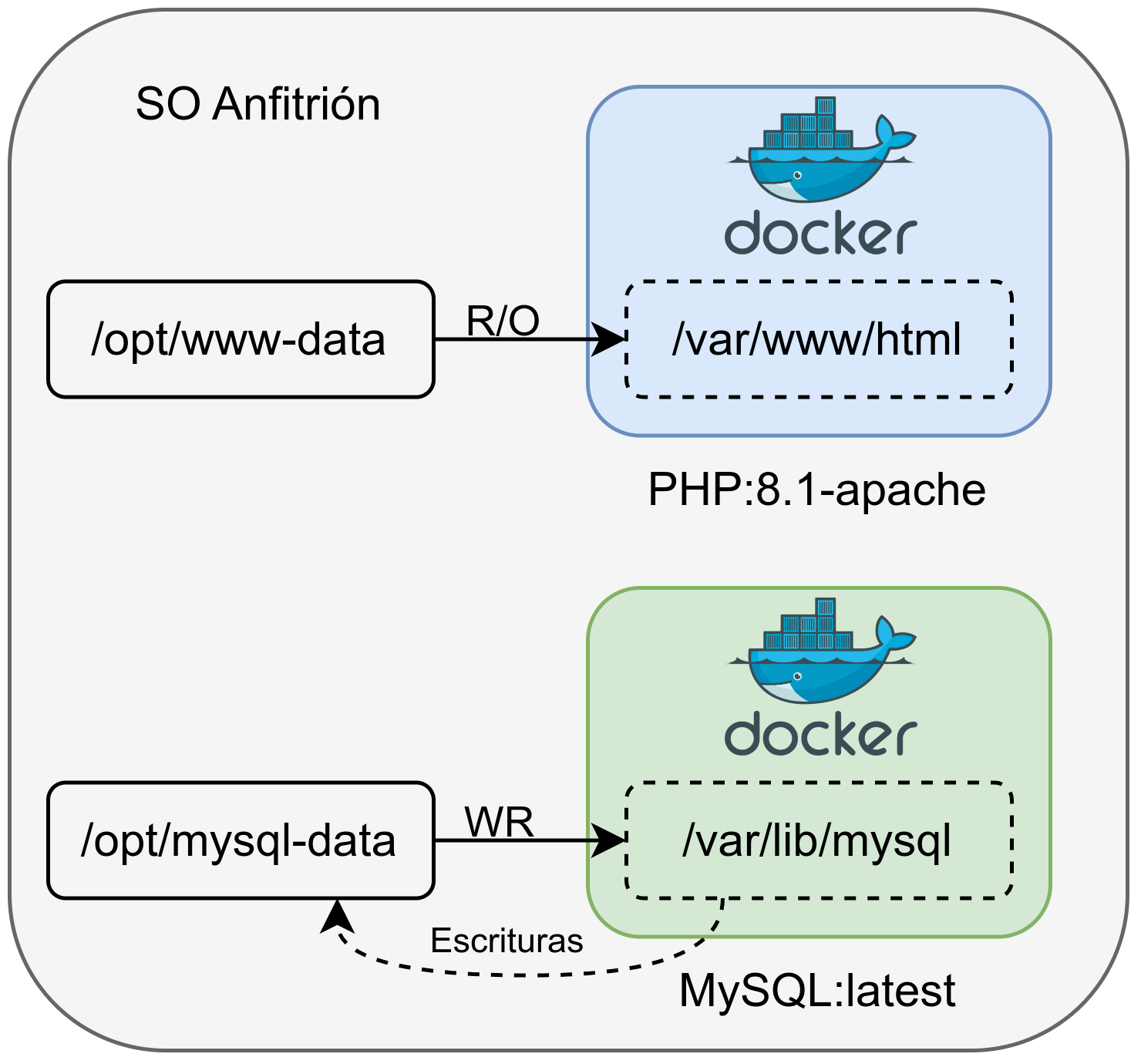

Estos volúmenes que le asignamos al contenedor pueden ser de dos tipos:

- Sólo lectura: Nos puede interesar asignar un volumen de sólo lectura cuando le pasamos ficheros de configuración o la propia web que queremos visualizar.

- Lectura-Escritura: En este caso se podrá escribir en el volumen. Por ejemplo, el directorio donde una base de datos guarda la información o una web donde deja imágenes subidas por usuarios.

De esta manera, tendremos que asignar el número de volúmenes necesarios a cada contenedor dependiendo de la imagen utilizada, el servicio que se levanta y lo que queremos hacer con los datos que le asignemos o generemos en el contenedor.

En la siguiente imagen se puede ver una infraestructura con dos contenedores y dos volúmenes:

- Contenedor Web: Se le asigna un volumen en modo sólo lectura cuya ruta original está en /opt/www-data, que dentro del contenedor está en /var/www/html.