Administración de Sistemas Gestores de Bases de Datos

1 Introducción

Hoy en día es habitual que los datos que usamos estén almacenados en una Base de Datos. Da igual que ese dato lo estemos utilizando desde un navegador web, en una aplicación de móvil o una videojuego. Cada consulta que realicemos al dato y cada posible modificación o eliminación del mismo realizará una petición (consulta o modificación) a un Sistema Gestor de Base de Datos.

Cada consulta realizada, cada petición de actualización o cada eliminación de datos, tendrá que ser procesada por el Gestor de Base de Datos y analizada para comprobar que lo que se va a realizar, como los permisos de quién pide la acción son adecuados, para posteriormente realizar la acción.

Los datos almacenados en una base de datos son de gran importancia en una empresa, por lo que la continuidad del servicio, así como la seguridad de los accesos recae en los administradores de Bases de Datos (DBA o DataBase Administrator) que deberán asegurar que el funcionamiento sea el esperado, así como la gestión de copias de seguridad de los mismos.

A lo largo de esta asignatura recordaremos los conceptos básicos de las bases de datos, comprenderemos la importancia y las funciones que desempeñan un Sistema Gestor de Base de Datos, aprenderemos a administrar el SGBD, crear y gestionar backups así como montar un sistema en Alta Disponibilidad.

2 Repaso

A modo de repaso rápido de la asignatura Gestión de Bases de Datos, veremos rápidamente unos conceptos que nos deberían ser conocidos.

2.1 ¿Qué es una Base de Datos?

Recordemos que una base de datos es un conjunto de datos que suelen pertenecer a un mismo contexto y que está almacenado para poder ser consultado posteriormente. Aunque actualmente una base de datos se asocia a un sistema informático, una biblioteca también puede considerarse una base de datos, ya que almacena libros que se pueden consultar, y el bibliotecario (el que te da acceso a los libros, si es que perteneces a la biblioteca) podría ser el símil del sistema gestor de la base de datos.

Actualmente las bases de datos se encuentran en todos los lugares, no sólo en servidores específicamente creados para ellos. Algunos ejemplos:

Cada vez que usamos una aplicación de móvil, la propia aplicación cuenta con una base de datos interna (aparte de los datos que pueda consultar a bases de datos externas)

Las páginas web que visitamos almacenan datos en pequeñas bases de datos en los propios navegadores que usamos.

Aplicaciones de escritorio que guardan las preferencias del usuario en bases de datos.

No todas las bases de datos tienen por qué ser gestionadas por sistemas gestores (como los ejemplos puestos previamente), ya que el acceso a los datos quizá no sea necesario que esté controlado, pero en entornos empresariales es lo habitual.

2.2 Tipos de Bases de Datos

Las bases de datos se pueden clasificar de varias maneras, teniendo en cuenta el contexto que estemos manejando, las necesidades que tengamos, el tipo de datos que estemos utilizando…

Nos vamos a centrar en la clasificación teniendo en cuenta los distintos modelos de administración de los datos, concrétamente en el modelo relacional, aunque veremos otros también utilizados.

2.2.1 Bases de datos relacionales

Es el modelo más utilizado actualmente para representar problemas reales y administrarlos de manera dinámica. El paradigma nació en 1970 de la mano de Edgar Frank Codd cuya idea es el uso de “relaciones”.

En este modelo, el lugar y la forma en que se almacenen los datos no tienen relevancia (que sí tenían otros modelos previos).

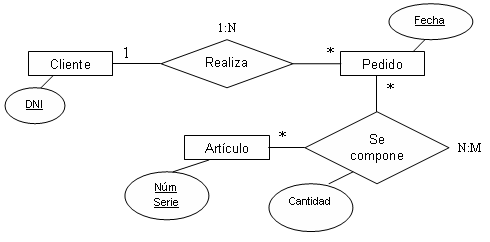

Para que una base de datos sea considerada relacional debe de seguir el modelo relacional, por lo que antes de introducir datos, para crear la base de datos habremos realizado los pasos necesarios para pasar del modelo entidad-relación al modelo relacional. Es por ello que hay que acordarse siempre de realizar la normalización de la base datos.

Para este tipo de bases de datos el lenguaje de consultas utilizado es el SQL (en inglés Structured Query Language; en castellano: lenguaje de consulta estructurada) el cual abordaremos más adelante.

2.2.2 No relacionales

Antes y después de la aparición del modelo relacional han existido distintos modelos de base de datos (jerárquico, de red, multidimensionales… ), por lo que hay que entender que el relacional no es el único modelo existente, aunque sí el más utilizado.

2.2.2.1 Bases de datos Documentales

Las bases de datos documentales son aquellas que se encargan de almacenar datos de tipo documento, también conocidos como datos semi-estructurados.

En el dato almacenado puede existir una estructura fija, o que puede ser modificada en el tiempo. Normalmente esta información suele estar almacenada en JSON o XML.

Este tipo de bases de datos entran dentro de las denominadas NoSQL, cuyos datos no requieren estructuras fijas como tablas y cuyo acceso suele realizarse mediante el sistema “clave-valor”.

Las bases de datos NoSQL están altamente optimizadas para las operaciones recuperar y agregar, y normalmente no ofrecen mucho más que la funcionalidad de almacenar los registros. No suele ser habitual el poder realizar consultas de tipo JOIN, por lo que este tipo de operaciones se realizaría desde la aplicación que realiza las consultas de obtención de datos.

No entraremos en este modelo de base de datos, debido a sus diferencias con el modelo relacional, pero es obligatorio conocer que existen y que son utilizadas en aplicaciones como las redes sociales (por ejemplo).

Algunos ejemplos de gestores NoSQL son: MongoDB, Elasticsearch, …

3 Sistemas Gestores de Bases de Datos

Un Sistema Gestor de Base de Datos es un conjunto de programas que permiten el almacenamiento, modificación y consulta de datos de una base de datos. Teniendo en cuenta los permisos del solicitante se le otorgarán ciertos privilegios lo que hará que se le permitirá acceder (o no) a ciertas funciones que podrá realizar sobre los datos.

Estos sistemas proporcionan distintas tareas para mantener la integridad de los datos, administrar el acceso y la opción de recuperar información en caso de que el sistema se corrompa.

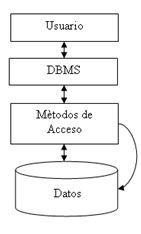

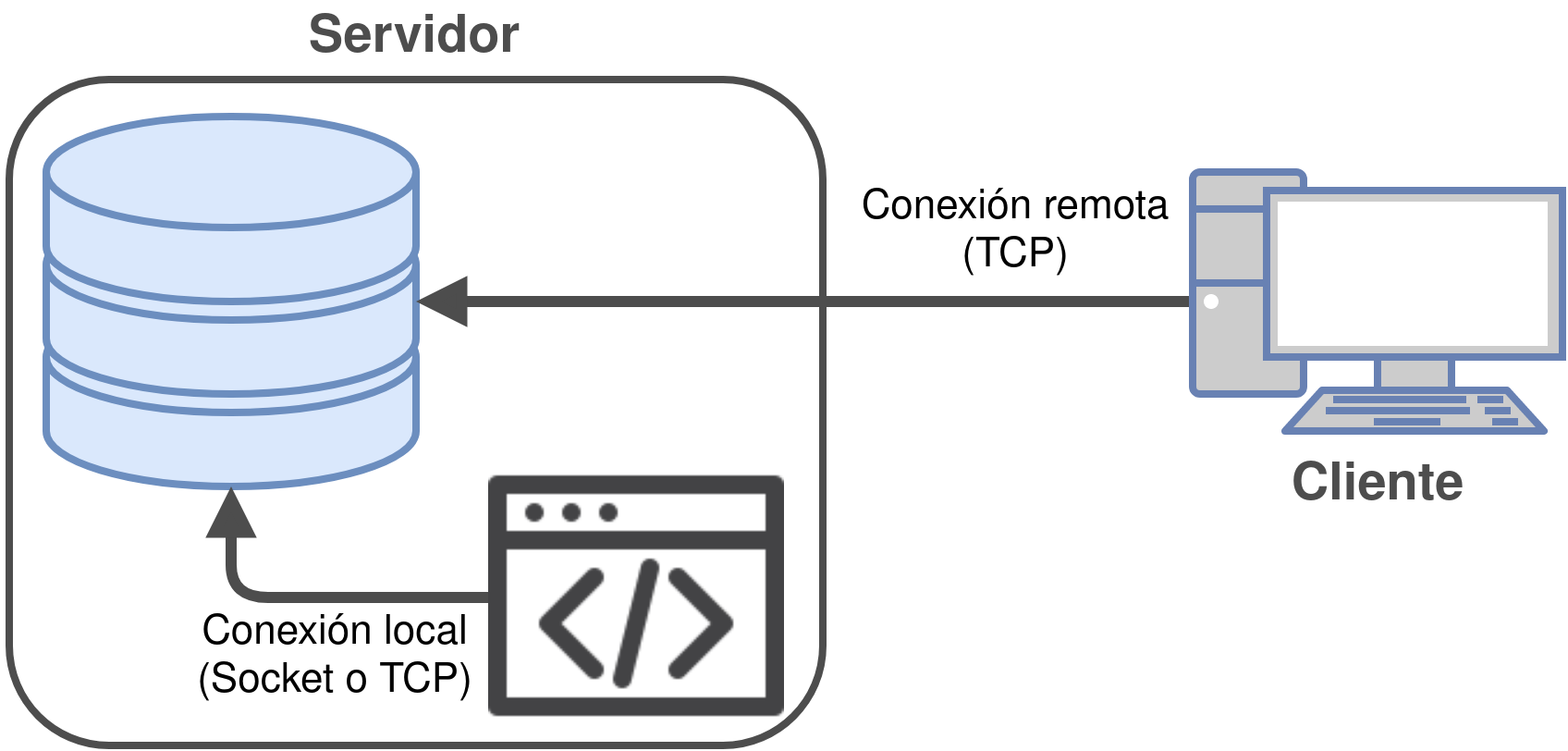

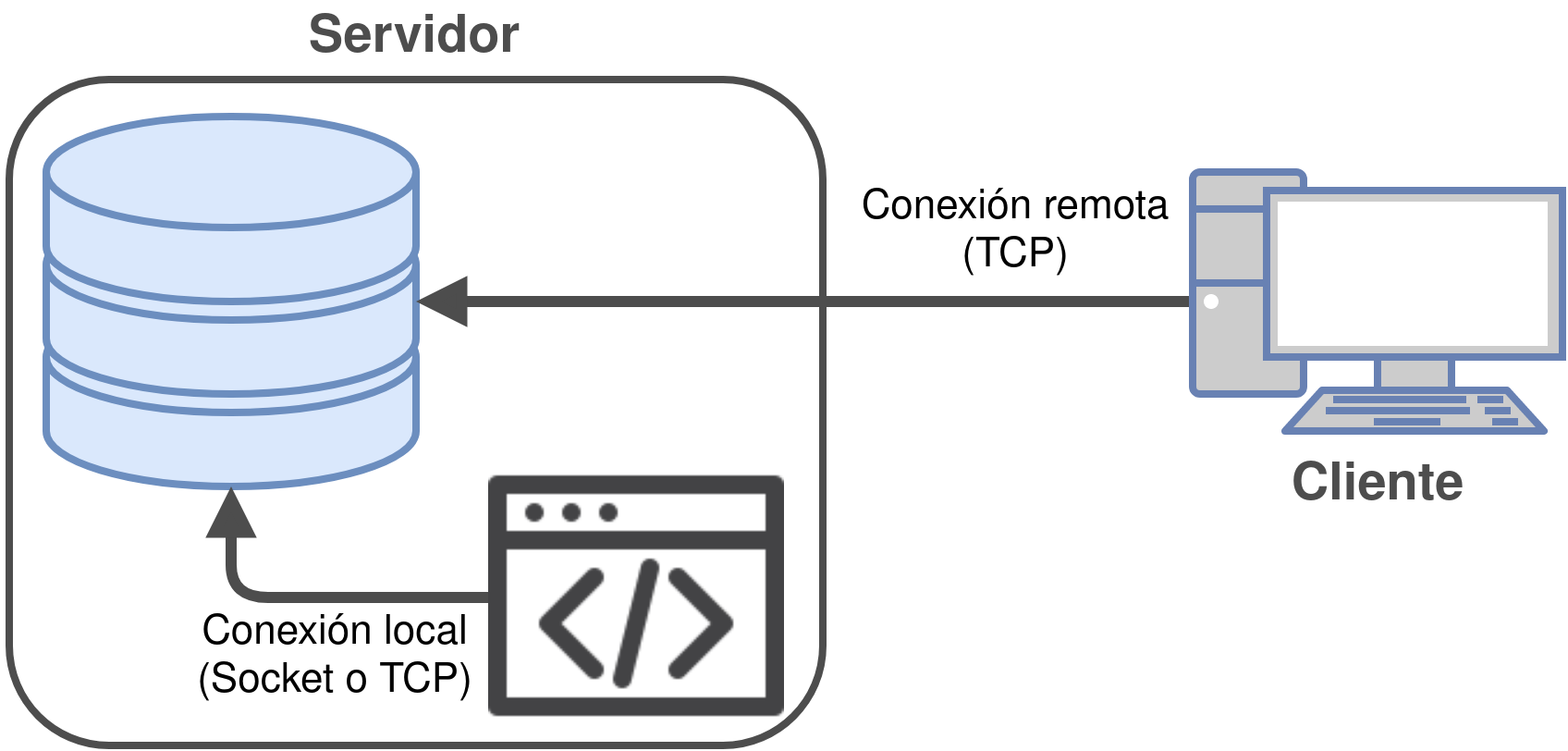

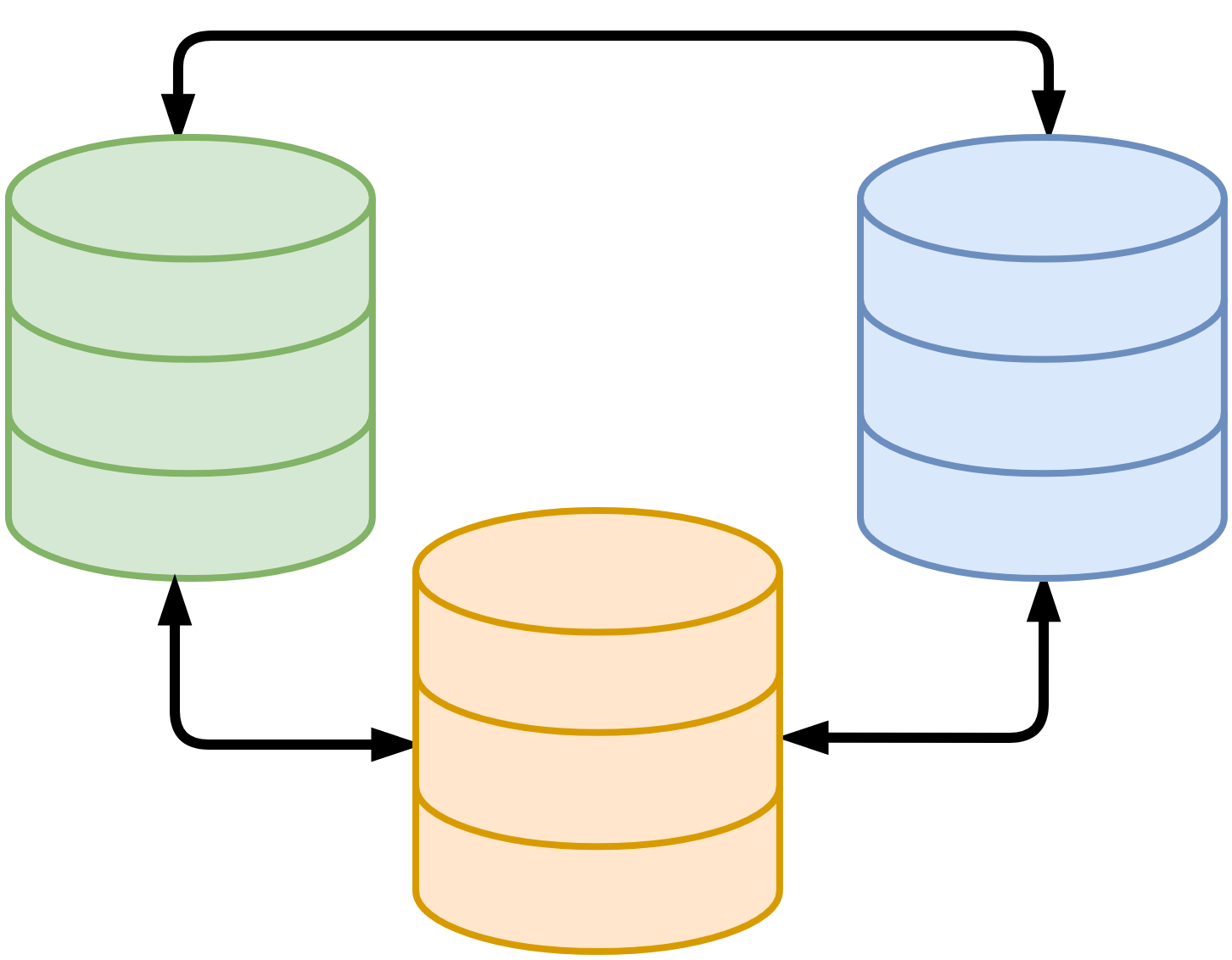

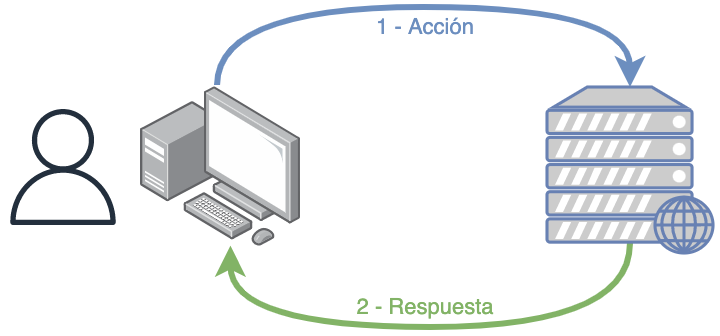

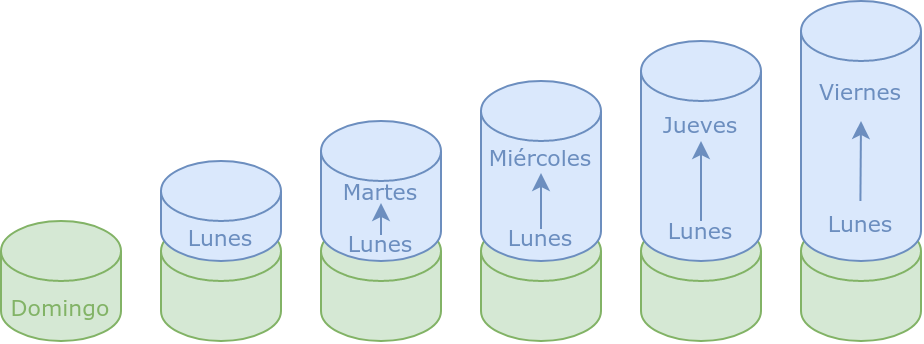

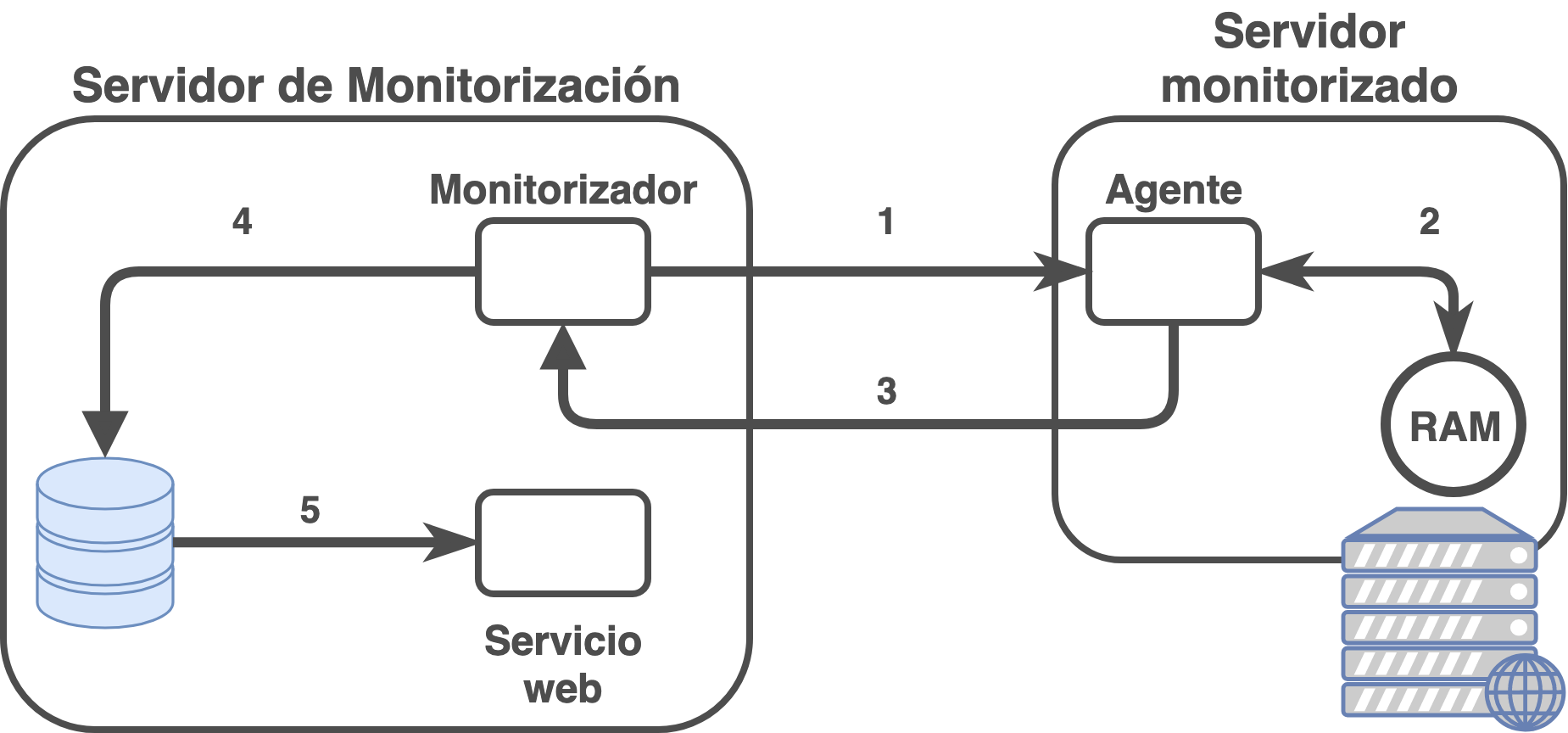

Tal como se puede ver en la imagen, el ejemplo de uso habitual de un Sistema Gestor de Base de Datos se puede resumir de la siguiente forma:

El usuario se comunica con el SGBD (Sistema Gestor de Base de Datos, o en inglés DBMS: DataBase Management System).

El SGBD comprueba que el usuario tiene permisos para acceder a los datos.

El SGBD conoce cómo están almacenados los datos por lo que hará uso del método de acceso adecuado de cómo se han guardado los datos.

Se recuperan los datos del dispositivo físico concreto donde estén almacenados los datos, teniendo en cuenta los datos pedidos por el usuario y el método de acceso.

Se le entregan los datos al usuario.

Todas estas tareas deben de realizarse de la manera más rápida posible, por lo que la optimización de cada una de las partes debe de ser adecuada.

3.1 Componentes de un SGBD

Normalmente un SGBD tiene los siguientes componentes:

El motor de la base de datos acepta peticiones lógicas de los otros subsistemas del SGBD, las convierte en su equivalente físico y accede a la base de datos y diccionario de datos en el dispositivo de almacenamiento.

El subsistema de definición de datos ayuda a crear y mantener el diccionario de datos y define la estructura del fichero que soporta la base de datos.

El subsistema de manipulación de datos ayuda al usuario a añadir, cambiar y borrar información de la base de datos y la consulta para extraer información. El subsistema de manipulación de datos suele ser la interfaz principal del usuario con la base de datos, y normalmente se hace uso del lenguaje SQL.

El subsistema de administración ayuda a gestionar la base de datos ofreciendo funcionalidades como almacenamiento y recuperación, gestión de la seguridad, optimización de preguntas, control de concurrencia y gestión de cambios.

Dependiendo del SGBD que utilicemos, podremos contar con otros apartados que vienen incluídos, o programas externos que podremos utilizar para ampliar alguna funcionalidad del mismo.

3.2 Modelo ACID de transacciones

En bases de datos se denomina ACID a las características de los parámetros que permiten clasificar las transacciones de los sistemas de gestión de bases de datos, donde ACID es un acrónimo en inglés de Atomicity, Consistency, Isolation and Durability (en castellano: Atomicidad, Consistencia, Aislamiento y Durabilidad).

Las definiciones son:

Atomicidad: Una transacción es una unidad lógica de trabajo que contiene una o varias sentencias SQL. El principio básico de una transacción es el todo o nada, una operación atómica tiene éxito o falla como un todo.

Un SGBD ha de ser capaz de asegurar la integridad de los datos ante la concurrencia de varios usuarios a la vez.

Un SGBD debe de ser capaz de agrupar varias sentencias SQL,de tal manera que puedan ser validadas (commit) o desechadas (rollback) como una unidad.

Ejemplo: en el caso de una transacción bancaria o se ejecuta tanto el depósito y la deducción o ninguna acción es realizada

Consistencia: (Integridad). Es la propiedad que asegura que sólo se empieza aquello que se puede acabar. Por lo tanto se ejecutan aquellas operaciones que no van a romper las reglas y directrices de Integridad de la base de datos.

El SGBD debe asegurar que cualquier transacción llevará a la base de datos desde un estado válido a otro también válido.

El SGBD debe asegurar que los datos son exactos y consistentes, es decir que estén siempre intactos, sean siempre los esperados y que de ninguna manera cambian ni se deformen. De esta manera podemos garantizar que la información que se presenta al usuario será siempre la misma.

Isolation / Aislamiento: Esta propiedad asegura que una operación no puede afectar a otras.

Esto asegura que la realización de dos transacciones sobre la misma información sean independientes y no generen ningún tipo de error.

Esta propiedad define cómo y cuándo los cambios producidos por una operación se hacen visibles para las demás operaciones concurrentes.

El aislamiento puede alcanzarse en distintos niveles, siendo el parámetro esencial a la hora de seleccionar SGBDs.

Durabilidad / Persistencia: Esta propiedad asegura que una vez realizada la operación, ésta persistirá y no se podrá deshacer aunque falle el sistema y que de esta forma los datos sobrevivan.

3.3 Software SGBD

Actualmente existen distintos SGBD que podemos instalar en nuestros servidores. Cada uno de ellos cuentan con sus características propias, por lo que tendremos que conocer las necesidades que tenemos a la hora de elegir entre ellas.

MySQL: base de datos relacional, desarrollada por Oracle desde que en 2008 ésta se hiciera con Sun Microsystems y de licencia libre (aunque también cuenta con una versión no-libre).

PostgreSQL: base de datos relacional, desarrollada por PostgreSQL Global Development Group y de licencia libre.

SQL Server: base de datos relacional, desarrollada por Microsoft.

Oracle Database: base de datos de tipo objeto-relacional desarrollada por Oracle Corporation.

DB2: base de datos relacional, desarrollada por IBM.

MongoDB: base de datos documental, desarrollada por MongoDB y de licencia libre.

Cassandra: base de datos NoSQL distribuida y basada en el modelo clave-valor, desarrollada por Apache y de licencia libre.

Elasticsearch: base de datos documental que cuenta con un servidor de búsqueda de texto completo.

Existen otros SGBD (tanto relacionales como no), pero el listado muestra las más conocidas y utilizadas a día de hoy. La elección del SGBD que vayamos a utilizar en nuestro proyecto debería ir acompañado de un análisis profundo de las características de cada uno de ellos, así como de las necesidades que requerimos.

MySQL

4 MySQL como Sistema Gestor de Base de Datos

El SGBD que usaremos durante esta asignatura es MySQL.

4.1 Introducción

MySQL es un sistema de gestión de bases de datos relacional desarrollado actualmente por Oracle Corporation, conocida empresa que también tiene su sistema SGBD Oracle privativo. MySQL cuenta con una licencia dual: Licencia Pública General (GPL) y licencia comercial, por lo que en su página web podremos encontrar ambas versiones (la primera de código abierto y gratuita, y la segunda con opción de pago, con servicios extra y soporte).

Actualmente MySQL está considerada como la base de datos relacional de código abierto más popular y se puede instalar en los tres sistemas operativos más conocidos actualmente.

4.1.1 Un poco de historia

MySQL fue inicialmente desarrollado por MySQL AB (empresa fundada por David Axmark, Allan Larsson y Michael Widenius). MySQL AB fue adquirida por Sun Microsystems en 2008, y ésta a su vez fue comprada por Oracle Corporation en 2010.

Es cierto que aunque en sus primeras versiones carecía de características como la integridad referencial y transacciones (debido al motor MyISAM utilizado en la creación de tablas), que son características muy importantes en un SGBD (y que PostgreSQL sí tenía), no impidió que cogiera fama en los denominados entornos LAMP (Linux + Apache + MySQL + PHP).

Poco antes de la compra de Oracle, desde la comunidad libre se realizó un fork (una copia completa) del código fuente de MySQL que dió origen a MariaDB. Desde ese momento, ambos SGBD han tenido vidas paralelas, pero el origen es el mismo.

Muchas distribuciones GNU/Linux contaban con MySQL como sistema SGBD para poder ser instalado, pero a medida que el desarrollo de MariaDB fue ganando adeptos muchas distribuciones realizaron el cambio, por lo que en ciertas distribuciones no es posible instalar MySQL desde los repositorios oficiales. De hecho, algunas distribuciones mantienen el paquete MySQL pero siendo un alias para que se instale MariaDB.

Desde la compañía Percona también crearon un fork de MySQL en el que añaden mejoras creadas por ellos y también venden soporte para el mismo.

Como veremos a continuación, el no poder realizar la instalación desde los repositorios oficiales no nos impedirá tener MySQL instalado en nuestro sistema.

4.1.2 Versiones de MySQL

MySQL cuenta con distintas versiones de SGBDs que hay que conocer para saber qué versión se necesita en cada caso concreto. Nos vamos a centrar en las versiones Community (las de licenciamiento libre), pero estas versiones también cuentan con su versión con licencia comercial.

4.1.2.1 MySQL Community Server

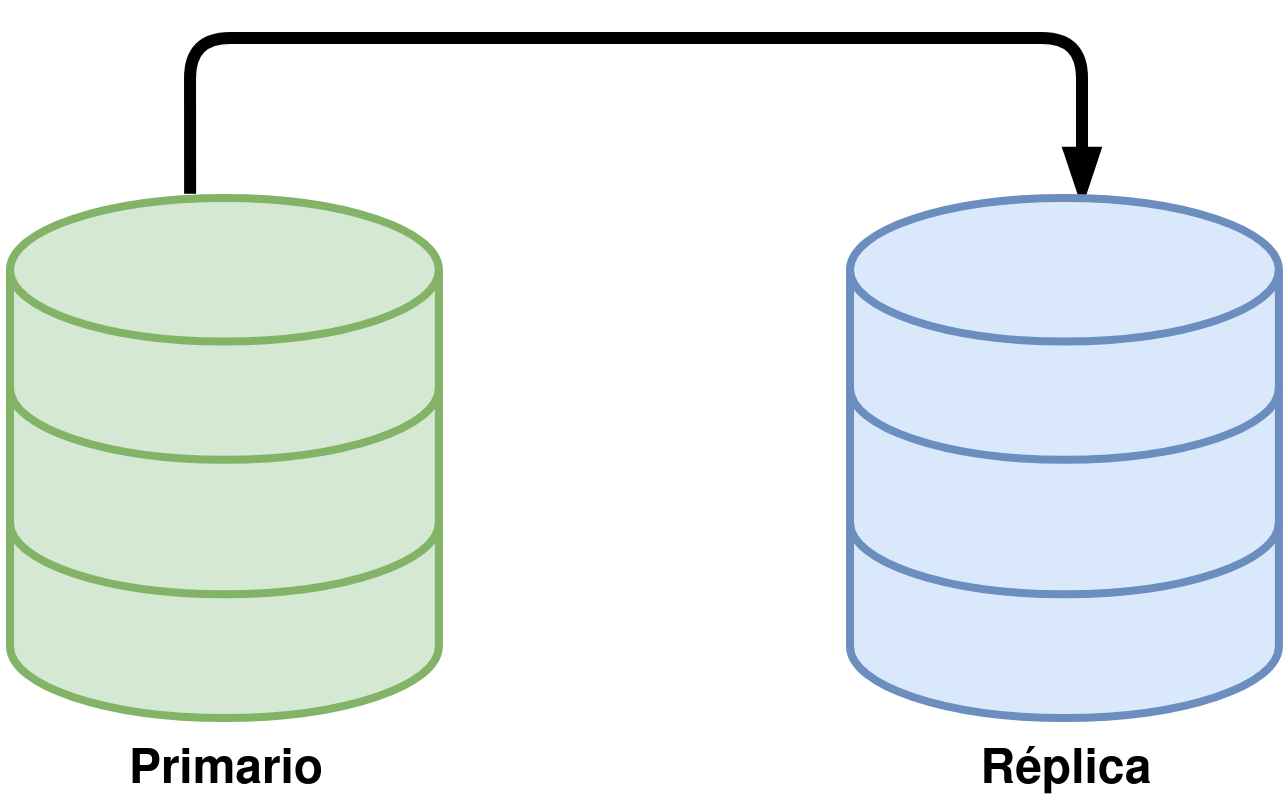

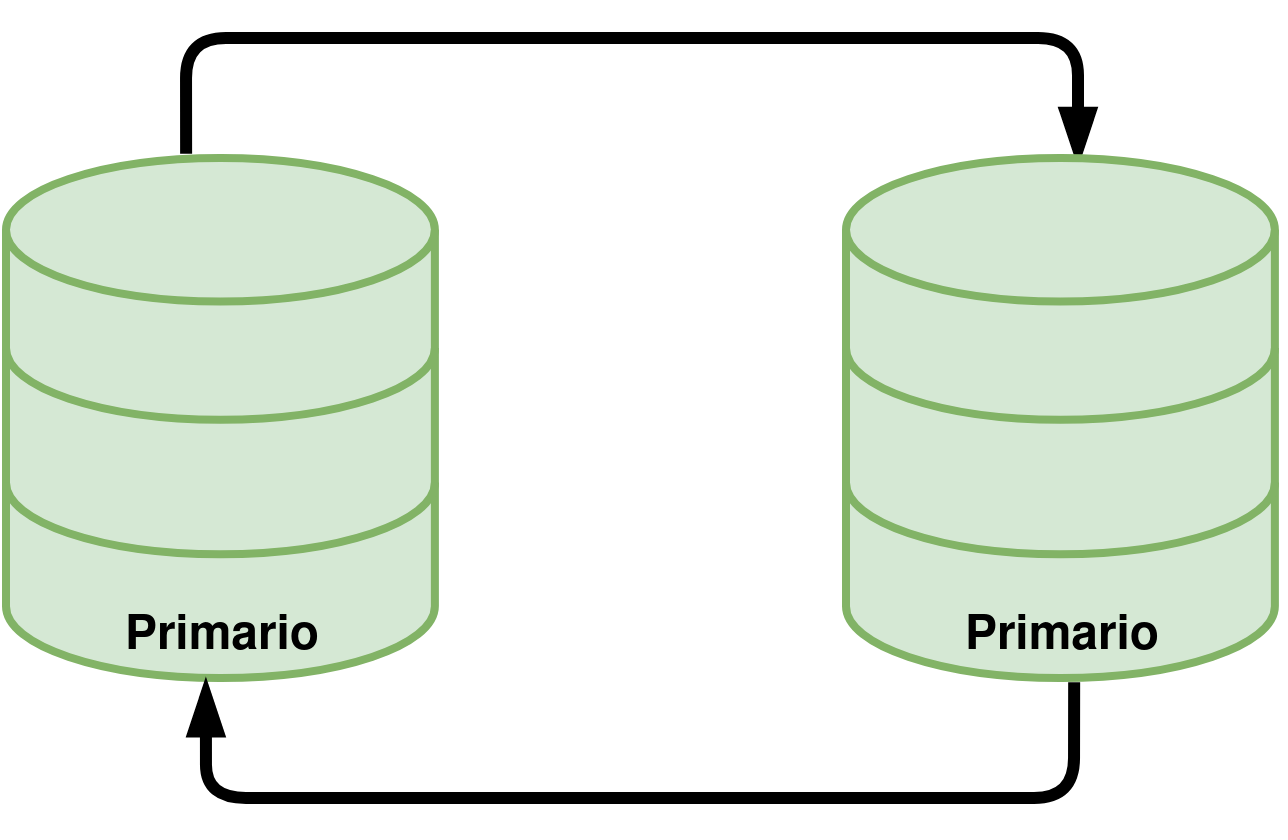

Es el SGBD que vamos a utilizar. Es la versión “clásica” de MySQL como SGBD, que permite crear bases de datos, introducir datos, manipularlos, … Esta versión cuenta con la opción de crear un sistema replicado “Primario → Réplica” o “Primario ←→ Primario” como veremos a lo largo del curso.

4.1.2.2 MySQL Cluster

Originalmente MySQL no soportaba crear clusters de servidores, sólo el sistema de replicación que soporta la versión “Community Server”, por lo que surgió la necesidad de poder crear un sistema clusterizado de 3 nodos o más que se gestionasen entre ellos, mantuvieran la información replicada… Eso se pudo realizar gracias a la librería Galera, que sirve para sincronizar la replicación de múltiples padres.

Hay que recordar que MySQL Server es distinto a MySQL Cluster, aunque desde un punto de vista de usuario que no entiende pueda parecer lo mismo.

4.1.2.3 MySQL Router

MySQL Router provee un enrutado transparente entre la aplicación de un usuario y cualquier servidor de MySQL. Puede sernos útil en sistemas de alta disponibilidad o de escalado para enrutar el tráfico al backend que más nos interese.

4.1.2.4 MySQL Workbench

Es un interfaz gráfico que nos proporciona herramientas para comprobar el estado de MySQL en el sistema remoto que tengamos que administrar. Existen versiones para distintos sistemas operativos y podremos instalarlo para conectarnos a servidores MySQL Remotos.

4.2 Características de MySQL Community Server

MySQL cuenta con una serie de características que hace que sea utilizado como SGBD de manera generalizada actualmente. Entre las características a destacar:

Facilidad de uso: Es un SGBD sencillo de utilizar en comparación con otras alternativas libres o privativas (PostgreSQL u Oracle respectivamente)

Soporte de motores de almacenamiento: Hasta la versión 5.5 se hacía uso del motor MyISAM que no tenía integridad referencial, pero eso se cambió por el uso del motor InnoDB que es el utilizado actualmente. Soporta varios motores, entre los que podemos destacar:

InnoDB: el utilizado por defecto actualmente. Es ACID compliant, seguro en transacciones, posibilidad para realizar commit y rollback.

MyISAM: debería usarse sólo para tablas de lectura, ya que no soporta transacciones, pero es muy rápido.

Memoria: se guarda toda la información en RAM, por lo que no sirve para persistencia de datos, pero hace que la información sea más rápida al acceder a ella

CSV: las tablas realmente son ficheros de texto en formato CSV. No soporta indexado.

Diseño multi-thread: por lo que permite hacer uso de múltiples hilos de CPU en caso de que estén disponibles.

Replicación: Permite crear entornos de replicación Primario → Réplica y Primario ←→ Primario.

Multiplataforma: Funciona en distintas plataformas (distintas versiones de GNU/Linux, MacOS, Windows, FreeBSD, …).

Software Libre: Tiene licencia libre lo que hace que podamos ver cómo funciona, y realizar modificaciones al código. Con ello se ha conseguido:

- Mucho soporte de la comunidad: Existen muchas herramientas realizadas por la comunidad que facilitan el uso y/o la administración de servidores MySQL.

4.3 Instalación de MySQL Community Server

Como ya se ha mencionado antes, en algunas distribuciones MySQL ha sido sustituido por MariaDB (como en el caso de Debian), mientras que en otras se puede realizar la instalación de cualquiera de las dos (el caso de Ubuntu).

Aunque haremos uso de la distribución Ubuntu, también se va a explicar brevemente cómo se haría la instalación en sistemas donde no podemos contar con el paquete en el repositorio oficial.

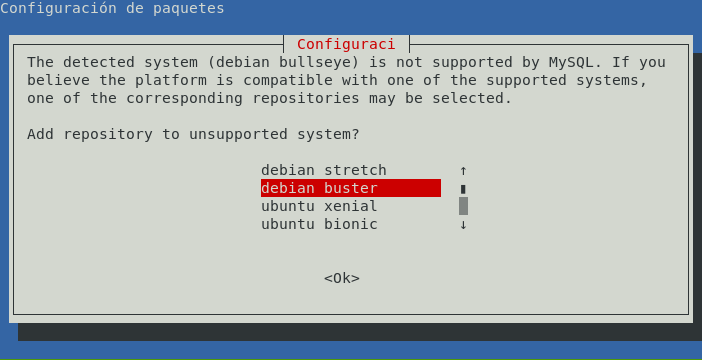

4.3.1 Sin paquete en el repositorio oficial

En caso de que nuestra distribución no cuente con el paquete en los repositorios oficiales, la instalación no será tan directa, pero eso no significa que sea difícil. La versión Community Server la podremos encontrar en su web de descarga, y desde aquí podremos descargarnos la versión que necesitemos para el sistema operativo que queramos.

En el caso de que queramos instalarlo en una distribución de GNU/Linux como Debian, Red Hat o Suse podremos hacer uso de los repositorios oficiales de MySQL para realizar la instalación. En el caso de Debian, sería:

- Descargar el paquete para poder configurar el repositorio oficial de MySQL para Debian/Ubuntu.

- Instalar el paquete:

Instalar paquete MySQL descargado de la web oficial

ruben@server1:~$ sudo dpkg -i mysql-apt-config_0.8.15-1_all.deb

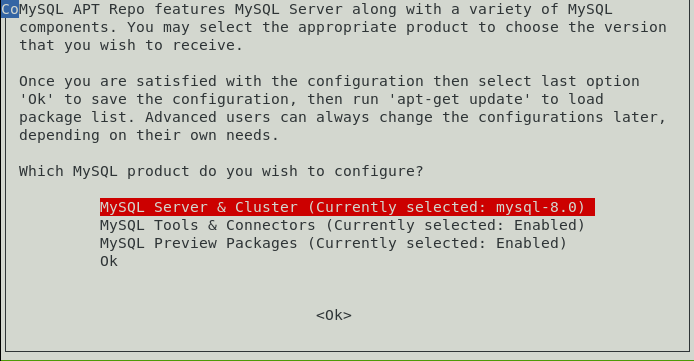

- Elegir en el menú que nos aparecerá:

En qué distribución estamos (ya que el mismo paquete sirve para Debian y Ubuntu).

Qué versión vas a querer instalar (dependiendo de la distribución y la versión en la que nos encontremos nos dejará unas versiones u otras).

- Instalar mysql-server (tal como veremos a continuación en Ubuntu).

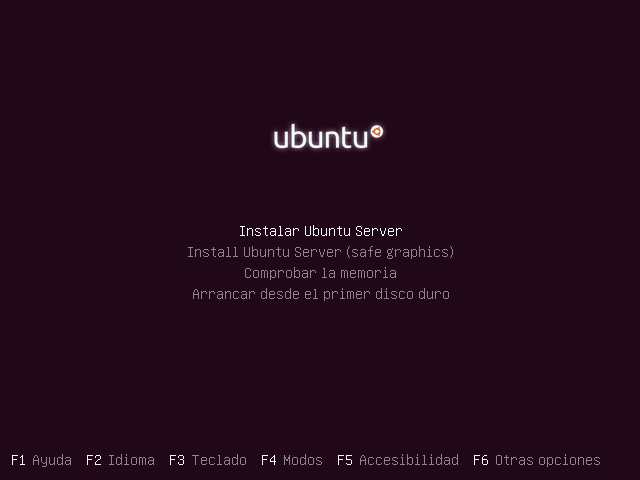

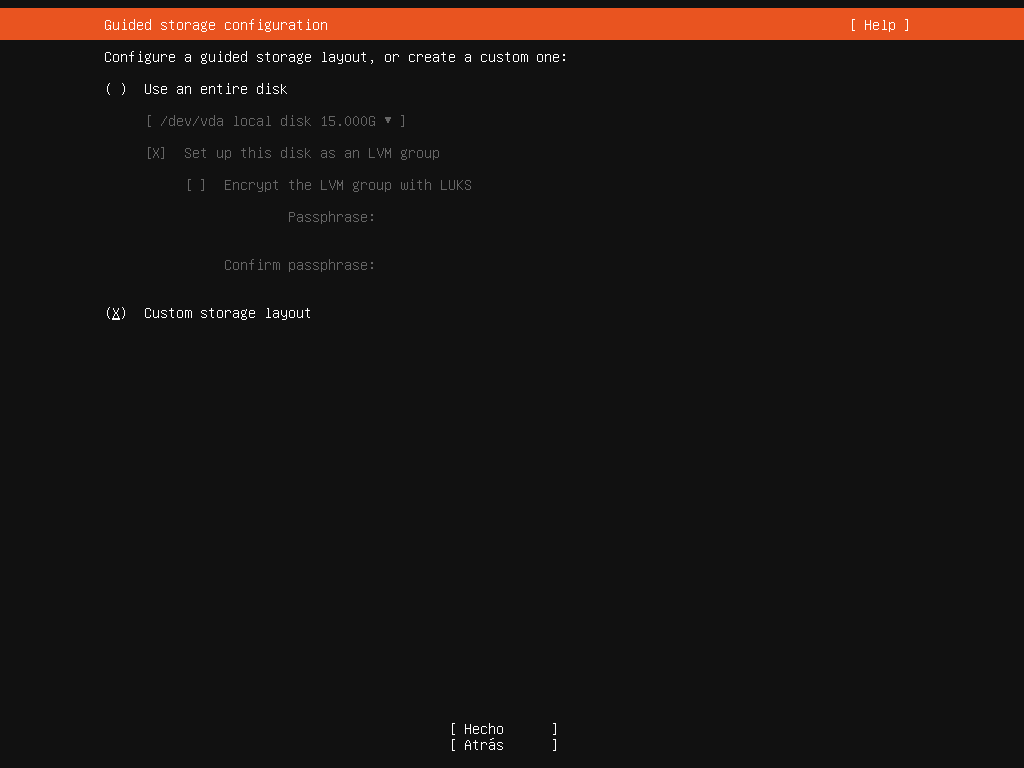

4.3.2 En Ubuntu 20.04

La versión LTS de Ubuntu 20.04 cuenta con la versión 8.0 de MySQL (concretamente la 8.0.21 en el momento en el que es creado este documento).

Debido a que contamos con esta versión, que es la última versión de MySQL podremos realizar la instalación de la siguiente manera:

Instalar paquete MySQL del repositorio de la distribución

ruben@server1:~$ sudo apt install mysql-server-8.0

5 Administración básica de MySQL

Una vez tenemos instalado nuestro SGBD tenemos que aprender los conceptos básicos para poder conectarnos a él, poder configurarlo y llegar a administrarlo.

5.1 Antes de empezar

MySQL, al igual que otros SGBD y servidores en general, y más cuando hablamos de Software Libre, cuenta con una documentación online realizada por los creadores del software con la que nos tenemos que familiarizar.

El manual de referencia de MySQL cuenta con mucha información acerca del servicio, de la configuración y administración, pero también de cómo utilizar el lenguaje SQL. Por lo tanto, es obligatorio tener soltura buscando información en él.

5.2 Arquitectura Cliente → Servidor en MySQL

MySQL funciona en “modo servidor” esperando a las conexiones de un cliente, lo que comúnmente se denomina “arquitectura Cliente → Servidor”.

El cliente que efectúa la conexión puede encontrarse en la misma máquina donde está situado el servidor (conexión local) o desde una máquina externa (conexión remota).

5.2.1 Conexión local (Socket)

En entornos UNIX existe la posibilidad de realizar la conexión a ciertos servidores que están en la misma máquina desde la que se origina la conexión, mediante lo que se denomina un Unix domain Socket.

Los sockets en entornos GNU/Linux se pueden ver como un fichero, y son un medio de comunicación entre procesos que se ejecutan en la misma máquina.

La configuración estándar de MySQL arranca creando un fichero Socket en la siguiente ruta por defecto /var/run/mysqld/mysqld.sock, por lo que la posibilidad de realizar una conexión local mediante dicho socket es posible.

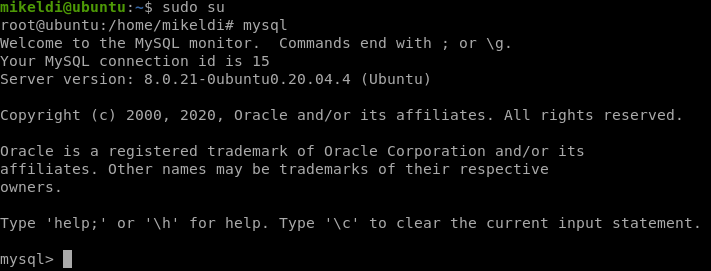

De hecho, nada más realizar la instalación de MySQL es la única manera de poder realizar la conexión y sólo será posible desde el usuario root:

Como se puede ver, en la imagen, los pasos para poder realizar la conexión han sido:

- Convertirnos en root

- Ejecutar el comando mysql.

Este comando es el cliente MySQL que realizará la conexión contra el Servidor MySQL. Debido a que no se le ha pasado ningún parámetro al comando, éste realizará un primer intento de conexión a la ruta del socket estándar (indicada anteriormente).

Una vez realizada la conexión veremos que nos aparece un prompt mysql> que indica que la conexión se ha realizado correctamente y estamos en el CLI (Command Line Interface, Interfaz de Línea de Comandos) donde podremos ejecutar órdenes de configuración, administración o peticiones a las bases de datos.

5.2.2 Conexión por red (local o remota)

En la configuración inicial de MySQL también aparece la opción de poder realizar una conexión mediante el protocolo de red TCP.

Ver puertos de MySQL

root@server1:~# ss -punta | grep -i mysql

tcp LISTEN 0 151 127.0.0.1:3306 0.0.0.0:* users:(("mysqld",pid=765,fd=34))

tcp LISTEN 0 70 *:33060 *:* users:(("mysqld",pid=765,fd=31))

Los puertos de escucha son:

- 3306: Puerto que escucha únicamente en la IP 127.0.0.1

- 33060: Nuevo protocolo X (desde la versión 5.7.12) que escucha en todas las IPs del sistema.

Para poder realizar conexiones a través de estos puertos los usuarios con los que intentemos conectarnos deberán poder aceptar dicha conexión. Más adelante veremos cómo realizar estas modificaciones.

Para poder realizar esta conexión también haremos uso del comando mysql. pero esta vez sí le tendremos que pasar parámetros de conexión. Un ejemplo de cómo conectarnos a un servidor por conexión de red es:

Conexión por red a MySQL

ruben@server1:~$ mysql -u usuario -h 192.168.1.100 -p

Podemos ver que se han pasado 3 parámetros y a continuación el valor que se le pasa a cada parámetro en el comando mysql. Los parámetros son:

-u o --user, es el usuario con el que vamos a realizar la conexión. Si no se usa éste parámetro, por defecto se le pasará el usuario con el que estamos logueados en el sistema

-h o --host, es el servidor al que queremos conectarnos mediante conexión por red. Si no se pone este parámetro la conexión se intentará a 127.0.0.1

-p o --password, para que nos pregunte por la contraseña de conexión del usuario. Si no se pasa este parámetro se entiende que no se va a necesitar contraseña.

5.3 Arranque, parada y estado del Servidor

Una vez instalado MySQL tenemos que conocer cuál es su estado y conocer los procedimientos de arranque y parada del servicio.

5.3.1 Comprobar estado del servidor

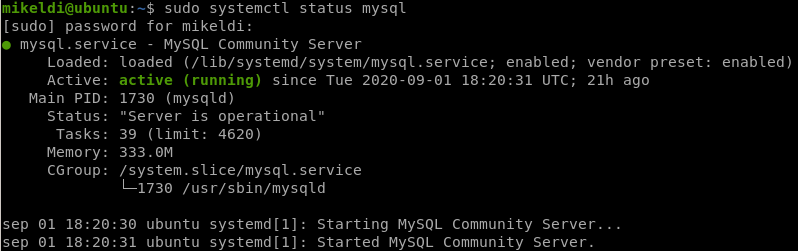

En la instalación de MySQL se ha instalado automáticamente un servicio en Systemd que nos permitirá conocer el estado de MySQL, si está arrancado o no.

Para ello deberemos ejecutar el siguiente comando:

Estado del servidor MySQL

ruben@server1:~$ sudo systemctl status mysql

Y tras realizar la ejecución del comando, en caso de que el servicio esté arrancado veremos:

5.3.2 Arranque y parada del servidor

En caso de que queramos parar el servidor, tendremos que hacer uso de Systemd:

Parar el servidor MySQL

ruben@server1:~$ sudo systemctl stop mysql

Y para arrancarlo de nuevo:

Arrancar el servidor MySQL

ruben@server1:~$ sudo systemctl start mysql

5.4 Primeros pasos

Como suele ser habitual cuando instalamos un servidor, viene con una configuración genérica que dista mucho de ser la ideal en un entorno productivo, y es por ello que tenemos que conocer cómo realizar modificaciones en la configuración para obtener mejores resultados.

Para poder administrar y configurar de manera correcta MySQL tendremos que conocer, al menos, lo siguiente:

- Especificaciones hardware donde está el servidor:

- Cantidad de memoria RAM

- Espacio en disco duro

- Velocidad de escritura/lectura a disco duro

- Tipo de aplicación que va a utilizar MySQL

- Conexiones esperadas

- Cantidad de usuarios que se van a conectar

- Origen de las conexiones

- …

Con esta información podremos realizar un primer análisis para intentar prever si el servidor donde está el servicio MySQL corriendo es suficiente o no. Si la instalación nos corresponde a nosotros, tendremos que conocer parte de las preguntas planteadas anteriormente para realizar la instalación en un servidor que vaya a poder adecuarse a las exigencias pedidas.

5.4.1 Securizar configuración inicial

Dependiendo del método elegido para instalar MySQL la configuración inicial puede venir con usuarios o bases de datos de prueba que no nos interesan y que se pueden borrar. Para poder securizarlo tenemos el siguiente comando:

Securizar la instalación

root@server1:~# mysql_secure_installation

Este script nos guiará con una serie de preguntas para securizar el servidor, que es muy utilizado en versiones anteriores, pero que no está de más ver las preguntas que nos realiza:

“Would you like to setup VALIDATE PASSWORD component?”: Habilita el componente de validación de contraseñas, que sirve para habilitar test de fuerza de las contraseñas, y en caso de no ser lo suficientemente seguras, no se permite crear el usuario con esa contraseña.

En versiones anteriores era un PLUGIN

Si lo habilitamos, no preguntará qué tipo de política queremos activar sobre las contraseñas:

- LOW: contraseñas de longitud mínima 8

- MEDIUM: como las LOW pero con números, caracteres especiales y mayúsculas y minúsculas.

- STRONG: como las MEDIUM pero que no se encuentren en un

Nos pedirá la contraseña del administrador “root” de MySQL. En la instalación de Ubuntu el usuario root se conecta mediante socket, por lo que este paso no cambiará nada.

“Remove anonymous users?”: En algunas distribuciones se crean unos usuarios anónimos, que deberían ser borrados.

“Disallow root login remotely?”: De nuevo, en Ubuntu el usuario root sólo se puede conectar en local mediante el socket, pero en otras distribuciones es posible que root pueda conectarse por TCP desde otros servidores y/o equipos. Lo recomendable suele ser que para root no se permitan conexiones remotas.

“Remove test database and access to it?”: MySQL suele venir con una base de datos de prueba llamada “test”. Se puede borrar.

“Reload privilege tables now?”: Recargar los permisos de los privilegios, ya que hemos realizado cambios en las contraseñas.

5.5 Ficheros de configuración

Como es habitual en GNU/Linux, los ficheros de configuración de los servicios están situados en el path /etc en este caso concreto dentro de la ruta /etc/mysql MySQL puede leer distintos ficheros de configuración, por lo que dependiendo de la distribución puede variar cuál tengamos, pero el orden suele ser:

- /etc/my.cnf: Es el primer fichero de configuración que se busca (en Ubuntu no lo tendremos)

- /etc/mysql/my.cnf : Fichero principal de configuración. En Ubuntu es un enlace simbólico a /etc/alternatives/my.cnf que a su vez es un enlace simbólico a /etc/mysql/mysql.cnf. Esto es debido a que en versiones antiguas esta última ruta era la oficial.

Si vemos este fichero de configuración veremos que tiene una directiva “!includedir”, esto significa que se van a incluir todos los ficheros con extensión “cnf” de esos directorios.

Estos ficheros de configuración tienen el formato conocido como “INI” y suele ser de este aspecto:

Ejemplo de fichero de configuración por secciones

[section]

option1 = value

[section2]

option2 = value

Debido a que durante la instalación de MySQL se han instalado otras herramientas, la sección determinará para qué servicio o aplicación será esa parte de la configuración:

- mysqld: servidor MySQL (mysql daemon)

- mysql: cliente de consola para realizar la conexión

- mysqldump: programa para realizar backups de las bases de datos.

Cuando realicemos modificaciones en la configuración de la configuración, si es para el servidor de MySQL tendremos que realizar un reinicio del servicio para que estas modificaciones sean tenidas en cuenta.

5.5.1 Analizando la configuración inicial

Tal como hemos comentado previamente, los ficheros de configuración en /etc/mysql pueden estar en distintos ficheros, por lo que es recomendable echar un ojo a los ficheros que tenemos tras realizar la instalación. Vamos a analizar parte del fichero: /etc/mysql/mysql.conf.d/mysqld.cnf:

Ejemplo de fichero de configuración de MySQL

#

# The MySQL database server configuration file.

# ...

[mysqld]

#

# * Basic Settings

#

user = mysql

# pid-file = /var/run/mysqld/mysqld.pid

# socket = /var/run/mysqld/mysqld.sock

# port = 3306

# datadir = /var/lib/mysql

bind-address = 127.0.0.1

#

# * Fine Tuning

#

key_buffer_size = 16M

# max_connections = 151

#

# * Logging and Replication

#

# Both location gets rotated by the cronjob.

#

# Log all queries

# Be aware that this log type is a performance killer.

# general_log_file = /var/log/mysql/query.log

# general_log = 1

#

# Error log - should be very few entries.

#

log_error = /var/log/mysql/error.log

#

# Here you can see queries with especially long duration

# slow_query_log = 1

# slow_query_log_file = /var/log/mysql/mysql-slow.log

# long_query_time = 2

# log-queries-not-using-indexes

Como se puede comprobar, en el fichero se pueden comprobar distintos tipos de filas, y el usar un editor que realice resaltado de sintaxis nos puede ayudar a diferenciar las líneas y lo que son. Vamos a realizar una pequeña explicación de varias líneas:

- Líneas que empiezan por “#: Al igual que sucede con otros ficheros de configuración, en este caso las líneas que empiezan por almohadilla, o”#“, son comentarios. Estas líneas son ignoradas y nos pueden ayudar a comprender la estructura del fichero o podremos poner comentarios para explicar para qué sirve una directiva de configuración.

- [mysqld]: Es el comienzo de la sección, y como se ha dicho previamente, esta sección será la que se utilice al arrancar MySQL. Por lo tanto, toda directiva de configuración dentro de esta sección servirá para modificar el comportamiento por defecto del servidor.

- user: indica al servidor MySQL con qué usuario arrancará el servidor

- bind-address: dirección en la que escuchará el servidor MySQL al arrancar

- log_error: fichero donde aparecerá lo acontecido durante el arranque del servicio y en caso de haber errores nos indicará parte de la razón.

Otras variables que aparecen comentadas en la configuración inicial y por tanto el valor que tiene esa opción de configuración no tiene por qué ser la que se esté utilizando actualmente:

- pid-file: fichero donde se escribirá el PID (Process IDentificator) durante el arranque.

- socket: fichero donde está el socket.

- port: puerto en el que escucha MySQL.

- datadir: lugar donde se almacena todos los datos de las bases de datos.

- max_connections: número máximo de conexiones que aceptará MySQL

- general_log_file: lugar donde se escribe el log general en caso de estar activo.

- general_log: activar, o no, el log general. Como se puede comprobar en un comentario previo, puede suponer un problema en el rendimiento del servidor.

- slow_query_log: log de queries lentas.

- long_query_time: el tiempo mínimo para que una slow query se loguee.

- log-queries-not-using-indexes: loguear las queries que no usan índices.

Como se puede ver en estas variables de configuración, y en las anteriores, el nombre de las mismas suele ser bastante auto-explicativo, por lo que nos podemos hacer una pequeña idea de lo que pueden hacer leyendo el nombre. Eso no quita para que en caso de duda, debemos consultar el listado completo de variables que puede llegar a tener MySQL.

Como se ha comentado previamente, en caso de realizar una modificación en el fichero de configuración, tendremos que realizar un reinicio del servicio como veremos posteriormente.

5.5.2 Validando la configuración

Las variables de configuración que hemos visto hasta ahora cuentan con dos apartados:

- Nombre de la variable: puede ser una única palabra (port, socket) o varias seguidas de guión bajo (bind_address, slow_query_log).

- Valor de la variable: Es el valor que aparece a la derecha del igual (“=”) y vemos que pueden tener distintos valores: mysql, 127.0.0.1, 16M , …

Los nombres de las variables es algo que no nos podemos inventar, y es por ello por lo que deben estar bien escritas en el fichero de configuración. En caso de escribir una variable que no exista, el servidor no arrancará si hacemos un reinicio del mismo. Ejemplo:

Ejemplo de log de error

2020-08-01T11:35:50.488392Z 0 [ERROR] [MY-000067] [Server] unknown variable 'mal=32M'

Como se puede ver en esta línea de log, hay un error al haber escrito una variable desconocida (en este caso el nombre de la variable es “mal”). Esto hace que el servidor no arranque y por tanto no se pueda acceder a él y haya una pérdida de servicio. Esto no debe suceder en un servidor en producción.

Para evitar este problema, antes de realizar cualquier reinicio del servidor, debemos asegurarnos que el fichero de configuración no contiene variables desconocidas:

Confirmar estado de la configuración

root@ubuntu:/etc/mysql/mysql.conf.d# mysqld --validate-config

2020-08-01T12:02:41.763658Z 0 [ERROR] [MY-000067] [Server] unknown variable 'mal=32M'

2020-08-01T12:02:41.763689Z 0 [ERROR] [MY-010119] [Server] Aborting

Esta opción nos puede ser útil si realizamos una actualización de MySQL y en la nueva versión ya no existen variables de versiones anteriores (es raro, pero puede haber opciones obsoletas).

Esta validación de configuración no hace una comprobación exhaustiva del valor adjudicado a la variable

Esta validación de configuración no hace una comprobación exhaustiva del valor adjudicado a la variable, por lo que en caso de que la variable sea correcta pero el valor adjudicado sea erróneo, al reiniciar el servidor tendremos que comprobar el log de errores para ver qué sucede. Por ejemplo, de tener lo siguiente en la configuración:

Error puesto en la configuración

bind-address = 127.0.0.1z

Al intentar reiniciar, veremos el siguiente error en /var/log/mysql/error.log:

Error en el log

[ERROR] [MY-010255] [Server] Can't create IP socket: Invalid argument

En cambio, si otras variables tienen un valor incorrecto, el servidor arrancará, y el valor que cogerá la variable dependerá de cómo se parsea el fichero de configuración. Por ejemplo:

Error en la configuración

key_buffer_size = 16Mz

max_connections = -1

Para conocer qué valor pueden tener estas variables, lo mejor es ir a la documentación y mirar la variable que queremos modificar o agregar. Por ejemplo, para slow_query_log veremos que en la documentación tiene la siguiente tabla:

| Referencia | Valor |

|---|---|

| Command-Line Format | --slow-query-log=ON |

| System Variable | slow_query_log |

| Scope | Global |

| Dynamic | Yes |

| SET_VAR Hint Applies | No |

| Type | Boolean |

| Default Value | OFF |

Esta tabla nos da mucha información acerca de la variable, ya sea para poder ver qué tipo de valor es (Boolean en este caso), su valor por defecto (OFF) y si podremos o no modificarla dinámicamente (Dynamic = Yes). El valor por defecto será el valor que obtendrá la variable si no aparece en el fichero de configuración con un valor puesto por nosotros.

Otro ejemplo, bind_address:

| Referencia | Valor |

|---|---|

| Command-Line Format | --sbind-addr=addr |

| System Variable | sbind_address |

| Scope | Global |

| Dynamic | No |

| SET_VAR Hint Applies | No |

| Type | String |

| Default Value | * |

5.6 Variables de configuración en MySQL

Tal como hemos visto, el listado completo de variables tiene cientos de posibles variables que podemos ver o modificar para ajustar el servidor a nuestros intereses. Las variables se deben separar en dos partes:

- System Var: Variables que sirven para el arranque del servidor o para ajustar el comportamiento del mismo. Se pueden modificar.

- Status Var: Variables para comprobar el estado del servidor. Sólo las podremos leer.

Las variables que podremos modificar se pueden pasar por:

- Fichero de configuración: la versión más cómoda, tal como hemos visto previamente. Hará que nuestro servidor siempre arranque con la misma configuración ya que los ficheros estarán escritos en el servidor.

- Línea de comandos: al arrancar mysqld, se le pueden pasar como parámetros estas variables con los valores que queramos. Se nos puede olvidar pasar algún parámetro.

Hay variables del sistema que si nos fijamos en la tabla no se puede pasar por fichero o por línea de comandos. Esto es debido a que son variables internas de cómo ha sido compilado MySQL o que tienen en cuenta las librerías del sistemas. Por ejemplo: version, have_ssl.

Si nos fijamos en la columna “Var Scope” vemos que puede tener los valores:

- Global : son variables que afectan a las nuevas conexiones que se realizan.

- Session : son variables que afectan a la sesión actual. Si intentamos leer una variable de sesión que no existe, nos mostrará el valor global.

- Both : son variables que existen en ambos estados, global y en sesión, y pueden diferir.

- Varies : Hay unas pocas variables que tienen esta opción (y también en la columna Dynamic) y nos indica que varía dependiendo de la versión de MySQL que estemos usando.

5.6.1 Comprobando las variables de estado (STATUS)

El listado de variables de estado nos muestra el nombre de las variables por las que podemos preguntar, el tipo de valor que pueden tener y si son globales o de sesión.

Para comprobar el estado de las variables globales del servidor:

Ver variables de estado

mysql> SHOW GLOBAL STATUS;

Si nos interesa buscar por el nombre de alguna variable de la sesión y obtener su estado:

Ver variables de sesión

mysql> SHOW SESSION STATUS LIKE '%slow%';

+-----------------------------+-------+

| Variable_name | Value |

+-----------------------------+-------+

| Slow_launch_threads | 0 |

| Slow_queries | 0 |

+-----------------------------+-------+

2 rows in set (0.01 sec)

5.6.2 Comprobando las variables del sistema (System)

Hemos visto que en los ficheros de configuración no están todas las variables que hemos visto en la documentación, y no tendría mucho sentido tener que estar yendo a ella para mirar qué variables tenemos y sus posibles valores por defecto. Para ver las variables globales del sistema, es obligatorio poner GLOBAL:

Ver variables globales

mysql> SHOW GLOBAL VARIABLES;

Si queremos buscar por una variable en concreto en la sesión, poner SESSION es opcional (en lugar de GLOBAL).

De no poner en qué ámbito queremos mirar las variables, se presupone que queremos ver el estado de la variable en la sesión actual.

Si queremos buscar una variable que contenga algo en el nombre podremos hacer uso de:

Ver variables globales

mysql> SHOW VARIABLES like '%slow%';

+----------------------------+---------------------------------+

| Variable_name | Value |

+----------------------------+---------------------------------+

| log_slow_admin_statements | OFF |

| log_slow_extra | OFF |

| log_slow_slave_statements | OFF |

| slow_launch_time | 2 |

| slow_query_log | OFF |

| slow_query_log_file | /var/lib/mysql/ubuntu-slow.log |

+----------------------------+---------------------------------+

6 rows in set (0.01 sec)

De esta manera buscamos las variables que nos puedan interesar y vemos el valor que tienen actualmente en la sesión, para así poder ver si nos interesa cambiarlo.

También podemos hacer uso desde la línea de comandos con el comando mysqladmin, pero no tenemos tanta libertad como desde el CLI de MySQL :

Ver variables desde la consola

root@server1:~# mysqladmin variables

5.6.3 Modificar configuración “en caliente”

Debido a que un SGBD es un servicio crítico, no siempre podremos realizar una parada de servicio debido a un cambio de configuración. Esto afectaría a todas las conexiones que tiene establecido el servidor, y cualquier intento de consulta sería rechazado durante la parada y el arranque del mismo.

No sólo eso, ya que cuando un SGBD está en funcionamiento, guarda información en memoria RAM (a modo de caché para las peticiones más realizadas, traspasa parte de las tablas a memoria, … ) y en caso de realizar un reinicio, esa memoria se liberaría y por tanto al arrancar se debería volver a pedir los datos a disco duro, haciendo que los primeros instantes de servicio sea lento.

Por ello, se pueden realizar modificaciones de la configuración sin parar el servicio, lo que se suele denominar “hacer modificaciones en caliente”.

Bien es cierto que no todas las variables se pueden modificar de esta manera, ya que algunas son necesarias durante el arranque del servicio. Por ejemplo:

- port: no podrá ser modificada “en caliente”, ya que el puerto debe de ser algo que se necesita durante el arranque.

- bind_address: lo mismo que la anterior.

- slow_query_log: si se puede modificar en caliente.

Para conocer si una directiva puede ser modificada en tiempo de ejecución podremos ir al listado completo de variables y comprobar la columna “Dynamic”, si aparece “Yes” es que se podrá modificar. Anteriormente hemos visto cómo la variable slow_query_log tiene la opción “Dynamic” a “Yes”, por lo que se puede modificar el valor dinámicamente, y para cambiarlo haremos:

Cambiar variable

mysql> SET slow_query_log = On;

ERROR 1229 (HY000): Variable 'slow_query_log' is a GLOBAL variable

and should be set with SET GLOBAL

mysql> SET GLOBAL slow_query_log = On;

Query OK, 0 rows affected (0.01 sec)

-- alternativa

mysql> SET @@GLOBAL.slow_query_log = On;

Query OK, 0 rows affected (0.01 sec)

Como se puede comprobar, se ha intentado modificar la variable sin poner “GLOBAL”, y debido a que “slow_query_log” es una variable global, nos ha dado un error. Por eso es muy importante tener en cuenta qué tipo de variable y para qué ámbito queremos realizar la modificación. También se puede ver que la modificación se puede realizar de dos maneras.

Hay que tener en cuenta que la variable modificada en caliente no se guarda en la configuración y por tanto se perderá en el siguiente reinicio.

5.6.4 Persistencia de las modificaciones

MySQL permite que estas variables que podamos hacer que estas variables persistan tras el arranque haciendo:

Cambiar variable de manera persistente

mysql> SET PERSIST slow_query_log = ON;

Esto lo que hace es crear un fichero en /var/lib/mysql/mysqld-auto.cnf con formato JSON con las variables que se ha dado la orden de persistir.

No se aconseja utilizar este método. Mejor modificar la configuración.

Aunque resulte cómodo, se aconseja realizar la modificación de la variable en el fichero de configuración correspondiente para tener todo de manera más centralizada. Para deshacer esta persistencia:

Eliminar las variables persistentes

mysql> RESET PERSIST;

Query OK, 0 rows affected (0.00 sec)

Y eliminará todas las entradas del fichero antes descrito: /var/lib/mysql/mysqld-auto.cnf.

SQL

6 SQL básico

6.1 Introducción

SQL (por sus siglas en inglés Structured Query Language) surgió como una evolución de un lenguaje previo llamado SEQUEL. SQL nació en IBM en 1977. Unos años más tarde fue considerado un estándar ANSI y al año siguiente (1987) un estándar ISO.

SQL tiene las siguientes características:

Lenguaje de definición de datos (DDL): nos permite crear y/o manipular la estructura de la base de datos y las relaciones que en ellas deben existir.

Lenguaje de manipulación de datos (DML): este apartado se puede subdividir en las siguientes tareas:

- Consultar determinada información.

- Insertar nuevos datos.

- Modificar los datos existentes.

- Eliminar datos que ya no sean necesarios.

Control de transacciones: para definir cuándo se inicia, cuándo finaliza o si es necesario deshacer una transacción.

Control de datos: permite asignar y revocar permisos a los usuarios, tanto de acceso a la información como de operaciones que pueden realizar sobre los mismos.

El lenguaje SQL puede ser utilizado:

- De forma interactiva: en una consola o desde un CLI instalado en la propia máquina donde se encuentra el servidor u otra máquina remota.

- Inmerso dentro de un lenguaje de programación anfitrión, ejecutando consultas desde Java o PHP, por ejemplo.

Es un lenguaje declarativo ya que permite especificar la operación que se debe llevar a cabo (en forma de sentencias), pero no la forma en la que se llevará a cabo. Esa será la tarea del SGBD, ejecutar la tarea de la manera más adecuada para obtener los datos.

Los SGBD implementan (de manera parcial o total) el estándar SQL y sobre él añaden funcionalidades propias e incluso lenguajes de programación propios derivados de SQL (PL/SQL en Oracle, PL/pgSQL en PostgreSQL. Por lo tanto, SQL no es un lenguaje de programación, pero hay SGBDs que han creado dicha funcionalidad.

Debido a que SQL es un estándar, las funciones principales deberían funcionar en cualquier SGBD que haga uso del estándar, aunque es cierto que algunos SGBD amplían SQL con funciones o procedimientos propios que otros SGBD no tienen porqué tener. Esas funciones o procedimientos extra a veces se incorporan al estándar un tiempo después.

Dentro del lenguaje SQL podemos separar las consultas o acciones teniendo en cuenta qué realizamos con ellos.

6.2 Lenguaje de definición de datos: DDL

El DDL (Data Definition Language) de SQL proporciona comandos para la definición de esquemas de relación, borrado de relaciones y modificaciones de los esquemas de relación. Existen tres operaciones básicas: CREATE, ALTER y DROP.

6.2.1 Gestión de bases de datos

La función de un SGBD es la de proporcionar la capacidad de tener distintas bases de datos en el sistema, es por ello que tenemos que aprender a gestionar las bases de datos que tenemos, o en un momento dado crear bases de datos.

Crear una base de datos y mostrar las existentes

mysql> CREATE DATABASE prueba;

mysql> SHOW DATABASES;

+-----------------------------+

| Database |

+-----------------------------+

| information_schema |

| mysql |

| performance_schema |

| prueba |

| sys |

+-----------------------------+

5 rows in set (0.00 sec)

Para poder entrar en una base de datos y poder visualizar, modificar o usar las tablas y datos que hay en ella:

“Entrar” en una base de datos

mysql> USE prueba;

Database changed

Borrar una base de datos existente.

Borrar una base de datos

mysql> DROP DATABASE prueba;

6.2.2 Gestión de tablas

La gestión de tablas se realiza cuando estamos dentro de una base de datos, por lo que deberemos asegurarnos que hemos entrado dentro de una de ellas antes de realizar ninguna gestión sobre ellas.

Crear distintas tablas

CREATE TABLE alumnos (

dni varchar(9) not null primary key,

nombre varchar(20),

apellido varchar (20),

telefono integer

);

CREATE TABLE asignaturas (

codigo integer not null primary key,

nombre varchar(50)

);

CREATE TABLE matriculacion_alumno (

codigo_asignatura integer,

dni_alumno varchar(9),

nota float,

fecha_matriculacion date,

PRIMARY KEY(codigo_asignatura, dni_alumno),

FOREIGN KEY (codigo_asignatura) REFERENCES asignaturas(codigo),

FOREIGN KEY (dni_alumno) REFERENCES alumnos(dni) ON DELETE CASCADE

);

Si queremos modificar el modelo de la tabla creada previamente

Modificar una tabla, añadiendo una columna

mysql> ALTER TABLE alumnos ADD nacimiento date;

Eliminar una tabla

mysql> DROP TABLE alumnos;

TRUNCATE es una función especial que vacía de contenido una tabla. Realmente lo que hace es borrar la tabla y volverla a crear, de ahí que sea considerada una función dentro del DDL.

Truncar una tabla

mysql> TRUNCATE TABLE alumnos;

Para poder gestionar una tabla debemos saber cómo es y cómo está creada, ya que dependiendo de ello podremos realizar modificaciones sobre la misma.

Para ver las columnas que tiene una tabla podemos hacerlo de dos maneras:

Ver columnas de una tabla

mysql> SHOW COLUMNS FROM alumnos;

mysql> DESCRIBE alumnos;

Podemos obtener más datos, como los privilegios que tenemos con el usuario que nos hemos conectado sobre cada columna haciendo:

Ver permisos sobre columnas

mysql> SHOW FULL COLUMNS FROM alumnos;

Y si queremos ver cómo se ha creado la tabla:

Ver cómo se ha creado una tabla

mysql> SHOW CREATE TABLE alumnos;

6.3 Lenguaje de manipulación de datos: DML

El DML (Data Manipulation Language) nos permite consultar, manipular, insertar o eliminar los datos.

6.3.1 Realizar consultas

A la hora de realizar consultas, podemos crear distintas y de distinto tipo.

Consultar todos los registros de una tabla

mysql> SELECT * FROM alumnos;

Consultar ciertos campos de una tabla

mysql> SELECT dni, nombre, nacimiento FROM alumnos;

También podemos realizar consultas condicionales:

Realizar consulta condicional con una fecha

mysql> SELECT dni, nombre, nacimiento

FROM alumnos

WHERE nacimiento > '1982-01-01';

Realizar consulta condicional y ordenada

mysql> SELECT dni, nombre, nacimiento

FROM alumnos

WHERE nacimiento > '1970-01-01'

ORDER BY dni ASC;

La complejidad de las consultas dependen de nuestro modelo de datos así como de los datos que queremos obtener:

Consulta relacionando varias tablas

mysql> SELECT a.dni, a.nombre, a.apellido, asig.nombre, ma.nota

FROM alumnos as a, asignaturas as asig, matriculacion_alumno as ma

WHERE a.dni = ma.dni_alumno

AND asig.codigo = ma.codigo_asignatura

AND ma.nota < 5

ORDER BY a.dni ;

6.3.2 Inserción y modificación de datos

No sólo podemos realizar consultas de obtención de datos, sino que también podremos insertarlos, modificarlos o borrarlos.

Insertar datos en una tabla

mysql> INSERT INTO alumnos VALUES ('12345678Z', 'Alumno', 'Uno', '555123456','1980-01-01');

En caso de que sólo queramos insertar parte de los datos, podremos realizar:

Insertar sólo datos obligatorios en una tabla

mysql> INSERT INTO alumnos(dni,nombre) VALUES ('87654321A', 'Alumno2');

A la hora de actualizar datos, deberemos elegir qué campos queremos elegir

Actualizar ciertos campos en una tabla

mysql> UPDATE alumnos SET nacimiento = '1984-01-01' WHERE dni = '87654321A';

Y a la hora de eliminar datos, podremos hacerlo de manera condicional.

Eliminar ciertos registros de una tabla

mysql> DELETE FROM alumnos where dni = '87654321A';

6.4 Control de transacciones

Como ya se ha visto previamente, los SGBDs deben de seguir el modelo ACID de transacciones para asegurar que los datos mantienen la integridad de los datos y el aislamiento a la hora de realizar transacciones sobre los mismos datos.

Por ello, SQL permite realizar inicios de transacciones BEGIN) para posteriormente aplicar todos los cambios que se han realizado (COMMIT) o cancelarlos (ROLLBACK).

MySQL utiliza el método autocommit por defecto

Empezar una transacción

Nos sirve a la hora de realizar grandes modificaciones en la base de datos. Se puede realizar de las dos maneras siguientes:

Hacer una transacción (se puede hacer de 2 maneras)

mysql> BEGIN;

-- alternativa:

mysql> START TRANSACTION;

A partir de aquí cualquier acción que se realice no será aplicada (aunque sí lo podremos ver en la sesión actual) hasta que no se termine la transacción.

Aplicar y terminar la transacción

Para aplicar los cambios realizados a lo largo de la transacción, y para que los cambios sean persistentes, se deberá ejecutar:

Aplicar y terminar la transacción

mysql> COMMIT;

Tras esto, los cambios serán realizados y el resto de conexiones verán las modificaciones realizadas.

Cancelar transacción

En caso de que queramos cancelar las ejecuciones realizadas desde el inicio de la transacción, deberemos ejecutar:

Cancelar la transacción y todo lo realizado en ella

mysql> ROLLBACK;

Modificar comportamiento autocommit

El comportamiento por defecto de MySQL es que cualquier ejecución es una transacción, por lo que realizará el bloqueo de datos necesario o realizará la modificación de los datos. Si queremos cambiar este comportamiento para la sesión actual deberemos hacer:

Modifiar el comportamiento del autocommit

mysql> SET autocommit = OFF;

Gestión de usuarios

7 Gestión de usuarios

MySQL permite la creación de cuentas que habilitan la conexión de clientes de usuario al servidor y el acceso a los datos que gestiona el servidor (ya sea conexiones mediante CLI o aplicación).

La función principal del sistema de privilegios de MySQL es la de permitir la conexión que se conecta desde un equipo remoto y asociarla a un usuario con permisos sobre una base de datos para que pueda ejecutar funciones tal que SELECT, INSERT, UPDATE y DELETE. Un usuario también puede recibir permisos para realizar funciones privilegiadas.

Para controlar qué usuarios pueden conectarse, cada cuenta tendrá asignada un credencial de autenticación, como puede ser la contraseña. Las funciones sobre usuarios más habituales son: CREATE USER, GRANT y REVOKE.

El sistema de privilegios de MySQL asegura que los usuarios sólo pueden realizar las funciones que le son permitidas. Cuando un usuario se conecta al servidor MySQL su identidad es determinada por:

El equipo remoto desde el que se realiza la conexión: no es lo mismo que la conexión se realice desde la IP local, desde una IP 192.168.1.100 o desde 172.26.20.2

El nombre de usuario que se haya especificado.

Cuando se realice la conexión, el sistema otorga privilegios de acuerdo con la identidad del usuario y desde donde se recibe la conexión, permitiendo, o no, ciertas acciones sobre los datos.

7.1 Cuentas de usuarios y contraseñas

MySQL guarda las cuentas de usuario y sus contraseñas en la tabla user de la base de datos del sistema mysql. Como ya se ha indicado, una cuenta se define con el nombre de usuario y el host desde el que se establece la conexión. MySQL soporta distintos tipos de autenticación, no sólo contraseñas. La autenticación está gestionado por el plugin de autenticación de cuentas. Algunos tipos de autenticación que soporta MySQL 8:

- Contraseña

- Autenticación PAM (para Linux y Mac)

- LDAP

- Autenticación mediante socket (conexiones locales)

7.1.1 Creación de usuarios

Como ya se ha explicado, es importante entender que para que la conexión sea correcta no sólo importa el usuario de conexión, sino desde donde se realiza la misma. Es por ello que a la hora de crear un usuario tendremos que conocer este dato ya que es importante. Aparte, tendremos que poner una contraseña, si es necesario, que sea lo suficientemente segura como para que pase el paso realizado en la securización inicial. A la hora de crear usuarios hay muchas opciones.

Crear usuario local (SOCKET)

El usuario solo se va a conectar desde la propia máquina, conexión mediante socket:

Crear usuario que sólo se conecte por socket

mysql> CREATE USER 'mikeldi'@'localhost' IDENTIFIED WITH auth_socket;

Crear usuario local (conexión TCP)

La conexión va a ser local, pero se va a hacer uso del protocolo TCP, y en este caso es necesario introducir contraseña.

Crear usuario que sólo se conecte por TCP

mysql> CREATE USER 'usuario'@'localhost' IDENTIFIED BY 'password';

Crear usuario para conexión remota (TCP)

Si queremos que la conexión se pueda realizar desde una IP concreta:

Crear usuario que sólo pueda conectarse desde una IP

mysql> CREATE USER 'usuario2'@'192.168.122.1' IDENTIFIED BY 'password';

Si queremos que un usuario se pueda conectar desde cualquier IP:

Crear usuario que pueda conectarse desde cualquier IP

mysql> CREATE USER 'usuario3'@'%' IDENTIFIED BY 'password';

Crear usuario y que se le expire la contraseña

El usuario se crea con la contraseña del comando, pero cuando se loguee no podrá realizar nada hasta que cambie la contraseña (ver más adelante):

Crear usuario y que la contraseña expire

mysql> CREATE USER 'usuario4'@'%' IDENTIFIED BY 'password' PASSWORD EXPIRE;

Si queremos que la contraseña le expire en 10 días:

Crear usuario y que la contraseña expire

mysql> CREATE USER 'usuario5'@'%' IDENTIFIED BY 'password' PASSWORD EXPIRE INTERVAL 10 DAY;

7.1.2 Conexión de usuarios

Dependiendo de cómo se realice la conexión (por socket o TCP) el método de conexión será de una manera u otra.

Conexión por socket

Para poder conectarnos por socket, tenemos que tener acceso a él, siendo lo habitual conexión local. El usuario utilizado será el usuario del sistema:

Conexión por socket desde el usuario root

root@server1:~# mysql

Conexión remota

Suponiendo que el servidor MySQL está en la IP 192.168.122.145, la conexión deberá realizarse de la siguiente manera (hay que tener en cuenta el origen de la conexión también).

Conexión al servidor 192.168.122.145

ruben@server1:~$ mysql -u usuario2 -h 192.168.122.145 -p

Conocer el usuario de conexión:

Para asegurarnos con qué usuario nos hemos conectado:

Ver el usuario con el que nos hemos conectado

mysql> select user();

+------------------------+

| user() |

+------------------------+

| usuario2@192.168.122.1 |

+------------------------+

1 row in set (0.00 sec)

Cambiar la contraseña del propio usuario:

Si nos conectamos con un usuario que tiene la opción “PASSWORD EXPIRE” activada, para cambiar la contraseña deberemos loguearnos con ese usuario y realizar:

Cambiar la contraseña

mysql> set password='password';

7.1.3 Ver los usuarios que existen

Los usuarios se guardan dentro de la tabla user en la base de datos mysql. Para poder ver los usuarios creados:

Mirar tabla de usuarios

mysql> use mysql;

mysql> select * from user;

Para poder ver de otra manera los datos de los usuarios:

Mirar la tabla en modo vertical

mysql> select * from user\G

*************************** 1. row ***************************

Host: %

User: usuario2

Select_priv: N

Insert_priv: N

Update_priv: N

Delete_priv: N

Create_priv: N

...

max_updates: 0

max_connections: 0

max_user_connections: 0

plugin: caching_sha2_password

authentication_string: $A$005$lq-g:Ps27zVBGU8SnP7eg7WK3qnQ6R

password_expired: N

password_last_changed: 2020-09-05 18:22:11

...

7.1.4 Limitando los recursos de las cuentas

Las cuentas de usuarios pueden tener recursos limitados. Estos límites se pueden poner al crear un usuario:

Limitar el número de queries por hora.

mysql> CREATE USER 'lim1'@'localhost' IDENTIFIED BY 'frank' WITH MAX_QUERIES_PER_HOUR 20;

O se pueden añadir los límites sobre cuentas ya creadas:

Limitar el número de conexiones a 2 para el usuario

mysql> ALTER USER 'usuario'@'localhost' WITH MAX_USER_CONNECTIONS 2;

Limitar el número de conexiones a 20 por hora

mysql> ALTER USER 'usuario'@'localhost' WITH MAX_CONNECTIONS_PER_HOUR 20;

Limitar el número de queries a 500 por hora

mysql> ALTER USER 'usuario'@'localhost' WITH MAX_QUERIES_PER_HOUR 500;

Limitar el número de updates a 500 por hora

mysql> ALTER USER 'usuario'@'localhost' WITH MAX_UPDATES_PER_HOUR 500;

7.1.5 Borrado de usuarios

Al borrar usuarios la sentencia “DROP USER” borra una o más cuentas y sus privilegios.

Al hacer un “DROP USER”, si el usuario tiene establecida una conexión no se borrará el usuario podrá seguir haciendo peticiones. Cuando la conexión se cierre será cuando se borre el usuario, y su siguiente conexión no se podrá establecer.

Al borrar un usuario no se pierden los objetos que el usuario haya creado.

Borrar usuario

mysql> DROP USER 'usuario'@'localhost';

7.1.6 Bloqueo de usuarios

Como borrar un usuario no se puede deshacer, podría ser recomendable bloquear antes la cuenta hasta asegurar al 100% que el usuario que vamos a borrar no se va a volver a necesitar:

Bloquear un usuario

mysql> ALTER USER 'usuario'@'localhost' ACCOUNT LOCK;

7.1.7 Renombrar un usuario

Podemos renombrar un usuario, cambiando el usuario y el origen de la conexión. Si la cuenta ya existe obtendremos un error.

Renombrar un usuario

mysql> RENAME USER 'usuario'@'localhost' TO 'ruben'@'192.168.122.1';

7.1.8 Cambiar contraseña al usuario

Es interesante realizar modificaciones en las contraseñas de usuarios cada cierto tiempo.

Cambiar contraseña de un usuario

mysql> SET PASSWORD FOR 'ruben'@'192.168.122.1' = 'password2';

7.2 Privilegios de usuarios

Hasta ahora lo que hemos permitido es que un usuario pueda realizar una conexión, pero un usuario conectado no puede realizar ninguna acción sobre tablas ya que no tiene permisos sobre nada. La sentencia GRANT da permisos a las cuentas de usuarios y establece qué operaciones puede realizar.

En la documentación oficial podemos ver todo los privilegios que pueden tener los usuarios.

En la siguiente tabla se muestran sólo unos pocos de los privilegios, y siempre conviene ir a la documentación oficial teniendo en cuenta la versión de MySQL que estamos utilizando, para confirmar los privilegios que existen:

| Privilege | Grant Table Column | Context |

|---|---|---|

| ALL PRIVILEGES | Synonym for “all privileges” | Server administration |

| ALTER | Alter_priv | Tables |

| CREATE | Create_priv | Databases, tables, or indexes |

| CREATE USER | Create_user_priv | Server administration |

| CREATE VIEW | Create_view_priv | Views |

| DELETE | Delete_priv | Tables |

| DROP | Drop_priv | Databases, tables, or views |

| DROP ROLE | Drop_role_priv | Server administration |

| GRANT OPTION | Grant_priv | Databases, tables, or stored routines |

| INDEX | Index_priv | Tables |

| INSERT | Insert_priv | Tables or columns |

| SELECT | Select_priv | Tables or columns |

| … | … | … |

Tal como se puede ver, existen multitud de privilegios que se les puede otorgar a los usuarios. Vamos a ver cómo añadir y modificar los permisos de los usuarios.

7.2.1 Añadir permisos a usuarios

Existen muchos tipos de privilegios que podemos otorgar a los usuarios, y veremos una pequeña muestra de ellos.

Dar todos los permisos a todo MySQL

Se le otorgan todos los permisos sobre todo

mysql> GRANT ALL ON *.* TO 'nuevo_admin'@'192.168.1.10';

Dar todos los permisos sobre tablas

Se le otorgan todos los permisos sobre todas las tablas de la base de datos db1

mysql> GRANT ALL ON db1.* TO 'usuario'@'localhost';

Dar permisos de SELECT

Es decir, el usuario podrá realizar consultas SELECT sobre la tabla alumnos de la base de datos db1.

Sólo realizar consultas SELECT sobre la tabla alumnos de la base de datos db1.

mysql> GRANT SELECT ON db1.alumnos TO 'usuario2'@'%';

Dar permisos de INSERT

El usuario podrá realizar inserciones en la tabla asignaturas.

mysql> GRANT INSERT ON db1.asignaturas TO 'usuario2'@'%';

Delegar permisos (GRANT)

Se puede dar permisos a un usuario para que pueda delegar permisos a otro usuario, pero sólo podrá dar los permisos que él mismo tenga.

Para que el usuario pueda delegar permisos

mysql> GRANT ALL ON prueba.* TO 'usuario3'@'%' WITH GRANT OPTION;

7.2.2 Activar nuevos permisos

Los nuevos permisos no son aplicados hasta que no se ejecuta la siguiente sentencia:

Para aplicar las modificaciones de permisos

mysql> FLUSH PRIVILEGES;

7.2.3 Eliminar permisos a usuarios

Se pueden eliminar, o revocar, permisos a usuarios:

Revocar permisos de INSERT al usuario:

mysql> REVOKE INSERT ON prueba.asignaturas FROM 'usuario2'@'%';

7.2.4 Visualizar permisos usuarios

Ver los permisos de nuestro usuario

Ver los permisos del usuario actual

mysql> SHOW GRANTS;

Ver los permisos de usuario2

mysql> SHOW GRANTS FOR 'usuario2'@'%';

Copias de seguridad

8 Gestión de backups en MySQL

Con la instalación del servidor de MySQL se realiza la instalación de ciertas aplicaciones de administración del servidor, entre las que se encuentran el programa para la realización de backups: mysqldump.

Existen distintas maneras de realizar un backup en MySQL, entre las que se pueden destacar:

Backup completo: Backup de todas las bases de datos que se encuentran instaladas en el servidor, incluyendo las del sistema.

Backup de base de datos: Se realizaría el backup de la base de datos en concreto elegida.

Backup de tabla: En este caso realizaríamos el backup de las tablas de una base de datos que nos interese.

Una vez elegido el tipo de backup que vamos a realizar deberemos elegir la herramienta que usaremos para llevar a cabo la estrategia planteada:

mysqldump: Script incluido en las herramientas instaladas junto con MySQL. Por defecto realiza backups en formato de texto plano que podemos guardar en un fichero. Nos permite realizar backup completos, de ciertas bases de datos o de tablas concretas.

Percona XtraBackup: Herramienta creada por la empresa Percona que nos permite realizar copias de seguridad sin realizar bloqueos en la base de datos.

Otras herramientas: Existen multitud de herramientas para realizar backups para MySQL. Antes de hacer uso de ellas, deberemos asegurarnos que cumplen con nuestras necesidades.

Hay que tener en cuenta que los backups de los datos de las bases de datos no realiza un backup de los ficheros de configuración que se sitúan en /etc/mysql por lo que el backup de esta configuración debe realizarse por algún otro método, ya que la configuración del servidor también es muy importante.

8.1 Herramienta propia: mysqldump

Vamos a hacer uso de la herramienta propia que se instala junto a MySQL, que es mysqldump. Este programa es muy sencillo de utilizar ya que los parámetros que reciben son similares al propio CLI.

Por otro lado, el fichero generado con este programa es un fichero de texto que puede ser visualizado con cualquier editor en caso de necesidad, y fácilmente importado en cualquier otro servidor.

Ayuda del comando mysqldump

root@ubuntu:~# mysqldump

Usage: mysqldump [OPTIONS] database [tables]

OR mysqldump [OPTIONS] --databases [OPTIONS] DB1 [DB2 DB3...]

OR mysqldump [OPTIONS] --all-databases [OPTIONS]

For more options, use mysqldump --help

Tal como podemos ver, si ejecutamos el script, nos da una ligera idea de cómo podemos realizar un backup con con el mismo. En caso de que el backup sea de una máquina remota para traerlo a local, podremos hacer uso de varios parámetros, por ejemplo mysqldump -u USER -h IP_REMOTA -p, como cuando usamos el CLI.

8.1.1 Backup completo

Un backup completo de MySQL hará que se guarde toda la información de las bases de datos internas del sistema, en las que se incluyen los usuarios y sus privilegios.

Este sistema es el método más sencillo si queremos realizar después una restauración completa en un nuevo servidor.

Hacer backup completo

root@ubuntu:~# mysqldump --all-databases > backup-completo.sql

De esta manera, le hemos indicado al script mysqldump que realice un backup de todas las bases de datos y el contenido obtenido lo vuelque al fichero backup-completo.sql. Este fichero generado es un fichero de texto que contendrá las bases de datos del sistema, usuarios, privilegios…

8.1.2 Backup de base de datos

Podemos realizar el backup únicamente de una, o varias, bases de datos que nos pueda interesar. Para poder realizar el backup de la base de datos que nos interese se hace uso del parámetro “–databases” seguido del nombre de las bases de datos, o en su forma abreviada “-B”. Los dos siguientes comandos son iguales:

Hacer backup de sólo las bases de datos DB1 y DB2

root@ubuntu:~# mysqldump --databases DB1 DB2 > backup-db1-db2.sql

root@ubuntu:~# mysqldump -B DB1 DB2 > backup2-db1-db2.sql

Al crear el backup de una, o varias, base de datos de la anterior manera, en el fichero de backup nos aparecerá algo tal que:

Información interna del backup

CREATE DATABASE /*!32312 IF NOT EXISTS*/ `DB1`;

USE `DB1`;

De esta manera, lo que nos está indicando el backup es que a la hora de restaurar, en caso de que no exista DB1 se creará previamente. Posteriormente realizará el borrado de las tablas y las volverá a crear para realizar el insert de datos.

También podremos obviar el argumento, por lo que en caso de introducir un único parámetro, lo tomará com la base de datos de la que realizar copia de seguridad.

Hacer backup de una única base de datos

root@ubuntu:~# mysqldump DB1 > backup-DB1.sql

Al hacer el backup de esta manera, en el fichero no aparecerá la creación de la base de datos, por lo que a la hora de realizar la importación tendremos que hacerlo sobre una base de datos ya creada.

8.1.3 Backup de una tabla

Puede darse casos que nos interese realizar backups de una única tabla, o poder hacer backups de una tabla de manera más seguida, y para ello podremos ejecutar:

De esta manera hacemos backup de la tabla “asignaturas” de la base de datos DB1.

8.2 Importar un backup

Tal como hemos visto existen distintas maneras de realizar un backup, por lo que dependiendo de cómo es el backup que queremos importar, se hará de una manera u otra.

Hay que entender que la importación de un backup puede suponer la pérdida de datos de las bases de datos del servidor donde importamos el backup, por lo que hay que asegurarse muy bien qué queremos restaurar y dónde lo vamos a restaurar para no haya pérdida de datos donde no queremos.

Importar datos de un backup puede suponer la pérdida de datos en el servidor donde se realiza la importación.

También es lógico pensar que dependiendo de la herramienta utilizada para realizar el backup la importación del mismo no tiene por qué ser igual, ya que distintas herramientas pueden dar lugar a distintos tipos de ficheros.

Antes de restaurar un backup confirma cómo se hizo y cómo haces la importación.

8.2.1 Importar backups de mysqldump

Como se ha comentado previamente, mysqldump se instala junto con el servidor, y debido a que es una herramienta sencilla de usar, su importación también es sencilla. Para realizar la importación de este tipo de backups haremos uso del propio CLI mysql.

8.2.1.1 Importar un backup completo

Al importar un backup completo haremos la sustitución de todas las tablas internas de MySQL por los datos que haya en el backup. Por lo tanto, nos tendremos que asegurar muy bien de que el servidor donde realizaremos la importación de datos es un servidor sin datos importantes.

Para importar un backup completo haremos:

Importar un backup completo

root@ubuntu:~# mysql < backup-completo.sql

Con esto estaremos indicando que el contenido del fichero de backup se importe sobre la conexión que hemos realizado, en este caso en local.

8.2.1.2 Importar un backup de una base de datos

Tal como hemos visto antes, a la hora de crear el backup de una, o varias, base de datos se puede realizar añadiendo el parámetro “–databases”, “-B” o sin especificar nada, sólo la base de datos. Dependiendo de cómo se haya creado el backup, la importación variará:

Si el backup se ha realizado con “–databases” o “-B” en el propio backup aparece:

“Create database” en el propio fichero de backup

CREATE DATABASE /*!32312 IF NOT EXISTS*/ `DB1`;y para realizar la importación:

Importar un backup completo

root@ubuntu:~# mysql < backup-DB1.sql

Si no hemos especificado más que el nombre de la base de datos, en el backup no aparece la creación o uso de la base de datos, por lo que tendremos que indicarlo en la importación, y la base de datos “restaurado” debe existir previamente.

Importar un backup completo en una base de datos llamada “restaurado”

root@ubuntu:~# mysql restaurado < backup-DB1.sql

8.2.1.3 Importar un backup de una tabla

Por último, si queremos importar un backup donde sólo existen tablas, a la hora de importar deberemos indicar en qué base datos queremos realizar la importación, ya que en el backup no aparece dicha información. Por ejemplo:

Importar un backup de una tabla en la base de datos “restauracion”

root@ubuntu:~# mysql restauracion < backup-db1-asignaturas.sql

De esta manera estamos indicando al CLI que el contenido del fichero de backup se importe sobre la base de datos restauración. Lógicamente esta base de datos debe estar creada previamente.

Monitorización

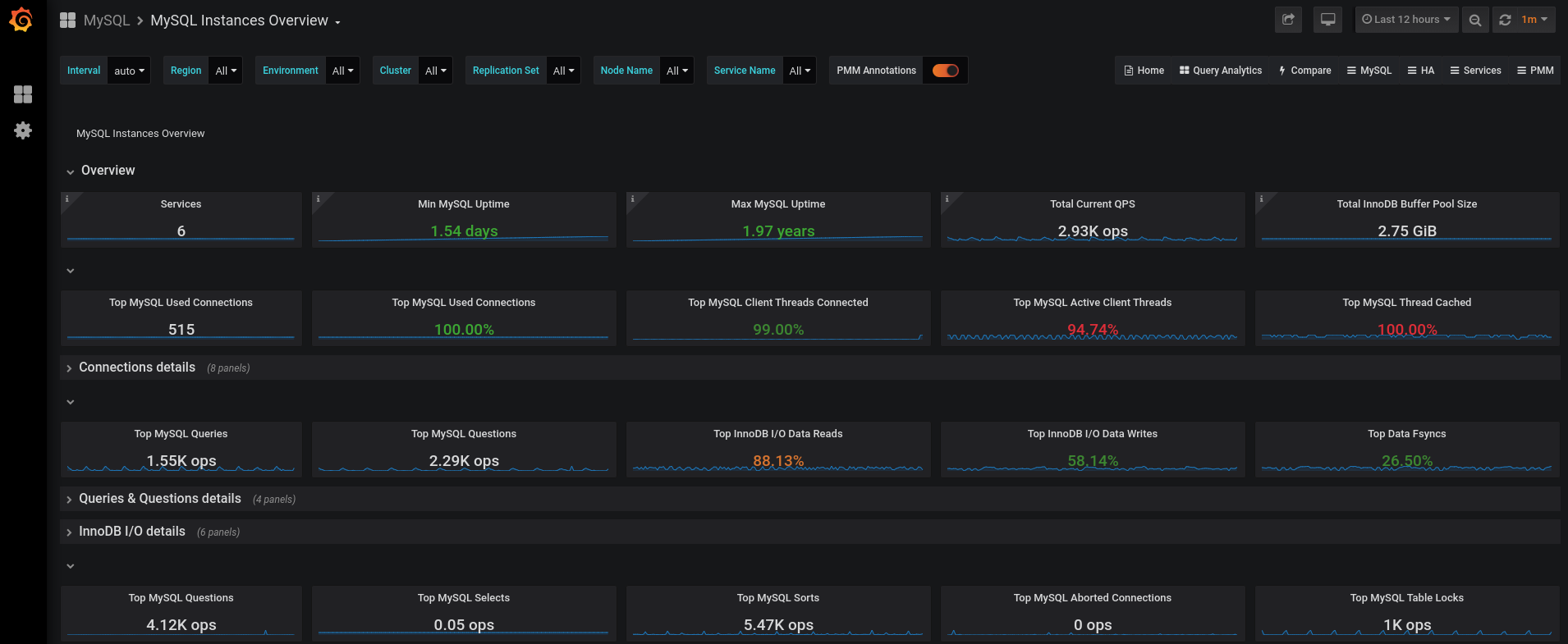

9 Monitorización de SGBDs

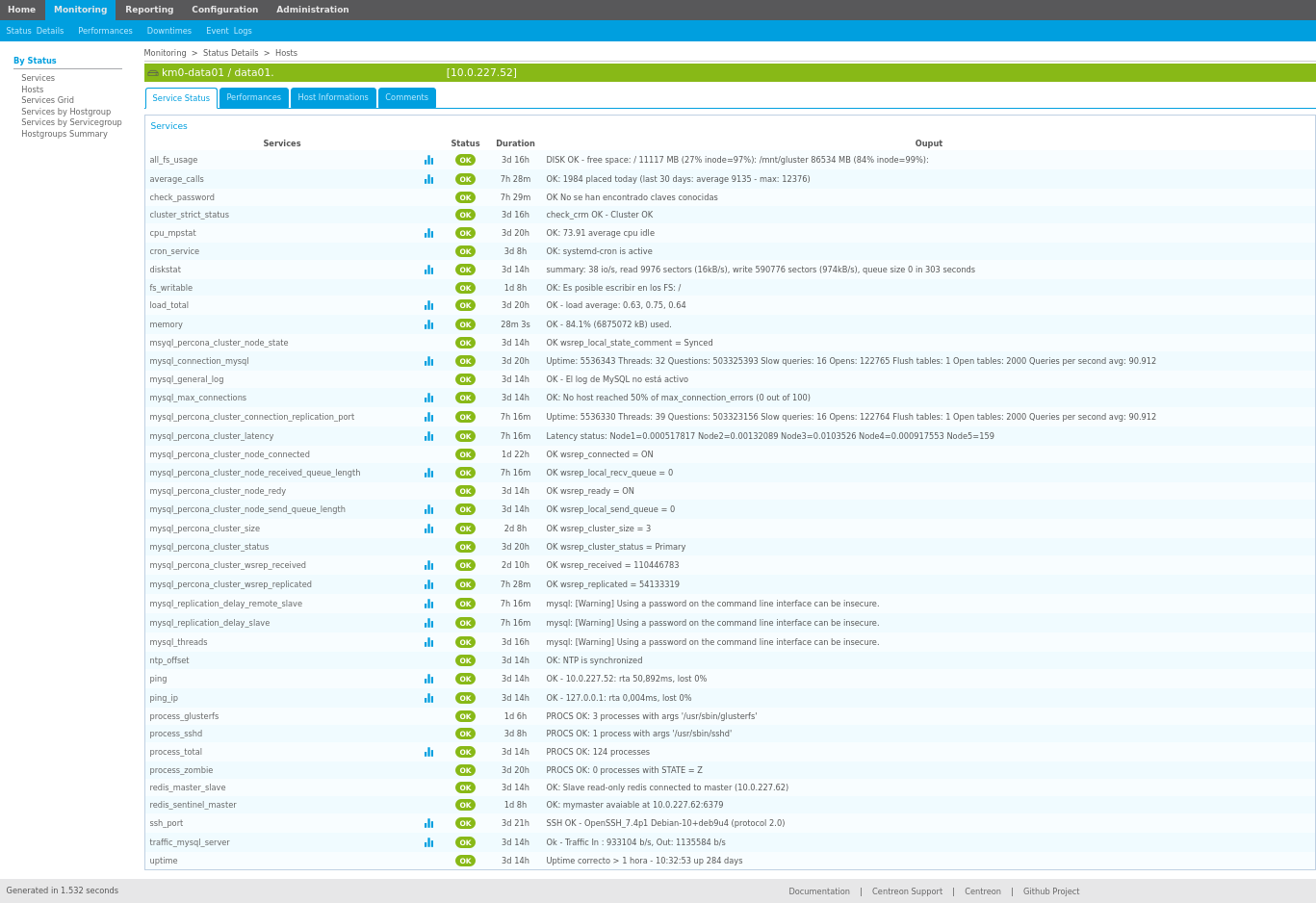

En el caso que nos ocupa, el de los Sistemas Gestores de Bases de Datos, aparte de la monitorización básica comentada en el anexo, necesitaremos monitorizar el estado del SGBD propiamente dicho. Para ello, de nuevo, se crearía una plantilla específica para cada SGBD que podamos tener en nuestra infraestructura. No será lo mismo monitorizar un servidor basado en MySQL o un Oracle, aunque muchos checks a comprobar deban ser lo mismo, pero la manera en la que se realizará la comprobación en el servidor será distinta.

Entre las comprobaciones que podemos realizar en un SGBD nos podemos encontrar con:

Servicio SGBD arrancado

Cantidad de RAM utilizada por el SGBD

Número de conexiones a las bases de datos

Número de hilos en ejecución del SGBD

Número de queries en ejecución

Número de tablas en memoria

Número de tablas bloqueadas

…

9.1 Monitorizar MySQL

Todo lo expuesto en el anexo es referente a los sistemas de monitorización en general, y es similar en todos ellos. Tal como se ha comentado previamente, cuando un servidor cuenta con un servicio éste debe ser monitorizado, y dependiendo del servicio a monitorizar se realizará una serie de comprobaciones u otras.

A la hora de monitorizar un sistema gestor de bases de datos deberíamos tener en cuenta al menos las siguientes comprobaciones, y en el caso de MySQL:

Número de conexiones actuales (usuarios/conexiones tiene el servicio)

Tiempo del servicio activo (uptime)

Número de hilos en ejecución

Tamaño de memoria utilizado

Tamaño de memoria caché utilizado

Número de tablas en memoria

Número de slow queries

Número de conexiones abortadas

Número de queries totales

En servidores en alta disponibilidad, deberíamos comprobar, en caso de un clúster:

Número de nodos en el clúster

Estado general del clúster

Latencia entre los nodos del clúster

Si el nodo está conectado al clúster

- Puede pasar que un nodo “se salga” del clúster (o lo saquemos) para realizar mantenimiento

Si el servidor está dentro de una infraestructura de Primario → Réplica:

Estado de la replicación

Retraso de la replicación

Tamaño del binlog

Las comprobaciones expuestas son un mero ejemplo, y existen muchas más que podemos realizar a nuestros sistemas. Para poder realizar este tipo de monitorización podemos hacer uso de scripts propios (ya que muchas de las comprobaciones son consultas a variables de estado de MySQL), scripts creados por otras personas o scripts de monitorización hechos de manera exclusiva para MySQL.

9.1.1 Scripts propios

Para realizar gran parte de los checks expuestos previamente se puede hacer uso de scripts propios, ya que pueden realizar consultas de las variables de estado para comprobar y determinar si el estado es correcto.

Un ejemplo de script creado ad hoc para nuestro sistema podría ser:

Script propio para monitorizar

#!/bin/bash