Enpresa kudeaketako sistemak

1 Sarrera

Informatika zientziaren arlo bat da, hainbat diziplina teoriko (adibidez, algoritmoen sorrera, konputazioaren teoria, informazioaren teoria, …) eta diziplina praktiko (hardwarearen diseinua, softwarearen inplementazioa) biltzen dituena.

Programak (edo softwarea) sortzerakoan, mota desberdinetakoak identifika ditzakegu:

Sistema-softwarea: Sistemaren parte diren programak edo aplikazioak dira, sistema hobetzen, kudeatzen… laguntzen digutenak. Adibidez: monitorizazio-aplikazioak, logen auditoretza-aplikazioak, driver-ak, …

Garapen-softwarea: Kasu honetan, beste aplikazio batzuk sortzen lagunduko diguten aplikazioak izango dira. Adibidez: funtzio-liburutegiak, konpilatzaileak, debugger-ak, IDEak…

Erabiltzaile-aplikazioak: Azken erabiltzaileek egunerokoan erabiliko dituzten aplikazioak dira. Honela bereiz ditzakegu:

Aplikazio orokorrak: Edozein erabiltzaile motak edozein unetan erabiliko dituenak dira. Helburu zehatz batekin sortuak dira, baina ez da beharrezkoa ezagutza handirik izatea erabiltzeko. Adibidez: web-nabigatzaileak, posta-bezeroak, bulegotika-aplikazio sinpleak, kalkulagailua, egutegia, …

Erabilera espezifikoko aplikazioak: Kasu honetan, erabiltzaile zehatz baterako sortutako aplikazioak dira, erabilera oso zehatzarekin eta normalean ezagutza jakin batzuk behar izaten dira erabiltzeko.

Ez dira zertan oso konplexuak izan, baina duten erabilgarritasuna edo egiten dutena garrantzitsua izan daiteke eta prozesu konplexuak izan ditzakete. Adibidez: CAD aplikazioak, birtualizazio-sistemak, aplikazio zientifikoak (R, JupyterLab), enpresa-aplikazioak, …

Ikasgai honetan enpresa-kudeaketarako software espezializatu mota desberdinak ikusiko ditugu, hala nola ERP eta CRM sistemak, informazio-sistemak bezala sailka daitezkeenak.

2 Informazio-sistemak

Orokorrean, informazio-sistema bat da erakunde baten funtsezko prozesuetan erabiltzeko informazioa kudeatzen, biltzen, berreskuratzen, prozesatzen, biltegiratzen eta banatzen laguntzen duen sistema.

Normalean, informazio-sistema hauek erabiltzeko errazak izaten dira, malgutasun maila bat dute (enpresetara egokitu daitezke), eta informazioa azkar eta erraz gorde eta berreskuratzeko aukera ematen dute.

Horrela, lortutako informazioa baliotsuagoa izango da erakundearentzat, “irudi” zabalagoa izango duelako eta informazio gehiago erlazionatu ahal izango duelako mota honetako softwarea erabili ezean baino.

2.1 Osagaiak

Informazio-sistema batek oinarrizko osagai hauek izan behar ditu, eta elkarrekin modu egokian elkarreragin behar dute funtzionamendu orokor ona izateko:

Hardwarea, datuak prozesatzeko eta biltegiratzeko erabiltzen den ekipo fisikoa.

Softwarea eta informazioa eraldatu eta ateratzeko erabiltzen diren prozedurak.

Enpresaren jarduerak ordezkatzen dituzten datuak.

Baliabideak ordenagailuen eta gailuen artean partekatzeko aukera ematen duen sarea.

Sistema garatzen, mantentzen eta erabiltzen duten pertsonak.

Azken puntua oso garrantzitsua da, izan ere, ez du ezertarako balio tresnarik onena, hardware onenean izateak, erabiltzaileek ez badituzte beharrezko ezagutzak.

Informazio-sistemak erabiltzen dituzten pertsonek beharrezko ezagutzak izan behar dituzte erabilera egokia bermatzeko.

Horregatik, informazio-sistema erabiliko duten pertsonek prestakuntza jaso behar dute eta/edo eskuliburuak izan behar dituzte erabilera egokirako, eta haien iritziak kontuan hartu behar dira enpresaren barne-prozesuak hobetzeko.

2.2 Datuak vs informazioa

Datuak erakundean jasotako gertakariak islatzen dituzte eta oraindik prozesatu gabe daude (balioak edo neurketen emaitzak islatzen dituzte). Datu horiek gai zehatz bati buruzko gertakariak edo zenbakiak izango dira, eta lehen begiratuan ez dute zertan esanahi argirik izan behar.

Aldiz, informazioa lortzen da datu horiek behar bezala prozesatu, agregatu eta/edo aurkeztu ondoren, erabilgarriak izan daitezen eta horrela bestela lortu ezin litzatekeen balioa lortzeko.

Datuen eta informazioaren arteko adibiderik argiena edozein ikerketa zientifikotan ikus daiteke: datuak lortu ondoren, metodo zientifikoaren bidez ondorio batera iristen da eta horrela informazioa lortzen da.

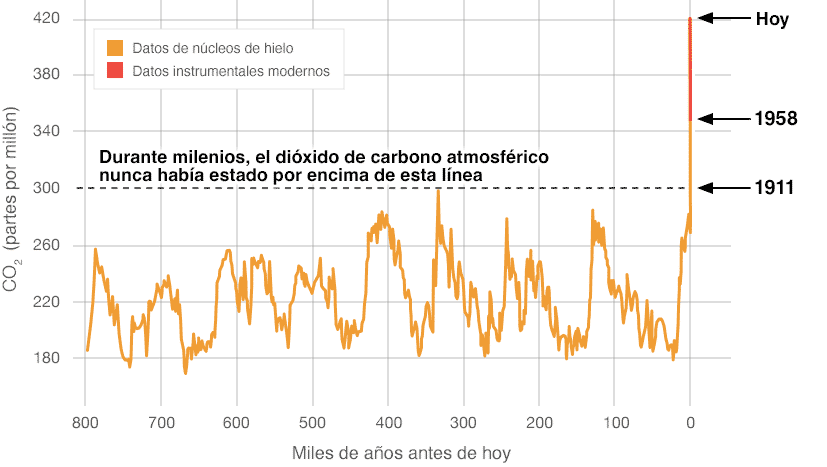

Adibidez, karbono dioxidoaren (CO2) neurketak atmosferan, datuak lortzen dira eta ondorengo irudia informazioa da:

2.3 Helburua

Informazio-sistemen helburua, eta kasu honetan, enpresa-kudeaketarako erabiltzen direnen helburua, ekintzak azkarrago eta eraginkorrago egitea da, eta, beraz, enpresarentzat ekonomikoki ere onuragarriagoa izan beharko luke.

Informazioaren eta komunikazioaren teknologiak enpresetan erabiltzea funtsezko elementu bihurtu da, ardatz eta abantaila lehiakorraren iturri gisa.

Gaur egun, informatika erabiltzen ez duen enpresa batek bere estrategia baldintzatzen du, eta oso litekeena da negozio-aukerak galtzea, bai eta bere produktuak eta zerbitzuak garatzeko aukera ere.

Horregatik, informatika eta enpresa-kudeaketarako software espezializatua erabiltzeak enpresei lagundu diezaieke:

Abantaila lehiakorrak lortzen.

Enpresaren barne-eraginkortasuna hobetzen: kostuak murriztu, produktibitatea hobetu, informazioaren antolaketa hobetu, …

Erabakiak hartzea erraztu eta hobetu, informazioa biltzearen bidez.

Negozio-estrategia berriak garatzeko.

2.4 Baldintzak

Informazioa erabilgarria izan dadin erakunde batean erabakiak hartzeko, hainbat baldintza bete behar ditu:

Zehaztasuna: zehatza eta akatsik gabea izan behar du.

Ulermena: erabiltzailearentzat ulergarria izan behar du.

Osotasuna: garrantzitsuak izan daitezkeen gertakari guztiak jaso behar ditu.

Ekonomikotasuna: informazioa lortzeko kostua txikiagoa izan behar du lortutako onurak baino.

Konfiantza: erabilitako datuen eta informazio-iturriaren kalitatea bermatu behar du.

Garrantzia: erabakiak hartzeko erabilgarria izan behar du.

Xehetasun maila: aurkezpen eta formatu egokiarekin eman behar da, erabilerraza eta maneiagarria izan dadin.

Une egokian: informazioa dagokion pertsonari eta une egokian eman behar zaio.

Egiaztagarritasuna: informazioa une oro egiaztatu eta konproba daiteke.

Kontuan izan: informazio gehiegi izateak ere kalte egin dezake.

2.5 Jarduerak

Informazio-sistema bat erabiltzean, bertan egin daitezkeen jarduerak honela laburbil daitezke:

Bilketa: Datu gordinen bilketa da. Datu horiek erakundearen barrukoak, kanpokoak, automatikoki edo eskuz bilduak izan daitezke.

Biltegiratzea: Datuak egituratuta gorde behar dira ondorengo erabilerarako. Bestalde, beren iraunkortasuna arriskuan ez dagoela ziurtatu behar dugu, horretarako biltegiratze-sistema egokia izan behar dugu. Horretarako, eskuragarritasun handiko sistema eta backup sistema ona konfiguratu behar ditugu.

Era berean, ziurtatu behar da datuetarako sarbidea mugatua eta ziurtatua izango dela sarbide-kontrol eta autentifikazio sistemen bidez.

Prozesamendua: Gakoa da, datuak informazio bihurtzen diren unea, eta horrela erakundeari erabakiak hartzen laguntzeko funtzioa betetzen du.

Banaketa: Sistemak informazioa behar duten pertsonen artean banatzeko aukera emango du.

2.6 Informazio-sistemen motak

Informazio-sistema mota desberdinak badaude ere, eta sailkapena hainbat funtzionalitate eta/edo helbururen arabera egin daitekeen arren, bi motatan zentratuko gara:

ERP: Enterprise Resource Planning edo enpresako baliabideen plangintza. Enpresa baten prozesu guztiak kudeatzeko aukera ematen duten sistema integratuak dira: kontrol ekonomiko-finantzarioa, logistika, ekoizpena, mantentze-lanak, giza baliabideak, …

CRM: Customer Relationship Management, bezeroekin harremanak kudeatzeko eta kontaktu komertzial guztiak kudeatzeko sistemak.

ERP

3 Sarrera

Enpresako baliabideen plangintza sistemak (ERP, ingelesez enterprise resource planning) zuzendaritzarako informazio-sistemak dira, enpresa baten produkzio-operazioekin eta ondasun edo zerbitzuen banaketarekin lotutako negozio-jarduera asko integratzen eta kudeatzen dituztenak.

ERP sistemak batzuetan back office (atzealdea) izenez ere ezagutzen dira, bezeroak eta publiko orokorrak ez baitute sarbiderik. Enpresako barne-erabiltzaileek soilik (eta ez dute zertan guztiak izan) izango dute atal desberdinetara sartzeko aukera aldaketak egiteko. Aldaketa horiek erabiltzaile amaierak ikusiko duenaren gainean ikusiko dira edo eragina izango dute.

4 Helburuak

ERP sistemak informazio-kudeaketarako sistemak dira, enpresa baten jarduera operatibo edo produktiboekin lotutako negozio-praktika asko automatizatzen dituztenak.

ERP sistemak normalean modulu desberdinez osatuta daude, enpresaren barruan ekintza desberdinak egiteko. Horietako edozein behar izanez gero, modulu hori instalatu edo konfiguratuko da, izan ere, ohikoena da lehenetsita desgaituta egotea.

Ohikoenak diren moduluen artean honako hauek nabarmentzen dira: produkzioa, salmentak, erosketak, logistika, kontabilitatea (mota desberdinetakoa), proiektu-kudeaketa, GIS, inbentarioak eta biltegien kontrola, eskaerak, nomina, ...

ERP sistemen helburu nagusiak hauek dira:

Prozesu guztien bateratzea eta trazabilitatea sistema bakar batean.

Enpresako prozesuen optimizazioa.

Baliabideen plangintza.

Enpresako arloen arteko prozesuen automatizazioa.

Datuetarako sarbidea eta informazio egituratua sortzea.

Informazioa erakundeko kide guztien artean partekatzeko aukera.

Datu eta berringeniaritza-eragiketa alferrikakoak ezabatzea.

5 Ezaugarriak

Wikipediak dioen bezala, ERP bat beste edozein enpresa-softwaretik bereizten duten ezaugarriak hauek dira: modularrak, konfigura daitezkeenak eta espezializatuak izan behar dute:

Modularrak. ERP sistemek ulertzen dute enpresa bat informazioa partekatzen duten eta beren prozesuetatik sortzen den informazioarekin elkarlotuta dauden sail multzo bat dela. ERPen abantaila bat, bai ekonomikoki bai teknikoki, funtzionalitatea modulutan banatuta egotea da, eta modulu horiek bezeroaren beharretara egokituta instala daitezke. Adibidez: salmentak, materialak, finantzak, biltegiaren kontrola, giza baliabideak, etab.

Konfigura daitezkeenak. ERP sistemak softwarearen kodean garapenak eginez konfigura daitezke. Adibidez, inbentarioak kontrolatzeko, baliteke enpresa batek loteen partizioa kudeatu behar izatea, baina beste batek ez. ERP aurreratuenek laugarren belaunaldiko programazio-tresnak izaten dituzte prozesu berriak azkar garatzeko.

Espezializatuak. ERP espezializatu batek konplexutasun handiko eremuetan eta etengabeko bilakaeran dauden egituretan dauden soluzioak eskaintzen ditu. Eremu horiek izaten dira enpresen benetako arazoa, eta arlo zeharkako guztiak ere barne hartzen dituzte. ERP espezializatuetan lan egitea behar benetakoei benetako soluzioak behar dituzten enpresentzako urrats logikoa da. ERP orokor batek, aldiz, eraginkortasun portzentaje txiki bat baino ez du eskaintzen, erantzun orokorretan oinarrituta, funtzionalitate-hedapenak behar dituztenak.

CRM

6 Sarrera

Wikipediak dioen bezala, bezeroarekiko harremanen kudeaketa (customer relationship management), ingelesez CRM siglez ezaguna, hainbat esanahi izan ditzake:

Bezeroekin oinarritutako kudeaketa edo administrazioa: erakunde osoaren kudeaketa-eredu bat, bezeroaren gogobetetzean oinarritua (edo, beste egile batzuen arabera, merkatura bideratua). Kontzeptu hurbilena marketin tradizionala da.

Bezeroekin harremanak kudeatzeko softwarea: Bezeroekin harremanak, salmentak eta marketina kudeatzeko laguntza ematen duten sistema informatikoak, Enpresa Kudeaketarako Sistemen (SGE) barruan integratzen direnak, eta CRM, ERP, PLM, SCM eta SRM barne hartzen dituztenak.

CRM softwareak hainbat funtzionalitate izan ditzake enpresaren salmentak eta bezeroak kudeatzeko: salmenten automatizazioa eta sustapena, data warehouse teknologiak (datu-biltegia) transakzio-informazioa agregatzeko eta reporting geruza, dashboard eta negozio-adierazle nagusiak eskaintzeko, marketin-kanpainen jarraipenerako eta negozio-aukerak kudeatzeko funtzionalitateak, gaitasun prediktiboak eta salmenten proiekzioak.

CRM-a enpresa batek bere egungo eta etorkizuneko bezeroekin duen interakzioa kudeatzeko ikuspegia da, bezeroekiko/erabiltzaileekiko enpresaren pentsatzeko eta jarduteko modu bat. Bezeroaren historiaren datuen analisia erabiltzen du enpresarekin harremanak hobetzeko, bezero horien fidelizazioan eta, azken batean, salmenten hazkundea bultzatzean zentratuz.

7 Helburuak

Aurrekoa kontuan hartuta, CRM-a salmentak eta baliabideak kudeatzen dituen programatik bereizita badago, zaila izan daiteke guztia ondo kudeatzea. Azken finean, bezeroarekiko harremana egindako salmenten edo proiektuen ondorioa da.

CRM software sistemek bezeroekin harremanak kudeatzeko hainbat funtzio eskaintzen dituzte:

Bezeroen datuak maila komertzialean gordetzea.

Helburu desberdinetarako segmentu pertsonalizatuak sortzea.

Bezeroen eta salmenten jarraipena egitea.

Salmenta-prozesuen automatizazioa (leads, alertak, zereginak…).

Promozio espezifikoak sortzea.

Produktuen salmenta osteko zerbitzuaren kudeaketa.

8 Osagaiak

CRM baten osagai nagusiak bezeroarekin harremana eraikitzen eta kudeatzen dute marketinaren oinarrian, proiektuen fase desberdinetan denboran zehar dagoen harremana aztertuz, fase horiek ez baitira homogeneoak.

Ez da berdina bezero batekin lehen proiektuaren hasieran dagoen harremana, hirugarren proiektu baten exekuzioan dagoenarekin alderatuta.

8.1 Komunikazio motak

Bezeroarekin harremana izateko osagai onak honako hauek izan daitezke:

Ahozko komunikazioa: Bezeroarekin egingo dugun komunikazioaren zati bat ahozkoa izango da. Horrela, gertutasuna eta harreman komertzialaren oinarriak ezartzeko hasiera lortuko dugu.

Ez da zertan lehen hurbilketa izan behar, baina normalean harremana gehien estutzen duena izango da. Era berean, komunikazio jakin bat partekatzeko eta proiektuak hasteko oinarriak ezartzeko modurik azkarrena izaten da.

Internet: Gaur egun, Internet bidezko marketina da ohikoena. Enpresaren webgunearen, sare sozialen edo beste webgune batzuetan txertatutako publizitate-kanpainen bidez izan daiteke.

Gaur egun, bezero berriak lortzeko, berritasunak eta produktuen/proiektuen aurrerapenak ezagutarazteko, bezeroekin harremana mantentzeko edo hasteko modu garrantzitsua da.

E-mail bidezko kanpainak: Sare sozialek bigarren planoan utzi badituzte ere, e-mail bidezko kanpainak enpresek bezeroekin harremana izateko modu bat izaten jarraitzen dute. Bi motatakoak izan daitezke:

Bezero zehatzetara zuzendutakoak: Eskaini nahi dugunaren arabera, eta bezeroek aurretik zer kontratatu duten kontuan hartuta, kanpainak bezero zehatzetara zuzendu daitezke, ahalik eta eragin handiena bilatuz.

Orokorrak: Kanpaina orokorragoak direnez, edo informazio orokorra eskaintzeko (enpresan egon daitezkeen aldaketak edo zerbitzuen hobekuntzak), kanpaina hauek bezero guztiei zuzendu ahal zaizkie.

Telefono bidezko marketina: Zerbitzu orokorrak eskaintzen dituzten enpresek telefono bidezko marketin-kanpainak erabil ditzakete bezero berrien bila.

Euskarria/soporte: Proiektu bat amaitu ondoren edo zerbitzu bat kontratatzean, ohikoa da bezeroarentzako laguntza-sistema bat izatea.

Sistema honen bidez, bezeroak “laguntza” eska dezake eta, enpresaren arabera, teknikari espezializatu batek zalantzak argituko dizkio edo lagunduko dio.

Odoo

9 Sarrera

Odoo, lehen OpenERP izenez ezaguna, enpresa-baliabideen plangintzarako softwarea da, lizentzia bikoitzarekin. Bertsio irekia eta beste bat lizentzia komertzialarekin dago, ezaugarri eta zerbitzu esklusiboekin.

Odook CRM atala ere badu (ingelesez customer relationship management, edo bezeroekin harremanak kudeatzeko sistema), baita webgune komertzial bat, fakturazioa, ...

10 Instalazioa

Aurreko gaian ikusi dugun bezala, sistema bat instalatzeko hainbat modu daude, eta proiektuaren beharretara egokitu behar dugu instalazioa.

Gure kasuan, Docker zerbitzuen bidez instalatzea aukeratuko dugu, horrela hainbat bertsio probatu ahal izango ditugu (bai Odoo bai datu-basearena).

Alternatiba bat makina birtual batean instalatzea edo web ofizialean dauden instalatzaileak erabiltzea litzateke.

Instalazioa egiteko, Docker Hub webgunean agertzen diren jarraibideak erabiliko ditugu, aldaketa txiki batzuekin.

10.1 Zerbitzu independenteak

Oinarrizkoena den sistema da, bi Docker edukiontzi altxatu behar dira:

PostgreSQL datu-basearen edukiontzia. Datu-basearen hainbat bertsio erabil daitezke, baina webgunean gomendatutakoari kasu egingo diogu. Erabiltzaile eta pasahitzarekin kontuz ibili behar da.

Kasu honetan, PostgreSQL-en portu lehenetsia (5432) ere publikatu da:

Datu-basearen edukiontzia sortu eta abiarazi

ruben@vega:~$ docker run -d -e POSTGRES_USER=odoo \

-e POSTGRES_PASSWORD=odoo -e POSTGRES_DB=postgres \

-p 5432:5432 --name odoo_db postgres:15

- Odoo bera duen edukiontzia. Edukiontzi honek web aplikazioa martxan jartzeko beharrezko zerbitzu eta liburutegiak izango ditu.

Datu-basearen edukiontzia sortu eta abiarazi

ruben@vega:~$ docker run -d -p 8069:8069 --name odoo \

--link odoo_db:db -t odoo

10.2 Docker Compose

Docker Compose hainbat edukiontzi zerbitzu batera exekutatzeko tresna da, YAML formatuan fitxategi baten bidez sortzen dena. Zerbitzuen arkitektura azkar eta erraz sortu, gelditu eta berreraikitzeko modua da.

compose.yaml fitxategi bat sortu behar da, eta komenigarria da “zerbitzuen stack”-aren izena duen direktorio batean egotea, edukiontziak sortzean direktorioaren izena erabiltzen baitu.

compose.yaml fitxategiaren edukia

version: '3.1'

services:

web:

image: odoo:16.0

depends_on:

- db

ports:

- "8070:8069"

db:

image: postgres:15

environment:

- POSTGRES_DB=postgres

- POSTGRES_PASSWORD=odoo

- POSTGRES_USER=odoo

ports:

- "5433:5432"

Zerbitzuak abiarazteko, fitxategia dagoen direktorio berean komando hau exekutatu behar da:

Docker compose abiarazi

ruben@vega:~$ docker compose up

2023ko uztailean Compose v2-ra migratu zen, web ofizialean azaltzen den bezala. Instalatutako bertsioaren arabera docker compose up edo docker-compose up izango da.

10.3 Tresna osagarriak

Datu-basean sartzeko, kanpoko bezero bat erabil dezakegu. Horrela, ez dugu edukiontzian sartu beharrik eta interfaze grafiko bat izango dugu administratzeko.

Erabili daitezke:

DBeaver: Mahaigaineko aplikazioa da, hainbat SGBD-rekin konektatzeko aukera ematen duena. community bertsioa eta lizentziaduna dago, azken honek NO-SQL datu-baseekin ere konektatzeko aukera ematen du.

pgAdmin: PostgreSQL administratzeko web zerbitzari bidezko aplikazioa da.

pgAdmin edukiontzia sortu eta abiarazi

ruben@vega:~$ docker run -p 8090:80 \

-e 'PGADMIN_DEFAULT_EMAIL=user@domain.com' \

-e 'PGADMIN_DEFAULT_PASSWORD=SuperSecret' \

--name pgadmin4 -d dpage/pgadmin4

Datuen erabilera txostenetan

11 Informazio-panelak

Informazio-panelek (ingelesez dashboard) datuak modu grafikoan bistaratzea ahalbidetzen diguten tresnak dira, programaziorik egin beharrik gabe informazio bihurtzeko.

Esan genezake panelak aldez aurretik programatutako interfaze grafiko bat direla, datu-iturri batetik (kalkulu-orri bat, CSV fitxategi bat, datu-base bat, …) datuak lortzen dituena, ondoren modu grafikoan bistaratzeko.

12 Ezaugarriak

Informazio-panelek honako ezaugarri hauek izaten dituzte normalean:

Erabilerrazak dira: ez da beharrezkoa programatzailea izatea haiek erabiltzeko, betiere datuak formatu egokian baditugu.

Grafiko mota desberdinak erabiltzeko aukera ematen dute: taulak, datu geolokalizatuetarako mapak, bero-mapak, tarta motako grafikoak, barra-mapak (horizontalak eta bertikalak), …

Interaktiboak dira: grafikoak elkarri lotuta egon daitezke, eta horrela, batean atal bat hautatzean, gainerakoak eguneratzen dira.

Iragazkiak sor daitezke datuetan bilaketa bat egiteko.

Sortutako dashboard-a parteka dezakegu edo aurkezpen bat sor dezakegu.

Aitzitik, erabiltzerakoan zenbait desabantaila ere egon daitezke, eta argi izan behar ditugu haiek erabili aurretik:

Ematen dituzten ezaugarrietara mugatuta gaude. Beraz, eskaintzen dituztenak ez diren grafikoak sortu nahi baditugu, ezingo dugu egin.

Datuak tresnak onartzen duen formatuan egon behar dute. Guk programatzen badugu, formatua gurea izan daiteke, edo datu-hiztegia gure gustura egon daiteke.

Tresnarekiko menpekotasuna. Funtzionalitateak kentzea, ordaindu beharra jartzea, … erabakitzen badute, datuak migratu eta panela berriro sortu beharko dugu.

13 Datuak ulertzea

Informazio-panela sortu aurretik, argi izan behar dugu zer datu mota ditugun, nola antolatuta dauden (edo antolatu behar ditugun), zein formatu duten, … horregatik, aurretiazko azterketa bat egin behar dugu.

13.1 Datuen analisia

Datuen analisia egiterakoan, gutxienez, honako ezaugarri hauek kontuan hartu behar ditugu:

Datuen iturria: Datu propioak al dira? Edozein unetan berreskura al ditzakegu? Fidagarriak al dira?

Datuen formatua: Ez dugu kontuan hartu behar soilik datuak jasotzen ditugun fitxategiaren formatua, baizik eta datuak normalizatuta dauden ala ez ere. Adibidez, zenbakiak osoko/erreal formatuan ala testu formatuan gordeta dauden; geolokalizazio-daturik badagoen, bereizita ala agregatuta dagoen; …

Datuak ulertzea: Nahiz eta agerikoa dirudien, beharrezkoa da datuetako atal bakoitza ulertzea, ondoren elkarrekin erlazionatzeko eta panelean/grafikoan erabiltzeko.

13.2 Datuen eskema sortzea

Aurreko puntua kontuan hartuta, baliteke datuak normalizatzea edo formatu espezifiko bat sortzea beharrezkoa izatea. Beraz, hori egiteko aukera emango digun tresnaren edo programazio-lengoaia baten ezagutza izan behar dugu.

Lortutako datu gordinek esperoak betetzen ez badituzte, egin beharreko lanen artean egongo dira:

Datuak normalizatzea: Datu mota bakoitza behar duen formatura bihurtzea. Adibidez, OpenData Euskadi plataformako zenbait geoposizio-datutan, UTM izeneko formatu bat erabiltzen dute, eta hori latitude eta longitude bihurtu behar da.

Datu-hiztegia: Datuetara eta erabiliko dugun panel-sistemara ondoen egokitzen den eskema/datu-hiztegia sortzea.

13.3 Fitxategi mota sortzea

Azkenik, beharrezkoa izango da tresnak behar duen formatuan fitxategi mota sortzea: json, CSV, excel formatuan, …

Horretarako, datuen eskemaren arabera, fitxategia tresna sinpleekin sor dezakegu (adibidez, excel, CSV formatuan fitxategi bat sortzeko) edo, agian, programazio-lengoaiak eta lan hori errazten diguten liburutegi espezifikoak erabili beharko ditugu (adibidez, python).

13.4 Analisiaren dokumentazioa

Beti gomendagarria da datuen analisi-prozesua dokumentatzea, etorkizunean edo denbora bat igarota ulertzeko zergatik aldatu diren datuak egin diren moduan, edo zergatik erabili den fitxategi mota bat eta ez beste bat.

Dokumentazioak, gainera, erraztuko du geroago aldaketak egitea edo tresna berrietara egokitzapenak egitea. Horrela, hasiera batean, lanaren zati bat egina izango dugu eta ez dugu berriro egin beharko.

14 Looker Studio informazio-panelen sortzaile gisa

Looker Studio, lehen DataStudio izenez ezagutzen zena, Google-ren tresna bat da, datu desberdinetatik hornitutako informazio-panelei forma eta ikusgarritasuna emateko.

Tresna hau doakoa da, erabiltzeko erraza, eta emandako datuekin mota askotako panelak sortzeko aukera ematen du. Horrez gain, bestelako bistaratze motak ere sor daitezke, eta komunitateak panel berriak eskaintzen ditu.

Panelak sortzeko, datuak behar ditugu, eta hauek hainbat iturritatik inporta edo erabili ahal izango ditugu, adibidez:

CSV fitxategiak (comma separated value)

Google kalkulu-orriak

MySQL, PostgreSQL, SQL Server, … datu-baseak

Komunitateak sortutako beste konektore batzuk

14.1 Datuak eskuratzea

Lehenik eta behin, datu-iturri bat sortu beharko dugu, lortutako datuak bertara igo ahal izateko. Aurrez aipatu den bezala, beharrezkoa da haien analisia egitea, eta, behar izanez gero, ondoren normalizatzea.

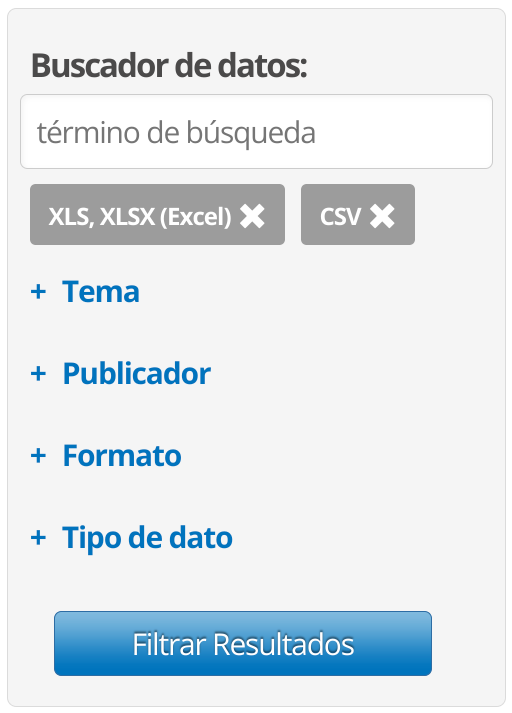

Adibide honetan, OpenData Euskadi plataformatik lortutako datuekin Google kalkulu-orri bat erabiliko da. Bilatuko dugu datuak CSV eta/edo Excel-eko XLS formatuan egotea, horrela datuen bihurketa ez dadin hain konplexua izan.

Datuak JSON formatuan edo beste formatu batean badaude, agian aldez aurretik bihurketa bat egin beharko genuke. Gainera, datuak manipulatu nahi izanez gero, ez litzateke hain zuzena izango.

Bilaketa egin ondoren, emaitzen zerrenda bat lortuko dugu, eta bertan aztertu ahal izango dugu gure interesekoak diren ala ez. Zenbait kasutan, izenak nahiko adierazgarriak dira. Gure interesekoak diren eta geolokalizazio-datuak dituzten datuak bilatuko ditugu.

Behin datuak deskargatu eta Google kalkulu-orri batean sartu ondoren, datuen analisia egin beharko dugu. Besteak beste, honako hauek egin beharko genituzke:

Lehenengo errenkada berrizendatu, zutabe bakoitza behar bezala identifikatuta egon dadin.

Datu bikoiztuek ezabatu daitezkeen egiaztatu.

Ez interesatzen zaizkigun eta/edo hutsik dauden zutabeak ezabatu.

Datu geografikoak formatu egokian dauden egiaztatu. Horretarako, Google Maps-en erabiliz dagokion udalerrira egiten duten erreferentzia ikus dezakegu.

Latitude eta longitude datuak zelula berean egon behar dute, koma batez bereizita.

UTM formatuan badaude, bihurtu egin beharko lirateke (konbertsore hau erabil daiteke).

Behin hori eginda, datuak erabiltzeko prest izango genituzke.

14.2 Datu-iturri bat sortzea Looker Studio-n

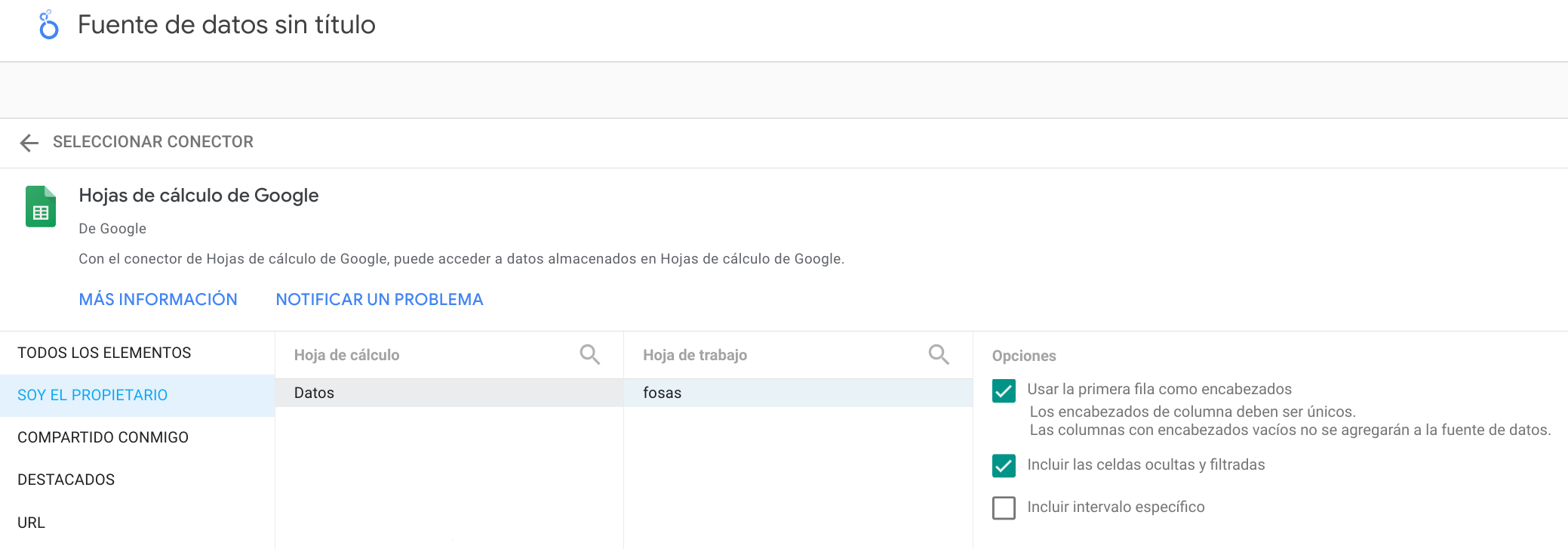

Datuak informazio-paneletan erabili ahal izateko, lehenik eta behin “Datu-iturri” bat gehitu behar dugu. Horretarako, “Sortu → Datu-iturri” aukeratuko dugu, eta interesatzen zaigun konektore espezifikoa hautatuko dugu.

Google kalkulu-orri bat erabiltzen badugu, hura atzitzeko baimenak eman beharko dizkiogu, eta interesatzen zaigun kalkulu-orria aukeratuko dugu. Inportazioan zenbait aukera hautatzeko aukera ere emango digu:

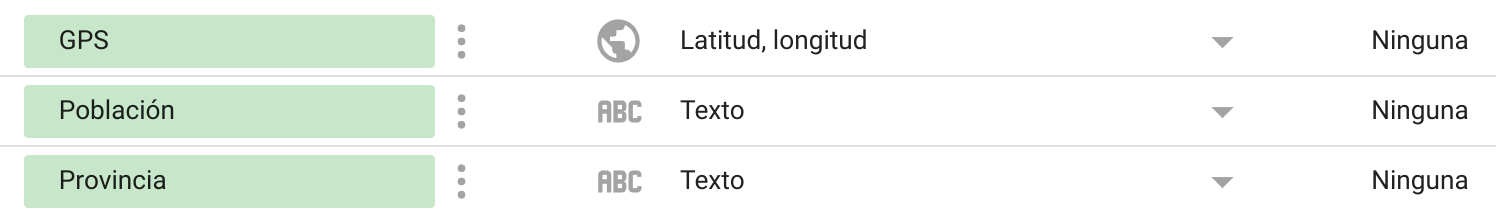

Inportazioa egin ondoren, datu-iturriaren barruan, datu bakoitzaren iturri mota identifikatu behar dugu. Zenbait kasutan, Looker Studio-k mota zuzena identifikatuko du, baina beste batzuetan ez, geolokalizazio-posizioekin gertatzen den bezala.

Behin datuak normalizatuta, txostena sortzen has gaitezke.

14.3 Txosten sortzea

Datuen normalizazioa amaitu ondoren, txostena sortzen hasteko momentua da eta datuak informaziora bihurtzeko. Horretarako, pentsatu beharko dugu zer mota informazio erakutsi nahi dugun eta nola.

Looker Studio-k hainbat grafikotan erabilera eskaintzen digu, bakoitzak bere berezitasunak eta konfigurazioa dituenez, interesgarria da bakoitza ikertzea eta nola funtzionatzen duen egiaztatzea.

Jarraian, batzuk azalduko dira:

Taula: Datuak erakusteko modurik errazena da, eta izenak dioen moduan, taula formatuan, errenkada eta zutabeetan banatuta. Zutabeak orden egokian jarri ahal izango ditugu, ordenaketa sistema sortu, errenkada bikoitz edo bakoitzari koloreak gehitu, eta abar.

Emaitzen koadroa: Normalean datu hautatu edo totalen kopurua kontatzeko erabiltzen dira.

Barren grafikoa: Datuak zutabeetan biltzen ditu, bertikal, horizontala, goranzkoa edo beheranzkoa aukeratu ahal izanik.

Mapak: Mapa mota desberdinak daude, eta datuen arabera modu batean edo bestean bistaratuko dituzte.

Berotasun mapa: Datuen posizioekin berotasun mapa bat sortzen du.

Burbuila mapa: Datuak geolokalizatzen ditu zirkulu txikiak gehituz. Horiek kolore desberdinetakoak izan daitezke, datuen aspektu nabarmen bat identifikatuz.

Alta Disponibilidad y Arquitectura de sistemas

15 Alta Disponibilidad

La alta disponibilidad en servidores se puede definir como el diseño de infraestructura (y su implantación) que asegura la continuidad del servicio y que no tiene un único punto de fallo.

Es lógico entender que un servicio debe de ser contínuo en el tiempo, ya que debe de dar servicio de manera continuada para que los usuarios puedan acceder a él. Pero para que esta premisa sea efectiva, y para asegurarnos que así sea, la infraestructura debe de estar redundada y carecer de puntos de fallo únicos en su diseño.

Esto quiere decir, que de cada servicio y para cada posible punto de fallo deberá haber al menos dos de ellos, para que en caso de que uno deje de funcionar el servicio siga funcionando (dos tomas eléctricas separadas, dos servidores que otorguen el servicio, dos conexiones a internet, ... ).

Es habitual que un sistema en Alta Disponibilidad deba de estar pensado desde el diseño. Algunos tipos de servicios pueden empezar como un único servidor y posteriormente realizar un escalado horizontal, formando la alta disponibilidad, mientras que para otros el diseño en alta disponibilidad debe de estar pensado desde el comienzo (habitualmente en algunos tipos de clusters).

15.1 Importancia de un sistema en Alta Disponibilidad

Como se ha citado previamente, la alta disponibilidad nos va a asegurar al menos tres grandes ventajas:

Una continuidad en el servicio

Un diseño libre de puntos de fallos únicos, gracias a la redundancia.

Mejorar el rendimiento global.

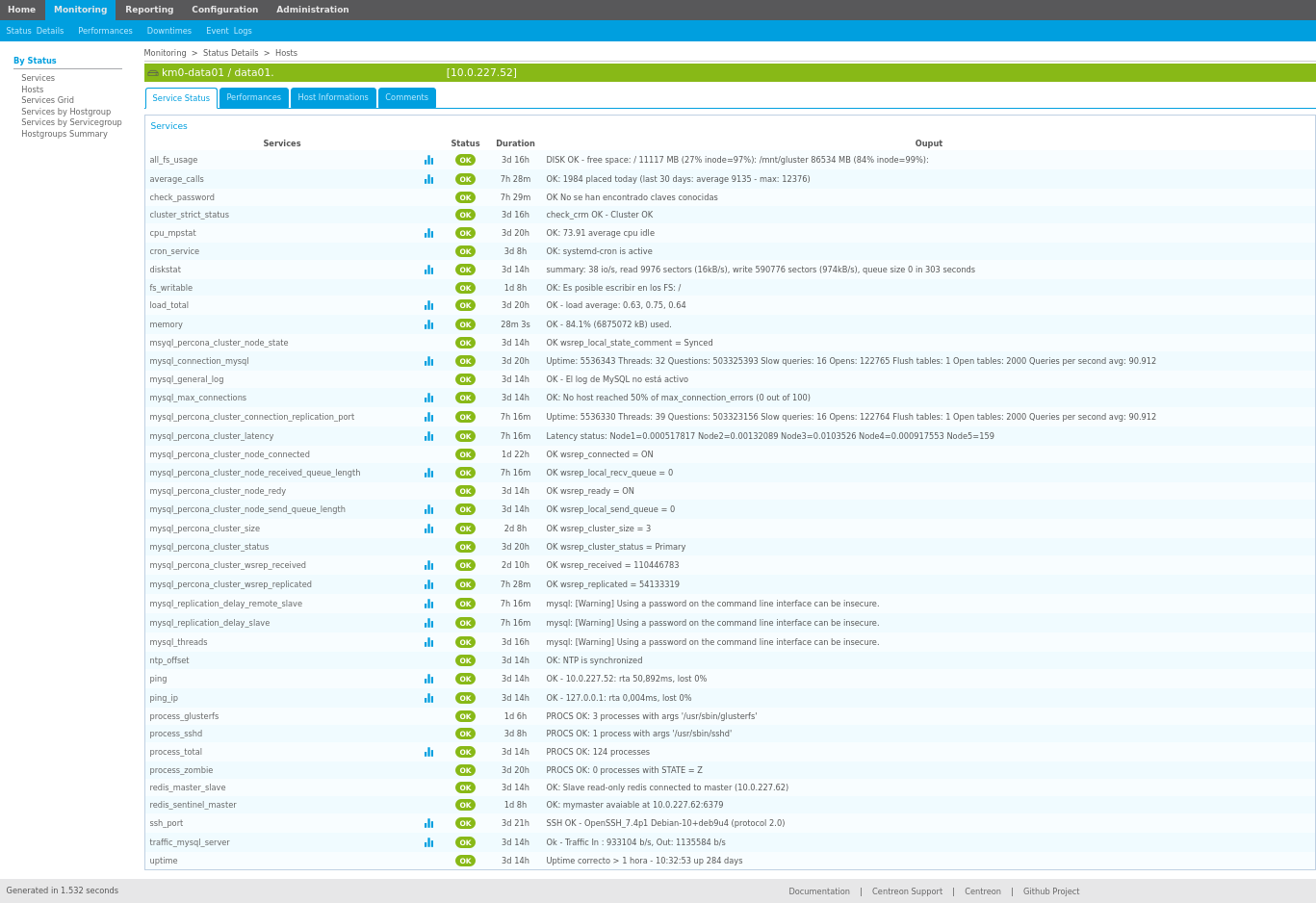

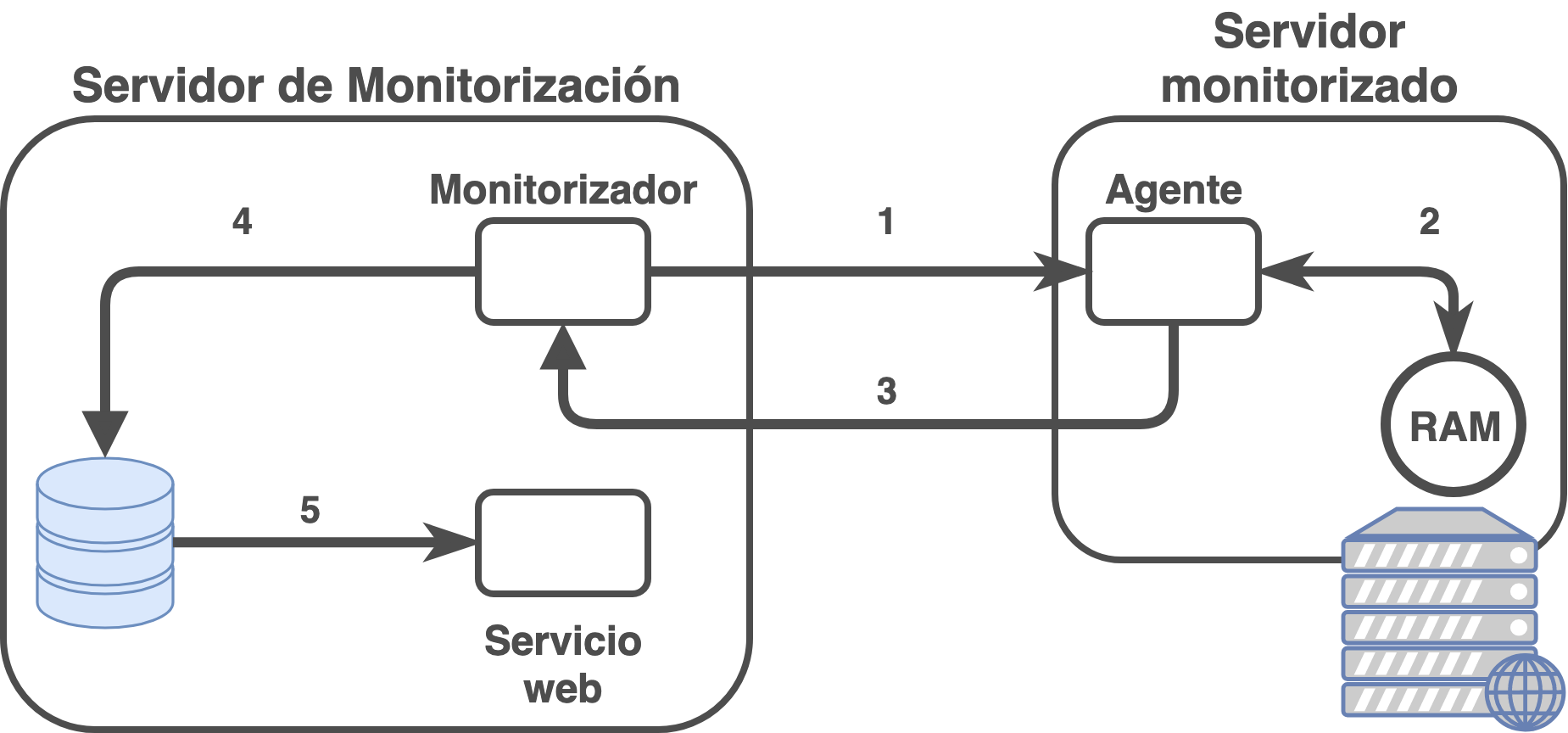

La redundancia permitirá que en caso de fallo de algún equipamiento/servicio, al estar redundando, no afecte al servicio. Gracias al sistema de monitorización seremos capaces de ver el problema y solventarlo lo antes posible. De estar el diseño correcto, el servicio mantendrá su actividad, mientras que por el contrario, si ha habido algún fallo en el diseño de infraestructura (o el problema es más grave de lo esperado) el servicio se verá afectado.

15.2 Tipos de Alta Disponibilidad

Existen muchos tipos de alta disponibilidad dependiendo de en qué capa de infraestructura estemos hablando. Por poner unos ejemplos:

Redundancia eléctrica: Los servidores normalmente cuentan con doble fuente de alimentación, por lo que cada fuente de alimentación debe de estar conectada a una toma eléctrica completamente separada de la otra.

Redundancia de conectividad física: El acceso a internet debe de ser redundado.

Redundancia de conectividad LAN: El acceso a la LAN/DMZ/red de servicio debe de estar redundado (stacks de switches, LACPs configurados en switches y servidores, … ).

Redundancia de servidores: Debe de existir una redundancia de servidores para asegurar que el servicio funcione en más de un servidor físico.

Redundancia de servicio: El servicio que se ofrece debe de estar redundado entre los distintos servidores.

La alta disponibilidad también se puede diferenciar como:

Alta disponibilidad real: En caso de que haya algún problema el servicio continúa como si no hubiese pasado nada, gracias a la redundancia completa de servicios/dispositivos.

Alta disponibilidad pasiva: En caso de error, los servidores activos serían los que reciben el impacto del problema y hay que escalar los servidores pasivos a modo activo para que comiencen a funcionar otorgando el servicio. Como se puede presuponer, esta modificación puede ser realizada de manera automática o de manera manual (lo que llevaría algo de tiempo, y por tanto el servicio se vería afectado).

16 Arquitectura de instalación

A la hora de realizar la instalación de un sistema de información, y teniendo en cuenta que es un pilar fundamental de la empresa, habrá que tomar ciertas decisiones desde el punto de vista de sistemas hardware.

De estas decisiones se encargará el sysadmin, o administrador de sistemas, pero tendrá que tener ayuda de los especialistas de la aplicación de sistemas de información, así como de determinar una decisión desde el punto de vista empresarial.

Entre las tareas que hay que tener en cuenta, se podrían destacar las siguientes:

Hardware: Determinar el hardware en donde se va a realizar la instalación. Hoy en día existen distintas alternativas, como son:

Hardware dedicado: Un servidor propio para el sistema, donde se realizará la instalación sólo para este servicio.

Máquina Virtual: El servicio será instalado en una máquina virtual a través de un sistema de virtualización profesional. El servicio es agnóstico al hardware, por lo que no sabrá si está virtualizado o no. Hoy en día suele ser la opción más común dadas las ventajas que ofrecen.

Elección del sistema de información: Esta es una tarea importante y que no se puede dejar de lado, ya que la decisión de optar por una herramienta u otra puede suponer un problema a futuro.

Es por eso que se debe realizar un estudio de mercado entre las distintas posibilidades y tener en cuenta, al menos, las siguientes situaciones:

Estado actual de la herramienta: Es importante saber si la herramienta analizada cuenta con un desarrollo continuado, si existe una empresa o grupo de desarrollo por detrás que la apoye; que no esté abandonada; que sea una herramienta con buena aceptación y críticas...

Coste de licencia: Es una herramienta que cuenta con una licencia a perpetuidad bajo un coste determinado, tiene licencia por el número de usuarios que acceden a ella, es una herramienta de Software Libre ...

Seguridad, actualizaciones y parches: La herramienta cuenta con actualizaciones de seguridad periódicas; no ha habido fallos de seguridad graves en las últimas versiones; cuando se detectan fallos las actualizaciones aparecen de manera rápida y efectiva; las actualizaciones y/o parches son gratuitos o de pago...

Coste de mantenimiento: Existe un coste asociado al mantenimiento de la aplicación, pero este puede ser por parte del sistema (realizar actualizaciones, aumento de recursos...) o por pago de licencias anuales, por versiones...

Posibilidades de personalización: Existe la posibilidad de personalizar la herramienta; parametrizar opciones propias que se ajustan a la empresa; creación de módulos/plugins propios para mejorar/expandir la funcionalidad de la herramienta, ...

Conocimientos sobre la herramienta: Dentro de la organización se cuenta con conocimientos acerca del uso/instalación/administración de la herramienta, debe ser subcontratado o existe la posiblidad de adquirir conocimiento mediante cursos o manuales.

Sistema operativo: Dependiendo del sistema de información elegido, se deberá instalar en un sistema operativo u otro. En este punto se pueden tener en cuenta también los puntos anteriores sobre el conocimiento para la toma de decisiones.

Método de instalación: Hoy en día existen distintas posibilidades a la hora de instalar servicios, por lo que es importante realizar una buena decisión:

Tradicional: Vamos a llamar sistema tradicional a aquel que se realiza mediante un instalador que realiza la instalación en el sistema operativo, que no suele dar demasiadas opciones de configuración durante el proceso.

Contenedores: Hoy día existen servicios que podemos instalar a través de sistemas de contenedores (como puede ser Docker), los cuales suelen facilitar la instalación, así como la posibilidad de que también sea un sistema multicapa.

Por capas: La instalación multicapa puede resultar un poco más compleja y la aplicación/servicio debe poder permitir realizarlo. Aunque inicialmente pueda suponer un poco más de esfuerzo, pero a la larga puede suponer una gran ventaja como es la alta disponibilidad.

Pasar de un sistema “monolítico” a un sistema por capas es posible, pero una vez más dependeremos de la aplicación. Por otro lado, si desde el inicio se ha creado un sistema multicapa, escalarlo será más sencillo que realizar la migración cuando ya esté en uso.

16.1 Arquitectura multicapa

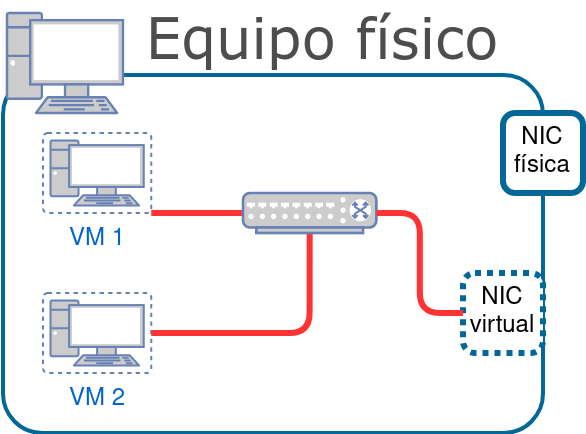

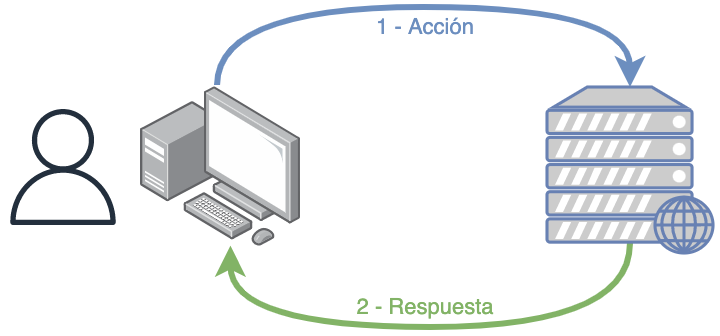

Un sistema informático multicapa es aquel que hace uso de una arquitectura cliente-servidor en las que existe una separación lógica y/o física entre las distintas funciones que tiene una aplicación o servicio.

Normalmente se suele representar como una arquitectura en tres niveles, siendo estos:

Capa de presentación: Es la que ve el usuario (también se la denomina «capa de usuario»), presenta el sistema al usuario, le comunica la información y captura la información del usuario en un mínimo de proceso (realiza un filtrado previo para comprobar que no hay errores de formato).

También es conocida como interfaz gráfica y debe tener la característica de ser «amigable» (entendible y fácil de usar) para el usuario. Esta capa se comunica únicamente con la capa de negocio.

Hoy en día lo habitual es que hagamos uso de servicios web, por lo que la capa de presentación es la web que estamos visualizando. En el caso de aplicaciones móviles, es la propia aplicación que tenemos instalada en el dispositivo.

Capa de negocio: es donde residen los programas que se ejecutan, se reciben las peticiones del usuario y se envían las respuestas tras el proceso. Se denomina capa de negocio (e incluso de lógica del negocio) porque es aquí donde se establecen todas las reglas que deben cumplirse.

Esta capa se comunica con la capa de presentación, para recibir las solicitudes y presentar los resultados, y con la capa de datos, para solicitar al gestor de base de datos almacenar o recuperar datos de él. También se consideran aquí los programas de aplicación.

En este tipo de arquitecturas, esta capa es la que se denomina backend, y lo habitual es que sea un sistema al que llamamos a través de una API (del inglés, application programming interface, o interfaz de programación de aplicaciones).

Capa de datos: es donde residen los datos y es la encargada de acceder a los mismos. Está formada por uno o más gestores de bases de datos que realizan todo el almacenamiento de datos, reciben solicitudes de almacenamiento o recuperación de información desde la capa de negocio.

Las aplicaciones web se pueden separar en dos capas: aplicación y base de datos.

En aplicaciones web es posible crear una arquitectura en capas aunque la aplicación no esté 100% pensado para ello: la propia aplicación y la base de datos.

16.2 Arquitectura de microservicios

Para poder crear una arquitectura de microservicios el enfoque debe darse desde el primer momento del desarrollo de software. Es decir, antes de realizar ningún tipo de programación la aplicación se planteará como pequeños servicios que podrán interactuar entre sí.

Cada servicio se encargará de implementar una única funcionalidad. En caso de necesitar alguna característica que se repita en varios, se debería crear un microservicio que proporcione dicha característica o funcionalidad.

Podríamos comparar una arquitectura de microservicios como una librería de programación, en la que existen funciones que realizan una única función.

Cada microservicio se desplegará de manera independiente, e incluso cada uno podrá estar programado en distintos lenguajes de programación. De esta manera se puede hacer uso del lenguaje y la tecnología más adecuada para cada funcionalidad.

17 Escalabilidad

Teniendo en cuenta todo lo dicho hasta ahora, cuando un sistema empieza a tener problemas de rendimiento deberemos abordar el problema y plantearnos cómo solucionarlo. De no hacerlo, se corre el peligro de que el servicio se vea interrumpido y por tanto perder tiempo de trabajo.

Antes de realizar ninguna modificación habría que analizar qué es lo que está sucediendo (para ello es importante tener un buen sistema de monitorización), y de esta manera saber en qué punto existe el problema y así poder solucionarlo.

Dependiendo de las decisiones tomadas durante la instalación, y tras lo visto previamente, podremos abordarlo de dos maneras diferentes.

“Escalabilidad” no existe en el diccionario de la RAE, pero se usa como anglicismo de la palabra scalability.

17.1 Escalado vertical

Cuando se escala verticalmente un sistema lo que se va a realizar es añadir más recursos al nodo que está teniendo problemas. Tras el análisis previo realizado se añadirán los recursos necesarios (más RAM, discos duros más rápidos, aumentar el número de procesadores/cores).

Comúnmente también se dice “meter más hierro”, porque antiguamente lo que se hacía era incrementar los recursos hardware del sistema. Hoy en día en sistemas virtualizados, estos recursos se pueden modificar, dependiendo del virtualizador, en “caliente”, por lo que no sería necesario reiniciar el servicio.

Es el sistema más simple, ya que incrementando los recursos se espera que el problema se apacigüe o desaparezca, aunque esto no tiene por qué ser siempre así.

17.2 Escalado horizontal

El escalado horizontal trata de solventar el problema repartiendo la carga entre más nodos. Este proceso de escalado es más complejo y dependerá de la modularidad del servicio ofrecido. Es decir, la lógica de la aplicación debería haberse pensado desde el inicio para un sistema que escalará de manera horizontal en el futuro.

En principio, al realizar un escalado horizontal no existe una limitación de crecimiento, ya que siempre que se pueda repartir la carga entre servidores, no importará el número de ellos.

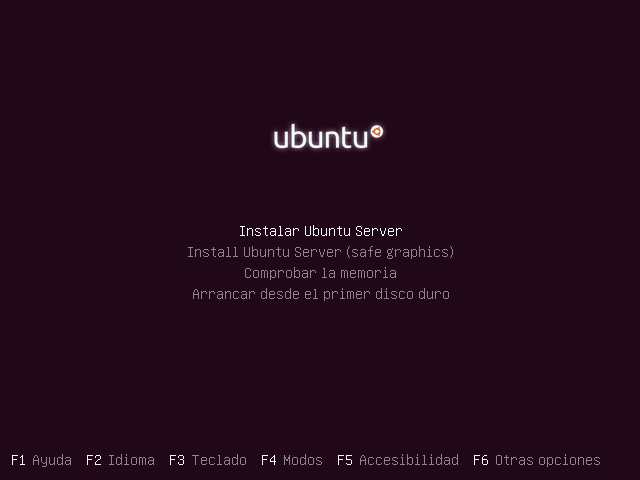

Dentro del escalado horizontal podríamos diferenciar dos tipos:

Escalado horizontal por capas: Teniendo en cuenta lo visto previamente acerca de la arquitectura multicapa, en este modelo lo que se conseguirá es escalar cada capa de manera independiente. Podría realizarse de la siguiente manera:

Servidores frontales (proxys) reciben las peticiones de la aplicación o del navegador y que balancean la carga y la mandan a servidores con la capa de presentación.

Servidores con la capa de presentación que realizan las peticiones de negocio a los servidores correspondientes.

Servidores de lógica de negocio que procesan las peticiones y piden los datos a un clúster de bases de datos.

Clúster de base de datos.

Escalado horizontal de microservicios: En el caso del escalado de microservicios, será similar al escalado horizontal, pero en este caso sólo se escalarán los microservicios necesarios.

Debido a que todo es mucho más modular, es posible que quizá sólo sea necesario realizar el escalado de algunos microservicios, que quizá sean los más utilizados o los que requieren más tiempo de ejecución.

Windows Subsystem for Linux

18 Sarrera

WSL (Windows Subsystem for Linux ingelesez) Microsoft-ek garatutako bateragarritasun-geruza bat da, Linux sistemetarako sortutako exekutagarriak Windows-en modu naturalean exekutatzeko.

2019. urtetik aurrera bertsio lehenetsia 2.a da, eta horrek aldaketa asko ekarri zituen sisteman, bertsio horrek Hyper-V virtualizatzailearen azpimultzo baten bidez sortutako birtualizazio-geruza batean exekutatzen baitu. Horrek esan nahi du exekutatzen ari den kernel-a askoz bateragarriagoa dela Linux-eko binarioekin 1. bertsioan baino. Birtualizazioa erabiltzen duen arren, aurreko bertsioarekin alderatuta errendimendua ere hobetzen du.

Lehenespenez, WSL ez dator instalatuta Windows 10ean, beraz, instalazioa egin behar da nahi ditugun aplikazioak (Docker, adibidez) exekutatu ahal izateko. Windows 11 bertsioetan, ordea, bai dator instalatuta.

19 Instalazioa

Instalazioa egiteko, Windows-en bertsio bateragarria beharko dugu (10 build 19041 edo berriagoa). Gaur egun ez luke arazoa izan behar sistema eguneratuta badugu.

Instalazioa egiteko administratzaile baimenak beharko ditugu, eta erosoago egiteko PowerShell kontsolatik edo Windows terminal berritik egingo dugu. Horretarako, administratzaile baimenekin kontsola ireki eta exekutatu:

WSL instalazioa Windows 10n

PS C:\Users\ruben> wsl --install

Instalazioa egin ondoren, sistema berrabiarazi behar da aldaketak aplikatzeko eta beharrezko zerbitzuak abiarazteko. Behin berrabiarazita, leiho bat agertuko da eta bertan erabiltzailea eta pasahitza sartzeko eskatuko digu, berriki instalatutako Linux sistemarako.

Lehenespenez, instalatzen den banaketa Ubuntu da.

20 Konfigurazioak

Instalazioa egin ondoren ikusiko dugu Windows-ek zenbait konfigurazio egin dituela zerbitzu berriaren instalazioa egokitzeko.

Instantziak abiarazita daudenean, Hyper-V sare-interfaze berri bat sortzen da, 172.25.240.0/20 sarearekin.

Aurretik esan bezala, WSL-2-n instantziak benetan Hyper-V makina birtualak dira. Instantzien konfigurazioa erabiltzaileak sortzen duen AppData direktorioan dago. Adibidez, Debian-en kasuan, disko gogorra ./AppData/Local/Packages/TheDebianProject…/LocalState/ext4.vhdx barruan dago.

AppData direktorioa lehenespenez ezkutatuta dago Windows fitxategi-arakatzailean.

Instantzien barruan, Windows-en disko gogorra atzitu daiteke /mnt/c-tik edo dagokion unitatetik.

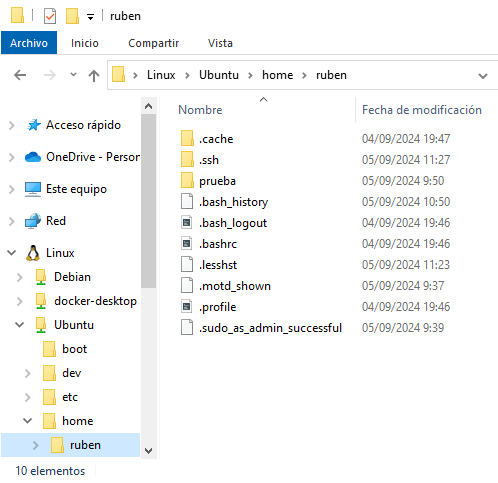

Windows-etik, fitxategi-arakatzailearen bidez, instantzien fitxategi-sistemara sar daiteke, sortuta ditugun instantziak bertan agertzen baitira.

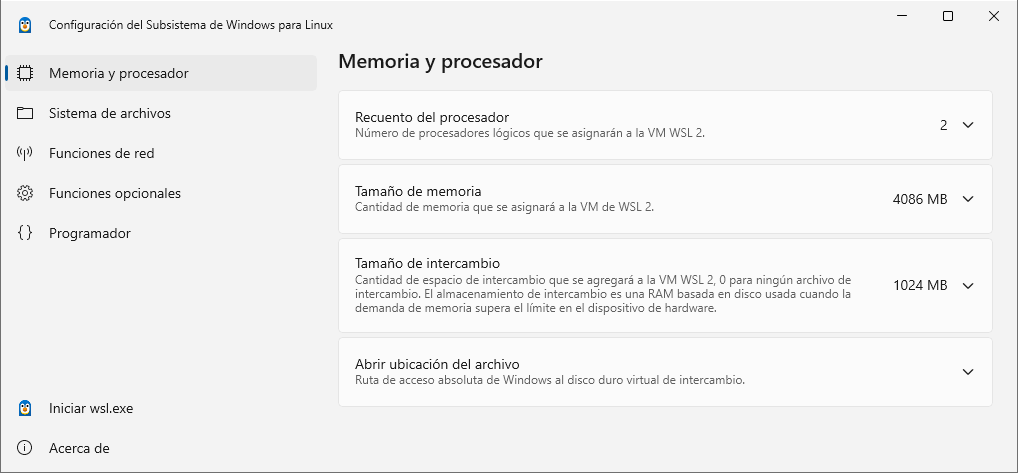

WSL ekosistema osoaren konfigurazio orokorra egiteko, aplikazio baten bidez egin daiteke (2024ko udazkenetik aurrera erabilgarri):

Aplikazio honetan alderdi interesgarri hauek aldatu daitezke:

- WSL barruko prozesadore logikoak

- Memoriaren gehieneko tamaina

- Sare modua (NAT, mirrored edo proxy)

20.1 Konfigurazio aurreratua

Konfigurazio aurreratu bat egiteko, dokumentazio hau erabil daiteke, bi ikuspegitatik:

wsl.conf: konfigurazio-fitxategia, distribuzioetako /etc direktorioan kokatzen dena. Konfigurazio honek soilik eragina du dagokion distribuzioan. Aurrerago Docker erabiltzeko adibide bat ikusiko dugu.

.wslconfig: Windows erabiltzailearen direktorioan dagoen fitxategia. Fitxategi honek WSL 2-rekin instalatutako distribuzio guztiei eragingo dien konfigurazioa izango du.

21 WSL pribilegio gabeko erabiltzaileekin

WSL-k administratzaile-baimenak behar dituzten zenbait ezaugarri erabiltzen ditu. Administratzaile-baimenik ez badago, lehenespenez WSL 1 bertsioa erabiliko da soilik, eta horren ondorioz azpisistemen errendimendua okerragoa da.

Beraz, WSL2 erabili ahal izateko administratzailearen kredentzialetara sarbidea izatea beharrezkoa da eta ondorengo komandoak exekutatu behar dira:

Pribilegio gabeko erabiltzaileetan WSL2 erabiltzea]{.title}

PS C:\Users\usuario> wsl --update

PS C:\Users\usuario> wsl --set-default-version 2

22 Komando erabilgarriak

Instalazioa egin ondoren, komando batzuk erabilgarriak izan daitezke WSL erabiltzerakoan. Ez dira guztiak zehaztuko, izan ere, wsl –help komandoarekin laguntza eta aukera gehiago lortuko ditugu.

Erakutsi instala daitezkeen banaketa guztiak

PS C:\Users\ruben> wsl -l -o

Debian banaketa bat instalatu

PS C:\Users\ruben> wsl --install -d Debian

Erakutsi instalatutako banaketak

PS C:\Users\ruben> wsl -l -v

Exekutatu instalatutako banaketa bat eta sartu bertan

PS C:\Users\ruben> wsl -d Debian

ruben@DESKTOP-1RVJ3UP:/mnt/c/Users/ruben$

Amaitu/Itzali banaketa bat

PS C:\Users\ruben> wsl -t Debian

Itzali instantzia guztiak

PS C:\Users\ruben> wsl --shutdown

Ezabatu instalatutako banaketa bat

PS C:\Users\ruben> wsl --unregister Debian

Klonatu instalatutako banaketa baten instantzia

PS C:\Users\ruben> wsl --export Ubuntu ubuntu.tar

PS C:\Users\ruben> wsl --import Ubuntu2 ubuntu2_files ./ubuntu.tar

23 Azpisistemen fitxategi-sistemara sartzea

Microsoft-ek WSL-rekin abiarazten ditugun Linux-eko fitxategi-sistemetara Windows fitxategi-esploratzailearen bidez sartzeko aukera sortu du. Honek aukera ematen du fitxategiak kopiatzeko/itsasteko sortu ditugun banaketen eta oinarri-sistema beraren artean. Hurrengo irudian hiru Linux azpisistema sortuta dauden esploratzailea ikus daiteke:

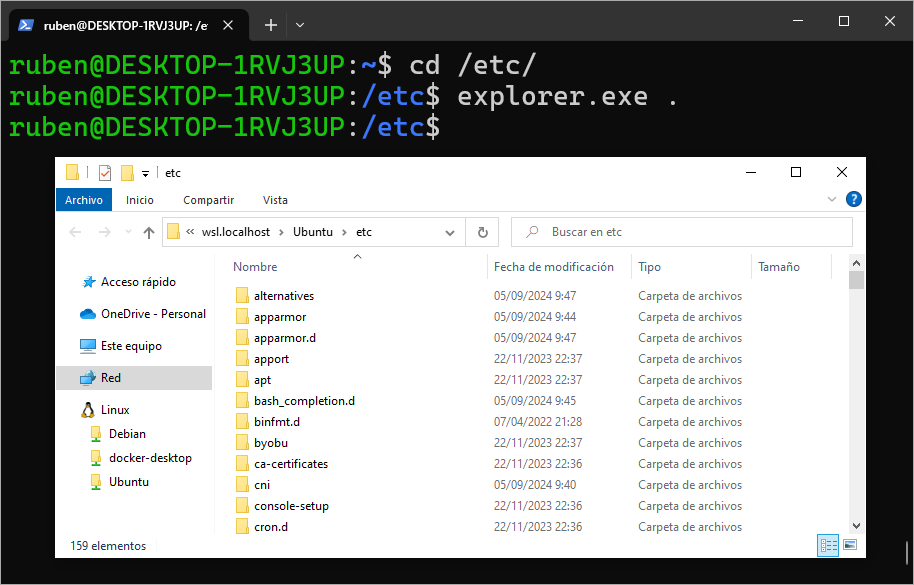

Bestela, azpisistema Linux-etik bertatik Windows aplikazioak exekuta ditzakegu, beraz edozein karpetan gaudela, explorer.exe . komandoa deitu dezakegu, eta horrek Windows esploratzailea irekiko du bide horretan bertan:

23.1 Fitxategi-sistemen errendimendua WSL-n

WSL nola funtzionatzen duen eta fitxategi-sistemen kudeaketa Windows sistema ostalariaren eta Linux azpisistemaren artean nola egiten den ikusita, argi izan behar dugu bi fitxategi-sistema independente daudela, baina elkarreragingarriak direla:

- Windows fitxategi-sistema: Gure Windows ordenagailuaren fitxategi-sistema da. Kontuan izan behar da, Linux azpisistemara sartzean, lehenespenez fitxategi-sistema horretan gaudela:

Linux azpisistemara sartzean, Windows fitxategi-sisteman gaude.

PS C:\Users\ruben\Desktop> wsl -d Ubuntu

ruben@DESKTOP-1RVJ3UP:/mnt/c/Users/ruben/Desktop$

Ikus daitekeen bezala, Ubuntun sartzean, gauden bidea hau da: /mnt/c/Users/ruben/Desktop, hau da, Windows fitxategi-sistema (C:) Linux-eko bidean muntatuta dagoena /mnt/c. Horregatik, Linux-etik Windows fitxategi-sistema osoa izango dugu eskuragarri bide horretatik.

- Linux azpisistemaren fitxategi-sistema: Sortu dugun Linux makina birtualak bere fitxategi-sistema propioa dauka, edozein Linux-en bezala,

/direktorioan.

Linux fitxategi-sistema errealera pasatzen gara

ruben@DESKTOP-1RVJ3UP:/mnt/c/Users/ruben/Desktop$ cd

ruben@DESKTOP-1RVJ3UP:~$ pwd

/home/ruben

Ikus daitekeen bezala, pwd komandoarekin, orain Linux errealeko fitxategi-sisteman gaude.

Linux azpisisteman aplikazioak erabiltzerakoan, gomendagarria da beti Linux-eko fitxategi-sistemaren barruan egitea, eta ez muntatutako sisteman, errendimendua askoz txikiagoa baita muntatutako sisteman. Beraz, ziurtatu behar dugu aplikazioa bide egokian dagoela.

Windows fitxategi-sistema muntatua erabiltzeak Linux azpisisteman errendimendua kaltetzen du.

24 Docker WSL barruan

Linux azpisistema batean Docker eduki nahi badugu, bi aukera bereiztu ditzakegu:

- Docker Desktop Windows-en erabiltzea. Docker Desktop-ek WSL erabiliko du azpian, eta aukera dugu azpisistemek Docker Desktop-en instalatutako Docker engine-a erabiltzeko. Hau da Microsoft-en dokumentazioak gomendatutako modua.

- Docker Engine Linux azpisistema baten barruan instalatzea.

Azken metodo hau behean azaltzen dugu.

24.1 Docker Engine WSLn instalatzea

Batzuetan interesgarria izan daiteke ez erabiltzea Docker Desktop, Docker-en kontrol osoa izan nahi dugulako, Linux makina birtual oso baten instalazioan bezala. Horregatik, dagokion Linux azpisistemaren funtzionamenduan aldaketa txiki bat egin behar dugu.

Docker Desktop erabiltzea errazagoa da sistema honen ordez.

Adibidez, Ubuntu banaketako Linux azpisistema sortu badugu, bertan sartu beharko gara, eta /etc/wsl.conf fitxategi bat sortu beharko dugu hurrengo edukiarekin.

wsl.conf fitxategiaren konfigurazioa

[boot]

systemd=true

Banaketatik irteten gara eta bere berrabiaraztea behartu behar dugu. Behin urrats hauek eginda, berriro instantzian sartzen bagara, systemd martxan egongo da eta, beraz, Docker Engine instalatu eta erabili ahal izango dugu ohiko moduan sortutako makina birtual baten moduan.

Introducción a Docker

25 Sarrera

Gaur egun oso ohikoa da kontainer-sistemak erabiltzea, eta ezagunena software garapenaren munduan Docker da. Sistema honek hainbat abantaila dakartza (aurrerago ikusiko ditugu), eta horri esker, besteak beste, produkzioko ingurunean erabilitako bertsioak garapen-faseetan erabilitako berberak direla egiaztatu dezakegu.

Dokumentu honetan Docker kontainer-sisteman oinarritutako sistema baten instalazioa eta konfigurazioa azalduko dira, zerbitzuak abiarazi ahal izateko eta ezagutu beharreko zenbait konfigurazio egiteko.

26 Kontainer-sistemak

Kontainer-sistemak birtualizazio-metodo bat dira (“sistema eragile mailako birtualizazioa” bezala ezagutua), eta horren bidez posible da sistema eragilearen nukleoaren birtualizazio-geruza baten gainean hainbat “erabiltzaile-espazio” instantzia exekutatzea.

“Erabiltzaile-espazio” horiei (bertan aplikazioak, zerbitzuak… exekutatuko dira) kontainerrak deitzen zaie, eta benetako zerbitzari bat bezala izan daitezkeen arren, sistema eragilearen kernel-ak eskaintzen duen isolamendu-mekanismo baten menpe daude. Horrez gain, baliabide-mugak aplika daitezke, hala nola espazioa, memoria, disko-sarbidea…

Kontainer bar zerbitzuen exekuziorako espazio bat da, eta baliabide-mugak (memoria, disko-sarbidea…) aplika dakizkioke.

Erabiltzaile baten ikuspegitik, zerbitzu bat makina birtual batean edo kontainer batean exekutatzea antzekoa da. Aldiz, sistema-administratzaile edo garatzaile baten ikuspegitik, kontaineren erabilerak hainbat abantaila dakartza, eta horiek hurrengo ataletan ikusiko ditugu.

26.1 Historia pixka bat

Kontainerrak erabiliz aplikazioak hedatzea gaur egun oso modan dagoen arren, ez da kontzeptu berria, 80ko hamarkadatik existitzen baita UNIX sistemetan chroot kontzeptuarekin.

Chroot, “chroot kaiolak” bezala ere ezaguna, komandoak direktorio baten barruan exekutatzea ahalbidetzen zuen, hasiera batean ibilbide horretatik irten ezin zela suposatuz. Segurtasun-murrizketa oso gutxi zituen, baina kontainer-sistemarako lehen urratsa izan zen.

LXC 2008an sortu zen, Linux kernelaren hainbat funtzionaltasun erabiliz prozesu desberdinak exekutatu eta bere sare-espazioa izan zezakeen ingurune birtual bat eskaintzeko. LXC-rekin batera tresna ugari sortu ziren kontainer hauek kontrolatzeko, baita txantiloiak sortzeko eta LXC-rekin programazio-lengoaia desberdinetatik interakzioa ahalbidetzen duen API bat ere.

Beste teknologia batzuk ere egon dira Linuxen, hala nola OpenVz, baina guk Dockerri erreparatuko diogu, gaur egun ezagunena baita.

26.2 Zer da kontainer bat eta nola sortzen da

Docker azpiegituraren barruan kontainer bat zer den eta nola sortzen den ulertzeko, hainbat kontzeptu bereizi behar ditugu:

- Docker irudia

- Docker kontainerra

Ondoren xehetasun handiagoz azalduko dira.

26.2.1 Docker irudiak

Kontainer bat sortzeko “irudi” bat erabiltzea beharrezkoa da, hau da, aplikazioaren kodea eta exekutatzeko behar dituen mendekotasun guztiak biltzen dituen fitxategi immutagarria (aldatu ezin dena). Horrela, azkar eta modu fidagarrian exekutatu daiteke, edozein ingurunean.

Irudiak, bere jatorri irakurketa-soilekoari esker, “txantiloi” gisa har daitezke, aplikazio bat exekutatzeko behar dituen ingurune osoa, une jakin bateko ordezkaritza direlako. Konsistentzia hori Docker-en ezaugarri nagusietako bat da.

Irudi batek interesatzen zaigun zerbitzua eta haren mendekotasunak ditu, eta exekutatzen den zerbitzaritik independenteak dira.

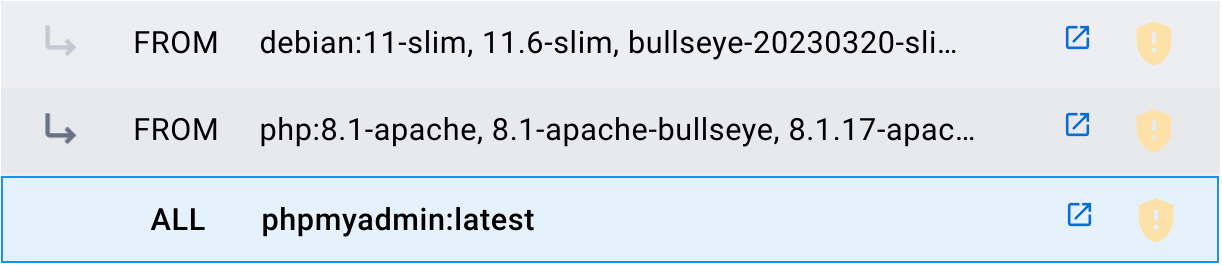

Irudi bat beste irudi batzuk oinarri gisa erabiliz sor daiteke. Adibidez, PHPMyAdmin irudiak PHPMyAdmin aplikazioa biltzen du PHP (8.1-apache bertsioa) irudiaren gainean, eta honek berriz Debian (11-slim bertsioa) irudia erabiltzen du.

Sortutako irudiei gehienetan etiketak (tags) eransten zaizkie bertsioak edo barne-ezaugarriak bereizteko. Sortzaile bakoitzak bere intereseko etiketak sortzen ditu. Adibidez:

- latest: Sortutako azken irudiari deritzo.

- php:8.1-apache: Irudi honetan PHPren bertsioa 8.1 dela eta Apache ere baduela adierazten du.

Erabili ditzakegu irudi publikoak komunitateak igotako irudiak gordetzen dituen registry publiko baten bidez deskargatuz. Gehien erabiltzen den registry nagusia Docker Hub da.

Docker irudiak publikoak edo pribatuak izan daitezke, eta registry izeneko biltegi batean gordetzen dira; ezagunena Docker Hub da

Gure irudi pribatuak sor ditzakegu, eta horiek gure ekipoetan gorde edo guk sortutako registry pribatu batean eduki ditzakegu (ordainpeko zerbitzuak ere badaude).

26.2.2 Docker kontainerrak

Docker exekuzio-denborako ingurune birtualizatu bat, non erabiltzaileek aplikazioak isolatu ditzaketen kontainer bat da. Kontainer hauek unitate trinkoak eta eramangarriak dira, eta baliabideen mugaketa-sistema aplika dakieke.

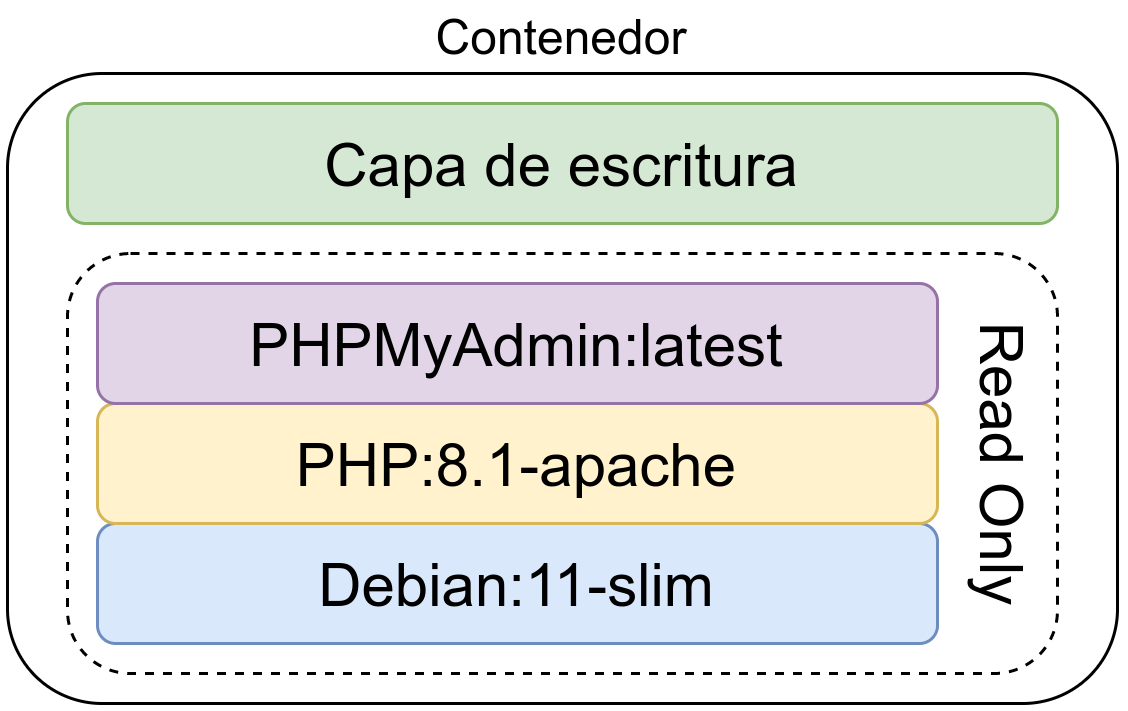

Kontainer bat irudi baten bidez sortzen da; irudi horren exekutagarri den bertsioa da, ingurune birtualizatu batean sortuta.

Kontainer bat irudi baten bidez sortzen da eta haren exekutagarri den bertsioa da. Horretarako, irudi immutagarriaren gainean idazketa-geruza bat sortzen da, eta hor idatzi daitezke datuak. Irudi base beraren bidez kontainer mugagabeak sor daitezke.

Idazketa-geruza ez da iraunkorra eta kontainerra ezabatzean galtzen da, hau da, kontainer baten datuak ezabatzen dira kontainer bera ezabatzean. Portaera hau saihesteko, datuen bolumen iraunkorra erabil daiteke, horrela datu horiek ez dira galduko.

Kontainer baten barruan sortutako datuak ezabatzen dira kontainerra ezabatzean

26.3 Kontainerrak vs. Makina birtualak

Makina birtualen erabilera oso hedatua dago, gero eta errazagoa baita hauek sortzea. Honek ez du esan nahi beti aukera onena denik; beraz, konparaketa bat egingo da, makina birtualekin eta kontainer-sistemekin garapena egiterakoan, kontuan hartu beharreko alderdi desberdinak aztertuz.

26.3.1 Azpiegitura

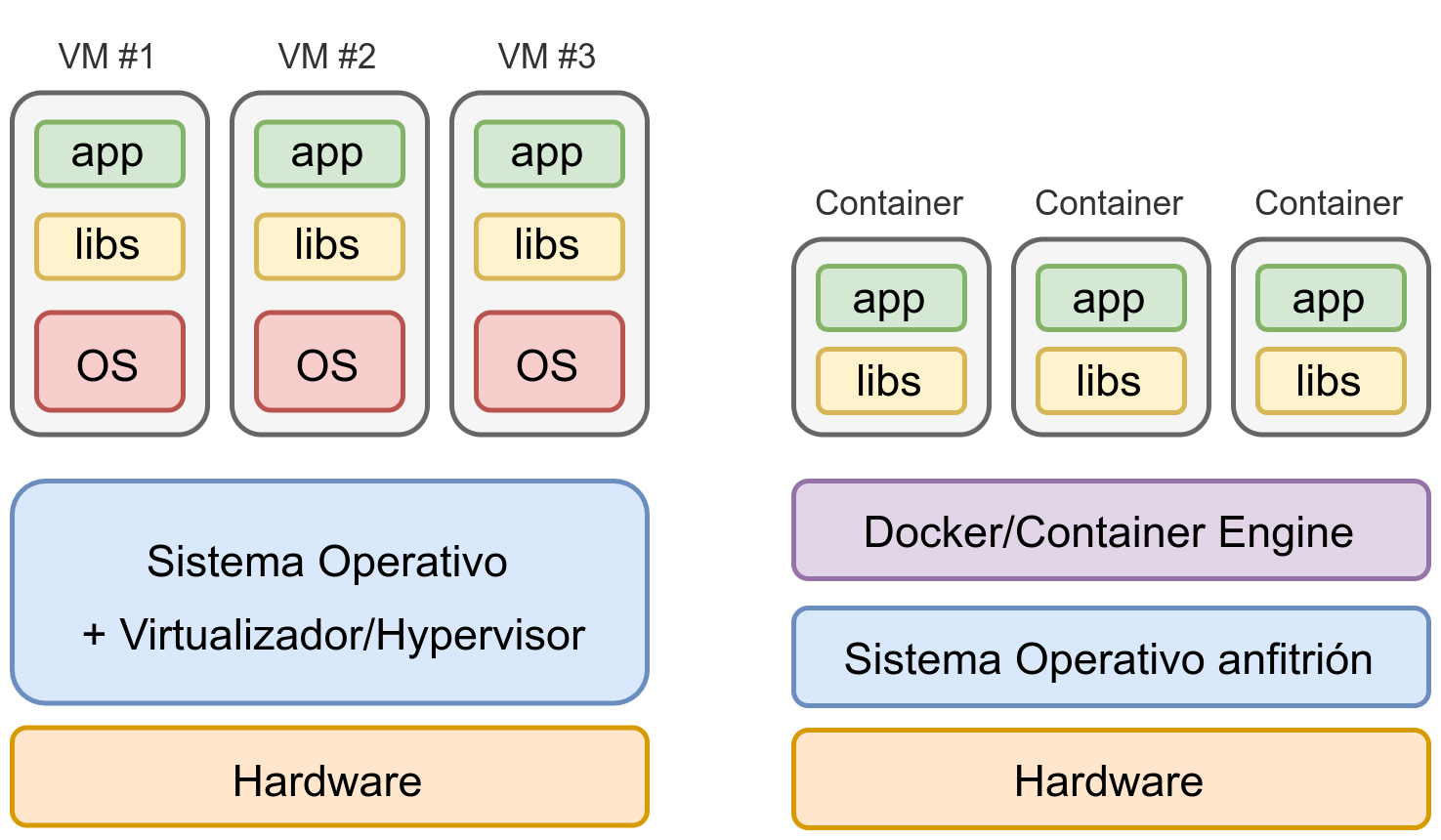

Makina birtualak sortzeak aukera ematen digu ingurune isolatuak sortzeko, bertan nahi dugun Sistema Eragilea instalatzeko eta, horrekin batera, behar dugun softwarea eta zerbitzuak instalatzeko.

Makina birtualak hardware-mailan birtualizatzen dira; horretarako beharrezkoa da Sistema Eragile bat hipervisorearekin, birtualizazioa ahalbidetzeko. Bestalde, kontainerrak aplikazio-geruzan birtualizatzen dira, eta horrek sistema askoz arinago bihurtzen du, baliabide horiek kontainer barruan exekutatu nahi ditugun zerbitzuetan erabil daitezen.

Irudian konparaketa bat ikus daiteke: 3 aplikazio desberdin makina birtualetan edo kontainer desberdinetan martxan jarriz nola geratuko litzatekeen azpiegitura.

Irudian ikus daitekeenez, zerbitzu bakoitza makina birtual bereizi batean izatean, sistema eragile osoa birtualizatu behar da, eta horrek baliabide-kostua (RAM memoria eta disko gogorra) eta konfigurazioan eta segurtasunean denbora-kostua dakar.

Kontainerrak erabiliz azpiegitura nabarmen sinplifikatzen da

Bestalde, kontainer-sistema batean, kontainer bakoitza zerbitzu isolatu bat da, eta hasiera batean bere parametroak konfiguratzeaz bakarrik arduratu beharko gara.

26.3.2 Garapenean dauden abantailak

Aplikazio bat garatzerakoan ohikoa da probak egitea liburutegi, framework edo programazio-lengoaia beraren bertsio desberdinak erabiliz. Horrela, gure aplikazioa bateragarria den ala ez ikus dezakegu.

Makina birtualak erabiltzean, gure banaketak (distribución) dituen bertsioen menpe gaude, eta baliteke bertsio berriak edo paraleloan beste bertsio batzuk ezin instalatzea.

Adibidez, gaur egun PHP-ren azken bertsioa 8.4.11 da eta Apache-ren bertsioa 2.4.65:

- Debian 12-n soilik PHP 8.2.29 eta Apache 2.4.62 instala daitezke.

- Ubuntu 24.04-n PHP 8.3.6 eta Apache 2.4.58 daude eskuragarri.

Docker erabiliz, interesatzen zaigun zerbitzuaren bertsio desberdinekin kontainerrak aldi berean martxan jar ditzakegu, gure aplikazioa/zerbitzua bateragarria den ala ez egiaztatzeko.

Docker erabiliz, bertsio desberdinekin zerbitzuak aldi berean martxan jar daitezke.

Bestalde, garatzaile batek sistema eragile desberdin bat erabili nahi badu, ez du kezkatu beharko bere banaketak bertsio berdinak dituen ala ez. Eta Windows/Mac erabiltzen badu, ez du zertan bertsio zehatzak instalatzen ibili.

26.3.3 Ekoizpenerako abantailak

Aurreko atalari lotuta, ekoizpenean (producción) derrigorrezkoa da garapenean erabilitako bertsio berberak erabiltzea bateragarritasuna (compatibilidad) bermatzeko.

Ekoizpenean (producción) bateragarritasuna bermatzeko, beti erabili behar dira garapenean erabilitako zerbitzuen bertsio berberak.

Zerbitzari bat eguneratuta ez badago, edo zerbitzari berean aplikazio desberdinak baditugu eta horietako bakoitzak softwarearen bertsio desberdinak behar baditu, makina birtualen ingurune batean oso konplexua bihurtzen da, ohikoena makina birtual berriak instalatu behar izatea baita.

Ez da beti posible zerbitzari berean software berdinaren bertsio desberdinak edukitzea.

Kontainer-ingurune batean, lehen azaldu den bezala, ez daukago arazo hori.

26.3.4 Azkartasuna zabalkundean

Aurreko guztiarekin lotuta, garapen/ekoizpen ingurune baten zabalkundea (despliegue) azkarragoa da kontainerrak erabiliz, zein sistema eragile erabiltzen ari garen kontuan hartu gabe.

Kontainerrekin zabalkundea azkarragoa da.

Aurrerago ikusiko da nola jarri martxan zerbitzu desberdinak komando bakar baten bidez.

27 Docker

Docker 2013an sortutako Software Libreko proiektu bat da, aplikazioak eta zerbitzuak kontainerren bidez modu azkar eta errazean hedatzeko aukera ematen duena, aurrerago ikusiko dugun bezala.

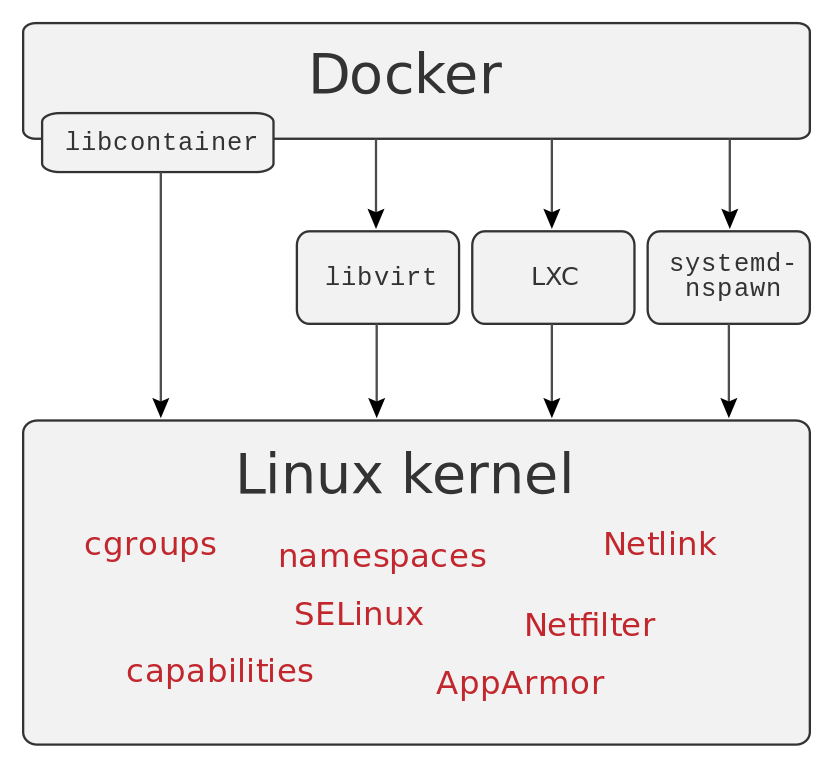

Kontainer hauek abstrakzio-geruza bat eskaintzen dute eta aplikazioak sistema eragilearen gainerako ataletatik isolatzeko aukera ematen dute, Linux kernelaren ezaugarri jakin batzuk erabiliz.

Kontainer barruan, honako isolamendu mailak azpimarra daitezke:

- Prozesu zuhaitza

- Muntatutako fitxategi-sistemak

- Erabiltzailearen IDa

- Baliabideen isolamendua (PUZ/CPU, memoria, S/I blokeak…)

- Sare isolatua

Beste edozein software motatan bezala, Dockerrek ezaugarri hauek guztiak erabiltzeko, beste aplikazio eta zerbitzu batzuetan oinarritzen da.

2015ean Docker enpresak Open Container Initiative sortu zuen, gaur egun Linux Foundation-en menpe dagoen proiektua, sistema eragile mailako birtualizaziorako estandar ireki bat diseinatzeko asmoarekin.

27.1 Instalazioa

Sistema eragilearen arabera, Docker modu ezberdinetan instala daiteke. GNU/Linux sistema eragileetan banaketa bakoitzak bere pakete propioa dauka instalazioa egiteko.

Docker instalazioa Ubuntu-n

ruben@vega:~$ sudo apt install docker.io

Ubuntu eta Debian-en pakete-izena “docker.io” da.

27.1.1 Windows eta/edo Mac-en instalazioa

Windows eta MacOS sistemetan Docker Desktop instalatzeko aukera dago; bertsio honek makina birtual bat erabiltzen du instalazioa errazteko. Hala ere, CLI ere instalatzen da, eta aurrerago ikusiko ditugun komandoak erabiltzeko aukera ematen du.

Windows kasuan, BIOS/UEFI-n birtualizazioaren luzapenak gaituta izatea beharrezkoa da, eta bi aukera hauetako bat konfiguratu behar da Docker Desktop instalatu aurretik:

- WSL2 erabiltzea.

- UHyper-V eta Windows kontainer-sistema erabiltzea.

27.2 Konfigurazioa

Instalazioa egin ondoren ikusiko dugu Docker zerbitzuak interfaze berri bat sortu duela gure makinan, zeinaren IPa 172.17.0.1/16 den, lehenetsitako helbideratzearen arabera.

IP berria

ruben@vega:~$ ip a

...

3: docker0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc noqueue

link/ether 02:42:9c:1f:e2:90 brd ff:ff:ff:ff:ff:ff

inet 172.17.0.1/16 brd 172.17.255.255 scope global docker0

valid_lft forever preferred_lft forever

IP honek zubi lana egingo du (makina birtualetan gertatzen den antzera) kontainer berriak abiatzen ditugunean. Kontainerrak 172.17.0.0/16 sarearen barruan egongo dira, hau da, ekipoaren sare nagusitik isolatuta.

Abiatu ditugun kontainerrak 172.17.0.0/16 sarean egongo dira

27.3 Docker erabiltzea pribilegiorik gabeko erabiltzaile batekin

Docker erabiltzeko root/administratzaile baimenik ez duen erabiltzaile batekin, erabiltzaile hori talde baten barruan gehitu behar da. Docker non erabiltzen dugunaren arabera, modu batean edo bestean egin beharko dugu.

27.3.1 Linux

Kasu honetan, erabiltzaileak izan behar duen taldea “docker” da, eta erabiltzaileari modu ezberdinetan gehi diezaiokegu:

- /etc/group fitxategia editatuz, eta erabiltzailea taldean gehituz

- Ondoren jartzen ditugun komandoak exekutatuz:

Gehitu docker taldea erabiltzaileari

ruben@vega:~$ sudo addgroup ruben docker

[sudo] password for ruben:

Adding user `ruben' to group `docker' ...

Adding user ruben to group docker

Done.

ruben@vega:~$ newgrp docker

Hemendik aurrera, Docker erabili ahal izango da taldera gehitu diogun erabiltzailearekin.

27.3.2 Windows

Windowsen erabiltzaile batek Docker Desktop erabili ahal izateko, “docker-users” taldekoa izan behar du. Gehitzeko, administratzaile baimenekin PowerShell batetik exekutatuko dugu:

Gehitu docker-users taldea erabiltzaileari

PS C:\Users\ruben> net localgroup "docker-users" "usuario" /add

27.4 Lehen urratsak

docker komandoak aukera asko ditu, beraz gomendagarria da parametro gabe exekutatzea. Horrela aukera guztiak eta bakoitzaren laguntza sinplifikatu bat ikus daitezke.

Docker komandoaren aukera batzuk

ruben@vega:~$ docker

Usage: docker [OPTIONS] COMMAND

Management Commands:

builder Manage builds

completion Generate the autocompletion script for the specified shell

config Manage Docker configs

container Manage containers

context Manage contexts

image Manage images

manifest Manage Docker image manifests and manifest lists

network Manage networks

node Manage Swarm nodes

plugin Manage plugins

secret Manage Docker secrets

service Manage services

stack Manage Docker stacks

swarm Manage Swarm

system Manage Docker

trust Manage trust on Docker images

volume Manage volumes

Commands:

...

Aukera hauetako bakoitzari --help parametroa gehi dakioke laguntza erakusteko. Moztu den bigarren atal batean komando gehiago sartzen dira.

Docker zerbitzua martxan dagoela ziurtatzeko, docker info erabil dezakegu, zerbitzuari buruzko informazio ugari erakutsiko diguna. Baina benetan nahi duguna bada egiaztatzea ea kontainerren bat martxan dagoen, errazagoa da docker ps erabiltzea (hau da docker container ls-en bertsio sinplifikatua):

Docker eta abiarazitako kontainerren egoera egiaztatzea

ruben@vega:~$ docker ps

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

ruben@vega:~$ docker container ls

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

Kasu honetan, ez dago kontainerrik abiarazita, eta zerrendako zutabeen goiburuak soilik erakusten dira.

27.5 Gure lehen kontainerra abiarazten

Orain gure lehen kontainerra sortzeko unea da. Horretarako, kontsola erabiltzen ari garenez, docker komandoa erabili behar da parametro sorta batekin. Kasu honetan, Apache HTTPD zerbitzua abiaraztea aukeratu da:

Lehen kontainerra abiarazten

ruben@vega:~$ docker run -p 80:80 httpd

AH00558: httpd: Could not reliably determine the server's ...

AH00558: httpd: Could not reliably determine the server's ...

[Fri Mar 24 18:25:14.194246 2023] [mpm_event:notice] ...

[Fri Mar 24 18:25:14.194347 2023] [core:notice] [pid ...

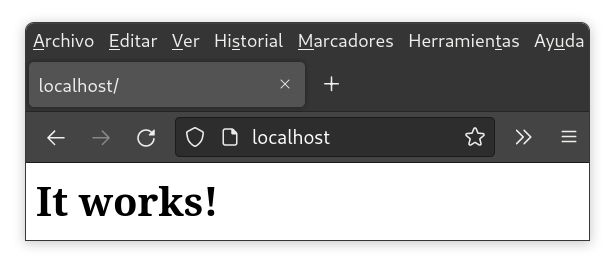

172.17.0.1 - - [24/Mar/2023:18:25:41 +0000] "GET / HTTP/1.1" 304 -

Apache zerbitzuaren log-ak ikusten ditugu abiaraztean, eta nabigatzailean http://localhost helbidera joanez gero, hauxe erakusten du:

Eta komandoak zer egiten duen ulertzeko, parametroak hauek dira:

- docker: Docker kontsolako bezeroa.

- run: Komando bat exekutatzen du kontainer berri batean (eta ez badago sortzen du).

- -p 80:80: Zerbitzariaren 80 portuan argitaratzen du kontainerrean erabiltzen den 80 portua. Pentsa daiteke port-forward bezala egitea dela firewall batean.

- httpd: Abiaraziko den kontainerraren irudia da. Kasu honetan, Apache HTTPD zerbitzariaren irudia da.

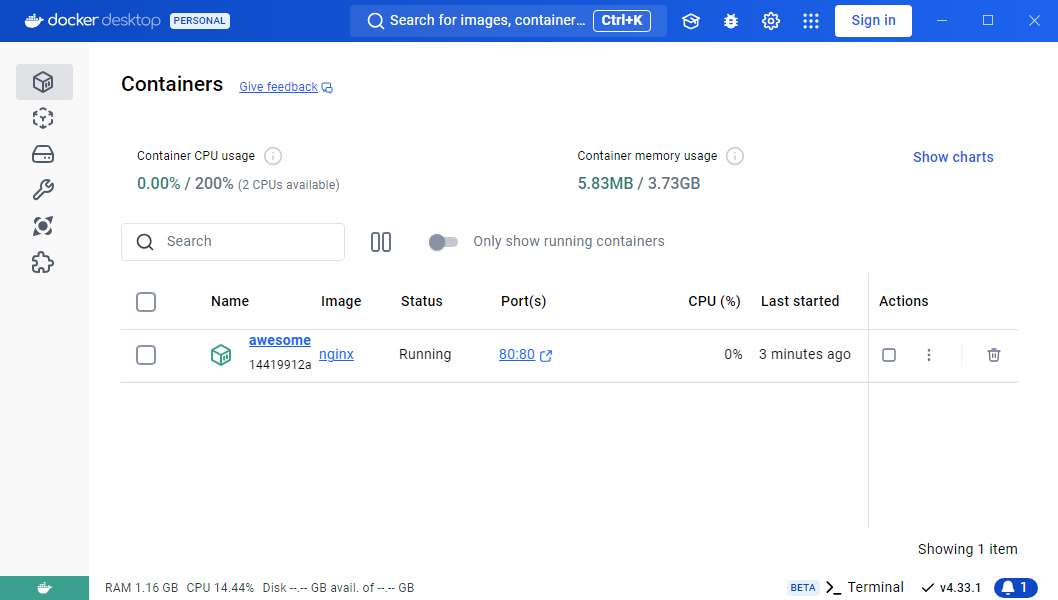

Eta docker-aren egoerak zer erakusten duen begiratuz gero, kontainerra abiarazita agertzen dela ikus dezakegu.

Docker eta abiarazitako kontainerren egoera egiaztatzea

ruben@vega:~$ docker ps

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

a1c3362b0d6c httpd "httpd-..." 3 seconds ago Up 2 seconds 0.0.0.0:80->80/tcp great

PORTS zutabean ikus daiteke nola agertzen den 0.0.0.0:80 portua (sistema eragileko edozein IP-rentzat 80 portuan entzuten duena), eta hori kontainerraren barneko 80/TCP portura birbideratzea dela.

27.6 Kontainerrak backgroundean eta aukera gehiago

Aurreko adibidean ikus daitekeenez, kontainerra lehen planoan geratzen da, Apache-ren log-ak erakutsiz. Honek garapenean gertatzen ari dena ikusteko balio dezake, baina ideia ona da kontainerra background moduan abiaraztea, eta behar dugunean log-ak kontsultatzea.

Jarraian Apache kontainer berri bat abiaraziko da parametro berriekin:

8080 portuan Web kontainer bat sortzea

ruben@vega:~$ docker run --name mi-apache -d -p 8080:80 httpd

Parametro berriak honako hauek dira:

--name mi-apache: Modu honetan kontainerari izen bat ematen zaio, sortutako kontainer guztien artean azkar identifikatzeko.-d: Parametro honek komandoa detach moduan exekutatzea ahalbidetzen du, eta horrela kontainerraren exekuzioa background-era bidaltzen du.-p 8080:80: Kontainerrean erabiltzen den 80. ataka zerbitzarian 8080. atakara publikatzen du. Pentsa daiteke firewall batean port-forward bat egitea bezalaxe.

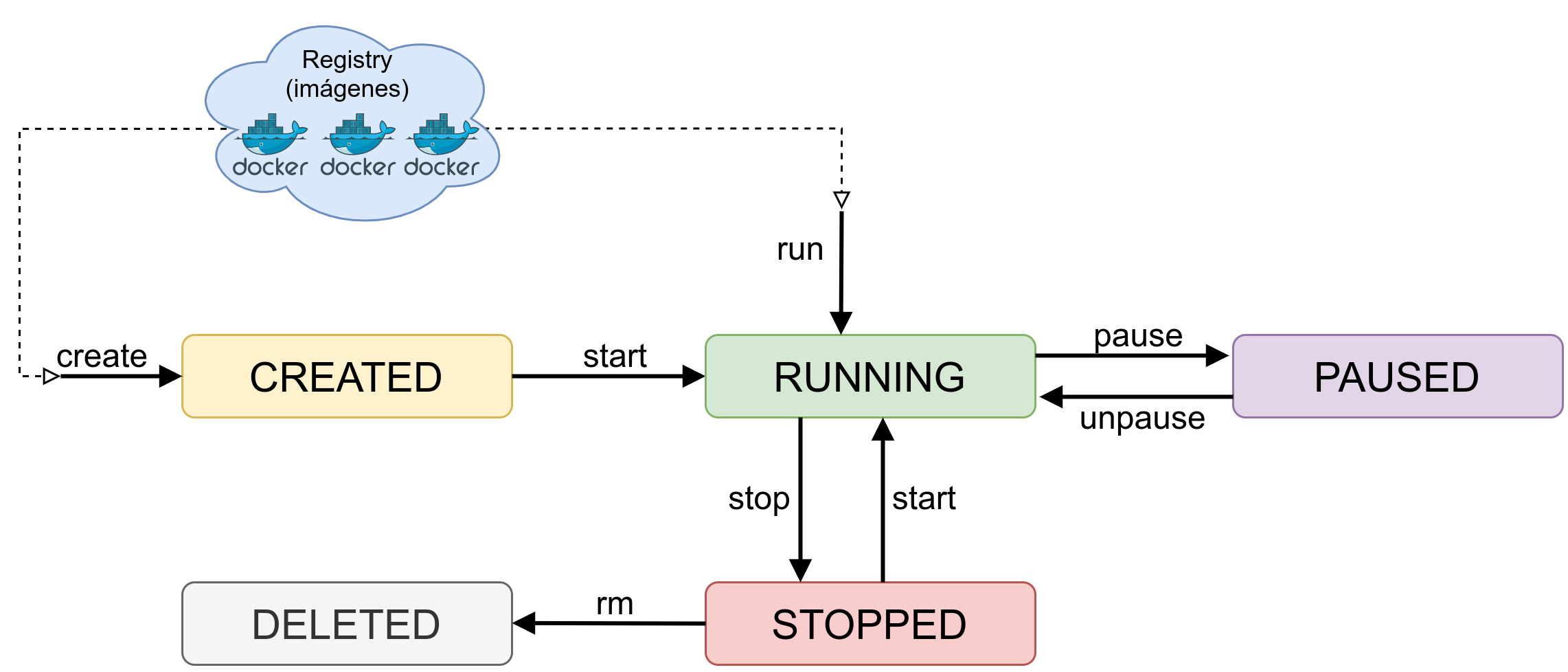

27.7 Kontainerrak gelditu, abiarazi eta ezabatu

Orain arte kontainerrak sortzen ikasi dugu, baina batzuetan interesgarria izan daiteke ez erabiltzen ari garen kontainer bat gelditzea, edo bere funtzioa bete duenean, ezabatzea.

27.7.1 Kontainerrak gelditzea

Kontainer bat gelditzeko, bere izena edo IDa (bakarra dena) ezagutu behar dugu. Datu hauek docker ps komandoaren bidez lor daitezke.

Horrela, honako hau exekutatu dezakegu:

Kontainerra gelditu

ruben@vega:~$ docker stop mi-apache

27.7.2 Gelditutako kontainer bat abiarazi

Kontainer bat gelditu ondoren, edo zerbitzaria berrabiarazten denean, gelditutako kontainer bat abiarazi nahi badugu, bere IDa edo izena ere ezagutu behar dugu.

Kontainer guztiak ikusteko (abiarazitakoak eta gelditutakoak), docker ps -a komandoaren bidez egin dezakegu.

Zerrenda horri esker, geldituta dagoen kontainer bat berriro abiarazi dezakegu docker start mi-apache komandoarekin, non “mi-apache” abiarazi nahi dugun kontainera den.

27.7.3 Kontainer bat ezabatu

Kontainer bat ezabatu nahi badugu, geldituta egon behar da, Docker-ek ez baitu exekuzioan dagoen kontainer bat ezabatzen utziko.

Interesgarria da proba kontainerrak edo ez erabiliko diren kontainerrak ezabatzea, baliabideak askatzeko.

Horretarako, aurreko kasuekin antzeko moduan, docker rm mi-apache komandoa erabili behar da.

28 Ingurune-aldagaiak

Kontainer batzuek aukera dute ingurune-aldagaiak jasotzeko sortzean. Aldagai hauek kontainerraren portaeran eragin dezakete, edo lehenetsi ezarpenetatik bestelako moduan abiarazi ahal izateko.

Docker irudiaren sortzaileak behar dituen ingurune-aldagaiak sor ditzake, gero bere aplikazioan erabiltzeko. Adibidez, PHPMyAdmin aplikazioaren irudia erabiliko da.

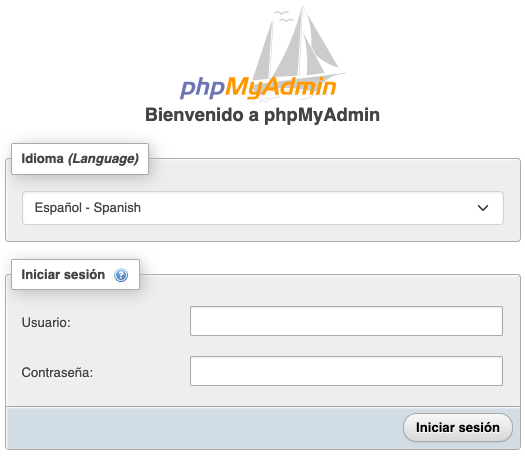

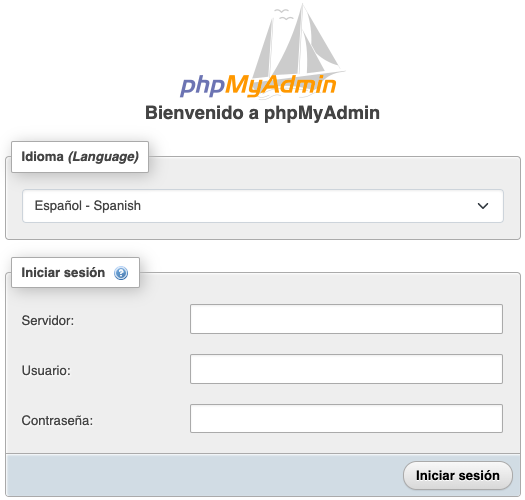

Hurrengo adibidean PHPMyAdmin kontainer bi sortuko dira, ataka, izen eta PMA_ARBITRARY ingurune-aldagaiarekin desberdinduta:

- Lehenengo kontainera 8081 atakan egongo da, “myadmin-1” izena izango du eta ingurune-aldagaia ez da hasieratuko.

- Bigarren kontainera 8082 atakan egongo da, “myadmin-2” izena izango du eta PMA_ARBITRARY aldagaia “1”-era hasieratuko da, PHPMyAdmin irudiaren dokumentazioan agertzen den moduan.

Horretarako, honako komando hauek exekutatu dira:

PHPMyAdmin-en bi kontainerrak sortzen

ruben@vega:~$ docker run --name myadmin-1 -d -p 8081:80 phpmyadmin

ruben@vega:~$ docker run --name myadmin-2 -e PMA_ARBITRARY=1 -d -p 8082:80 phpmyadmin

Ikusten denez, bigarren kontainerrean -e parametro berria pasatu zaio, hau da, hurrengoaren ingurune-aldagaia dela adierazten duena (ingelesez environment). Kasu honetan, ingurune-aldagaia PMA_ARBITRARY da, eta 1 balioarekin hasieratu da.

Orain gure web nabigatzailean zerbitzariaren IPko 8081 eta 8082 atakak bisitatuz gero, webak erakusten digun formularioan desberdintasun txiki bat nabarituko dugu.

8081 atakako formularioan (non aldagaia ez den hasieratu) erabiltzaile-izena eta pasahitza bakarrik sartu daitezke. Aldiz, 8082 atakako formularioan, PMA_ARBITRARY aldagaia hasieratuta, eta irudiaren dokumentazioak adierazten duen moduan, MySQL zerbitzariaren IP adierazi ahal izango dugu, konektatu nahi dugun zerbitzaria izanik.

Ezkerrean 8081 atakako formularioa, aldagaia hasieratu gabe. Eskuman, 8082 ataka aldagaiarekin hasieratuta.

Aldagaiek zerbitzuaren portaeran (edo sortzean) eragina izan dezaketenez, garrantzitsua da dokumentazioa irakurtzea eta erabilgarriak izan daitezkeen aldagaiak identifikatzea.

Docker irudien dokumentazioa irakurtzea gomendatzen da, ingurune-aldagai posibleak identifikatzeko eta guretzat erabilgarriak diren ikusteko.

29 Datuen bolumen iraunkorra

Orain arte Apache zerbitzua abiarazten duen irudi baten bidez kontainer bat sortu dugu, bere orrialde lehenetsia erakutsiz. Kontainer barruan gure HTML orrialdea idatzi genezake, baina kontuan izan behar dugu kontainer baten datuak kontainerra ezabatzen denean desagertzen direla.

Kontainer barruan egindako aldaketak mantendu nahi baditugu, datu-bolumenak erabiltzea beharrezkoa da. Hau ez da bestelako zerbait, sistema eragileko diskoaren bide bat kontainer barruko bide batean muntatzea baizik.

Kontainerrei esleitutako bolumen hauek bi motatakoak izan daitezke:

- Irakurketa bakarrik: Irakurri bakarreko bolumen bat esleitzea interesgarria izan daiteke konfigurazio-fitxategiak edo ikusgai jarri nahi dugun weba pasatzerakoan.

- Irakurketa-Idazketa: Kasu honetan bolumenean idatz daiteke. Adibidez, datu-base batek informazioa gordetzen duen direktorioa edo erabiltzaileek igotako irudiak gordetzen dituen weba.

Modu honetan, kontainer bakoitzari esleitu beharreko bolumen kopurua irudiaren, abiarazten den zerbitzuaren eta kontainer barruan sortu edo esleituko ditugun datuekin egin nahi dugunaren arabera zehaztu behar da.

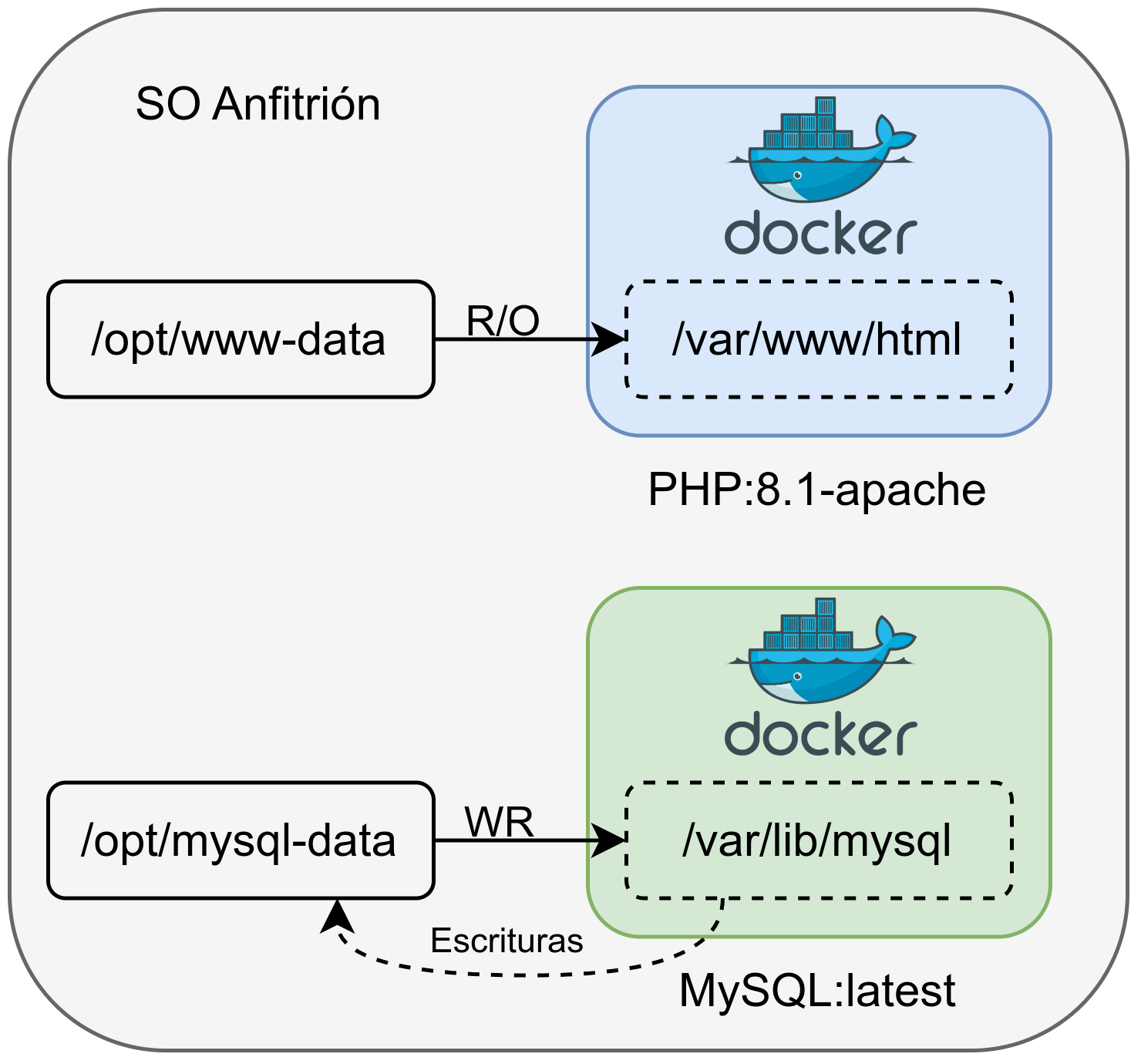

Hurrengo irudian bi kontainer eta bi bolumen dituen azpiegitura ikus daiteke:

- Web Kontainerra: Irakurri-bakarreko bolumen bat esleitzen zaio, jatorrizko bidea /opt/www-data dena, kontainer barruan /var/www/html dagoena.

- MySQL Kontainerra: Datu-basearen datuak gordetzea beharrezkoa denez, idazketa baimentzen duen bolumen bat esleitzen zaio. Beraz, kontainer barruan /var/lib/mysql sortzen dena, benetan anfitrioi sistema eragilean /opt/mysql-data gordetzen da.

29.1 Bolumen idazgarria gehitu kontainer bat sortzerakoan

Kontainer bat sortzerakoan bolumen bat gehitzean, lehenetsita irakurketa-idazketa moduan sortzen da. Kontainer barruan bide zehatz batean egindako edozein idazketa, fitxategia anfitrioi sistema eragileko bide adierazian sortzea ekarriko du.

Idazketa-bolumena gehitu kontainer bat sortzerakoan

ruben@vega:~$ ls /opt/mysql-data

ruben@vega:~$ docker run -d -p 3306:3306 --name mi-db \

-v /opt/mysql-data:/var/lib/mysql \

-e MYSQL_ROOT_PASSWORD=my-secret-pw \

mysql:latest

ruben@vega:~$ ls /opt/mysql-data

auto.cnf client-key.pem '#innodb_temp' server-cert.pem ...

Adibide honetan, MySQL irudia erabiliz kontainer bat sortu da, bolumen bat esleituta (lehenetsita idazketa baimentzen duen moduan esleitzen da) eta gero pasahitzarekin konektatzeko beharrezko parametro batekin.

-v /opt/mysql-data:/var/lib/mysql:

-vparametroaren bidez kontainerrei bolumen bat pasatuko zaiela adierazten zaie. Gero, anfitrioi sistema eragileko bidea /opt/mysql-data zehazten da, kontainer barruan /var/lib/mysql muntatuko dena.-e MYSQL_ROOT_PASSWORD=my-secret-pw: “-e” parametroak kontainerrei ingurune-aldagaiak pasatzeko balio du. Kasu honetan, eta MySQL irudiaren webgunean azaltzen den bezala, hau da datu-basea hasieratzen den bitartean root erabiltzailearen pasahitza esleitzeko modua.

Kontainerra sortu ondoren, eta docker ps komandoa erabiliz kontainerra martxan dagoela ziurtatu ondoren, anfitrioi sistema eragiletik edo beste edozein lekutik aurretik zehaztutako pasahitzarekin konekta daiteke.

MySQL-ren status ikusten

ruben@vega:~$ mysql -h127.0.0.1 -uroot -P3306 -p

Enter password:

...

MySQL [(none)]> show databases;

+--------------------+

| Database |

+--------------------+

| information_schema |

| mysql |

| performance_schema |

| sys |

+--------------------+

4 rows in set (0,007 sec)

29.2 Irakurketa-bakarrik moduan bolumena gehitu

Jarraian azalduko dira pausoak PHPz sortutako web sinple bat daukan kontainer bat martxan jartzeko, web hori anfitrioi sistema eragileko /opt/www-data bidean dagoena.

Irakurketa bakarreko bolumena gehitu kontainer bat sortzerakoan

ruben@vega:~$ ls /opt/www-data

index.php

ruben@vega:~$ docker run -d -p 80:80 --name mi-web \

-v /opt/www-data:/var/www/html:ro \

php:8.2.4-apache

Kontainer hau sortzean esleitutako parametro berria hau da:

-v /opt/www-data:/var/www/html:ro: Bolumen bat esleituko diogula adierazteko, anfitrioi sistema eragileko /opt/www-data bidea kontainer barruko helbidearekin lotuz eta irakurketa-bakarrik moduan ezarriz /var/www/html.

Geroago, Docker kontainer baten barruan nola sartu ikusiko dugunean, komando hau erabil daiteke kontainer barruko bidea bisitatzeko eta benetan irakurketa-bakarrik moduan dagoela egiaztatzeko.

29.3 Docker kontainer baten barruan sartzea

Normalean ez da beharrezkoa kontainer baten barruan sartzea, izan ere, aurretik esan bezala, bertan egindako aldaketa guztiak galtzen dira (bolumen iraunkor baten barruan ez bada).

Hala ere, probak egiteko edo irudi baten funtzionamendu zuzena egiaztatzeko, kontainer baten barruan sartzea interesgarria izan daiteke. Horretarako, exekutatu beharreko komandoa hau da:

Kontainer batean sartu

ruben@vega:~$ docker exec -it mi-db /bin/bash

Erabilitako parametroak hauek dira:

exec: Martxan dagoen kontainer baten barruan komando bat exekutatu nahi dugula adierazten du.-it: Bi parametro elkartuta dira; sarrera irekita mantentzeko (modu interaktiboa) eta TTY (kontsola) bat sortzeko balio dute.mi-db: Sartu nahi dugun kontainerraren izena da. Halaber, kontainerraren IDa ere adierazi daiteke./bin/bash: Exekutatu nahi dugun komandoa da. Kasu honetan, bash shell bat. Zenbait kasutan shell hau ez dago instalatuta eta/bin/sherabili behar da.

Kontuan hartu behar da kontainer baten barruan aplikazioa/zerbitzua funtzionatzeko beharrezkoa den software minimoa bakarrik dagoela, beraz, komando asko ez dira existituko.

30 Beste komando erabilgarri batzuk

Kontainer baten informazio osoa lortzeko, bere egoera, erabilitako bolumenak, portuak, …

Kontainer baten informazioa lortu

ruben@vega:~$ docker inspect mi-db

Lokalean deskargatutako irudiak zerrendatu. Irudiak lokalean edukita, ez da berriro deskargatu beharko, eta horregatik, irudi horietako bat erabiltzen duen kontainer berri bat sortzea askoz azkarragoa izango da.

Lokalean dauden irudien zerrenda